Stanford University CS231n, Spring 2017

1.[231N] Lecture 1,2 review

Lecture 1 Review 우선 강의 1은 완전 ot느낌이다. 컴퓨터비전의 역사와 앞으로 우리가 배울 내용을 다룬다. 그래도 간략하게 요약해보자. Vision History 60년대 초반부터 컴퓨터비전의 역사가 시작된다. Larry Roberts, 19

2.[231N] Lecture 3,4 review

Leture 3 | Loss Functions and Optimization 3번째 강의에서는 손실함수와 최적화에 대해 배운다. 나는 동시에 224N강의를 듣고 있고, 224 n에서 배운 내용이 다시 231n에 나와서 뭔가 복습을 하는 느낌도 있다. 하지만 솔직히

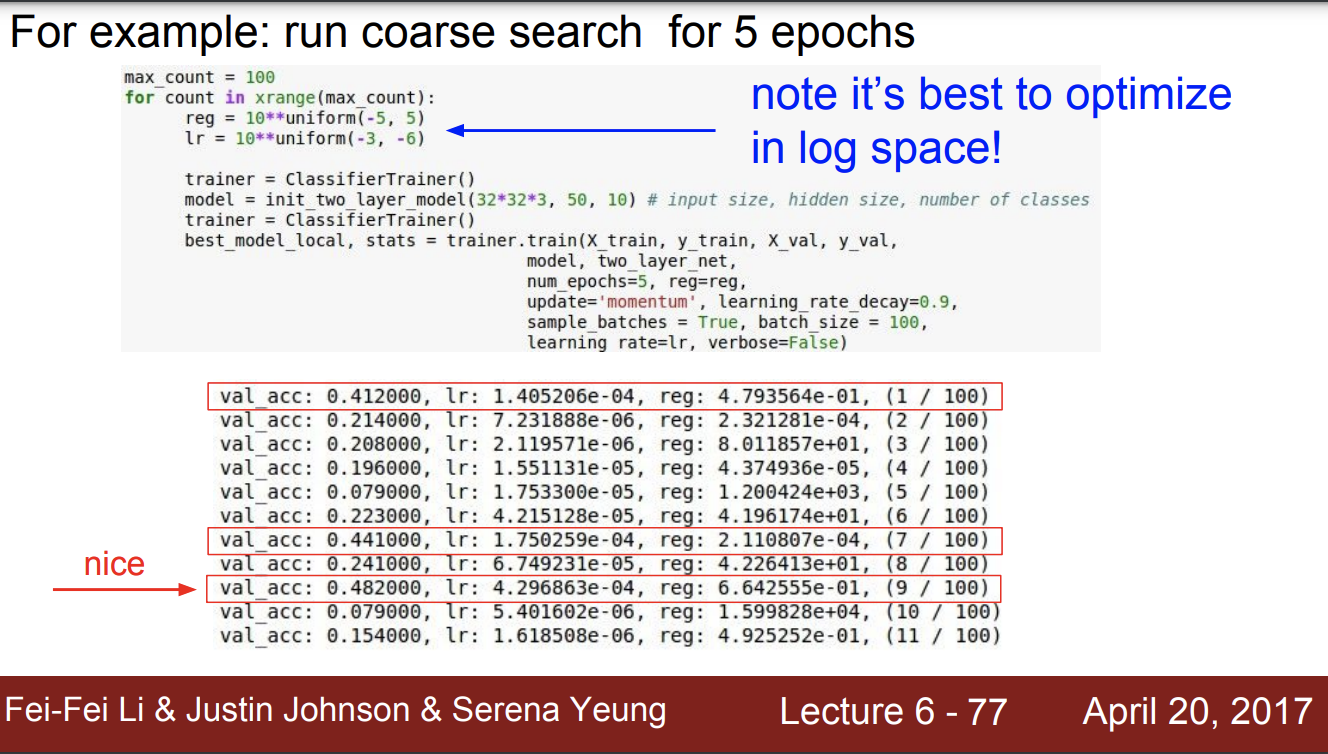

3.[231N] Lecture 5, 6 review

Lecture 5 5강에서는 Convolutional Neural Networks에 대해 배운다. 나는 일단 컴퓨터비전 기초를 대학교 수업에서 배웠어서 복습하는 기분이었다. 근데 스탠포드 박사과정 조교님이 강의를 잘하셨다. (약간 학생들 질문에 답변은 애매하긴

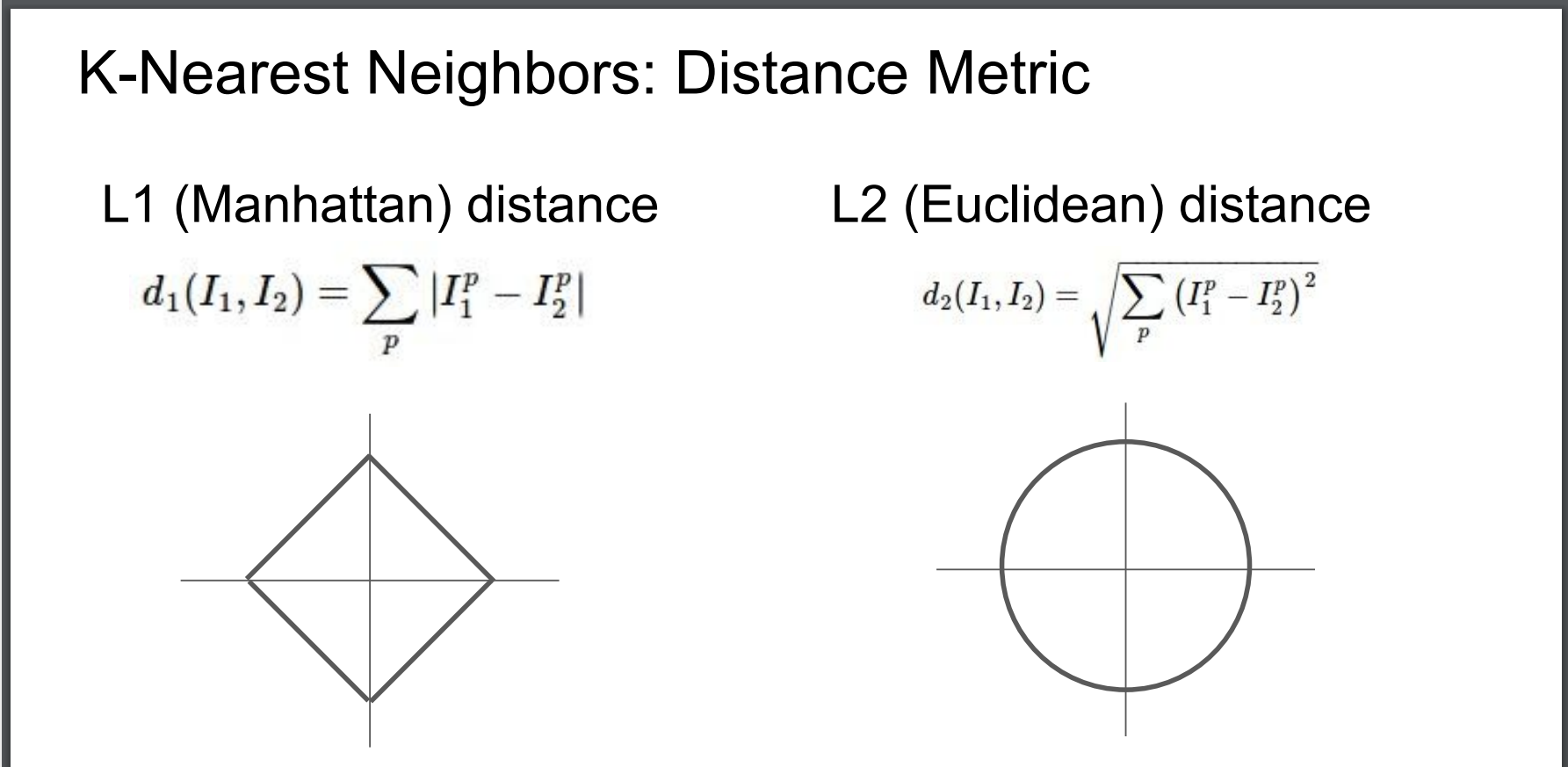

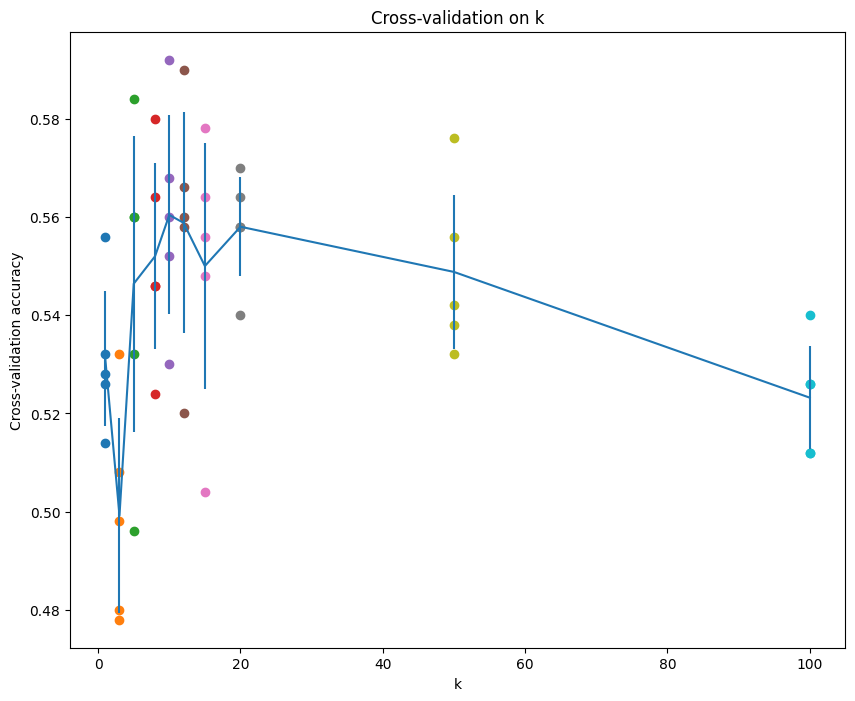

4.[231N] Assignment 1 - KNN

과제1 를 시작한다. 과제는 Colab에서 수행하고, 일단 처음 환경설정하는 건 동영상을 보고 쉽게 따라할 수 있다. 과제 링크 그리고 과제 하나에 여러개의 과제가 또 있다. 할 게 너무 많아 순서대로 KNN SVM Softmax classifier Two-Lay

5.[231N] Assignment 1 - SVM

과제 1 의 두번째 코드인 SVM을 시작해보려 한다. 일단 CIFAR-10 Data Loading and Preprocessing 부분을 모두 실행한다. 데이터를 train, valid, test로 나누고 32,32,3 크기를 3072로 합친다. 그리고 추가적으로

6.[231N] Lecture 7 review

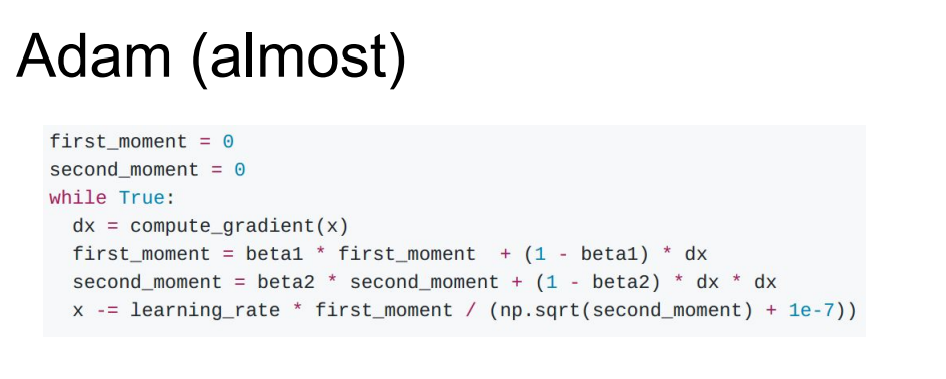

Lecture 7 모델을 train 시키기 위해 필요한 개념 2를 정리하도록 한다. 강의링크 이번 강의에서는 Fancier optimization Regularization Transfer Learning 에 대해 알아보자. Optimization (최적화)

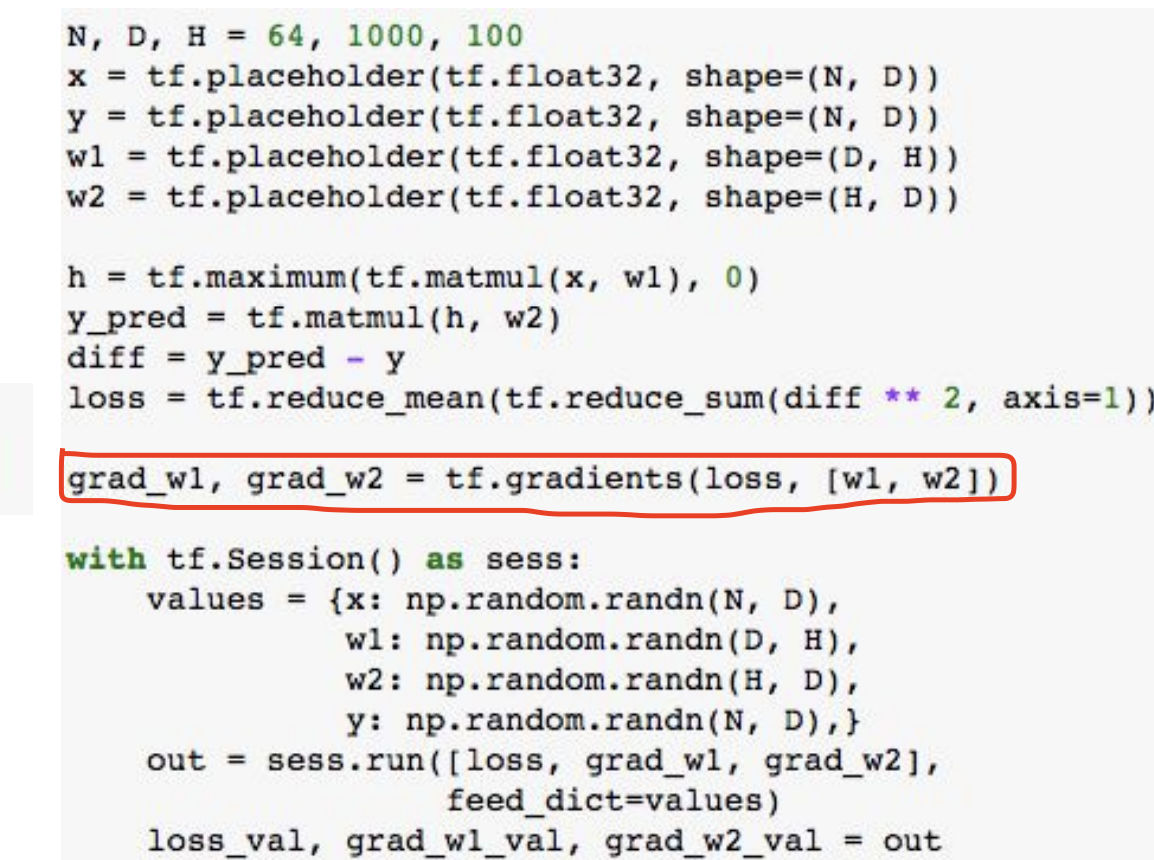

7.[231N] Lecture 8 review

Lecture 8 이제 8번째 강의이다. 강의 영상 이번 강의에서는 CPU VS GPU Deep Learning Frameworks Caffe / Caffe 2 Theano / TensorFlow Torch / PyTorch 를 배우고자 한다. CPU

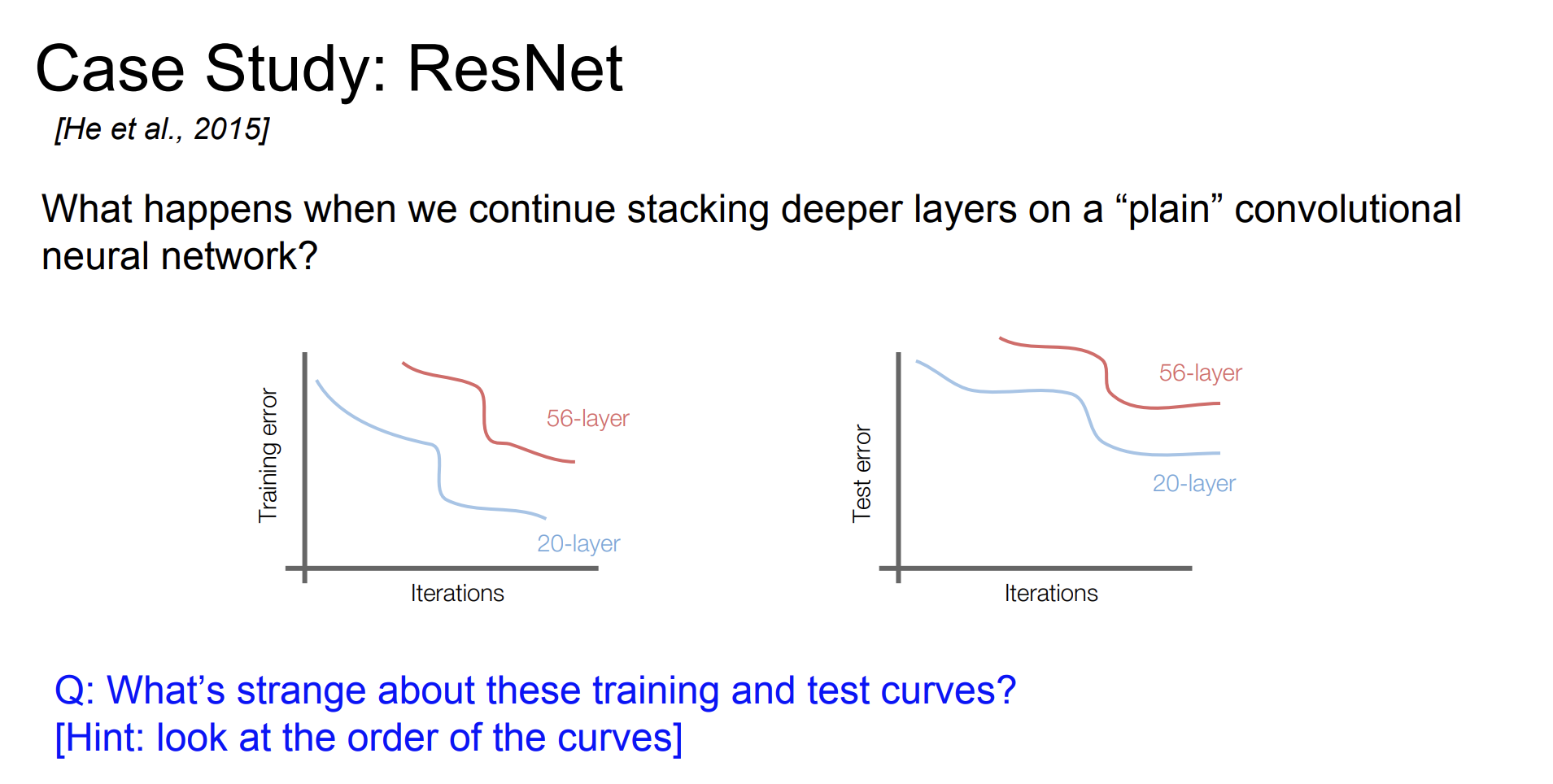

8.[231N] Lecture 9 review

강의 자료 강의 영상 강의 ppt Lecture 9 오늘 배울 내용은 바로 CNN Architectures 에 대해 배워보자. AlexNet VGG GoogLeNet ResNet Also NiN Wide ResNet ResNeXT Stochastic Dept

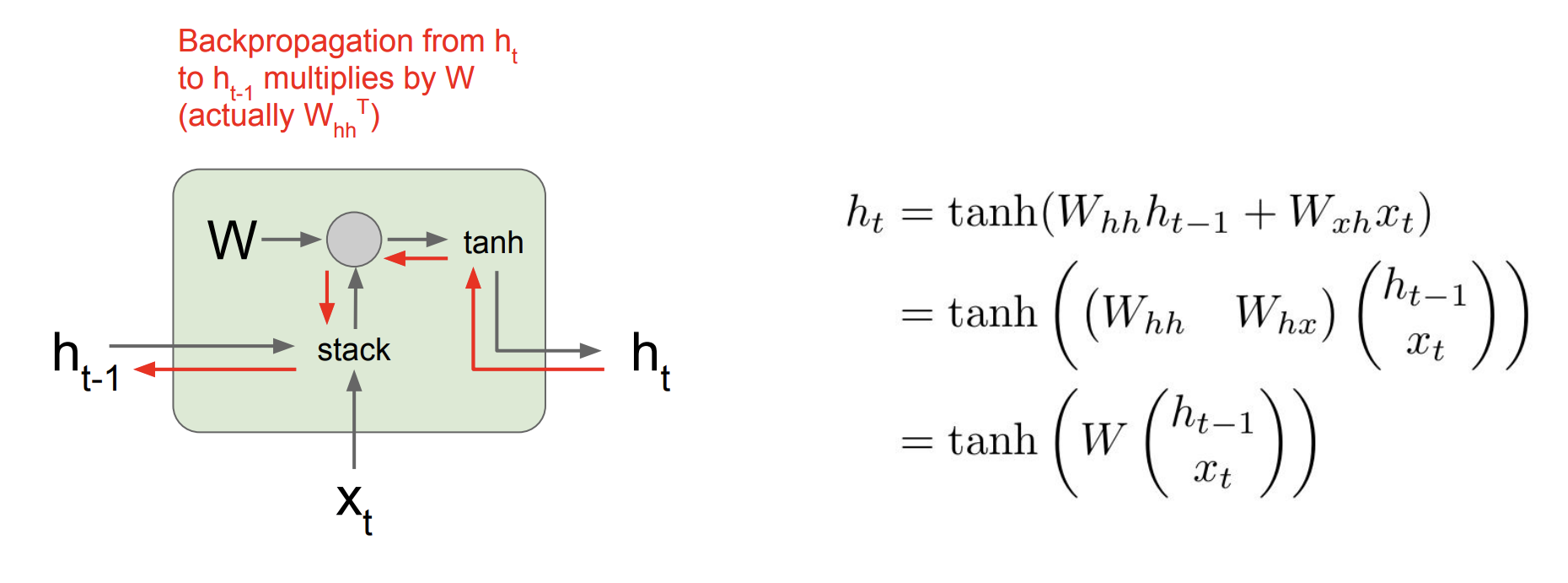

9.[231N] Lecture 10 review

강의 자료 강의 영상 lecture 10 | RNN 강의 PPT Lecture 10 | RNN 이전시간까지 CNN 아키텍쳐들에 대해서 배웠다. 오늘은 Recurrent Neural Networks에 대해 배워보자! Process Sequences 우리는 지금

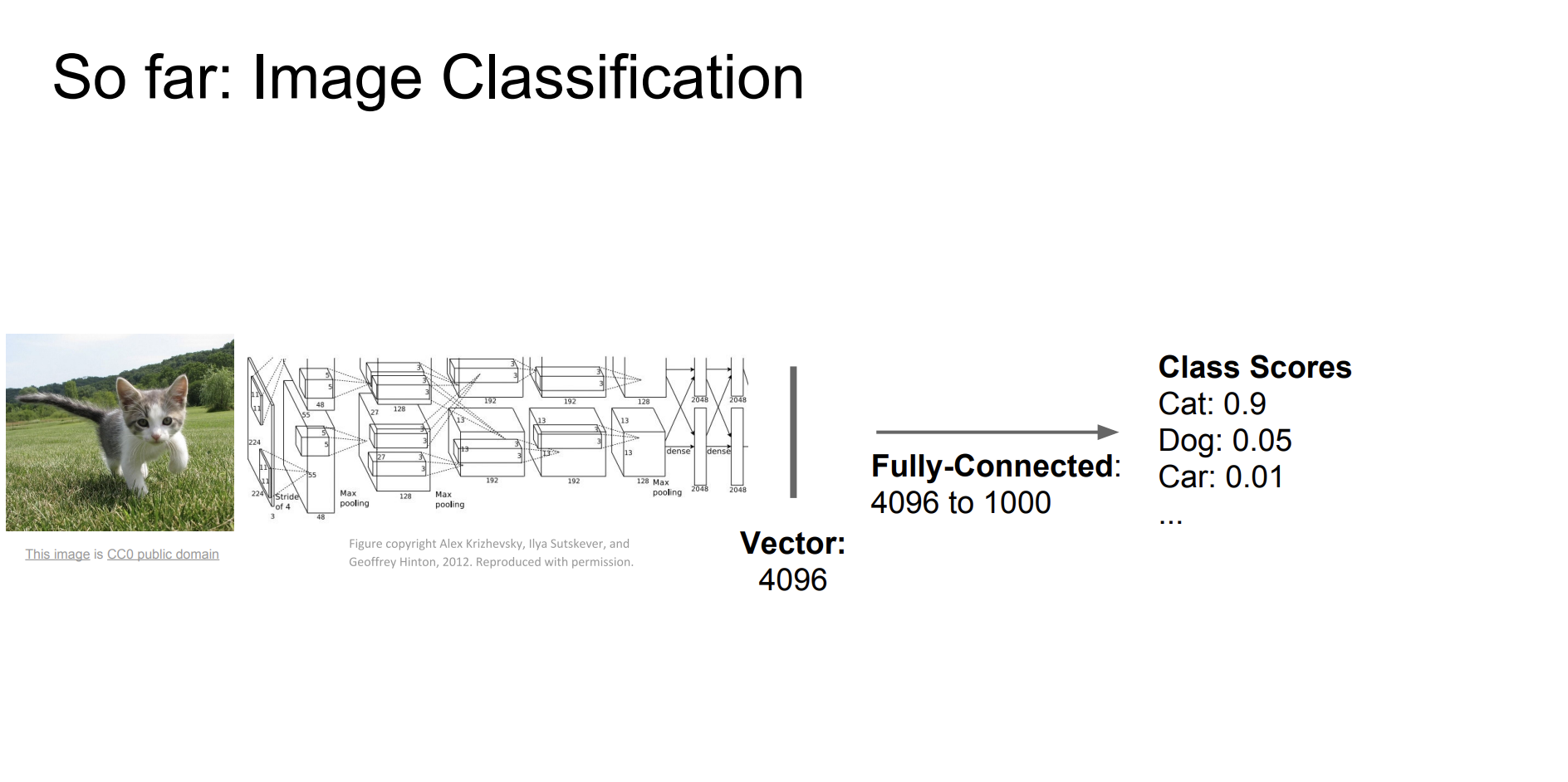

10.[231N] Lecture 11 review

강의 자료강의 영상강의 ppt오늘 배울 내용은 !Today: Segmentation, Localization, Detection좀 재밌는거 배우는 것 같아서 신난당지금까지 우리는 이미지 분류를 진행했다.그럼 이제 다른 컴퓨터비전 작업에 대해서 알아보자!Segmantic