클라우드

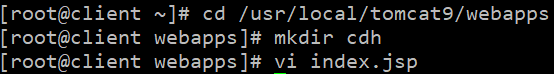

1.[클라우드] 웹 서버와 웹 어플리케이션와 DB 서버 연동

가상 머신 준비

2.[클라우드] 웹, 앱, db 확장

이전 게시글 아파치 설정하는 방법으로 총 2대 만들기.만들어 놓은 것에서 워커 파일의 설정을 변경해줘야 한다.vi /etc/httpd/conf/httpd.conf 파일에서 저 부분을 worker1에서 loadbalance로 변경vi /etc/httpd/conf/work

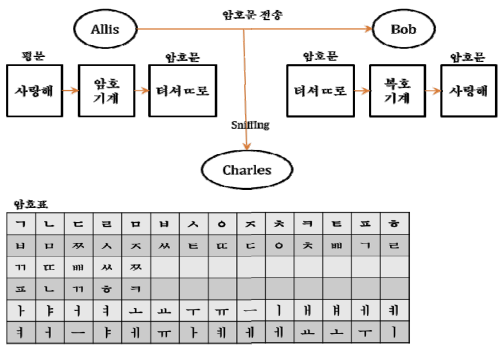

3.[클라우드] SSL

20.04 프리티어 버전으로 하고, key pair는 나머지는 디폴트, ppk 파일로 다운받는다.ssh에서 쓸 것이기 때문이다.ec2 대시보드로 들어가면 실행 중이라고 뜰 것이다.putty 설정에 들어가서 Connection -> SSH -> Auth 에 가서 다운받은

4.[클라우드] 오픈 스택 설치 및 구동, 인스턴스 생성

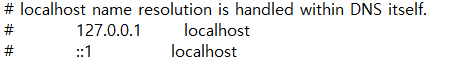

dns 서버에 물어 보기 전에 /etc/hosts를 먼저 봄.dns와 굳이 통신하지 않아도 열 수 있음.윈도우에도 있음.C:\\Windows\\System32\\drivers\\etc3대 모두 설정그래서 우리가 localhost로 들어갔을 때 자기 ip로 접속이 되는

5.[클라우드] 오픈스택(커스텀 이미지 관리)

xming 다운우리 리눅스 컴퓨터가 gui를 지원안함그래픽이 있는 프로그램이 실행이 되도 제대로 실행안됨.리눅스에서 실행되는 그래픽을 윈도우에 쏴줘서 윈도우에 뛰울거임. 그게 가능한게 xming임.전부 설치하면 오른쪽 아래에 실행되고 있는 아이콘이 생김. 이러면 잘 설

6.[django] 배포

centos8 버전으로 준비yum install -y httpd httpd-devel python39 python39-devel mysql-devel redhat-rmp-configsetenforce 0systemctl stop firewalld개발을 진행한 가상환경에

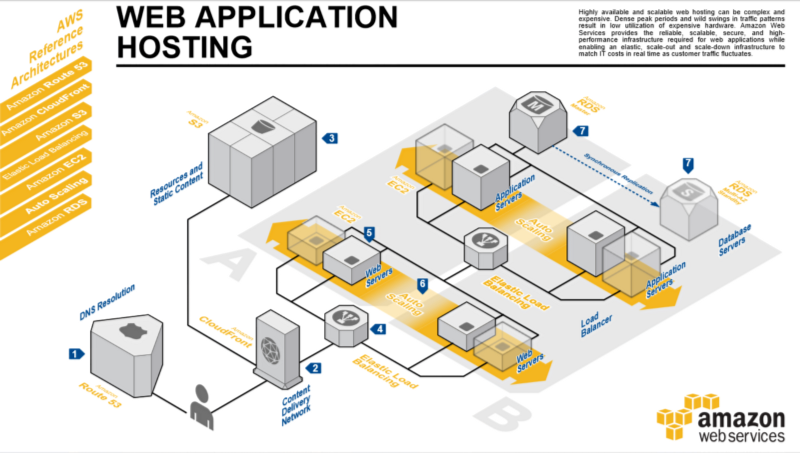

7.[AWS] EC2와 RDS를 이용한 무료 배포

EC2 인스턴스 생성 이름 설정 Ubuntu 20.04 프리티어 키 페어

설정 방법위의 명령어로 프로메테우스 기본 설정 파일 생성 및 수정자신의 장고 프로젝트의 설정 파일로 들어가기위의 코드대로 수정가장 루트 폴더의 urls.py를 바꿔야 한다.추가해준다.설정 방법위의 명령어로 프로메테우스 기본 설정 파일 생성 및 수정다른 vm에 hapro

9.[클라우드] 부하 테스트

jmeter-plugin-manageropen-jdkapache-jmeter위 3개 파일을 다운로드 받자.oepn-jdk를 다운받고 압축 해제.압축 해제한 파일 jdk-11.0.2 폴더를 로컬디스크c 밑에 놓기시스템 환경 변수 편집 들어가기고급 -> 환경 변수 -> 시

10.[클라우드] 부하 테스트 실습

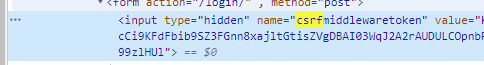

HTTP Request의 이름을 알아보기 쉽게 바꾼다.위의 그림처럼 CSS Selector 만들어준다.HTTP Request처럼 이름 바꿔준다.우리는 지금 로그인 테스트를 위해 CSRF 토큰을 가져와 심고, 아이디와 비밀번호를 입력해 로그인페이지의 부하를 주려고 하는

11.[django] EC2에서 gunicorn 연동 + S3(static, media)

Gunicorn이란? Python WSGI(Web Server Gateway Interface)로 WEB Server(Nginx)로부터 서버사이드 요청을 받으면 WSGI(Gunicorn)를 통해 서버 어플리케이션(Django)으로 전달하는 역할을 함 Django의 [

12.[AWS] s3 vs ec2 그리고 람다

s3 웹서버 방식 (서버리스, 요청 건수 당 요금) 사용할 때만 요금이 나감 ec2 웹서버 방식 (시간 당 요금) nginx 기능들을 사용함 서비스 특정 시간에만 사용자가 폭발적으로 늘어나는 서비스 배달 배달이 전혀 없는 시간대에도 ec2는 폭발적일때와 마찬가지로

13.(AWS) 람다로 backend 배포시키기 (feat. zappa)

간단한 람다 api 만들어보기 백엔드 (drf) 람다에 올리기

14.[클라우드] kafka

Kafka는 LinkedIn에서 개발한 분산 스트리밍 플랫폼, 오픈 소스 메시지 브로커메시징, 메트릭 수집, 로그 수집, 스트림 처리 등 다양한 용도로 사용 가능빠르다수 천개의 데이터 소스로 부터 초당 수백 메가바이트의 데이터를 입력 받아도 안정적으로 처리 가능확장가능

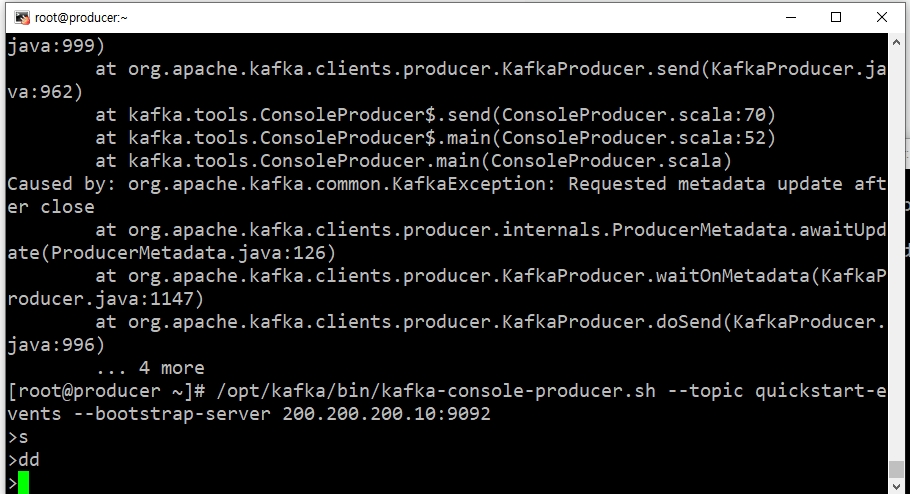

15.[kafka] 실습

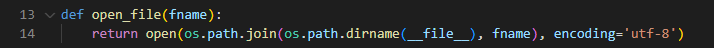

자신의 장고 프로젝트에 입혀보기 필자는 기본적인 루틴을 생성하는 API가 있기 때문에, 생성하는 곳에 밑의 코드를 넣었다. 그래서 루틴을 생성하게 되면, 해당 broker에게 생성 메세지를 날리고, consumer로 받게끔 실습을 할 예정이다. 물론 producer는

16.장고에 kafka 적용

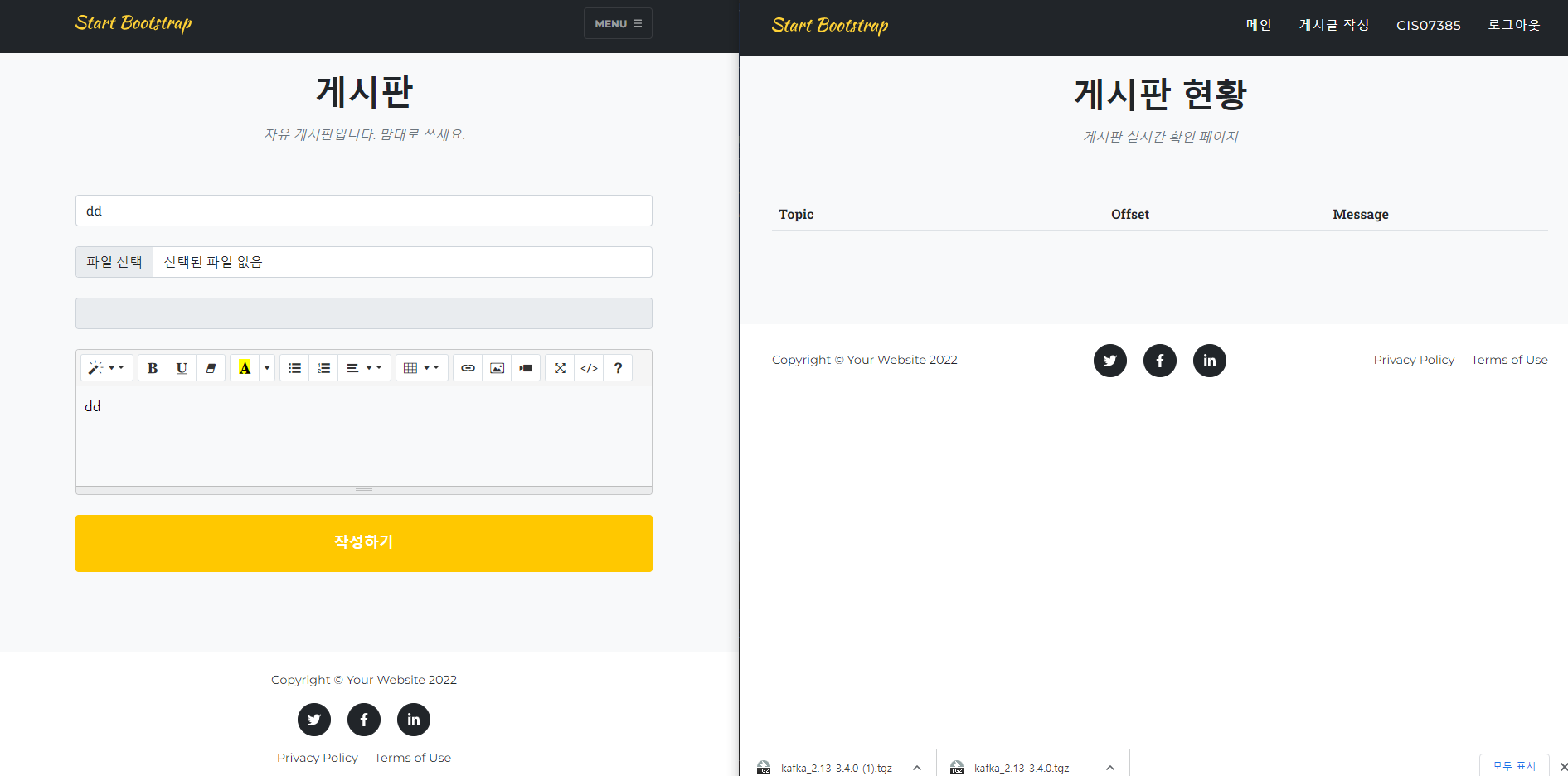

로직 설명 게시글 작성하면 producer가 특정 topic으로 broker에게 메세지 전달 broker는 큐에 메시지 저장 consumer는 kafka와 연결되어 있는 rest_proxy에 자신의 ID 등록 자신의 저장 공간을 할당 받은 후, 특정 Topic 구독

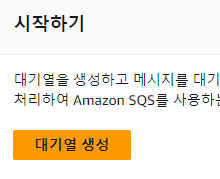

17.AWS의 메시징 서비스

지금까지 이전 게시글에서는 kafka를 이용해 온프레미스에서 동작하는 것으로 실습을 해보았다.이번에는 AWS에서 제공해주는 메시징 서비스를 이용해 실습을 해보도록 하자.aws에서 말하는 대기열은 kafka의 topic을 생성하는 거라고 생각표준 유형과 fifo 유형이

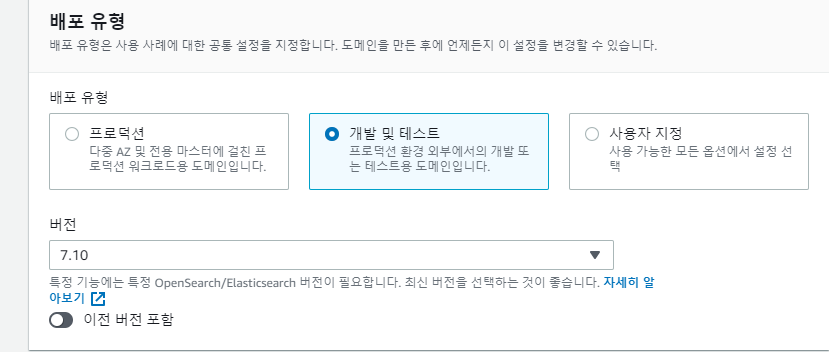

18.[AWS] Elasticsearch

한달에 750시간 공짜, ebs storage는 10gb 공짜도메인 생성 (클러스터 하나 생성)배포 유형은 개발 및 테스트버전은 elasticsearch의 7.10 버전을 사용인스턴스 구성t3.small까지만 750시간 공짜다..보통 노드 수를 최소 3개는 가져가야 하