분류 성능 평가 지표 : Classification

종류

-

정확도(Accuracy)

-

오차행렬(Confusion Matrix)

-

정밀도(Precision)

-

재현율(Recall)

-

F1 스코어

-

ROC AUC

1. 정확도(Accuracy)

예측 결과가 동일한 데이터 건수 / 전체 예측 데이터 건수

이진 분류 데이터 구성인 경우 숫자 놀음이 될 수 있음

불균형한 레이블 값 분포에도 적합하지 않음

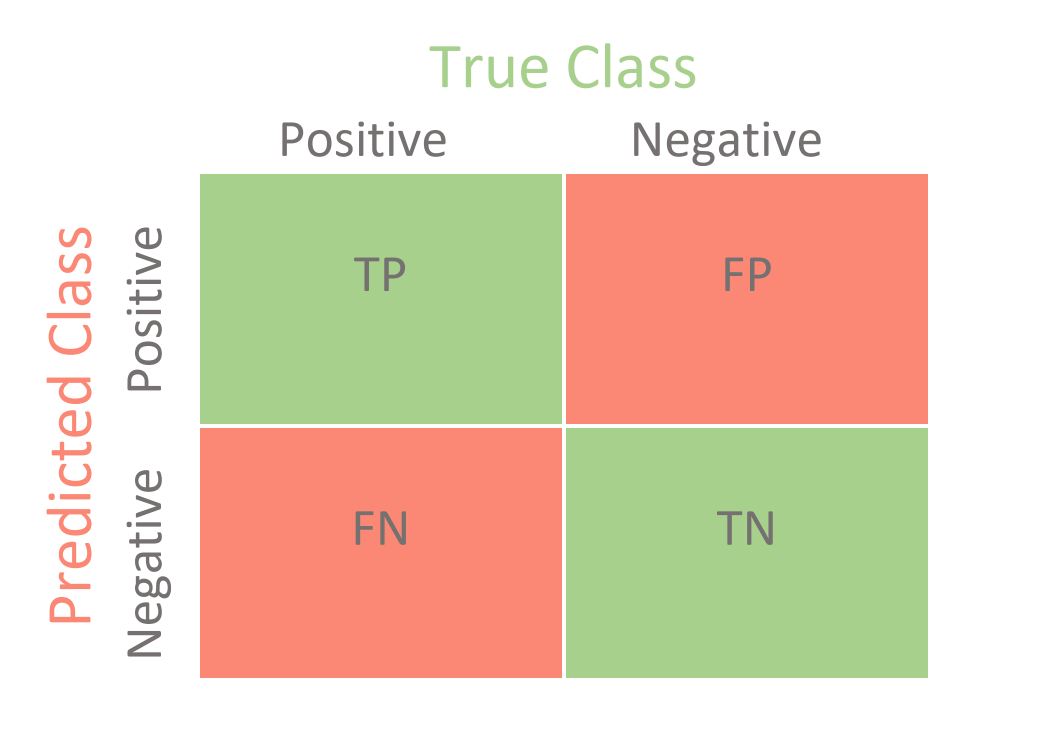

2. 오차 행렬(Confusion Matrix)

이진 분류의 예측 오류가 얼마인지와 어떤 유형의 오류가 발생하는지를 나타내는 지표

사분면의 지표를 가짐

- True Negative(TN) - Negative O

- False Negative(FN) - Negative X

- False Positive(FP) - Positive X

- True Positive(TP) - Positive O

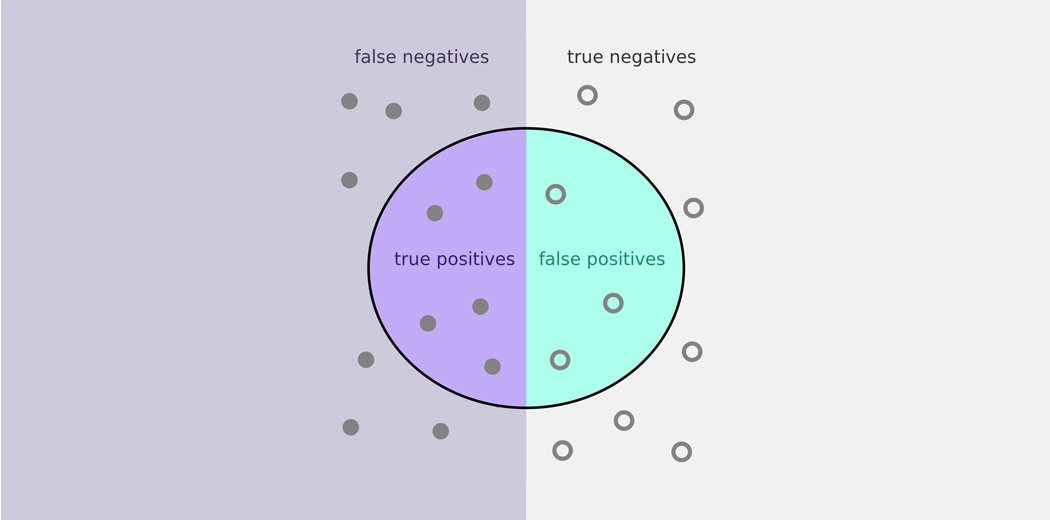

3. 정밀도(Precision)와 재현율(Recall)

- 정밀도: TP / (FP + TP)

실제 양성인 것을 음성으로 판단하면 안됨 - 재현율: TP / (FN + TP)

분류 결정 임곗값에 따라 Positive일 확률이 높아진다 -> 재현율 증가

Positive일 기준을 낮추는 것

precision_recall_curve() 함수를 통해 임곗값 제한 가능

향상 시키는 방법

- 정밀도

확실한 기준이 되는 경어만 Positive로 예측하고 모두 Negative로 예측 - 재현율

모든 케이스를 Positive로 예측

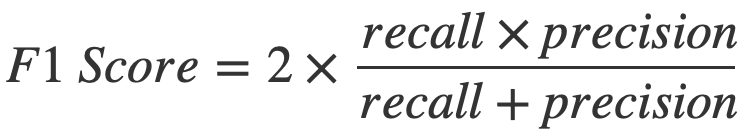

4. F1 Score

정밀도와 재현율을 결합한 지표

둘 중 어느 한쪽도 치우치지 않은 수치일 때 높은 값을 가짐

f1_score 함수를 통해 측정 가능

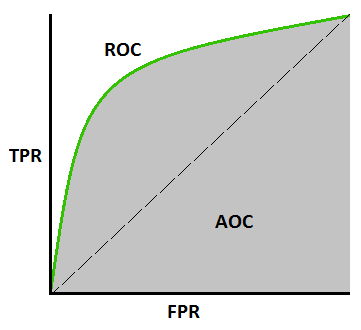

5. ROC 곡선과 AUC 스코어

- ROC 곡선

FPR(False Positive Rate)가 변할 때 TPR(True Positive Rate)의 변화 곡선

FPR이 X축, TPR이 Y축에 위치

성능 지표는 ROC 곡선 면적에 기반한 AUC(Are Under Curve) 값으로 결정

1에 가까울수록 좋은 수치

Life is either a daring adventure or nothing at all. - Helen Keller

삶은 과감한 모험이거나 아니면 아무것도 아니다. - 헬렌켈러