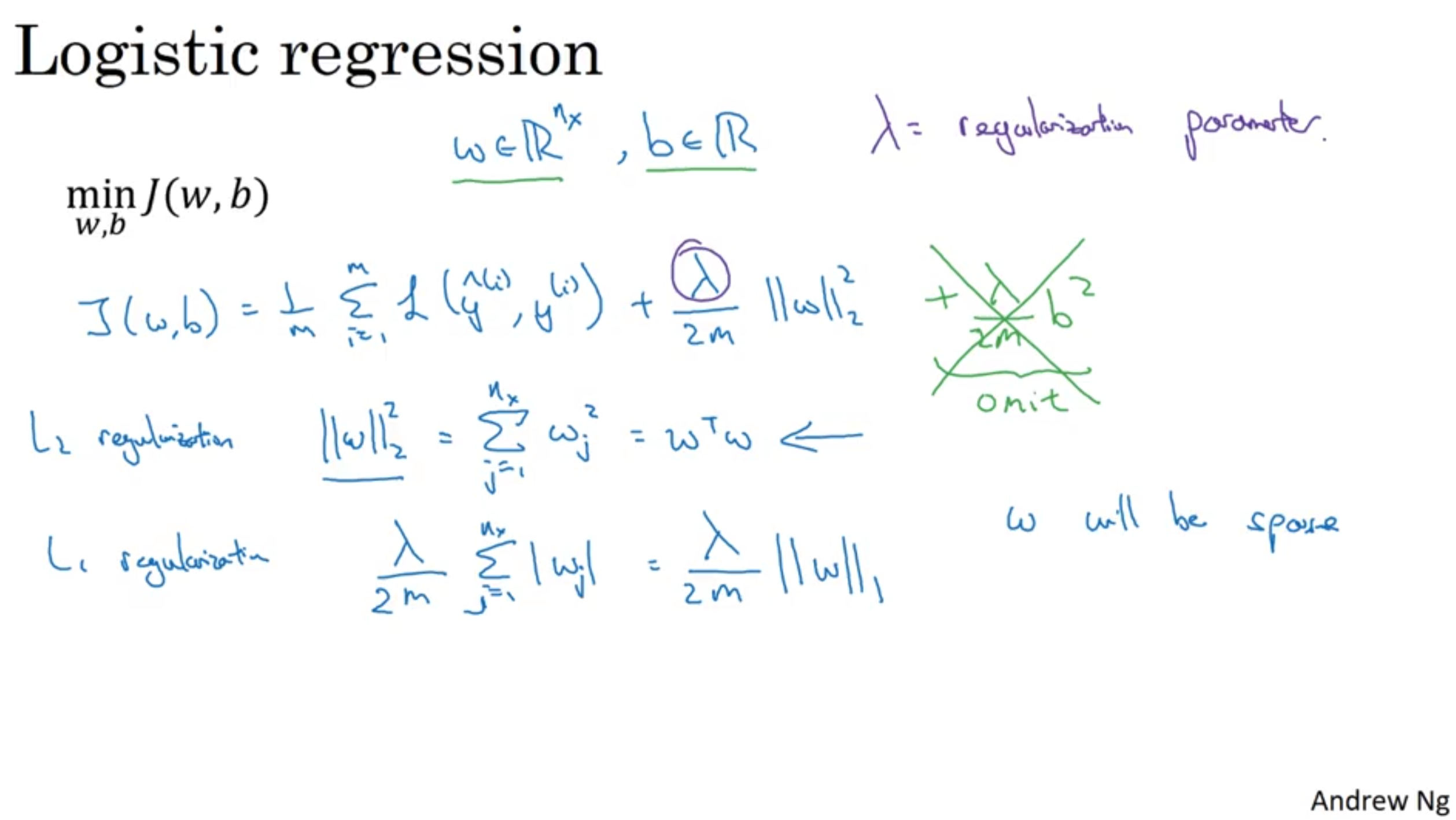

- 오버피팅을 방지하기 위한 조치로 L2 norm을 Cost Function에 더해줌. → 하이퍼파라미터인 lambda를 조정해야함.

- L2 Regularization이 가장 많이 사용됨.

- L1 Regularization을 사용하면 W matrix에 많은 숫자가 0이됨. 잘 사용하지 않음.

- K-fold cross validation을 수행할 때 다른 lambda 값을 적용해보면서 적정 값을 찾아감.

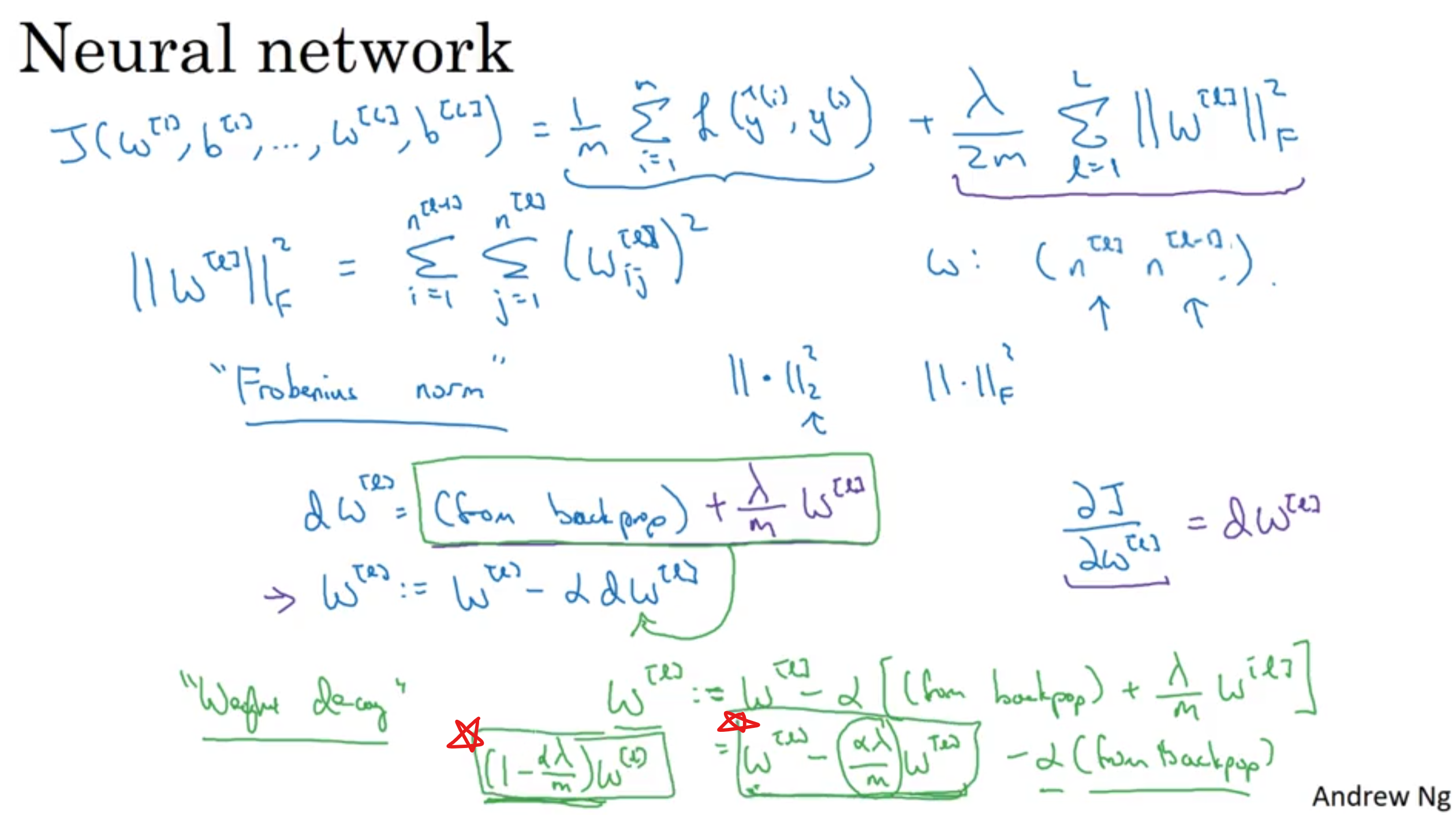

- Neural Network에서는 L2 norm을 Frobenuius norm이라고 부르기도 한다. 또 다른 이름은 Weight Decay이다.

- 결국 기존의 W에 1보다 조금 작은 값을 곱해서 숫자의 크기를 줄일 수 있도록 해주는 역할이 된다.

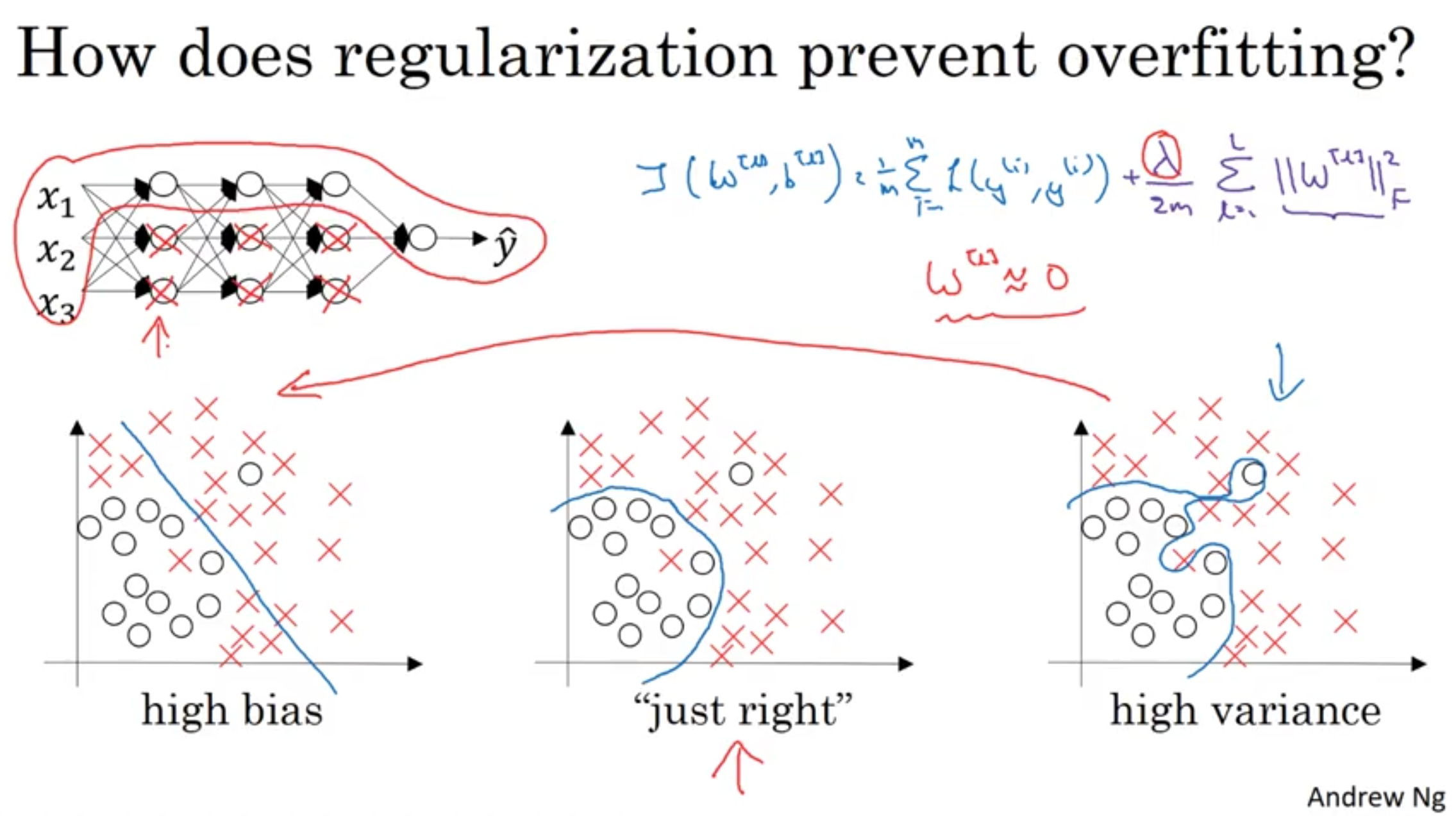

- Lambda를 크게 설정하면 W의 값이 0에 가까워짐. Weight가 0에 가까워 진다는 것은 hidden layer의 node들의 영향력이 줄어드는 것을 뜻함.

- 따라서 모델 자체가 Simple 해지기 때문에(마치 logistic regression 처럼) overfitting이 방지됨.

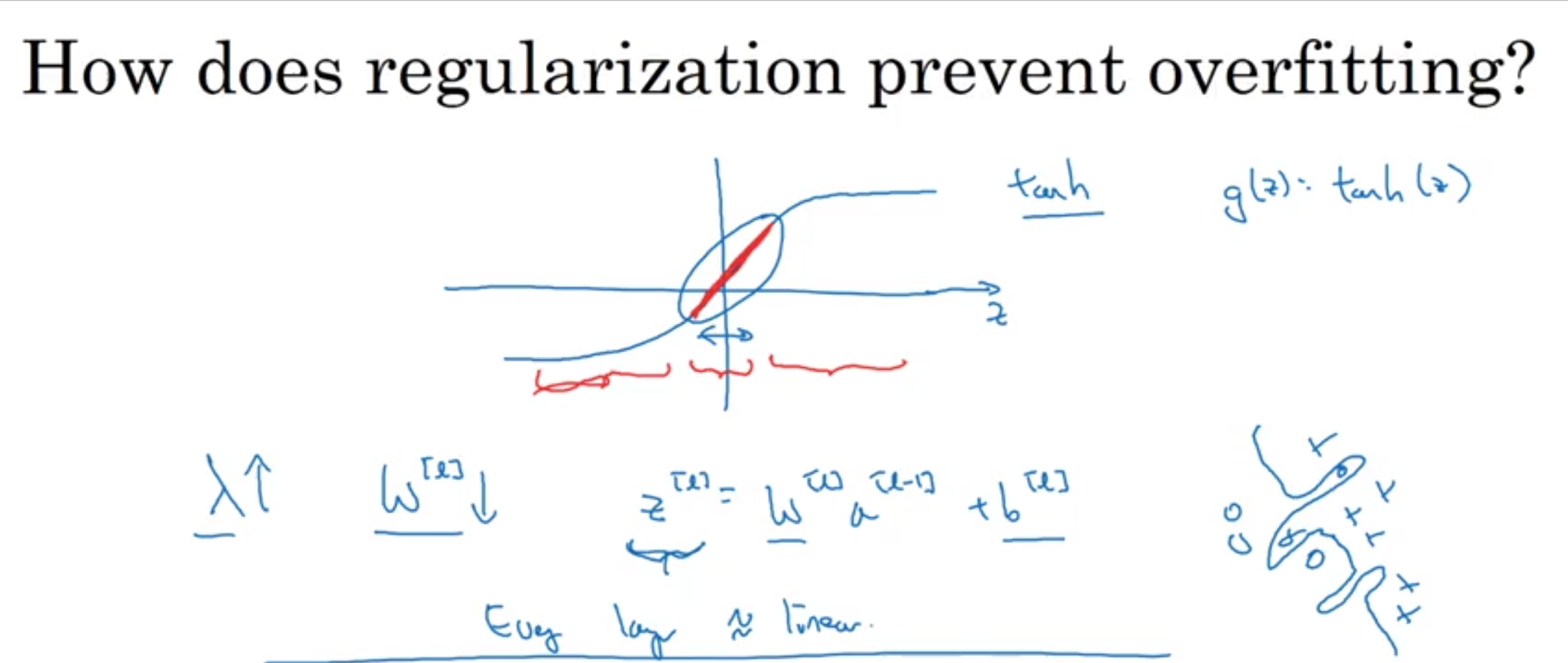

- Lambda가 커지면 Weight가 작아짐. 결국 Z 값이 0에 가까워지고, activation function에서 linear 부분에 몰리게 됨.

- 결국 모든 레이어가 linear function과 가까워짐.

- 따라서 모델이 Simple해지는 효과가 있으며 overfitting이 방지됨.

결국 Weight가 너무 커지면 overfitting의 위험이 있는 것이고, 이를 방지하기위해 regularization을 통해 Weight를 줄여주는 것!