안드레 카파시(Andrej Karpathy)는 인공지능(AI)과 딥러닝 분야에서 저명한 연구자이며, 특히 컴퓨터 비전과 자연어 처리(NLP)에 기여했습니다. 그의 연구와 경력은 크게 다음과 같이 요약할 수 있습니다.

1. 딥러닝 및 컴퓨터 비전 연구

- CVPR, NeurIPS 등 주요 학회 논문: 이미지 인식, 객체 탐지, 이미지 캡셔닝 연구 수행

- 2015년 Stanford PhD 논문: “Connecting Images and Natural Language”에서 딥러닝 기반 이미지-텍스트 매핑 연구

- Recurrent Neural Networks (RNN) & LSTMs 활용: 이미지 캡셔닝, NLP 모델 개선

2. OpenAI 및 테슬라(Tesla) 경력

- OpenAI 공동 창립 멤버(2016년): 강화학습, GPT 계열 모델 연구

- 테슬라 AI 총괄(2017-2022): 자율주행(Autopilot), Dojo 슈퍼컴퓨터 개발 주도

- 2023년 OpenAI 복귀: GPT-4 및 멀티모달 AI 관련 연구

3. AI 교육 및 오픈소스 기여

- CS231n (Stanford 강의): 컴퓨터 비전과 CNN을 설명하는 강의, 딥러닝 입문서로 유명

- GitHub 및 블로그 활동: Micrograd(자동미분 엔진), MinGPT(경량 GPT 구현) 등 오픈소스 프로젝트 공개

4. 최근 연구 방향

- LLM(대규모 언어 모델) 경량화

- Autonomous AI Agents 개발

- 멀티모달 AI (텍스트, 이미지, 오디오 결합)

그의 연구는 딥러닝을 실용적으로 적용하는 데 초점을 두고 있으며, 특히 자율주행, 생성형 AI, NLP, 컴퓨터 비전 분야에서 큰 영향을 미쳤습니다.

1. CNN(합성곱 신경망, Convolutional Neural Networks) 연구

안드레 카파시는 Stanford 박사 과정(CS231n 강의 포함)에서 CNN을 활용한 컴퓨터 비전 연구를 수행했습니다. 그의 연구는 특히 이미지 인식, 객체 탐지, 이미지 캡셔닝에 집중되었으며, 주요 기여는 다음과 같습니다.

① CNN 기반 이미지 분류(Image Classification)

- AlexNet, VGGNet, ResNet 같은 CNN 모델 개선 및 응용

- 딥러닝을 이용한 이미지 자동 태깅, 얼굴 인식, 객체 탐지 연구

② 이미지 캡셔닝(Image Captioning)

- CNN + RNN(LSTM) 조합을 사용해 이미지를 보고 자동으로 설명을 생성하는 연구

- 이를 통해 컴퓨터 비전과 자연어 처리(NLP) 결합

- 대표 논문: “Deep Visual-Semantic Alignments for Generating Image Descriptions” (2015)

③ 강화학습을 통한 CNN 최적화

- CNN을 강화학습(RL)과 결합해 자율주행, 로봇 비전 시스템에 적용

- 예: 테슬라 Autopilot에서 카메라 기반 도로 인식 최적화

2. AI 에이전트(AI Agent) 연구

AI 에이전트는 스스로 학습하고 의사결정을 내리는 AI 시스템으로, 카파시는 이를 여러 분야에서 연구 및 적용했습니다.

① 테슬라의 자율주행 AI (Autonomous AI Agents)

- 카메라 기반 자율주행(비디오 CNN + Transformer 조합)

- 강화학습(RL)과 지도학습을 결합해 차량의 의사결정 최적화

- Dojo 슈퍼컴퓨터 활용: 대규모 자율주행 데이터 학습

② AI Agents for Gaming & NLP

- OpenAI Gym & Dota 2 AI 연구 참여

- MinGPT 프로젝트: 경량 GPT를 활용한 AI 챗봇 개발

- 자동 코드 생성 및 디버깅 AI 연구

③ 멀티모달 AI 에이전트

- 최근 LLM 기반 AI Agents 연구 중

- 텍스트 + 이미지 + 음성 결합하여 실시간 의사결정 수행

- 예: OpenAI에서 GPT-4 Turbo 기반 AI 비서 개발

카파시의 연구는 CNN을 기반으로 한 컴퓨터 비전과 AI 에이전트 개발을 중심으로 진행되었으며, 딥러닝과 강화학습을 실용적으로 적용하는 데 큰 기여를 했습니다.

1. MinGPT (Minimal GPT) 프로젝트

MinGPT는 안드레 카파시가 만든 경량 GPT(Generative Pretrained Transformer) 구현체로, GPT 모델의 기본 개념을 단순하게 구현한 오픈소스 프로젝트입니다.

① MinGPT의 특징

- GPT 모델의 핵심 요소만 포함: 복잡한 최적화 기법 없이 Transformer 아키텍처의 기본 원리를 학습하는 데 초점

- PyTorch 기반 경량 구현: 코드가 단순하고 직관적이며, 연구 및 교육 목적으로 사용하기 적합

- 텍스트 생성 실험 가능: 작은 데이터셋에서도 자연어 생성이 가능하며, GPT의 기본 작동 방식을 이해하는 데 도움

② MinGPT의 주요 활용

- GPT 모델을 처음 접하는 연구자 및 개발자를 위한 학습 자료

- LLM(대규모 언어 모델) 개발을 위한 경량 실험 환경

- 다른 Transformer 모델을 직접 구현해보는 기반 코드

카파시는 MinGPT를 통해 "GPT 모델의 본질적인 구조와 작동 원리를 배우기 쉽게 만들고자 했다"고 설명합니다.

2. Multi-Modal AI 프로젝트

멀티모달(Multi-Modal) AI는 텍스트, 이미지, 오디오 등 여러 유형의 데이터를 동시에 처리하는 AI를 의미합니다. 최근 카파시는 OpenAI에서 이 분야의 연구를 주도하고 있습니다.

① 멀티모달 AI의 핵심 개념

- 텍스트 + 이미지 + 음성 데이터의 통합 학습

- Transformer 모델을 활용해 서로 다른 데이터 유형을 연결

- 예: GPT-4 Turbo는 텍스트뿐만 아니라 이미지 이해까지 가능

② 카파시의 멀티모달 연구 방향

- 비디오 기반 AI 분석: 장면을 이해하고 설명할 수 있는 AI 개발

- 음성-텍스트 통합 모델: 실시간 대화와 텍스트 요약이 가능한 AI

- 자율주행 AI의 감각 통합: 카메라 + 라이다 + 음성 명령을 동시에 처리하는 AI

③ 대표적인 멀티모달 AI 프로젝트

- DALL·E: 텍스트를 입력하면 이미지를 생성하는 모델

- CLIP: 텍스트-이미지 매칭을 수행하는 모델

- GPT-4 Turbo: 멀티모달 기능을 확장하여 이미지 기반 질문 응답 가능

카파시는 이러한 연구를 통해 AI가 보다 인간처럼 다양한 감각을 통합해 이해하고 반응하는 방향으로 발전해야 한다고 주장하고 있습니다.

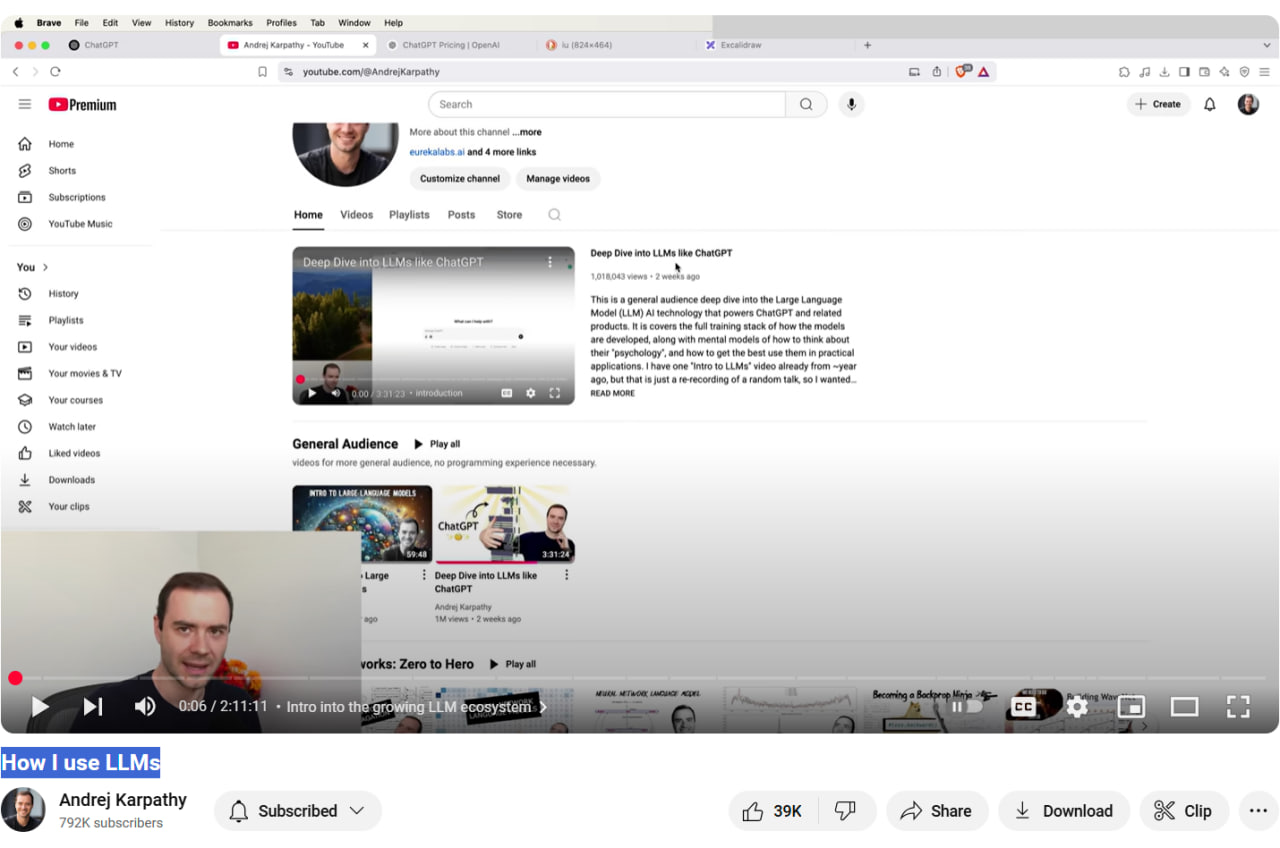

https://youtu.be/TTah-S-d_Uk?si=y-blR4W5SqLtijFg

1. MinGPT PyTorch 코드 예제

MinGPT는 Transformer 기반의 경량 GPT 모델입니다. 아래 코드는 간단한 GPT 모델을 PyTorch로 구현한 예제입니다.

import torch

import torch.nn as nn

import torch.nn.functional as F

class GPTBlock(nn.Module):

def __init__(self, embed_size, heads, dropout, forward_expansion):

super(GPTBlock, self).__init__()

self.attention = nn.MultiheadAttention(embed_dim=embed_size, num_heads=heads, batch_first=True)

self.norm1 = nn.LayerNorm(embed_size)

self.norm2 = nn.LayerNorm(embed_size)

self.feed_forward = nn.Sequential(

nn.Linear(embed_size, forward_expansion * embed_size),

nn.ReLU(),

nn.Linear(forward_expansion * embed_size, embed_size)

)

self.dropout = nn.Dropout(dropout)

def forward(self, x):

attn_output, _ = self.attention(x, x, x)

x = self.norm1(x + attn_output)

ff_output = self.feed_forward(x)

x = self.norm2(x + ff_output)

return self.dropout(x)

class MinGPT(nn.Module):

def __init__(self, vocab_size, embed_size, num_layers, heads, dropout, forward_expansion):

super(MinGPT, self).__init__()

self.embed = nn.Embedding(vocab_size, embed_size)

self.layers = nn.ModuleList(

[GPTBlock(embed_size, heads, dropout, forward_expansion) for _ in range(num_layers)]

)

self.fc_out = nn.Linear(embed_size, vocab_size)

def forward(self, x):

x = self.embed(x)

for layer in self.layers:

x = layer(x)

return self.fc_out(x)

# 모델 생성

vocab_size = 50257 # GPT 토큰 개수

embed_size = 128

num_layers = 4

heads = 4

dropout = 0.1

forward_expansion = 4

model = MinGPT(vocab_size, embed_size, num_layers, heads, dropout, forward_expansion)

print(model)2. Multi-Modal AI (CLIP) PyTorch 코드 예제

멀티모달 AI의 대표적인 예제는 OpenAI의 CLIP 모델입니다. 아래는 텍스트와 이미지를 함께 학습하는 PyTorch 코드입니다.

import torch

import torch.nn as nn

import torchvision.models as models

class MultiModalModel(nn.Module):

def __init__(self, embed_size):

super(MultiModalModel, self).__init__()

# 이미지 인코더 (ResNet50 사용)

self.image_encoder = models.resnet50(pretrained=True)

self.image_encoder.fc = nn.Linear(self.image_encoder.fc.in_features, embed_size)

# 텍스트 인코더 (간단한 Transformer 사용)

self.text_encoder = nn.Embedding(10000, embed_size)

# 최종 투영 레이어

self.fc = nn.Linear(embed_size, embed_size)

def forward(self, image, text):

img_features = self.image_encoder(image)

txt_features = self.text_encoder(text)

# 이미지와 텍스트를 같은 차원으로 정렬

img_features = self.fc(img_features)

txt_features = self.fc(txt_features.mean(dim=1))

return img_features, txt_features

# 모델 생성

embed_size = 256

model = MultiModalModel(embed_size)

print(model)설명

-

MinGPT 코드

- Transformer 기반 GPT 모델을 경량화한 버전

- 입력된 토큰을 Embedding → Multi-Head Attention → Feed Forward → 출력 구조로 처리

-

Multi-Modal AI 코드 (CLIP 유사 모델)

- ResNet50을 이미지 인코더로 사용

- 텍스트 임베딩을 Transformer 기반 인코더로 처리

- 최종적으로 두 개의 정보를 공통 임베딩 공간에 매핑

이러한 방식으로 MinGPT는 텍스트 생성, Multi-Modal AI는 텍스트-이미지 매칭 같은 작업에 활용됩니다.