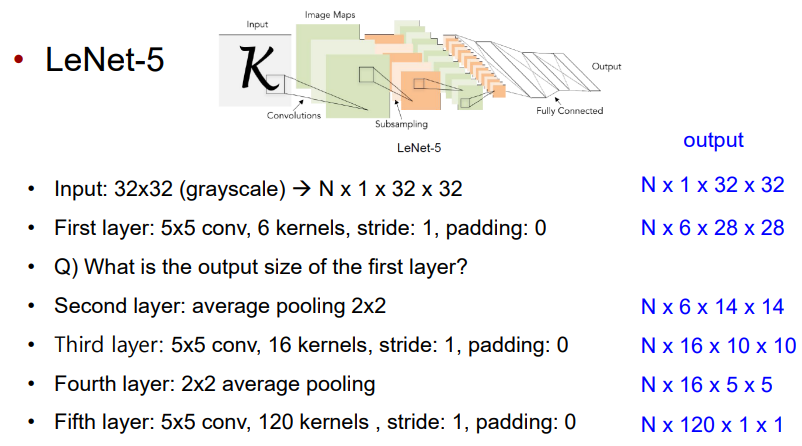

LeNet

Pooling도 마찬가지. filter size 대신 kernel size로 계산.

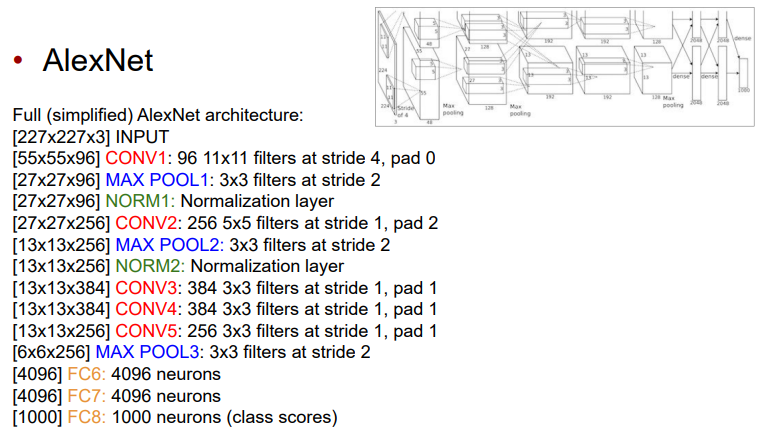

AlexNet

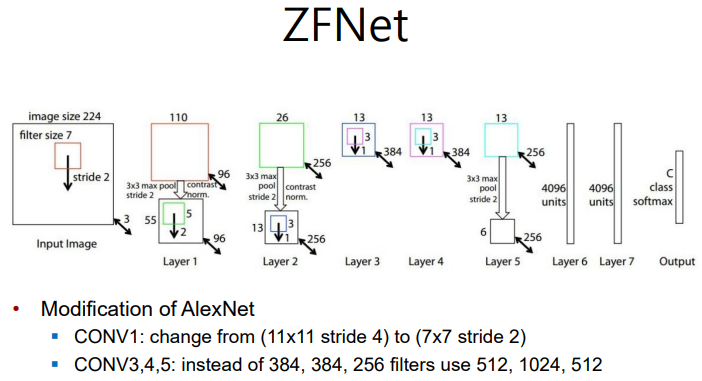

ZF-Net

- Improved hyperparameters over AlexNet

- DeconvNet: 각 layer에서의 결과를 시각화함 > 현재 layer가 잘 학습하고 있는지 판단할 수 있다.

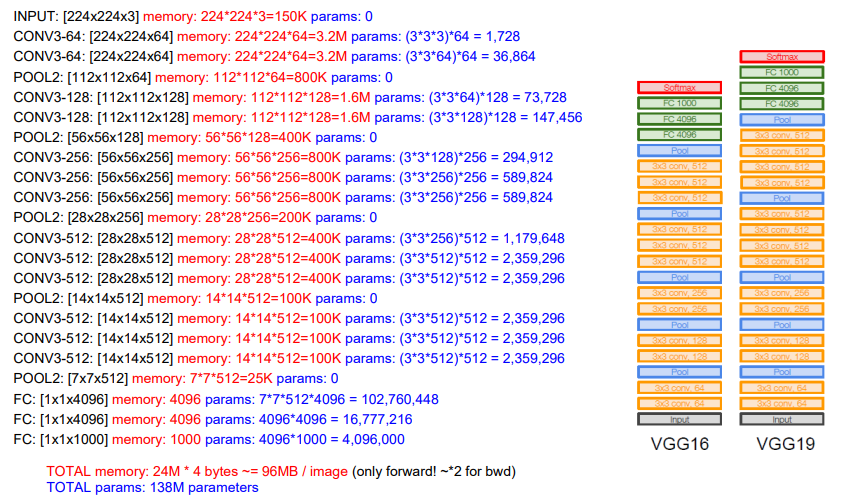

VGG

- Small filters, Deeper networks

- 8 layers (AlexNet) > 16~19 layers (VGG16Net)

- Only 3x3 CONV stride 1, pad 1 and 2x2 MAX POOL stride 2

- Parameter 수가 너무 많다는 단점

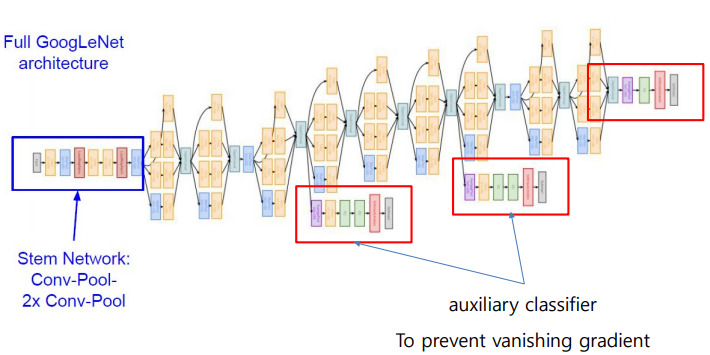

Google Net

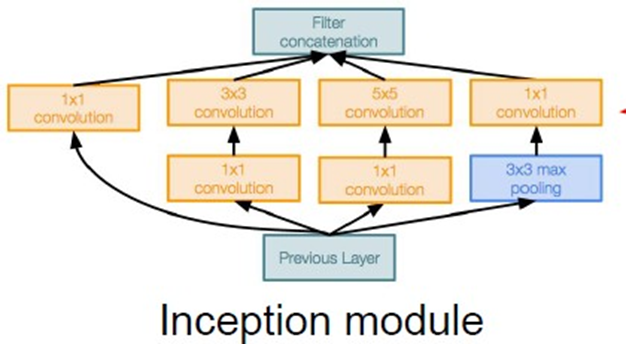

Inception module

- Input, output size가 같다.

- No FC layers

- Only 5 million parameters: 파라미터 감소

-> 1x1 conv "bottleneck" layers 사용

-> 레이어는 늘었으나 파라미터는 줄어드는 효과

- 처음에 inception input 사이즈에 맞추기 위해 조정

- 중간에 gradient가 사라지는 문제를 방지하기 위해, 중간 지점에서 gradient backpropagation을 한다.

ResNet

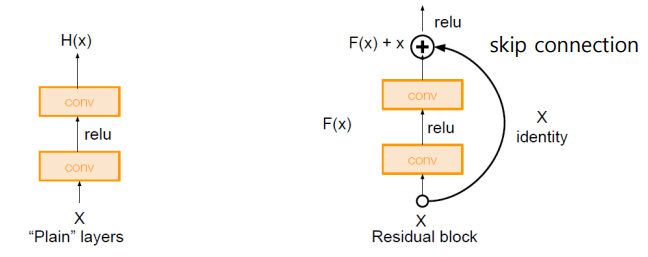

- Very deep networks using residual connection

- (기존) 단순히 layers를 추가하면, 깊어질수록 gradient가 잘 전달되지 않아 error가 커진다.

- (해결) Skip connection을 추가하여, input X를 F(x)에 더한다.

- ResNet50 이상은 bottleneck(1x1 conv)를 사용한다.

📌 Note

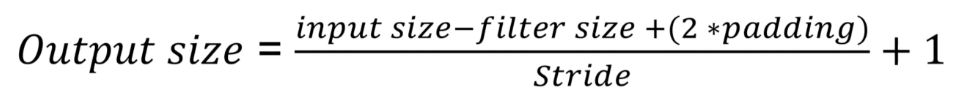

- Output size 계산하기

- Memory, parameters 계산하기

- Google net의 1x1 conv 효과