들어가기 전에 다시 한번 더 상기를

변수, X라는 데이터가 여럿일 경우에 대한 선형회귀Linear Regression를 풀기 전에 복기해봅시당

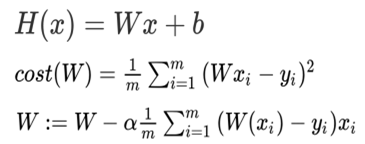

H(x)는 가설함수Hypotheis Function로 모든 데이터를 대변하는 적절한 함수입니당.

가설함수Hypotheis Function가 적용된 x의 실제 값 y와 오차를 측정해서 평균을 내서 오차의 정도를 낸 것을 비용함수Cost Function이라고 합니당.

오차에 대한 민감도+오차의 음수 문제를 해결하기 위해 제곱한다고 하였습니당.

그리고 이 오차를 최소화하기 위해 가중치W 값을 변경해주어야 하는데, 이 변경을 가능하게 하는 것이 경사하강법Gradient Descent Method(세번째)라고 합니당.

이를 통해 비용함수Cost Function 수치가 가장 적게 나오는 가중치W를 구하는 것이 머신러닝의 핵심이라고 볼 수 있겠습니당.

변수가 여럿인 경우를 고려해봐요

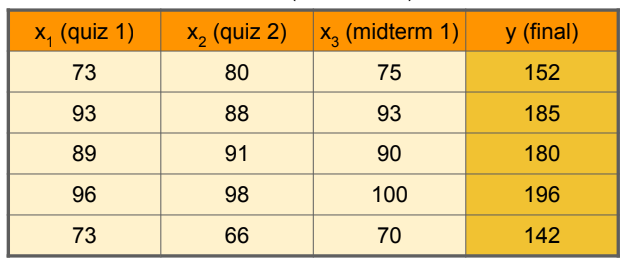

여지껏 배워온 것은 데이터x가 하나인 경우에 대한 방법이었어요.

그럼 이렇게 데이터x가 여러개면 어떻게 해야할까요? 머신러닝에서는 이 경우를 Multi-feature라고 한다고 합니당.

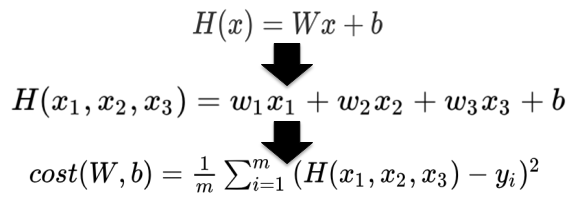

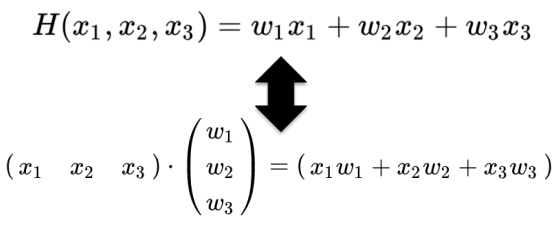

Multi-feature가 되면 가설함수Hypothesis Method를 아래와 같이 정의하면 됩니당!

변수가 여러개면 가중치W도 그 갯수만큼 여러개로 되며, 이를 그대로 비용함수Cost Function에 적용하면 됩니당

여러 변수를 편리하게!

지금이야~ 변수가 3개정도니까 표현하는데 부담이 없지만 이후 몇개가 될지 알 수가 없어요!

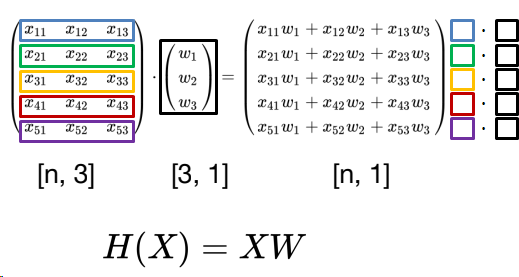

그래서 우리는 행렬Matrix를 통해 이를 간편하게 표현하면 됩니당!

콤팩트하게 행렬에 대해 설명해볼게요

좌측엔 5행 3열의 행렬, 우측엔 3행 1열의 행렬이 있습니다.

여기서 단순히 곱하는게 아닌 행렬만의 곱셈, Dot이라는 것을 수행합니당!

좌측의 행과 우측의 열을 기준으로 곱하고 더하는 것을 확인하실 수 있어용!

결과 값을 보시면 각 좌측의 행의 데이터x의 가설함수Hypothesis Method 결과가 있는 것을 확인하실 수 있고, 우리는 이를 통해 보다 간편하게 Multi-feature의 가설함수Hypothesis Method를 구할 수 있습니당!

대문자 표기와 WX가 아닌 XW로 표기

- 행렬

Matrix는 일반적으로 대문자로 표기를 합니다.TensorFlow에선 데이터 행렬X를 좌측, 가중치 행렬W를 우측으로 둬서Dot을 수행합니다. 그래서 보통 WX가 아닌 XW로 표기합니다.

후기

출퇴근 중에 계속 강의를 보며 학습하고 있지만 글쓰는데 늦어졌습니다 ㅠ 머리로는 이해하지만 이걸 글로 전개하는 건 또 다른 얘기네용...

그만큼 부족한 부분이 많다고 생각합니다! 아직 성장할 수 있는 부분이 많이 남았다고도 생각하렵니다 ㅎㅎ

보다 나은 모습으로 거듭나기 위해 계속 정진해나가겠습니다!