신경망 기초

인공신경망과 생물신경망

사람의 뉴런(neuron)

: 두뇌의 가장 작은 정보처리 단위

: 구조

= 세포체는 간단한 연산

= 수상돌기는 신호 수신

= 축삭은 처리 결과를 전송

: 사람은 10^11개 정도의 뉴런을 가지며, 각 뉴런은 약 1000개 다른 뉴런과 연결되어 10^14개 연결을 가짐

두 줄기 연구의 동반상승(synergy) 효과

: 컴퓨터 과학

= 컴퓨터의 계산(연산) 능력의 획기적 발전

: 뇌(의학) 과학

= 뇌의 정보처리 방식 규명 연구

-> 컴퓨터가 사람 뇌의 정보처리를 모방하여 지능적 행위를 할 수 있는 인공지능 도전

: 뉴런의 동작 이해를 모방한 초기 인공신경망 연구시작

=> 퍼셉트론 고안

사람의 신경망과 인공신경망 비교

| 사람 신경망 | 인공 신경망 |

|---|---|

| 세포체 | 노드 |

| 수상돌기 | 입력 |

| 축삭 | 출력 |

| 시냅스 | 가중치 |

신경망의 종류

인공 신경망은 다양한 모델이 존재함

- 전방 신경망과 순환 시경망

- 얕은 신경망과 깊은 시경망

-> 은닉층의 양 차이

결정론 신경망과 확률론적 신경망 비교

- 결정론 신경망

-> 모델의 매개 변수와 조건에 의해 출력이 완전히 결정되는 신경망 - 확률론적 신경망

-> 고유의 임의성을 가지고 매개변수와 조건이 같더라도 다른 출력의 가지는 신경망

퍼셉트론

- 구조

: 절(node), 가중치(weight), 층(layer)과 같은 새로운 개념의 구조 도입 - 제시된 퍼셉트론 구조의 학습 알고리즘을 제안

- 원시적 신경망이지만, 깊은 인공신경망을 포함한 현대 인공신경망의 토대

-> 깊은 인공신경망은 퍼셉트론의 병렬 배치를 순차적으로 구조로 결합함

=> 현대 인공신경망의 중요한 구성 요소가 됨

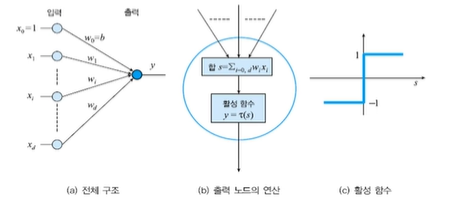

구조

퍼셉트론의 구조

- 입력

: i 번째 노드는 특징 벡터의 요소 xi를 담당

: 항상 1이 입력되는 편향(bias) 노드 포함 - 입력과 출력 사이에 연산하는 구조를 가짐

: i번째 입력 노드와 출력 노드를 연결하는 변(edge)는 가중치 wi를 가짐

: 퍼셉트론은 단일 층 구조라고 간주함 - 출력

: 한 개의 노드에 의해 수치(+1 혹은 -1) 출력

=> bias는 T라는 임계점의 위치를 0점으로 옮기는 역할을 한다.

동작

퍼셉트론의 동작

-

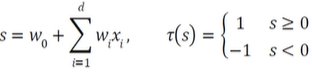

선형연산 -> 비선형연산

: 선형 - 가중치의 합

: 비선형 - 활성함수를 적용 -

수식

y = T(s)

-

행렬 표기

y = T(W^T*X)로 정리 가능하다. -

결정직선

w1x1 + w2x2 + w0 = 0 을 생각했을 때

w1,w2는 직선의 기울기, w0는 절편(편향)을 결정

공간을 2분할 하는 존재.

2차원은 결정직선, 3차원 결정정 평면, 4차원 이상 결정 초평면(decision hyperplane)이 된다.

학습

퍼셉트론의 학습

- 지금까지 학습을 마친 퍼셉트론의 동작을 설명

: 일반적인 분류기의 학습과정

- 과업 정의와 분류과정의 수학적 정의(가설설정)

- 해당 분류기의 목적 함수 J(세타,w)정의

- J(세타,w)를 최소화하는 세타,w 찾기 위한 최적화 방법 수행

-> w벡터를 어떻게 찾는 것이 중요하다. (가중치)

목적함수 정의(1+2)

- 퍼셉트론(가설 혹은 모델 설정)의 매개변수 w

매개변수 집합은 세타 = {w}

- 목적합수를 J(세타) 또는 J(w)로 표기

- 퍼셉트론 목적함수 상세 조건

: J(w) >= 0

: w가 최적이면 J(w) = 0

: 틀리는 셈플이 많은 w일 수록 J(w)는 큰 값을 가진다.

경사 하강법(gradient descent)

: 기울기를 이용하여 반복 탐색하여 극값을 찾음

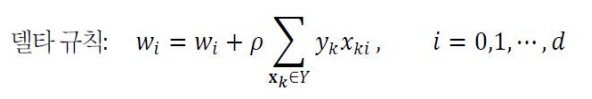

델타규칙 = wi + 1 = wi + learningrate * j(wi)'