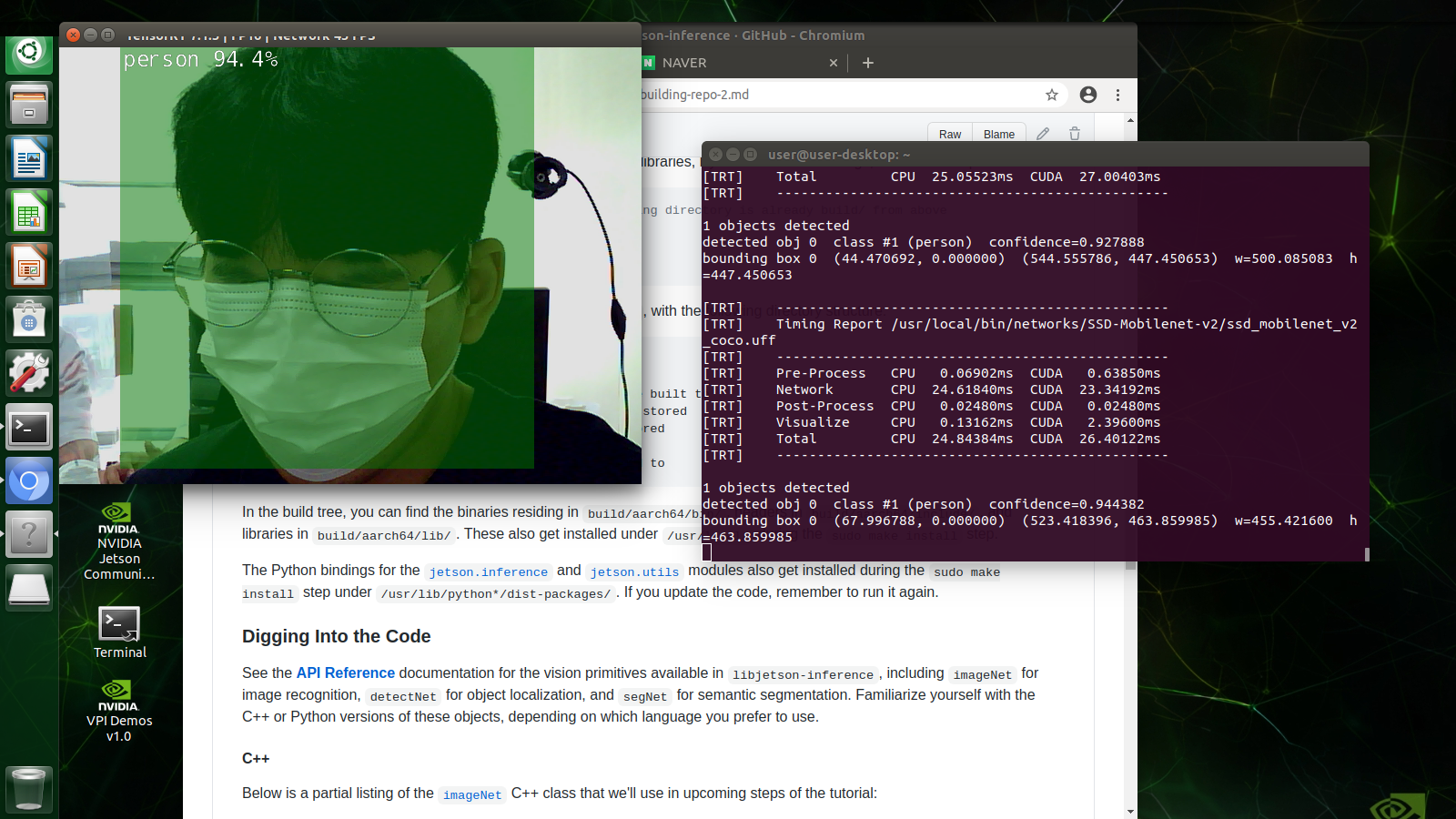

jetson-inference

https://github.com/dusty-nv/jetson-inference/blob/master/docs/building-repo-2.md

kind of detection

SSD and yolo are famous

SSD : training using pytorch

we'll use pytorch

detectnet

가까운 거리에서 빠르게 탐색하지만 원거리에서의 탐색은 좋지 않음

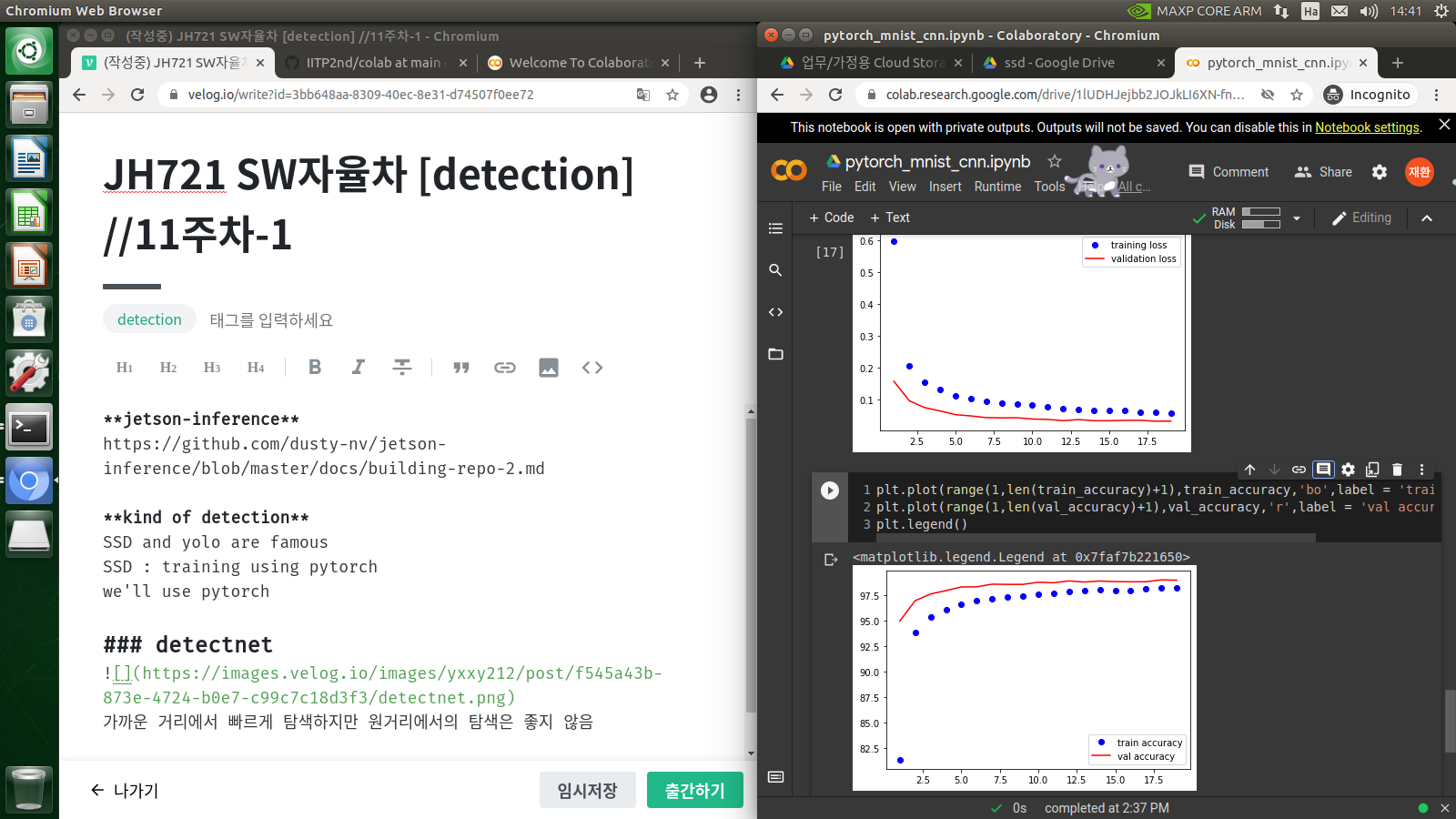

pytorch

다양한 네트워크

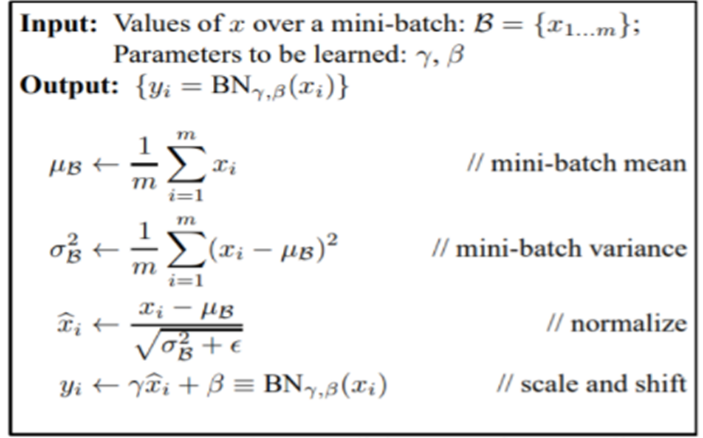

배치 정규화(Batch Normalization)

네트워크 안에 들어가는 레이어 개념으로 네트워크가 깊어지면서 vanishing gradient이 생기는 것을 방지한다.

3) Hidden layer 사이의 Activation Func 앞에 들어가면서 히든레이어의 아웃 풋 값을 받아서 Normalization(정규화)를 해준다.

4) Normalizaion 한 데이터 값을 다시 Batch Normalization을 해준다.

-> normalization을 하면서 평균 0, 분산 1의 그래프를 띄게 되고 BN을 이용해 Scaling과 Shift를 해준다.

BN의 장점

- 파라미터의 의존성이 떨어짐

- 학습속도가 빨라짐

- 오버피팅을 발생이 적어짐

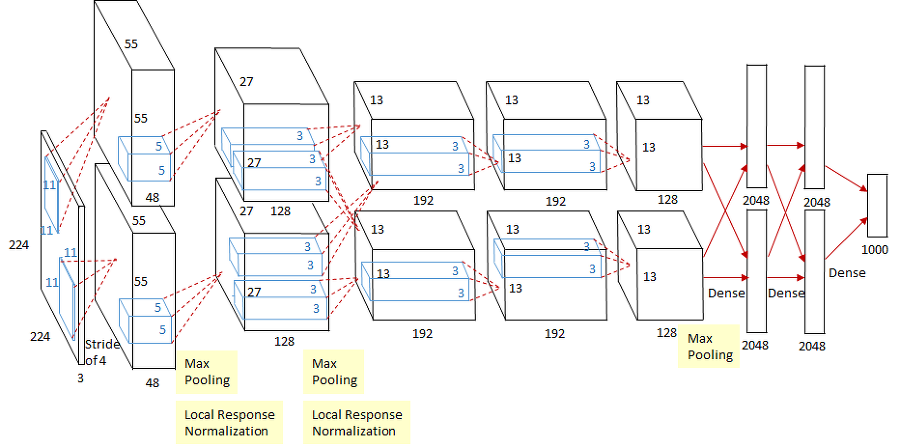

AlexNet

Conv layer와 Pooling layer을 거치면서 마지막에 FC layer로 결과를 출력합니다.

Conv layer를 거치면서 특징을 뽑아내고 FC 층게서 행렬 곱으로 차원을 축소하고 마지막에 소프트 맥스 함수를 이용해서 10개의 클래스를 구별하였습니다.

AlexNet이 최초로 사용한 것

-

최초 딥러닝기반으로 우승

-

최초 ReLu 함수 사용

conv 층 다음에 활성화 함수인 ReLu를 사용

ReLu 함수는 딥러닝 발전에 큰 도움을 주었고 아직까지 많이 사용되고 있다. -

최초 GPU 사용

2개의 GPU를 사용해서 사진처럼 두개부분에서 연산을 했습니다.

GPU는 병렬연산의 최적화 되있기 때문에 많은 샘플 이미지들을 학습할 수 있었음

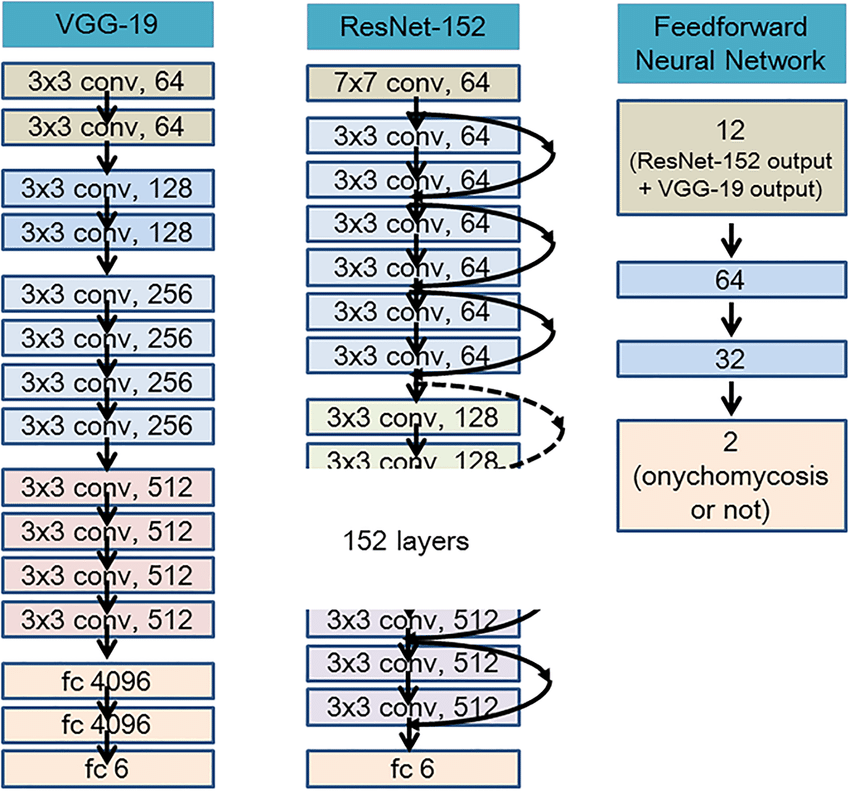

VGGNet

단순하면서 성능 좋은 네트워크

특징

AlexNet에 비해 큰 사이즈의 필터가 필요 없고 3x3과 1x1 필터만을 사용

AlexNet보다 레이어의 수가 늘어날 수 있습니다.(11~19)

1x1 conv를 사용했음

적은 사이즈의 필터를 반복하는 단순한 구조로 높은 정확도를 얻을 수있다.

GoogLeNet

구글이 만들고 모두가 사용하는 네트워크

정식 명칭은 Inception v1~v4

특징

22계층으로 이루어졌음 / 효과적인 인셉션 모듈

네트워크 마지막에 AGP가 FC를 대체함

AlexNet에 비해 파라미터 개수가 12배 적습니다.

GoogLeNet은 Network In Network(NIN)이라는 자층 퍼셉트론, 1x1 conv layer, GAP(Global Average Pooling) 세가지 개념이 있음

Network In Network(NIN)

다층 퍼셉트론(MLP) -> 인셉션 모듈

레이어 깊어지면 파라미터 많아짐 -> 파라미터 많으면 오버피팅 일어남

또한, 많은 학습하면 배니싱 그레이디언트 문제가 생김

So, 파라미터 자체를 줄이자

-> 인셉션 모듈을 개발하였고 동일한 입력에 대해 서로 다른 크기/유형의 회선을 갖고 모든 출력을 쌓는 것.

conv 연산 후 풀링과 FC로 마무리 되는 일련의 과정 = 모듈

이 모듈을 다양한 스케일의 필터를 이용한 것이 마이크로 네트워크라는 단일 구조의 모듈이 됨

1x1 convolution layer

1x1 conv layer는 ReLu함수와 함께 이용 되기 때문에 NIN 개발자는 이로써 더 많은 비선형성을 도입하여 네트워크의 표현력을 향상시킴(책 P.50-51 참조)

GAP

구글넷이 흥미로운 점 마지막에 FC 레이어를 사용하지 않는 것

GAP는 Pooling 방식이기 때문에 특징 맵의 특징은 효과적으로 추출하고 오버피팅을 방지

7x7을 평균내서 1x1로 만들면 1x1x1024가 됨(가중치x)

보조 분류기

네트워크에서 그레디언트 소실 문제를 해결하고 정규화를 제공하는 역활을 함

ResNet

첫번째 레이어에서 edge를 학습, 두 번째 shape를 학습, 세 번째 object를 학습, 네 번째는 더 나아가 눈과 같은 작고 구체적이고 대상을 학습하는 동의 방식이다.

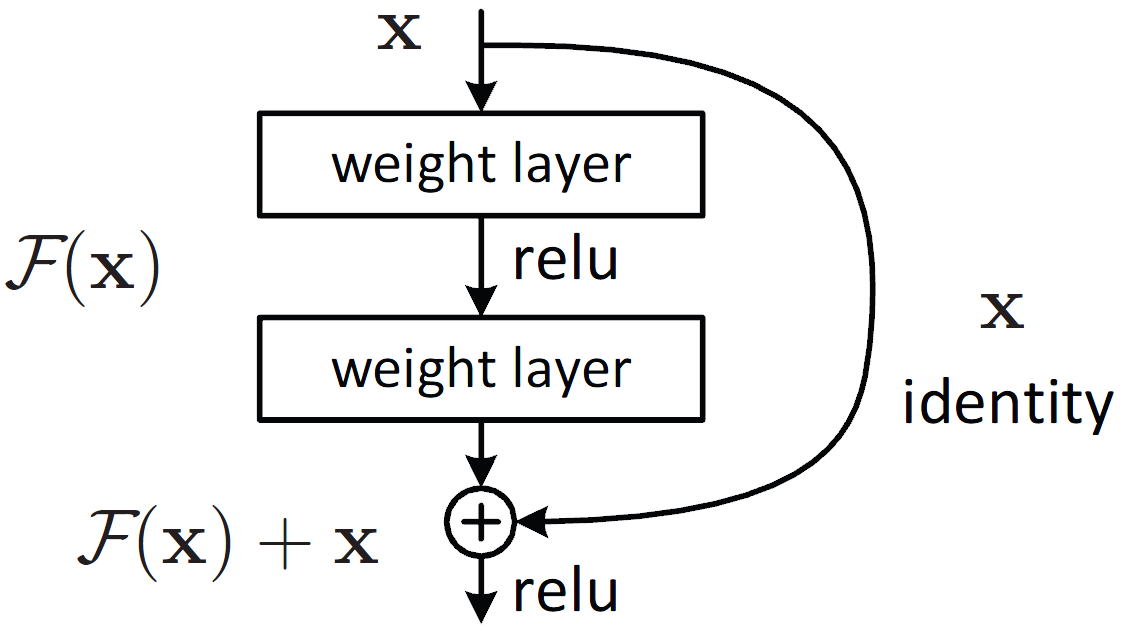

잔차 블럭(Residual Block)

F(x)+x 공식은 숏컷으로 피드 포워드(정방향)신경망을 구현할 수 있음

숏컷 연결은 위의 그림에 표시된 하나 이상의 레이어흫 건너 뛰는 역결.

아이덴티티 매핑을 수행하고 그 수행한 출력이 스택 된 레이어의 출력에 추가됨

resnet 설명(확인해보자):

https://lv99.tistory.com/25