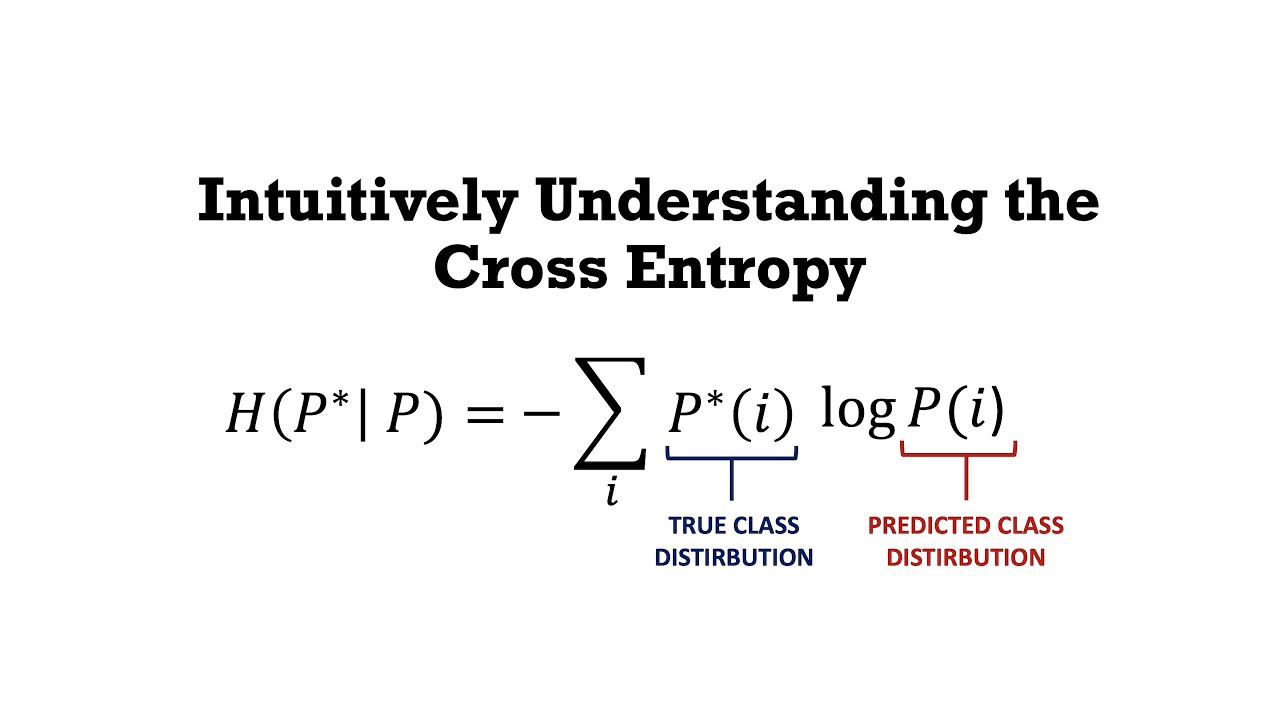

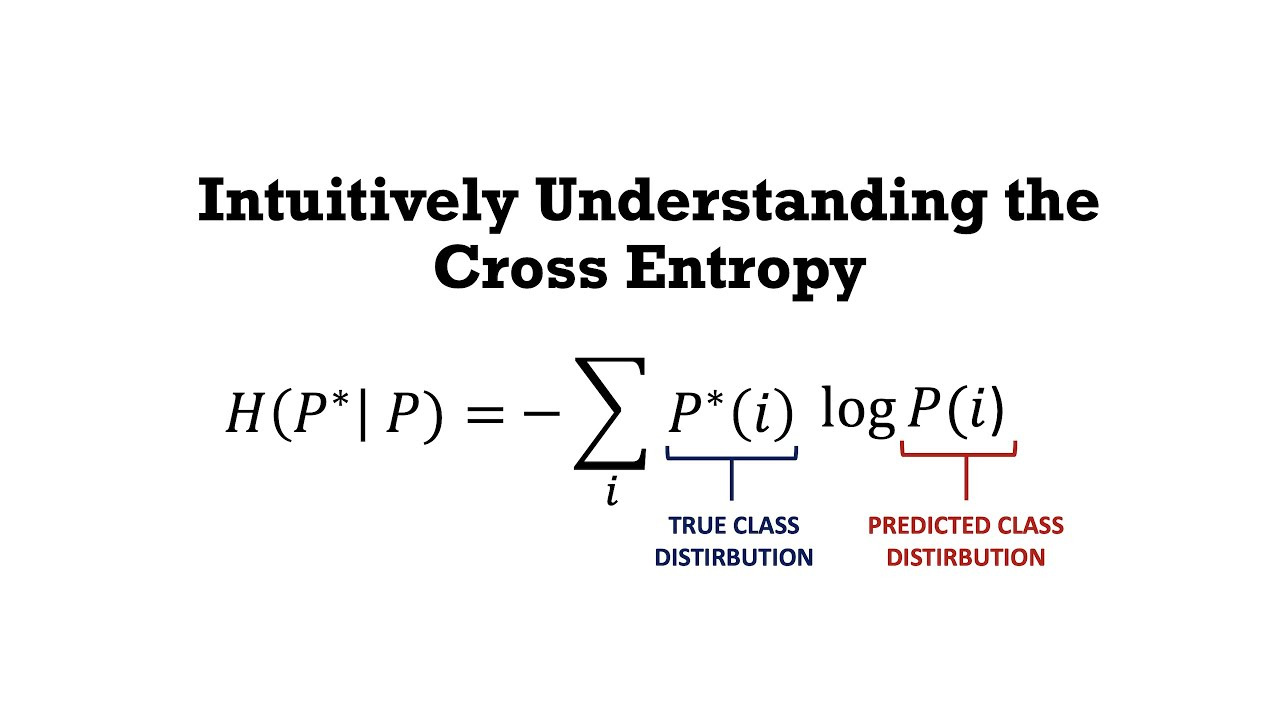

크로스 엔드로피 : Cross-Entropy

0과 1을 추출하는 Classification에서 사용

: 사진처럼 True Class 일 때와 Predicted class 일 때가 나뉘여 값이 남는다.

Loss 사용 이유:

실제값과 예측값을 차이(dissmilarity)를 계산하기 위하여

Entorpy란 무엇?:

Entropy한 불확실성에 대한 척도

예를 들어 랜덤의 공을 꺼낼 때, 비율이 반반이라면, 어떤 공이 자주 관찰될지 예측할 수 없기 때문에

Entropy가 크다고 할 수 있다.

=>Entropy 는 예측하기 쉬운 일에서보다, 예측하기 힘든일에서 더 높다.

Cross-Entropy:

머신 러닝의 분류 모델이 얼마나 잘 수행되는지 측정하기 위해 사용되는 지표

예측한 값과 예측하고자 하는 값을 통해 차이를 계산하는 것

당신의 시간이 헛되지 않는 글이 되겠습니다.

I'll write something that won't waste your time.