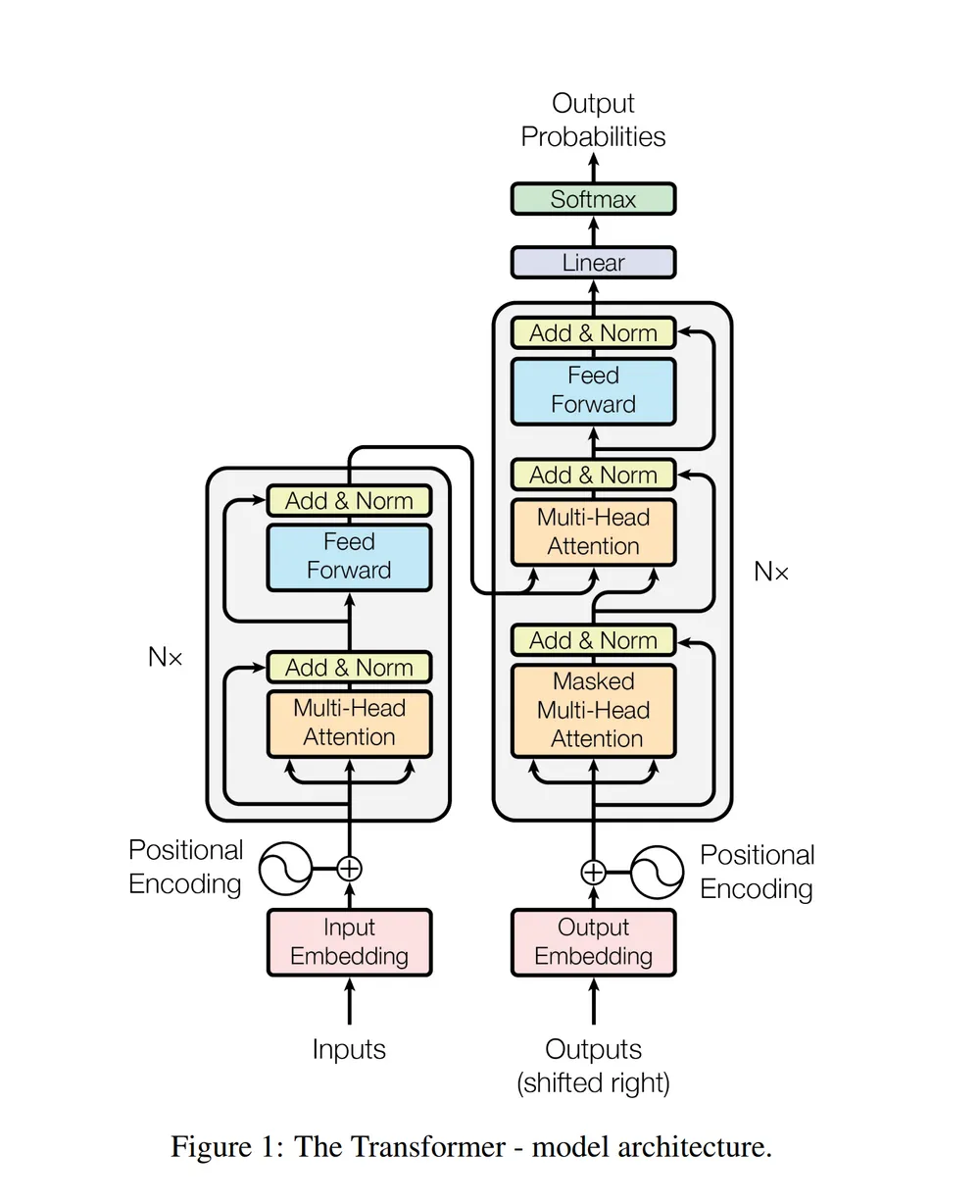

[Transformer A to Z] 4. Encoder block(residual connection, Position-Wise Feed-Forward Networks)

0

Transformer

목록 보기

4/5

Residual connection, Normalization

-

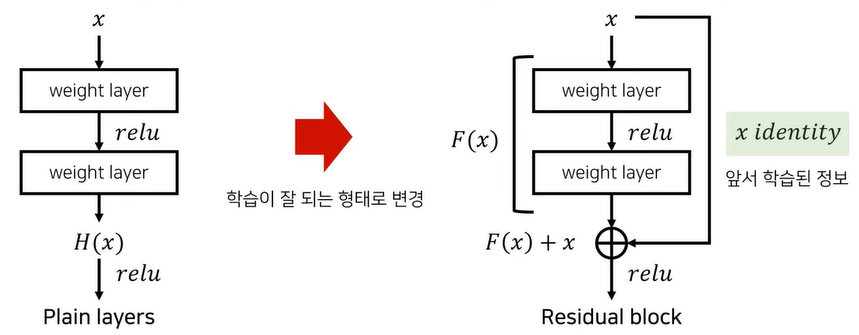

인공신경망을 학습할 때 깊은 모델이 더 좋은 성능을 낼 것이라 생각할 수 있는데, 일정 깊이에 도달하면 오히려 정확도가 감소하는 경향을 보인다. (deep residual learning for image recognition 논문 참고)

-

이를 해결하기 위한 것이 residual connection이다.

-

일반적인 feed-forward 방식의 신경망에서, 입력값이 출력까지 한 방향으로 전달되는 구조인데,

-

residual connection은 일부 레이어를 건너뛰어 데이터가 신경망 구조의 후반부에 도달하는 또 다른 경로를 제공한다.

자세한 설명은 이 링크 참고

자세한 설명은 이 영상 참고

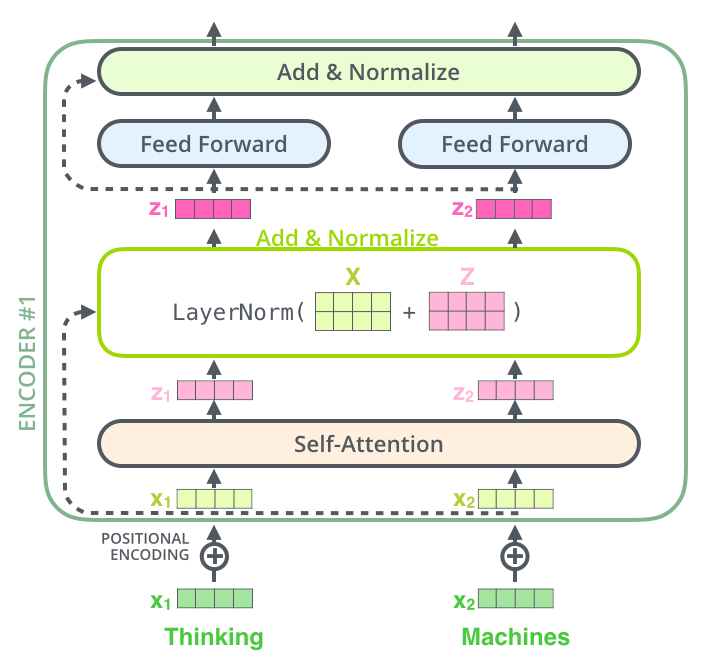

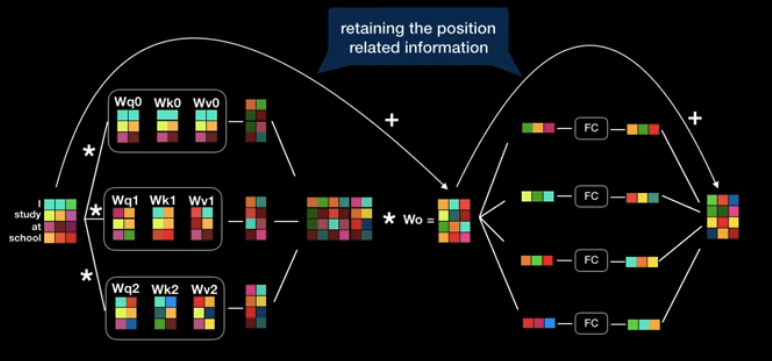

- 각 encoder, decoder 내의 sub-layer는 residual connection으로 연결되어 있고, 그 후에는 layer-normalization 과정을 거친다.

이를 시각화하면

Position-wise Feed-Forward Networks

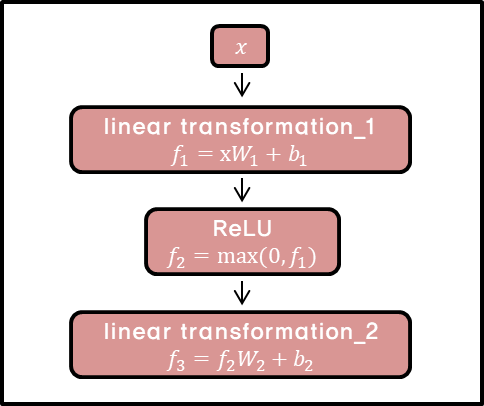

- 인코더와 디코더 모두 feed-forward neural network(FFN)를 가지고 있다.

- position 마다, 즉 개별 단어마다 적용되기 때문에 position-wise이다.

- 2번의 선형 변환과 ReLU 활성화함수를 이용한다.

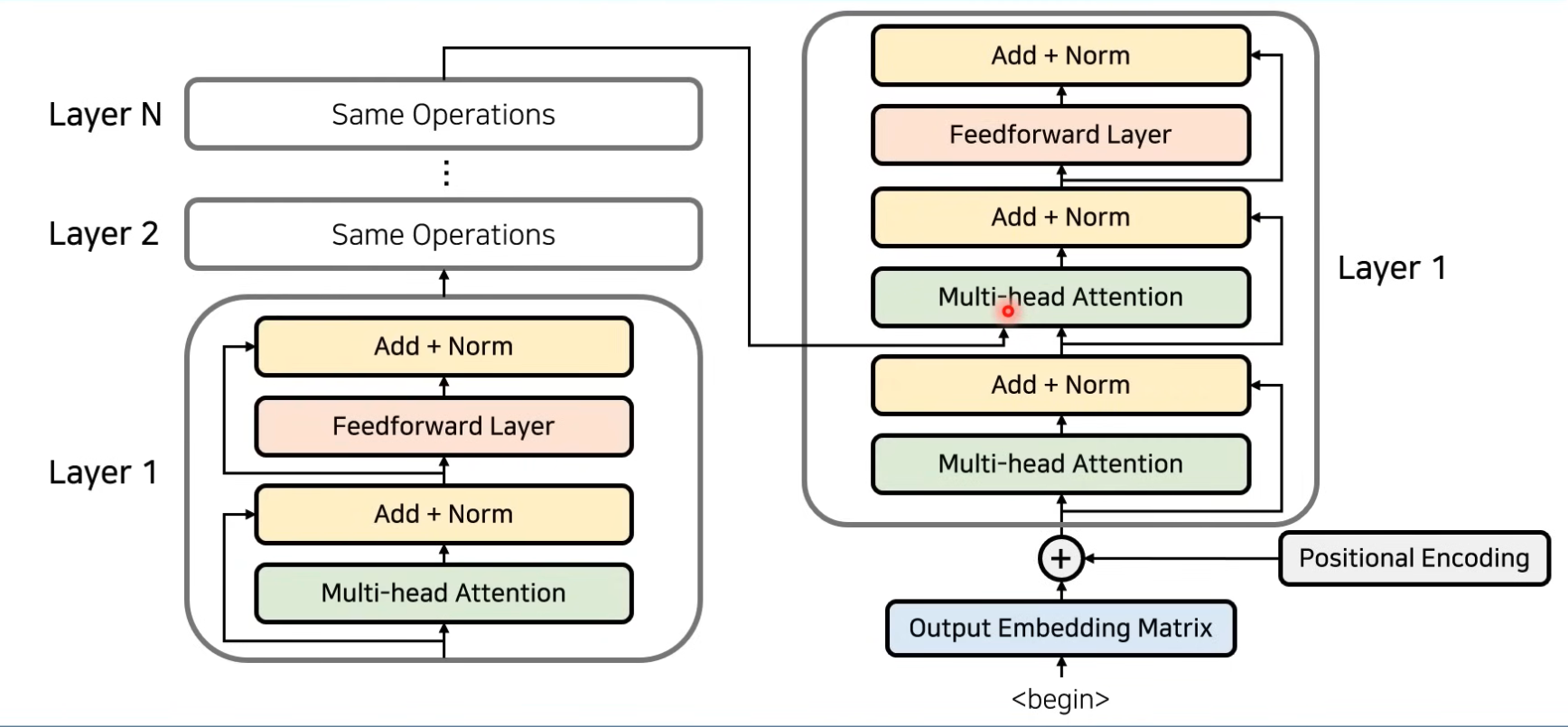

Encoder block 정리

이후, 인코더의 마지막 레이어에서 나온 출력값이 디코더에 들어가게 된다.

Reference

위키피디아

ratsgo 블로그

pozalabs 블로그

동빈나 유튜브