NLP

1.[논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

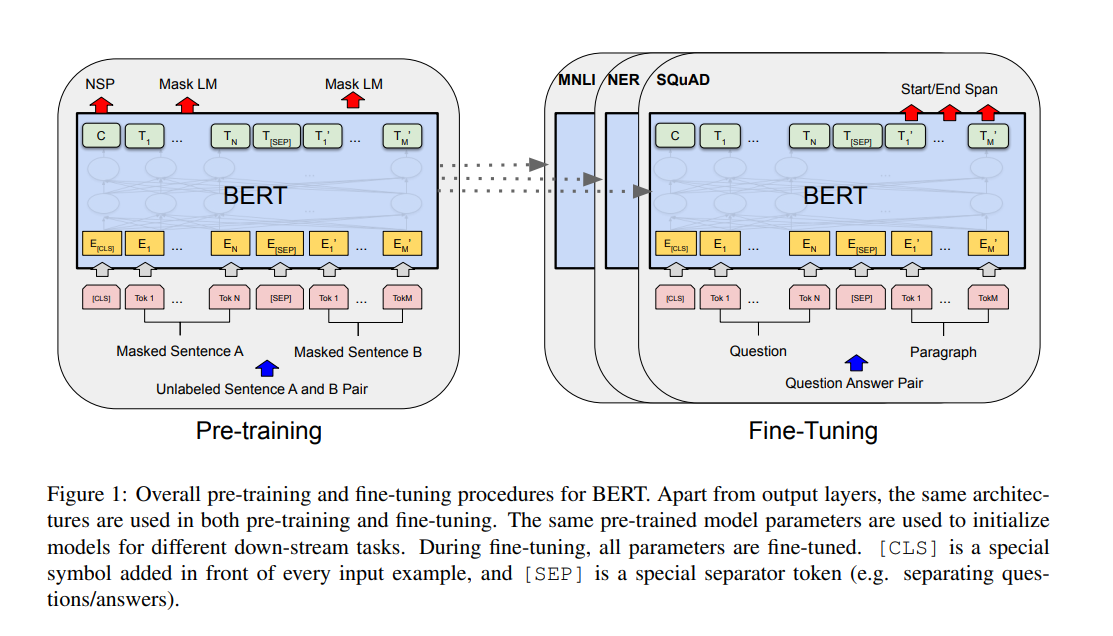

💡 BERT?Bidirectional Encoder Representations from TransformersBERT 논문의 원본은 여기에서 확인할 수 있다.Language model pre-training은 많은 NLP task의 성능을 향상시킬 수 있다. pre

2023년 8월 11일

2.[논문 리뷰] ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

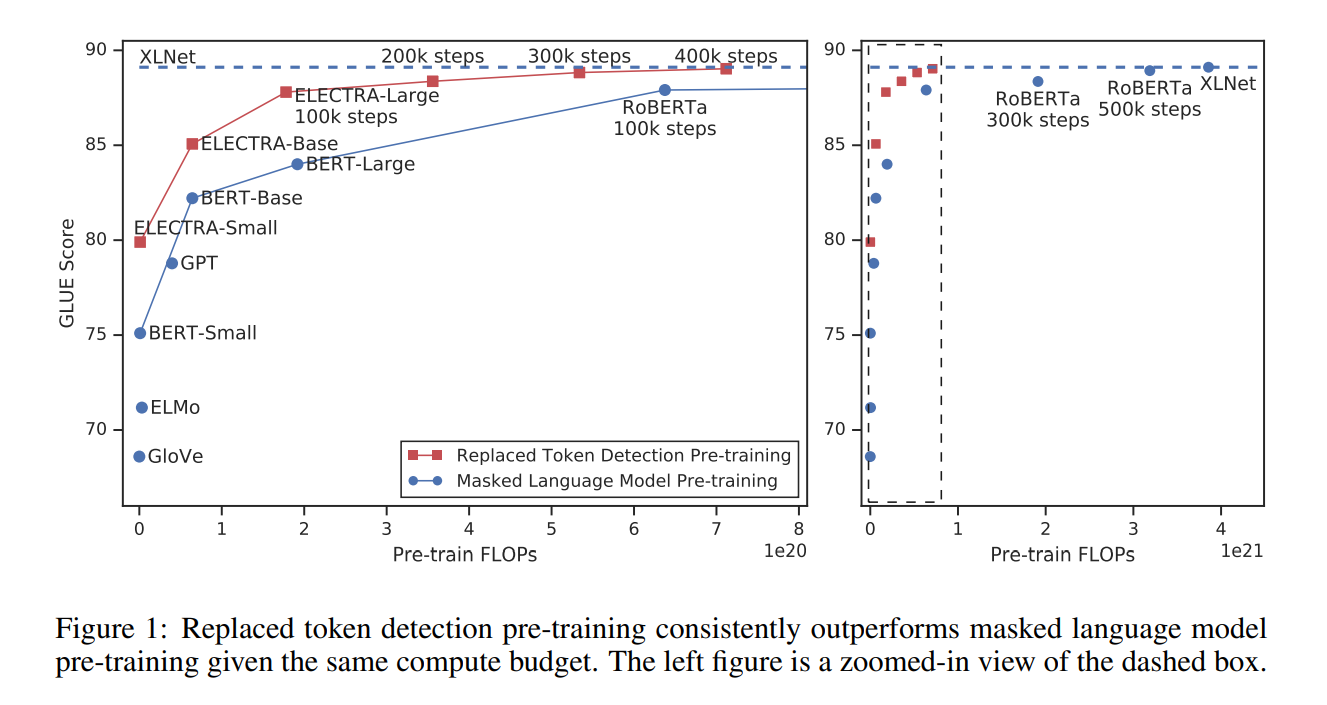

💡 ELECTRA?Efficiently Learning an Encoder that Classifies Token Replacements AccuratelyELECTRA 논문의 원본은 여기에서 확인할 수 있다.BERT에서 사용하는 pre-training 방법인 Mas

2023년 8월 26일

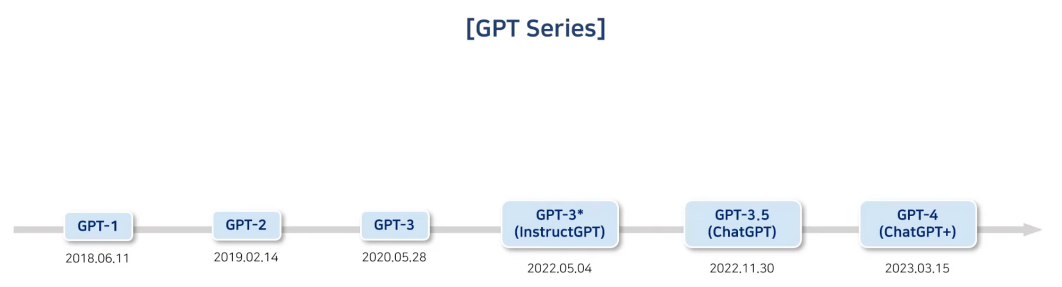

3.InstructGPT

논문은 여기에서 확인할 수 있다.InstructGPT는 기존의 GPT-3의 문제점을 해결하고자 GPT-3가 세상에 나온지 2년 후 출시되었다.GPT-3의 근본적인 문제점은 다음과 같다.문맥적으로는 맞는 말일지 모르나, 사실과는 다른 말을 지어낼 수 있다.편향적이거나 유

2023년 9월 3일