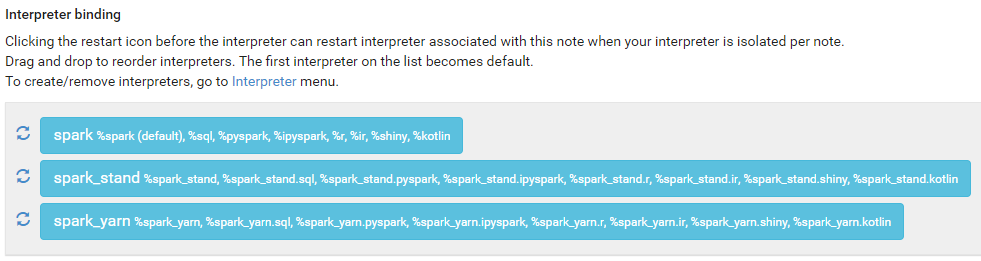

%spark

sc.master

res1: String = local[*]ubuntu에서 jps로 확인하면 SparkSubmit이 작동중인 것 확인 가능

sc.version

res2: String = 3.2.1기본적으로 scala 사용

%pyspark

sc.master

'local[*]'python으로 사용하기 위해서는 %pyspark를 사용함

%pyspark

sc.version

'3.2.1'%spark_stand

%spark_stand

sc.master

res1: String = spark://spark-master-01:7177jps에서 SparkSubmit이 추가로 동작하는 것을 확인할 수 있음

spark master web ui: http://spark-master-01:8180/ 에서 Running Applications (1) -> Name -> Zeppelin_STAND 확인 가능

Running Applications (1) -> Application ID에서 5개의 executor 확인

$ ssh spark-worker-01 /skybluelee/jdk8/bin/jps에서 worker 01~03을 확인하면 총 executor가 5개임을 확인할 수 있음

%spark_stand.pyspark

sc.master

'spark://spark-master-01:7177'마찬가지로 pyspark를 사용하여 python으로 구동 가능

%spark_yarn

%spark_yarn

sc.master

res1: String = yarnyarn web ui: http://spark-master-01:8188/ 동작 확인 가능

ID -> Attempt ID -> Container ID에서 6개의 executor 확인 가능. yarn은 application master가 항상 존재하기 때문. 첫번째만 1024 Memory, 1 VCores이고 이후부터 진짜 executor임. header가 존재하기 때문에 3072 Memory, 2 VCores와 같이 설정한 memory보다 값이 적음

hdfs web ui: http://spark-master-01:9870/explorer.html#/user/spark/.sparkStaging 에서 yarn web ui의 application 값이 동일한 것을 확인할 수 있음