Painter논문의 후속 논문입니다. Painter 논문을 안보셨으면 리뷰를 한번 보고 오시기 바랍니다.

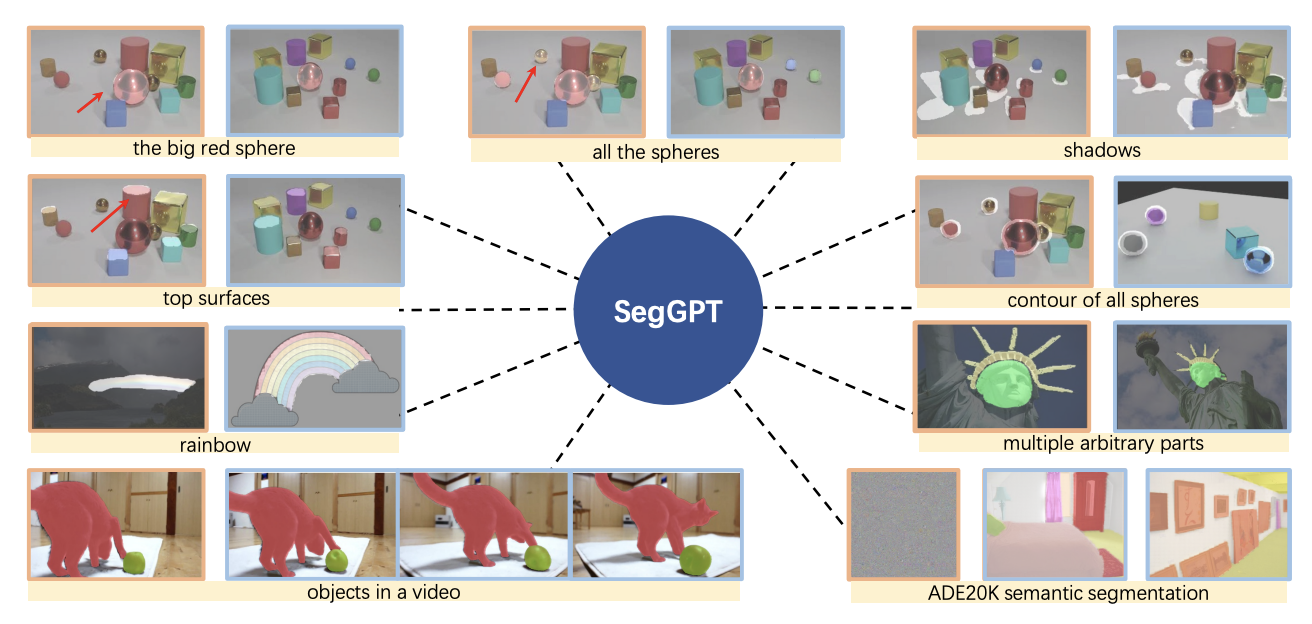

이름이 SegGPT라 GPT와 연관이 되어있을 것 같지만 원래 이름은 segment everything with a generalist Painter입니다.

전체적인 내용은 Painter논문과 유사하기 때문에 어떤 부분이 바뀌었는지 접근법만 간단하게 살펴보겠습니다.

Approach

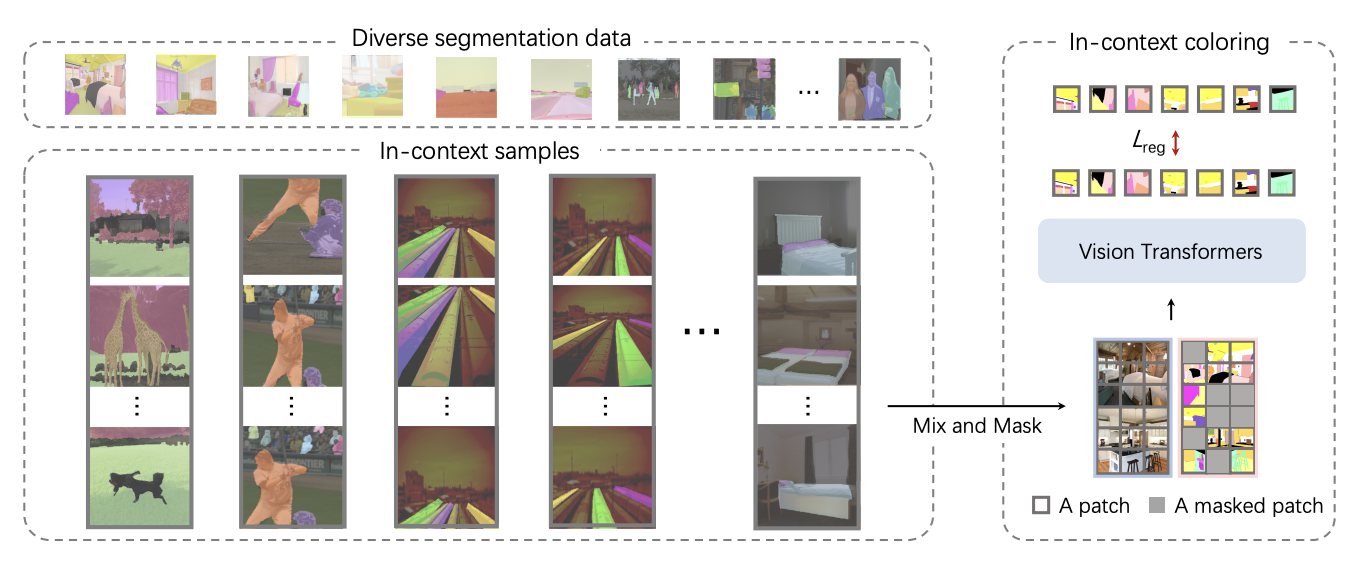

In-context coloring

기존 방법인 Painter의 경우 semantic segmentation은 카테고리에 따른 색상이 사전에 정해져 multi task learning으로 솔루션이 축소됩니다.(이 말이 정확히 의미하는 바를 이해하지 못했지만 주어진 카테고리외의 카테고리는 segment할 수 없다는 의미인 것 같습니다)

instance object의 색상은 location category를 따릅니다. 이러한 방법은 segment간의 관계를 사용하기보다 color에만 집중하게 된다고 합니다.

위 문제를 해결하기위해 논문에서는 random coloring scheme를 제안합니다. 이는 data에서 비슷한 context의 이미지(same category)를 선택하여 target이미지에 랜덤한 색을 할당합니다(=re-coloring).

이렇게 함으로써 model이 task를 결정하기위해 특정한 color에 의존하기보다 contextual information에 더 집중해서 배우도록합니다.

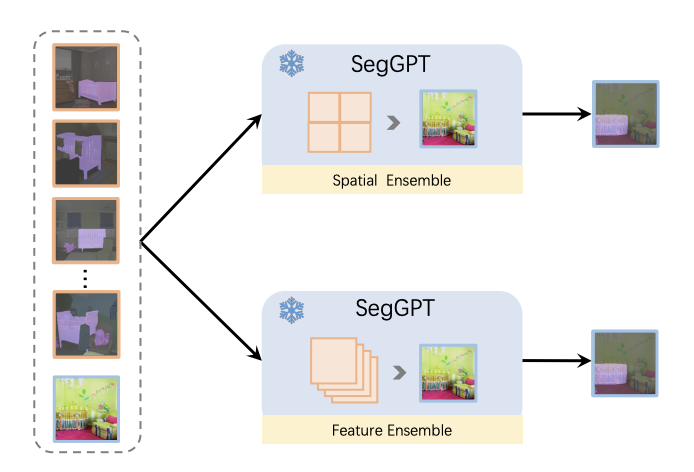

Context ensemble

훈련을 끝내고 나서 추론을 시행할 때 segment하고자 하는 input image와 함께 여러개의 example image를 사용할 수 있습니다.

Spatial ensemble

여러개의 이미지를 그리드 이미지로 붙여서 input image와 같은 크기의 single image로 만듭니다. 이러한 방법은 추가적인 계산 비용 거의없이 context를 추출할 수 있습니다.

Feature ensemble

example 이미지(=query image)를 batch dimension으로 합치고 query iamge의 특징이 attention layer이후에 평균화 된다는 점을 제외하면 독립적으로 계산됩니다.

이는 중간 layer에서 feauter를 상호작용하게 하였고 prompt의 수에 제한이 없도록 합니다.

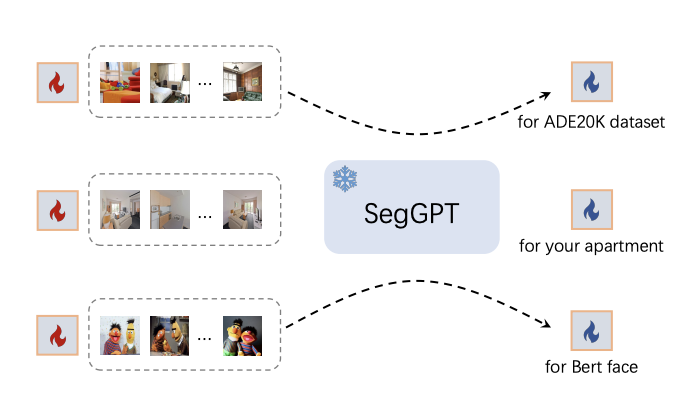

In-context tuning

이 부분이 제일 이해가 되지 않았는데 모델을 freeze한 후 learnable image tensor를 사용하여 훈련때 update한다고 합니다. Tuning하고 난 이후에는 학습된 이미지 텐서를 가져와 특정 application을 위한 plug-and-play key로 사용합니다.

Result

one, few shot에서는 굉장히 좋은 성능을 보였습니다.

In-context tuning에서는 in-domain내의 간단한 표시기로 색상을 사용하는 것이 어렵습니다. Painter와 기존 모델보다 좋지못한 지표를 보였는데 random coloring scheme 때문에 최적화가 어렵기 때문입니다. 논문의 모델은 성능이 목표가 아니라 일반화가 목표이고, 개선할 여지가 충분하다고 합니다.

Discussion & Conclusion

논문에서 제시한 모델은 in-domain과 out-domain segmentation 등의 task에서 강력한 성능을 보여줍니다. 그러나 random coloring regime 방법이 훈련을 어렵게 만들기에 ADE20K와 같이 충분한 훈련데이터가 있는 경우 성능이 낮아질 수도 있습니다.

모델의 크기를 키우거나 self-supervised를 이용해 성능을 더 높일 여지가 남아있습니다.

기존 방법인 Painter의 경우 semantic segmentation은 카테고리에 따른 색상이 사전에 정해져 multi task learning으로 솔루션이 축소됩니다.(이 말이 정확히 의미하는 바를 이해하지 못했지만 주어진 카테고리외의 카테고리는 segment할 수 없다는 의미인 것 같습니다)

이 뜻이 아니고요 여기서 말하는 카테고리는 task의 카테고리입니다 사진 보시면 painter 논문의 경우 task마다 색이 균일하잖아요? 그럼 그 색보고 아 이 색이니까 너는 sementic segmantaion이구나 뭐 이런느낌이라는거에요