Airflow

1.Step 1. Mac M1에 AirFlow 설치하기

오늘은 Airflow 설치를 실습해본다. 이후에는 간단하게 DAG을 생성하는 작업까지 해볼 것 이다.최근에는 데이터 엔지니어링, AIOps등의 필요성에 대해 고찰해보면서 뭔가 Airflow, Kafka등에 대해 미리 실습해보면 좋을 것 같아서 일부 내용을 실습해보려고

2024년 12월 8일

2.Step 2. Airflow 에서 DAG 생성해보기, API 데이터 호출 후 Parquet 형태로 저장하기

Step1에서 Airflow 설치에 관해서 실습하였다. 이번에는 DAG를 생성해서 데이터를 수집해 Parquet 형태로 저장하는 Flow를 실습해보려고 한다. Step1을 통해 이미 Airflow가 Docker위에 띄워진 상태여야 한다. Airflow에서는 파이프라인을

2024년 12월 8일

3.Step 3. Splunk에서 데이터를 추출해 그 결과를 외부 API와 결합한 결과 저장하기 / Splunk / Airflow

오늘은 Splunk에서 IP 데이터를 추출해 그 결과를 whois 에 조회한 후 Splunk Index에 다시 Collect 하는 프로세스를 구축해볼 것 이다.이는 DAG로 여러개의 Operation을 작성하면 되는데, 그냥 파이썬 코드를 작성하면 된다.환경은 로컬 환

2024년 12월 22일

4.Airflow 기본 DAG 삭제하기

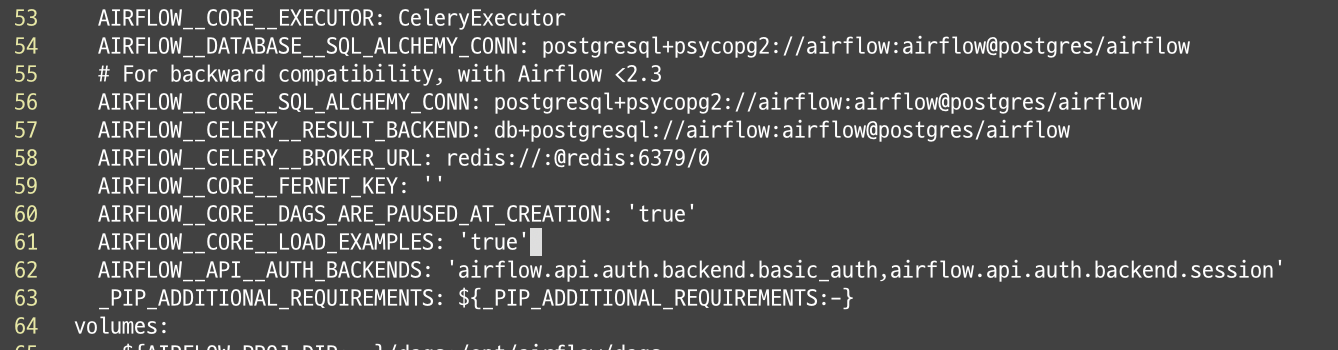

Airflow를 설치하면 기본으로 load되는 DAG들이 있다... 먼가 신경쓰이기 때문에 이걸 없애줄 것 이다.docker-compose.yaml를 열어준다.AIRFLOW\_\_CORE\_\_LOAD_EXAMPLES 문구를 찾는다.true로 된 속성을 false로 바

2024년 12월 29일