오늘은 Airflow 설치를 실습해본다. 이후에는 간단하게 DAG을 생성하는 작업까지 해볼 것 이다.

최근에는 데이터 엔지니어링, AIOps등의 필요성에 대해 고찰해보면서 뭔가 Airflow, Kafka등에 대해 미리 실습해보면 좋을 것 같아서 일부 내용을 실습해보려고 한다.

일단 설치는 너무 간단해서 쓸게 없었다..

사전 환경

- 도커 설치되어 있어야함

0. 파이썬 가상환경 활성화

python3 -m virtualenv --python=3.9 airflow

activate airflow

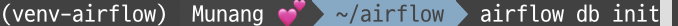

user 명 옆에 괄호친 부분이 가상환경 명으로 나오면 된다.

1. Airflow 다운로드

mkdir airflow

pip install apache-airflow2. docker-compose 파일 다운로드

curl -LfO 'https://airflow.apache.org/docs/apache-airflow/2.5.1/docker-compose.yaml'3. docker 띄우기

docker compose up4. 초기 환경 설정

1) 사용자 권한 설정

mkdir -p ./dags ./logs ./plugins

echo -e "AIRFLOW_UID=$(id -u)" > .env

AIRFLOW_UID=500002) airflow DB 초기화 하기

airflow db init

초기화 한 후 airflow.cfg 파일이 있는지 보면 된다.

5. docker 재실행

docker-compose down

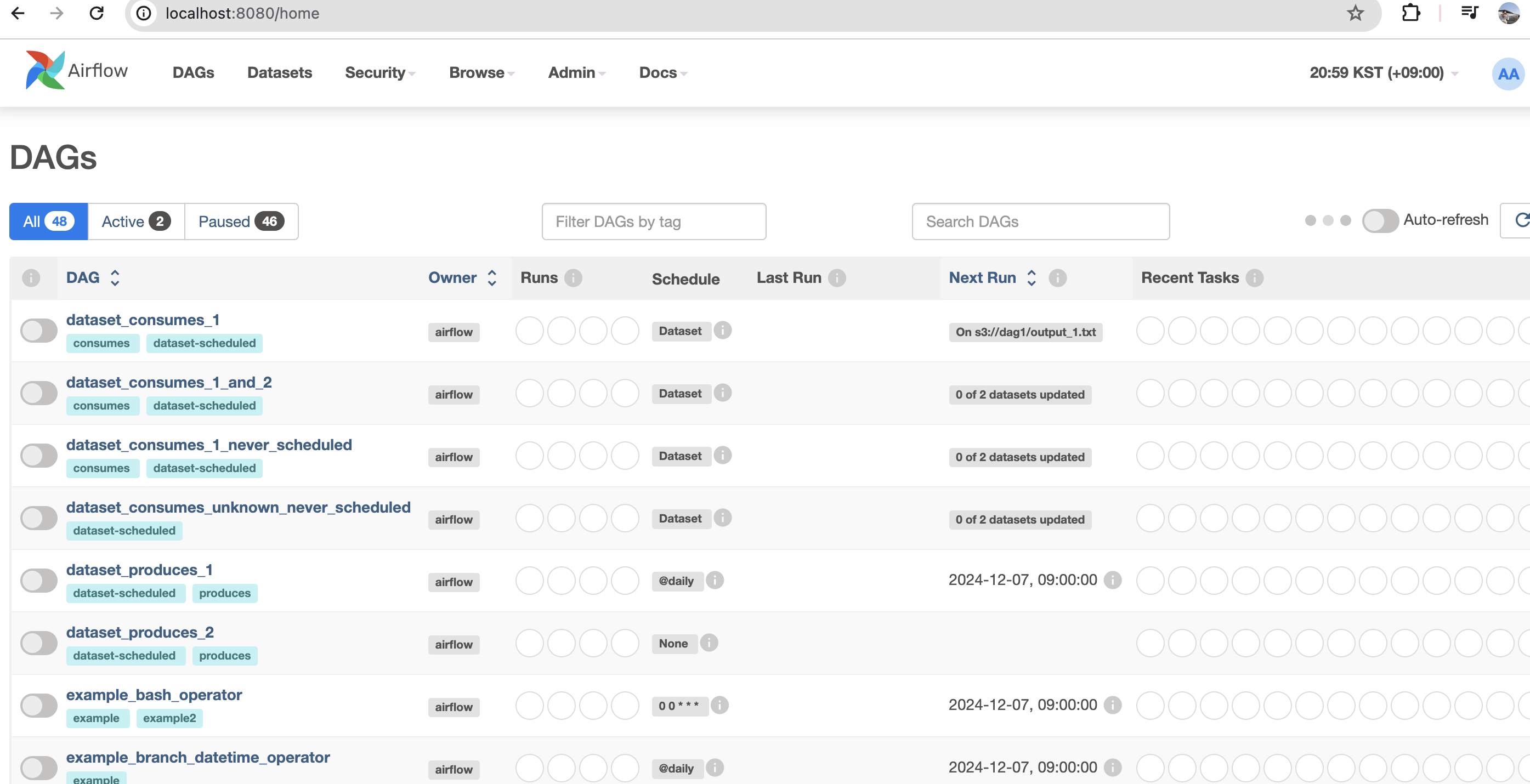

docker-compose up 6. airflow 페이지 접속하기

localhost:8080 으로 접속 후 디폴트 계정인 airflow/airflow를 입력하면 된다.

설명이 너무 초라하지만.. 정말 이게 끝이다.. 설치가 됐댜..

다음에는 DAG를 생성해서 데이터를 수집해보겠다.