오늘 공유드릴 논문은

https://arxiv.org/abs/1903.08689

Implicit Generation and Modeling with Energy-Based Models

라는 논문으로 2019년 NeurIPS에 publish된 논문입니다.

Energy based model은 일반적인 Generative model (VAE, GAN, flow-based model)과 비교했을 때 데이터 분포의 likelihood를 modeling하는데 있어서 몇가지 장점을 가지고 있습니다 (Energy 함수가 data distribution에서 나온 샘플에 대해서는 낮은 에너지값, 그 외 다른 입력에 대해서는 높은 에너지값을 가지기만 하면 되는 모델을 학습하기 때문에 간단하고 다양한 모델에 일반적으로 적용할 수 있다는 장점).

그러나 훈련 시에, implicit generation (MCMC sampling)을 통해 훈련을 진행한다는 문제도 존재합니다. -> high dimension에서는 계산이 많아 오래걸리고 quality를 보장하기 어려움.

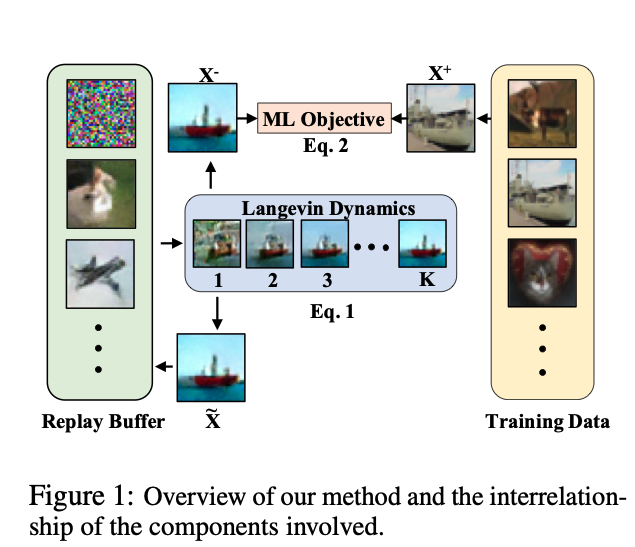

본 논문은 MCMC based EBM training의 scale을 확장할 수 있는 technique(Replay buffer)을 소개하는 논문으로, 이미지에 해당하는 high-dimensional data domain에서 성공적인 implicit generation을 통해 EBM training을 수행함을 강조합니다.

Replay buffer가 왜 성공적인 sampling을 가능케 하는지에 대해 간단하게 설명해보면,

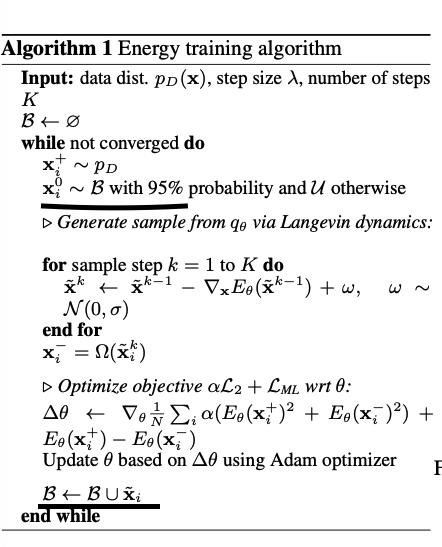

Stochastic Gradient Langevin Dynamics sampling을 진행하게 될 때, 일반적으로 initialization하는 샘플은 noise sample로 두고 K번의 iteration을 거쳐 샘플링을 진행합니다. 이 때 , iteration이 클수록 모델의 샘플을 실제 데이터 샘플에 가까워지는 것으로 알려져 있습니다.

본 논문에서는 Replay buffer를 사용하여

- refine past sample을 계속해서 사용할 수 있습니다.

a. Replay buffer에서 95%는 이전 step의 샘플을 뽑아내고, 5%는 uniform noise로부터 뽑습니다. - sampling step K의 수를 증가시킬 수 있고, sample diversity 또한 증가할 수 있다고 합니다.