영상으로 보기: https://www.youtube.com/watch?v=PJxIx3lIbTQ

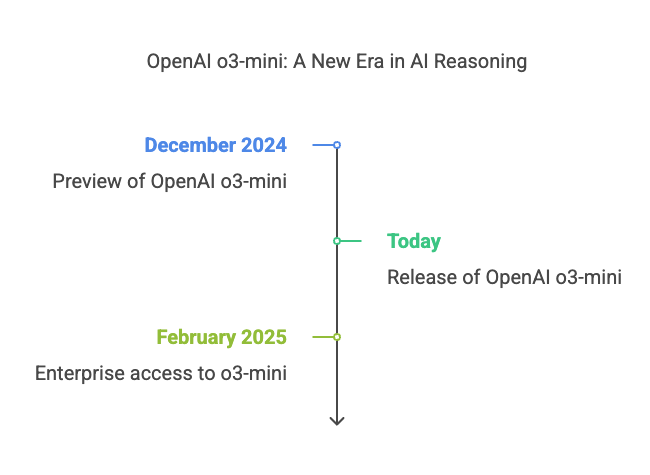

금일 OpenAI에서 새로운 모델인 o3를 공개했습니다. 이 모델은 12월 preview에서 처음 공개되었는데 이제 ChatGPT 웹사이트를 통해서 사용할 수 있습니다.

o3 모델은 현재까지 openAI에서 공개한 추론 모델중 가장 경쟁력있는 가격으로 제공됩니다.

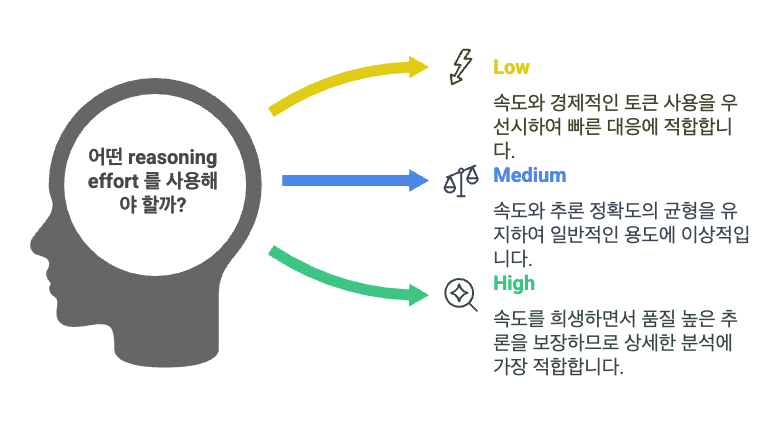

o3-mini 성능

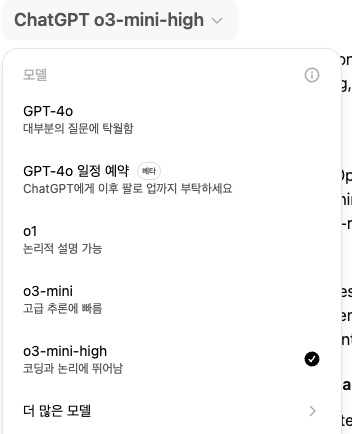

현재 o3모델은 chatGPT 무료 유저는 reason 모드로만 제공하고 Plus, Team, Pro 유저는 o3-mini, high 버전을 사용할 수 있습니다.

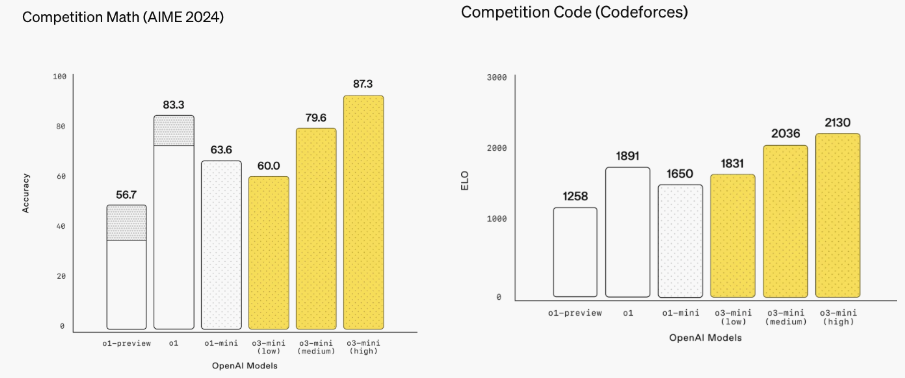

o3 mini는 o1-mini보다 빠른 응답을 제공하며 더 높은 추론 설정으로 o1 보다 더 정확한 답변을 제공합니다. 첫번째 토큰이 응답되기까지 평균 시간을 비교해보았을 때 o3-mini는 o1-mini와 비교해 2500ms 만큼 더 빠릅니다.

OpenAI 팀은 o3-mini가 o1-mini를 대체할 수 있다고 공식적으로 이야기했습니다.

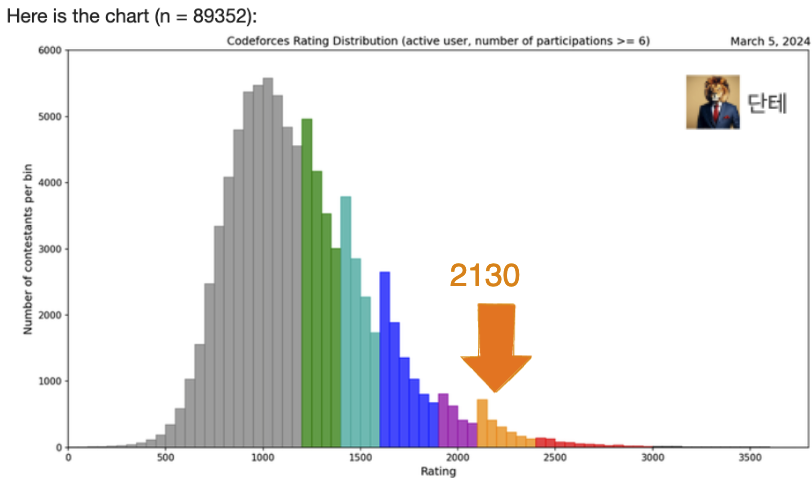

지금까지의 연산/추론 벤치마크에서 다른 openAI의 모델과 비교했을 때 더 좋은 점수를 보여주며 Codeforces의 경우 상위 1%의 실력을 보입니다.

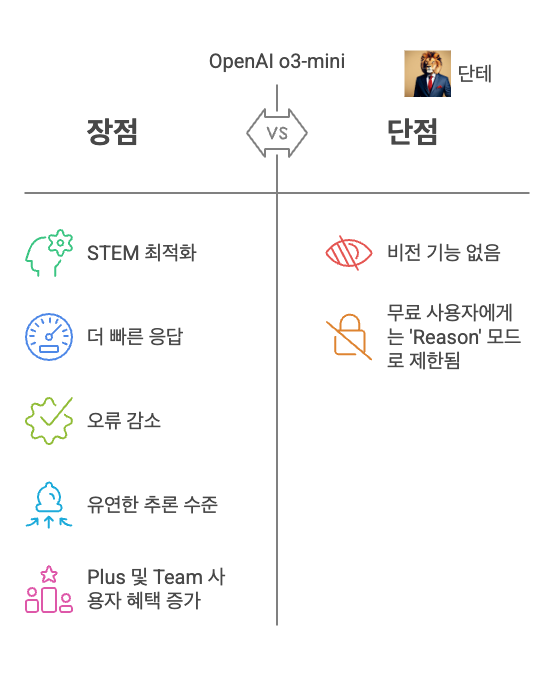

컨텍스트 윈도우

컨텍스트 윈도우는 모델이 한 번에 처리 할 수있는 최대 토큰수입니다. 다시 말해, 이전 대화의 토큰을 정의하고, 지난 대화를 통해 모델에 입력된 토큰들을 다음 응답을 생성하기위한 컨텍스트로 사용합니다. 컨텍스트 윈도우가 더 넓을수록 모델은 현재 대화 맥락에 맞게 응답할 확률이 올라가기에 대화의 질이 높아집니다.

o3-mini의 컨텍스트 윈도우는 200,000 토큰인데 o1-mini (128,000)와 비교했을 때 더 높은량을 소화할 수 있습니다. o3-mini의 컨텍스트 윈도우 토큰은 o1(o1-mini가 아님)과 동일합니다.

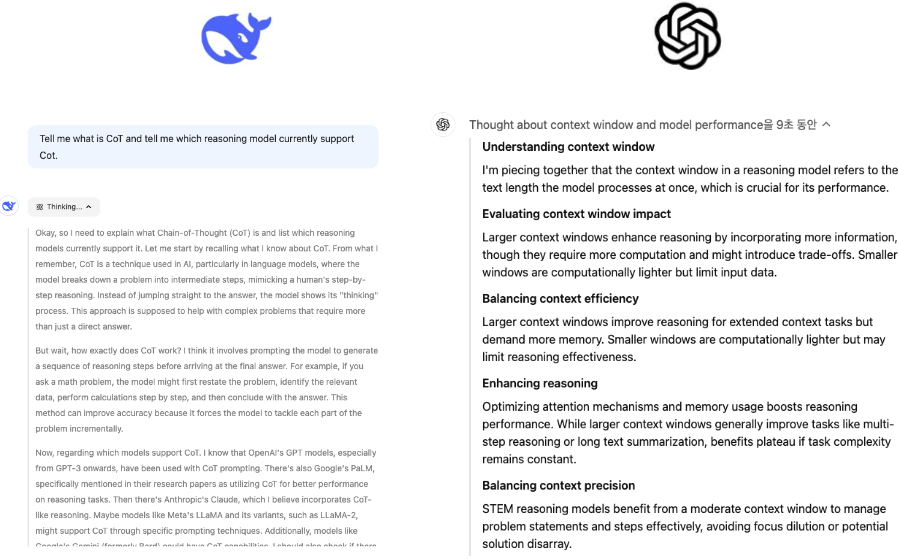

CoT(Chain of Thought)

CoT는 복잡한 작업을 중간 추론 단계로 나누어 문제 해결을 향상시키기 위해 인공 지능, 특히 언어 모델과 함께 사용되는 프롬프트 기술입니다. 직접적인 답을 바로 제공하는 대신 일련의 논리적 단계를 생성하여 인간과 같은 추론을 모방합니다. 이 접근법은 수학 연산, 상식 추론과 같은 멀티 스텝 분석이 필요한 작업의 성능을 향상시킵니다.

CoT를 투명하게 공개하는 R1과 요약 버전만 공개하는 o3-mini

CoT를 공개하지 않는 것은 경쟁사가 유사한 방법으로 경쟁모델 개발을 하거나 유저가 허용되지 않은 정보를 열람(Jail Break)하는 것을 막기 위해서입니다. R1은 CoT를 공개하여 큰 인기를 얻었는데, 이에 대응하여 CoT의 요약본만을 공개

하는걸로 타협한 것으로 보입니다.

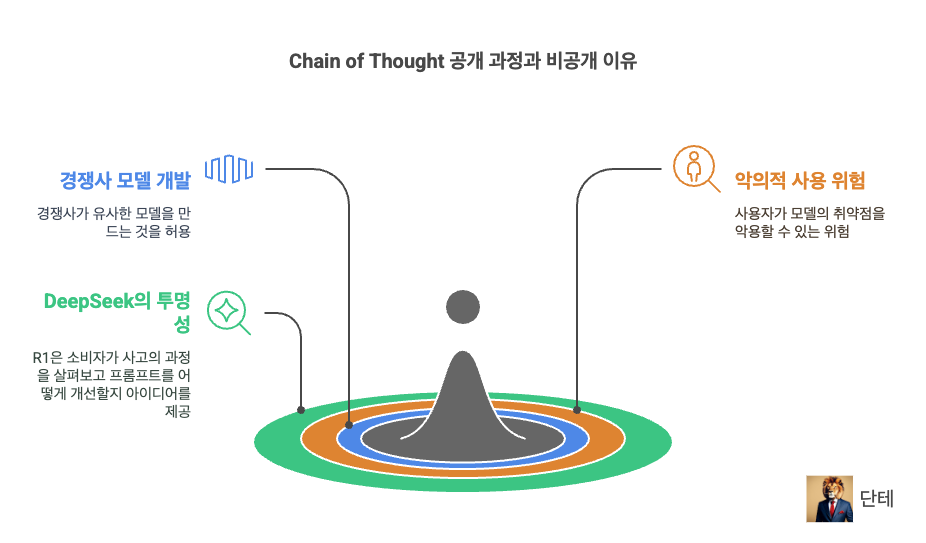

추론 레벨

개발자들은 이번 o3-mini버전을 API를 통해서도 사용할 수 있습니다. 다음은 자바스크립트를 통해 모델 추론을 사용하는 예제 코드입니다.

import OpenAI from "openai";

const openai = new OpenAI();

const prompt = `

Write a bash script that takes a matrix represented as a string with

format '[1,2],[3,4],[5,6]' and prints the transpose in the same format.

`;

const completion = await openai.chat.completions.create({

model: "o3-mini",

reasoning_effort: "medium",

messages: [

{

role: "user",

content: prompt

}

],

store: true,

});

console.log(completion.choices[0].message.content);예제 코드 옵션의 reasoning_effort가 눈에 띄는데 높은 응답 속도로 괜찮은 수준의 토큰응답을 원하거나 응답이 속도를 희생해서라도 높은 수준의 추론 응답을 받기를 원하는 용도에 따라 옵션을 설정할 수 있습니다.

한가지 아쉬운 점은 o1-mini와 마찬가지로 비전 추론을 제공하지 않기에 이미지를 업로드하여 사용하기 위해서는 o1버전을 사용해야 합니다.

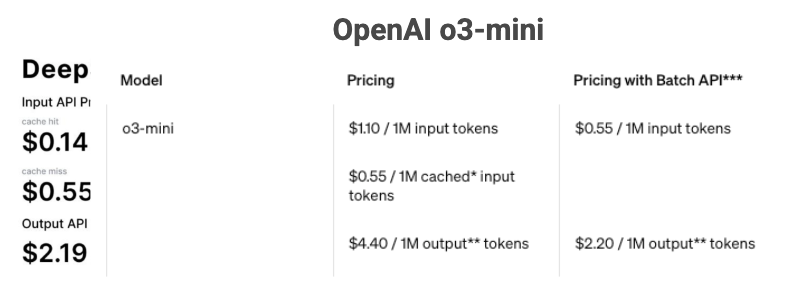

o3-mini API 가격 정책

기존 o1 모델보다 가격이 많이 싸졌습니다. DeepSeek의 저렴한 API 가격을 염두에 둔 것으로 보이나 아직까지 DeepSeek과 비교해 여전히 비싼 편(약 2배)이라 이부분은 아쉽다는 평이 많습니다.

그러나 점차 좋은 성능을 가진 모델들의 API 사용 비용이 낮아지고 있어 200달러나 되는 프로 모델을 사용할 필요없이 고성능 모델들의 보급화가 이뤄질 것으로 예상됩니다.

위 표에서 말하는 Output 토큰은 모델 내부적으로 사용되는 토큰을 포함하며 API 응답값에 포함되지 않습니다. Batch API는 답변을 즉시 받아볼 수 없고 24시간 안에만 응답을 주는 방식을 이야기합니다. 50%의 할인된 가격으로 사용할 수 있습니다.

AI model fatigue?

frontend에는 tech fatigue라는 말이 있습니다. 너무 빨리 기술 트렌드가 변경되는 것에서 느끼는 피로도를 의미하는데 작년 2024년 한해만 하더라도 정말 많은 모델들이 출시되었습니다. 개인적인 사정이나 흥미, 취향등의 문제로 AI기술 발전에 관심을 가지지 않았던 분들은 어디서 부터 봐야 하는지 잘 감이 안오시거나 벌써 피곤하실 겁니다. 지금은 얼마나 좋은 성능의 AI모델을 발전하는지 각 기업들에서 경쟁하는 시기입니다. 모델은 우리가 공부를 하거나 자는동안에도 매번 나올 것이고 AI 리서처가 아닌 개발자인 우리들은 매번 모델이 나올때마다 공부하기가 어렵다면 나의 생활반경에서 어떤 AI 도구를 어떻게 사용하는지 정도만 패턴화시켜두시기 바랍니다. 코딩을 한다면 Cursor나 Windsurf, 영상을 만든다면 Sora, 이미지는 Canva등.

예를 들어 Windsurf를 사용해서 어떤 모델이 나오던지 내가 코딩 업무에 잘 활용할 수 있다면

DeepSeek R1 32B 모델로 대화하고

Claude 3.5 Sonnet 모델로 코딩 에이전트를

동시에 사용할 수 있습니다.

좋은 글 감사합니다!