이전글에서 Sink Connector를 통해 Kafka Topic에 있는 데이터를 ElasticSearch로 전달 받을 수 있었다.

그렇다면 전달 받은 데이터가 잘 쌓이고 있는지, Kibana를 통해 Dashboard, Discover를 만들어보자

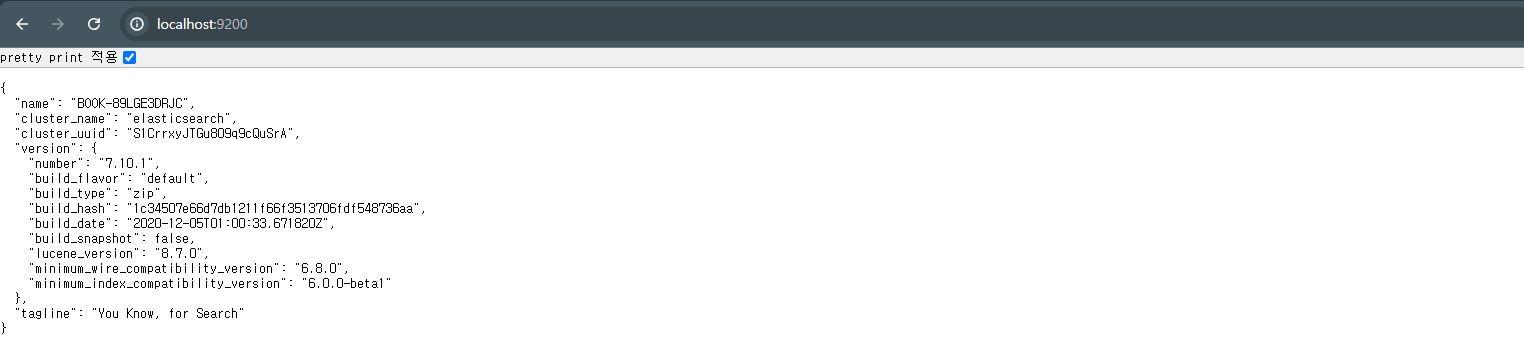

설치 및 확인

버전 정보

elasticsearch-7.10.1

kibana-7.10.2

C:경로로 설치했습니다.

/bin 아래 폴더의 .bat 파일을 통해 실행시키면 됩니다.

Kibana 확인

데이터 확인

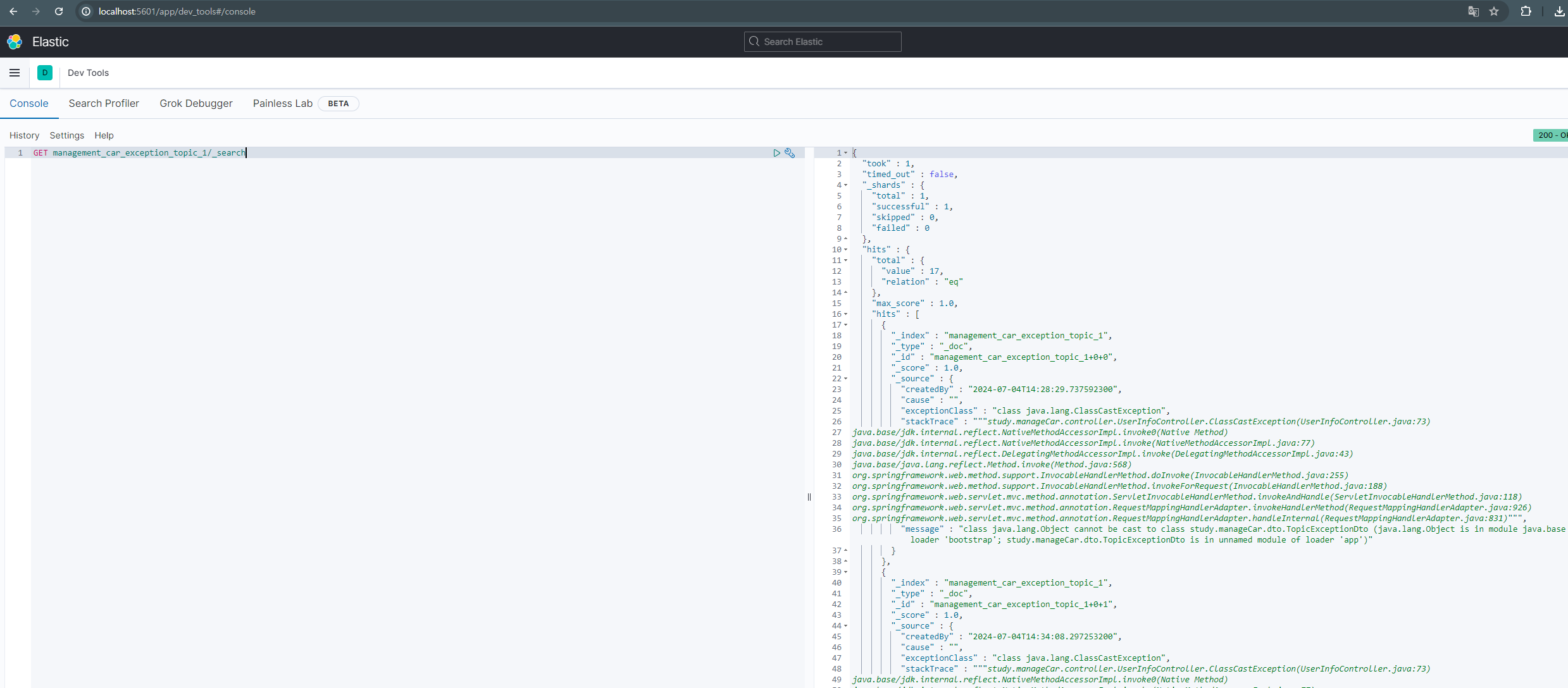

Dev Tools 사용

Kibana를 통해 Kafka에서 받은 데이터를 확인할 수 있습니다.

메인 페이의 우측 상단에 있는 Dev tools에서 아래 명령어를 실행해보면 데이터를 확인할 수 있습니다.

GET management_car_exception_topic_1/_searchmanagement_car_exception_topic_1 은 Topic 이름 입니다.

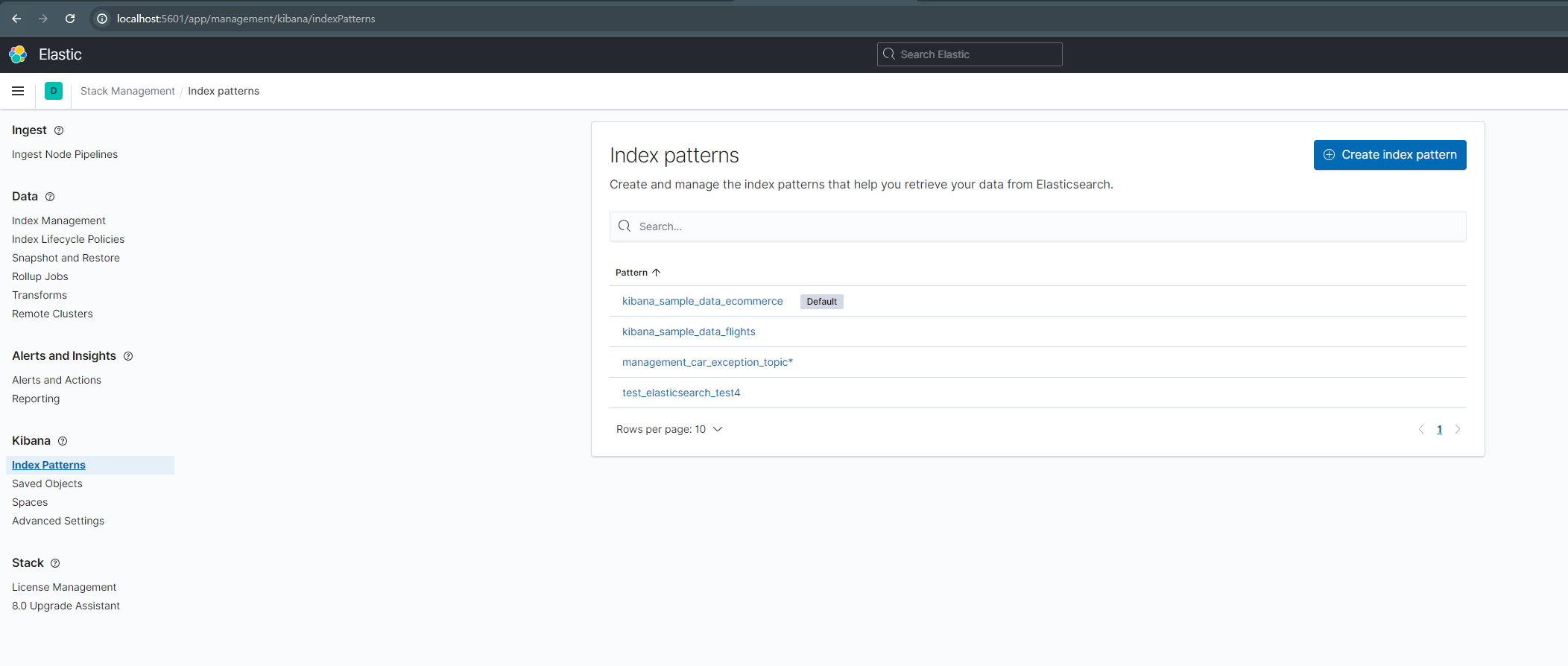

Index patterns

데이터가 잘 들어왔으면 Index patterns을 만들어야 합니다.

해당 패턴을 기준으로 Kibana에서 Dashboard, Discover를 만들 수 있습니다.

좌측 메뉴 탭에서 젤하단에 있는 Management > Stack Management 에서 만들면 됩니다.

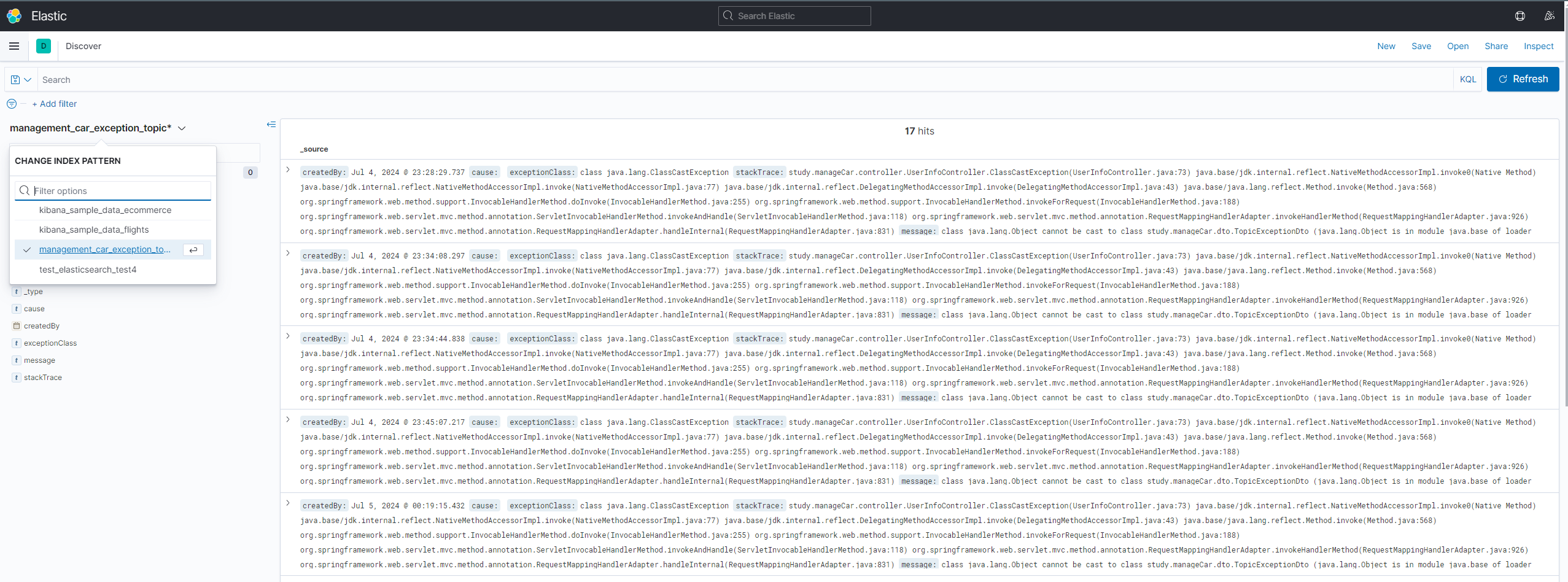

Discover

위 사진으로 찾아오셨다면 우측 상단에 있는 create index pattern 버튼으로 전달받은 데이터를 기준으로 만들면 됩니다

그런다음 Kibana로 넘어온 뒤 Discover를 선택하고 나서

좌측에 있는 INDEX PATTERN을 여러분들이 만든 index로 선택한다면 데이터를 확인할 수 있습니다.

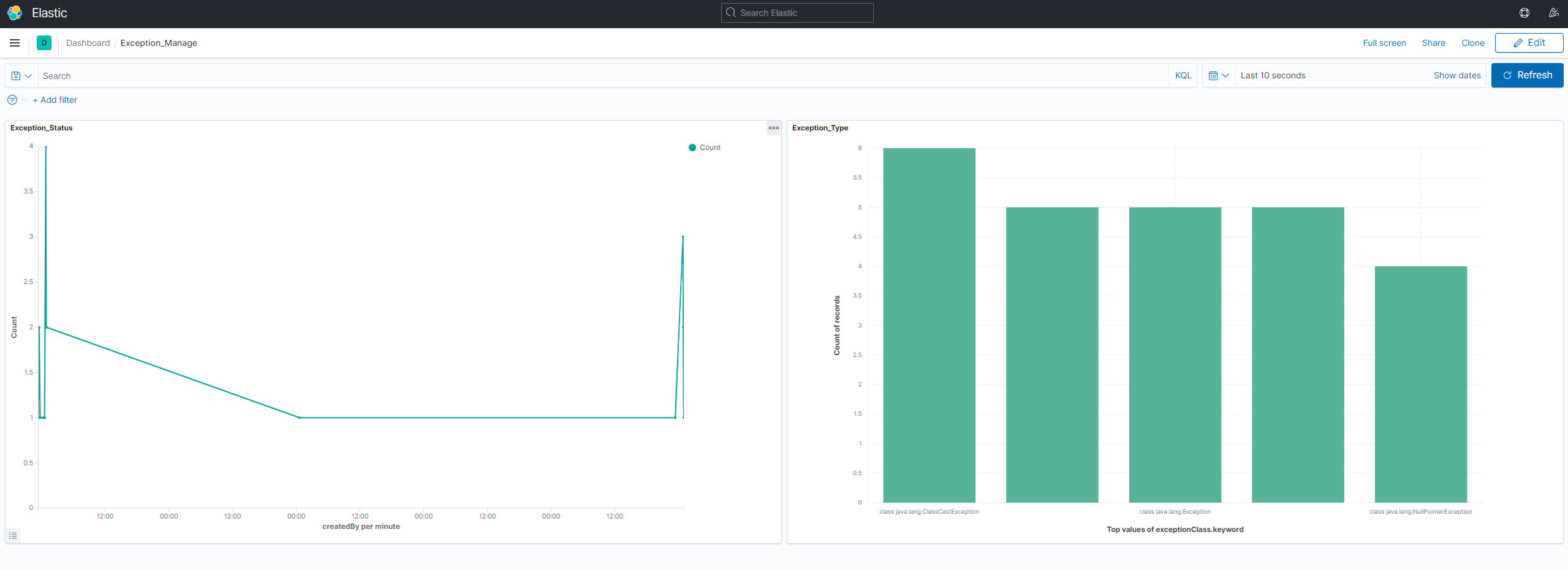

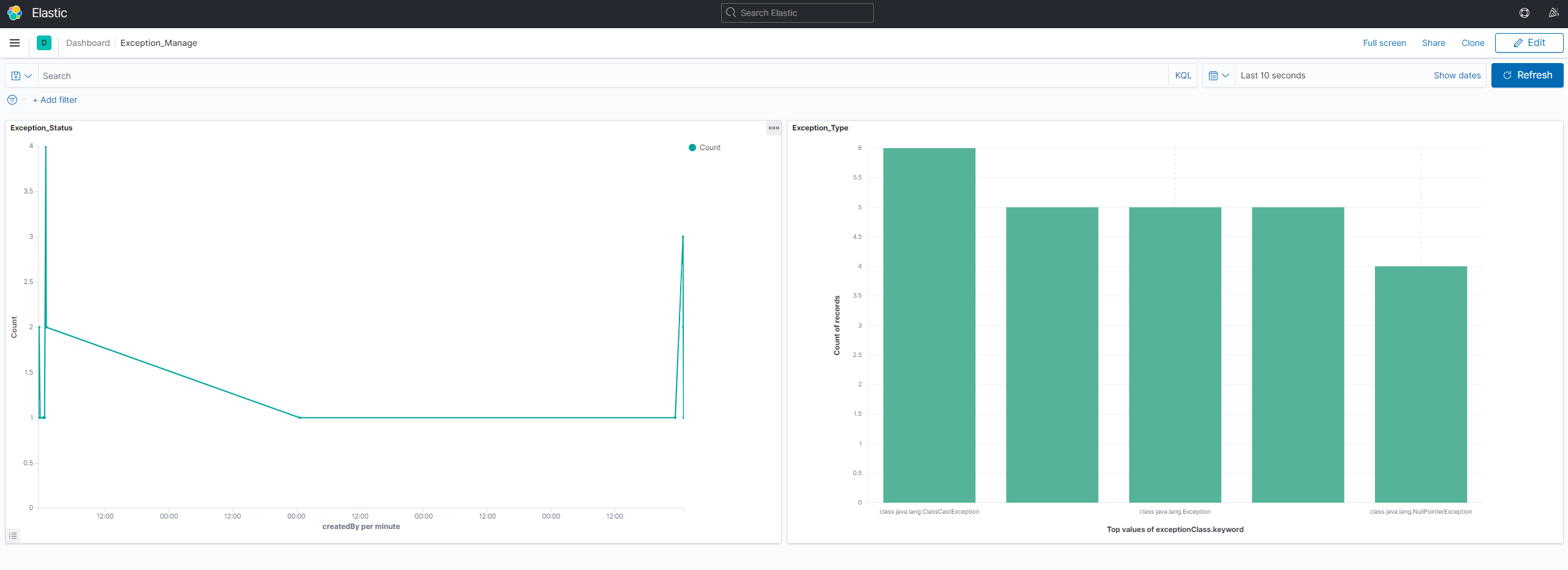

Dashboard

Dashboard는 여러분들이 보고싶은 Chart나 Gragh가 다를 수 있습니다.

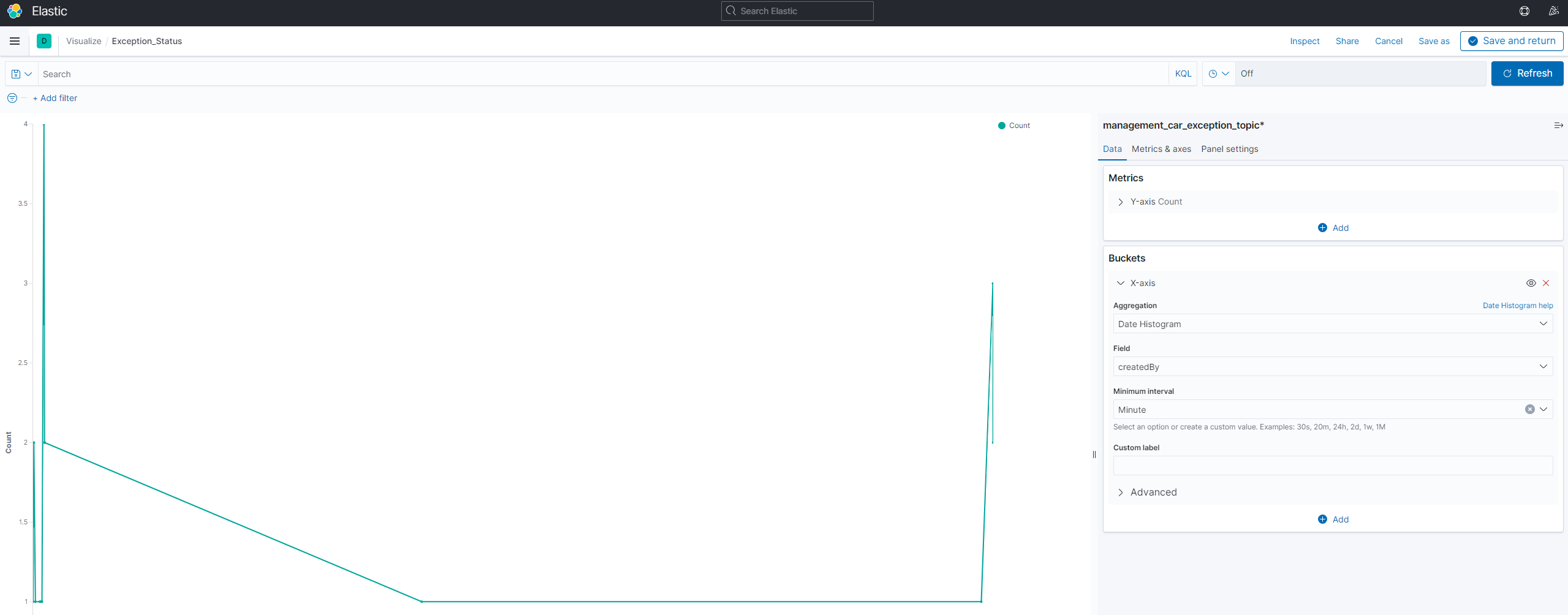

Exception이 들어오는 시간에 따른 Chart

X는 Data 들어오는 시간에 맞춰 표시하도록

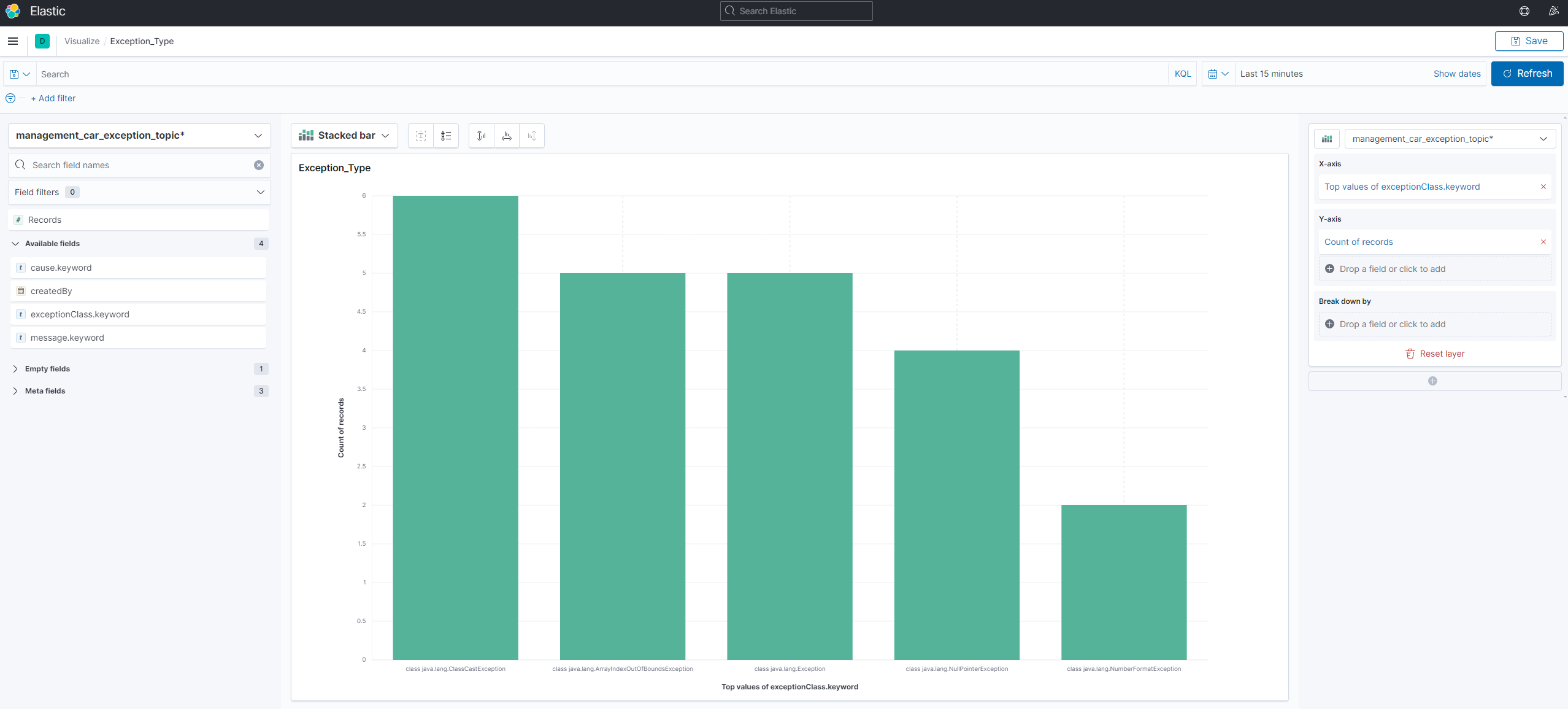

ExceptionType에 따른 개수 Chart

X는ExceptionClass.keyword로 잡았습니다.

각각의 차트를 그렸다면 Dashboard에서 한번에 볼 수 있습니다.