Kafka 미니 플젝

1.프로젝트 설계

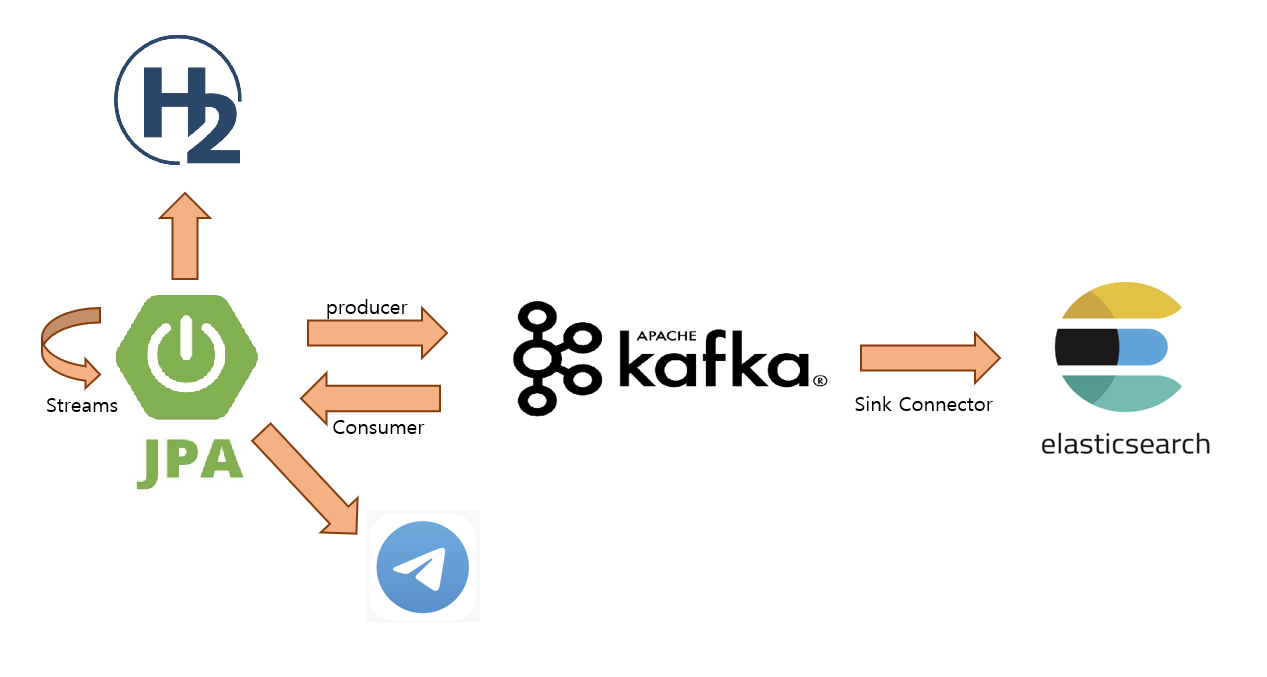

이번 미니 프로젝트의 목표는 새롭게 알게된 내용을 사용해보면서 직접 눈으로 확인해보고 싶었다. 긴말은 생략하고 머리속에 있던 그림을 보여드리면 설계 이미지 Application Front를 만들게 되면 시간이 다 뻇길 것 같아서 제외 API 통신을 통해 데이터를

2.JPA Entity 작성

기능을 생각하면서 테이블을 구성해보니 아래 정도로 추려졌다. 사용자와 차량의 관계는 언제든지 변경이 가능하다. ERD 위 ERD 사진으로 Entity 작성 공통이나 마스터정보에 대해 먼저 작성 BaseEntity 테이블 마다 공통으로 들어가는 정보 기입 시간

3.Kafka 설치, Spring 추가

Kafka 설치 Apache Kakfa에서 버전에 맞게 다운로드 2.~ 버전과 3.~ 버전의 차이만 확인해보시고 다운로드 받으면 됩니다. 전 2.5.0 버전과 3.7.1버전을 다운받았습니다. -> 에러 찾을려고 2개 다운 받은 것이니 한개만 다운 받으셔도 됩니다.

4.Kafka streams 추가

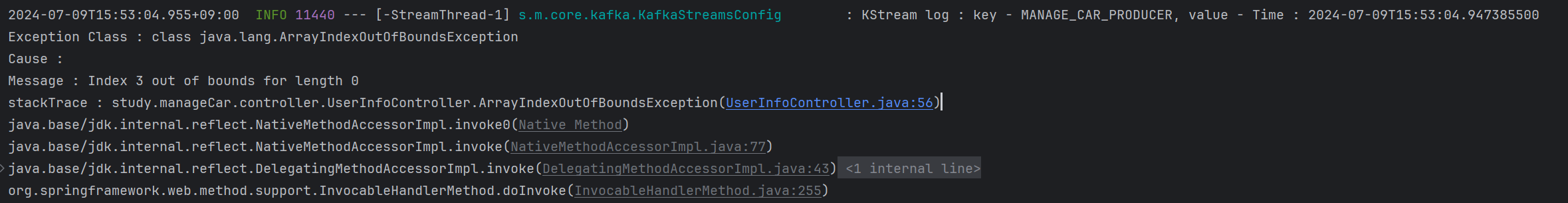

Application 에서 에러 발생 시 A Topic 으로 전송을 하게 되고 Streams를 통해 A -> B Topic으로 전송해주면 B Topic의 Consumer가 확인하여 담당자에게 전송하도록 하는 파이프 라인 구축 B Topic 부터 생성 Kafka

5.Kafka ElasticSearch Sink Connector 설정

시간을 젤 잡아먹은 Sink Connector 설정 방법 window라서 그랬을까 에러 발생 시 데이터가 쌓이는 Topic에서 데이터 시각화를 위한 ElasticSearch 연동을 시작 ElasticSearch Connector ElasticSearch Sink

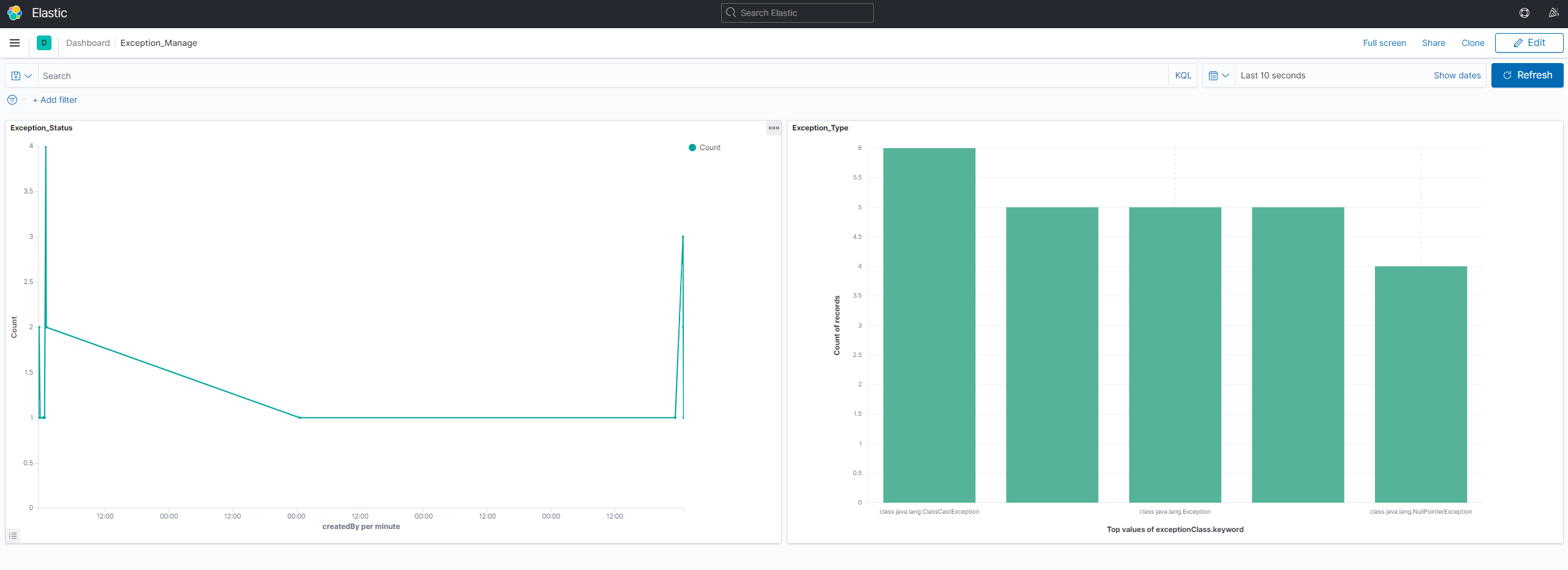

6.ElasticSearch 데이터 확인

이전글에서 Sink Connector를 통해 Kafka Topic에 있는 데이터를 ElasticSearch로 전달 받을 수 있었다. 그렇다면 전달 받은 데이터가 잘 쌓이고 있는지, Kibana를 통해 Dashboard, Discover를 만들어보자 설치 및 확인 >

7.결론

처음 설계와 달라진 부분이라고 하면은서버1JPA ApplicationProducer서버2KafkaStreams서버3Consumer이렇게 각각 따로 올릴려고 했지만...서버1JPA ApplicationProducerConsumerStreams서버2KafkaJPA Appl