AI : Quantization

1.[AI] 양자화(Quantization) 의 기초 개념

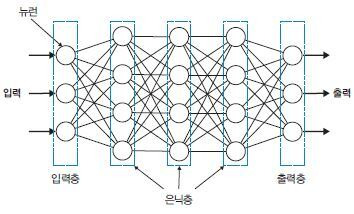

부동소수점(float32)으로 학습된 모델의 가중치(W), 편향(b), 활성값(activation) 들을 더 작은 비트 수 (예: int8)로 표현하는 과정인공 신경망에서, 노드에 입력되는 각 신호가 결과 출력에 미치는 중요도를 조절하는 매개변수(파라미터)인공 신경망에

2025년 6월 2일

2.[AI] 모델 양자화의 시작 - llama.cpp

왜 양자화를 하는지 알아봤으니 모델을 직접 만져보자. 이번에는 허깅페이스에서 모델을 개별 다운로드 받아 gguf 파일로 변환하고 llama-cpp-python 으로 돌려보는 것을 해보겠다. 1. llama.cpp git clone clone 완료 2. cmake

2025년 6월 2일

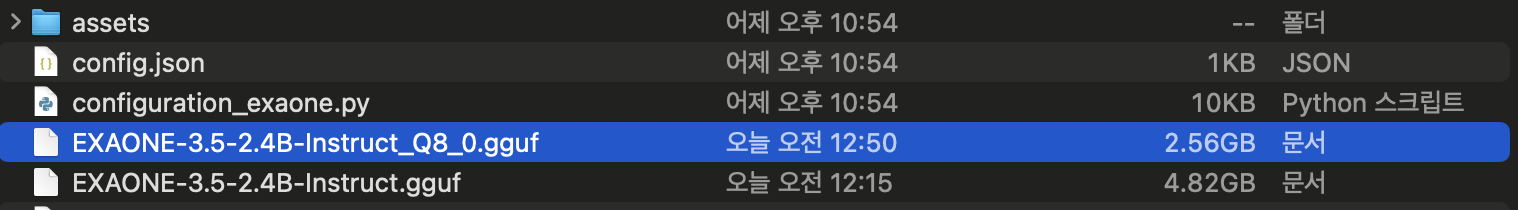

3.[AI] llama-quantize로 직접 양자화 실행

\--outtype 옵션 없이 그대로 진행Float16 을 제외한 나머지 옵션을 모두 적용해 보았다.quant size 가 2437.71MB 로 약 2GB 정도 줄었다.나름 양호한 편이다.모델의 용량이 많이 줄어듬에도 불구하고 괜찮은 답변을 내 준 exaone3.5:2

2025년 6월 2일