- Publish: NeurIPS 2023

- Year: 2023

- LINK: https://arxiv.org/abs/2306.01293

Summary

-

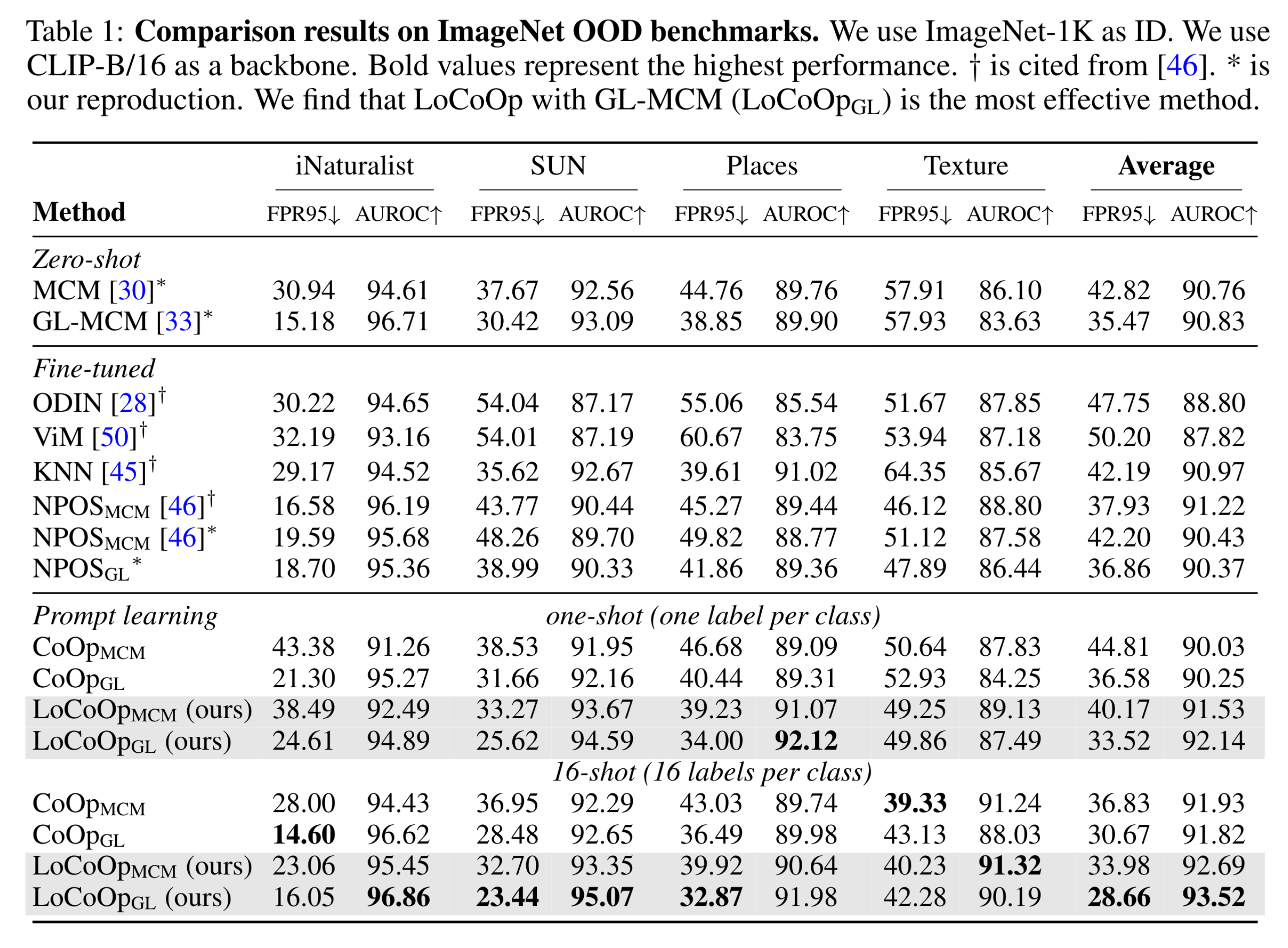

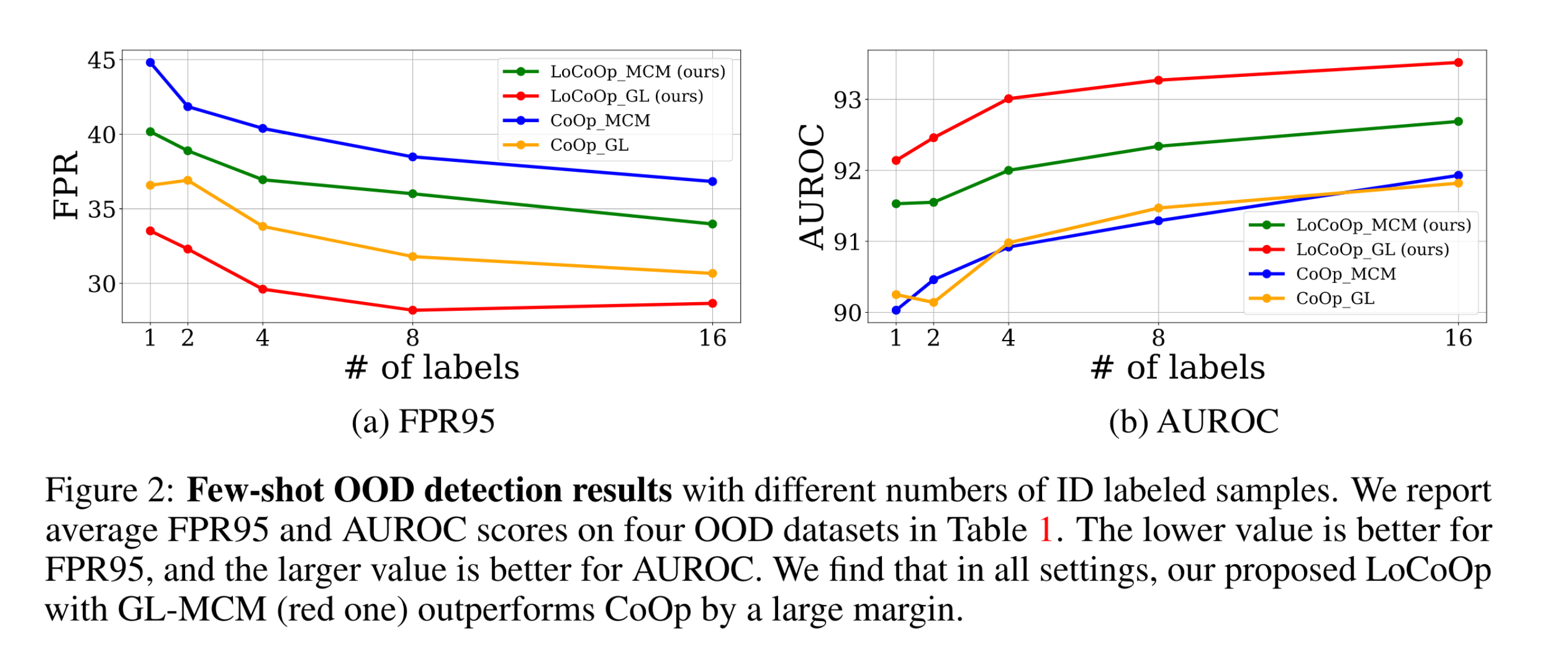

few-shot out-of-distribution detection을 위한 새로운 vision-language prompt learning approach 제안

- few-shot OoDD: 일부의 ID images-lables 에 대해 학습한 후, 본 적이 없는 class의 OOD image를 detection

- CoOp은 few-shot ID classification 을 효과적으로 달성

- BUT, 텍스트 임베딩에 ID와 무관한 정보가 포함될 가능성 때문에 OOD detection에서 한계를 가지고 있음

-

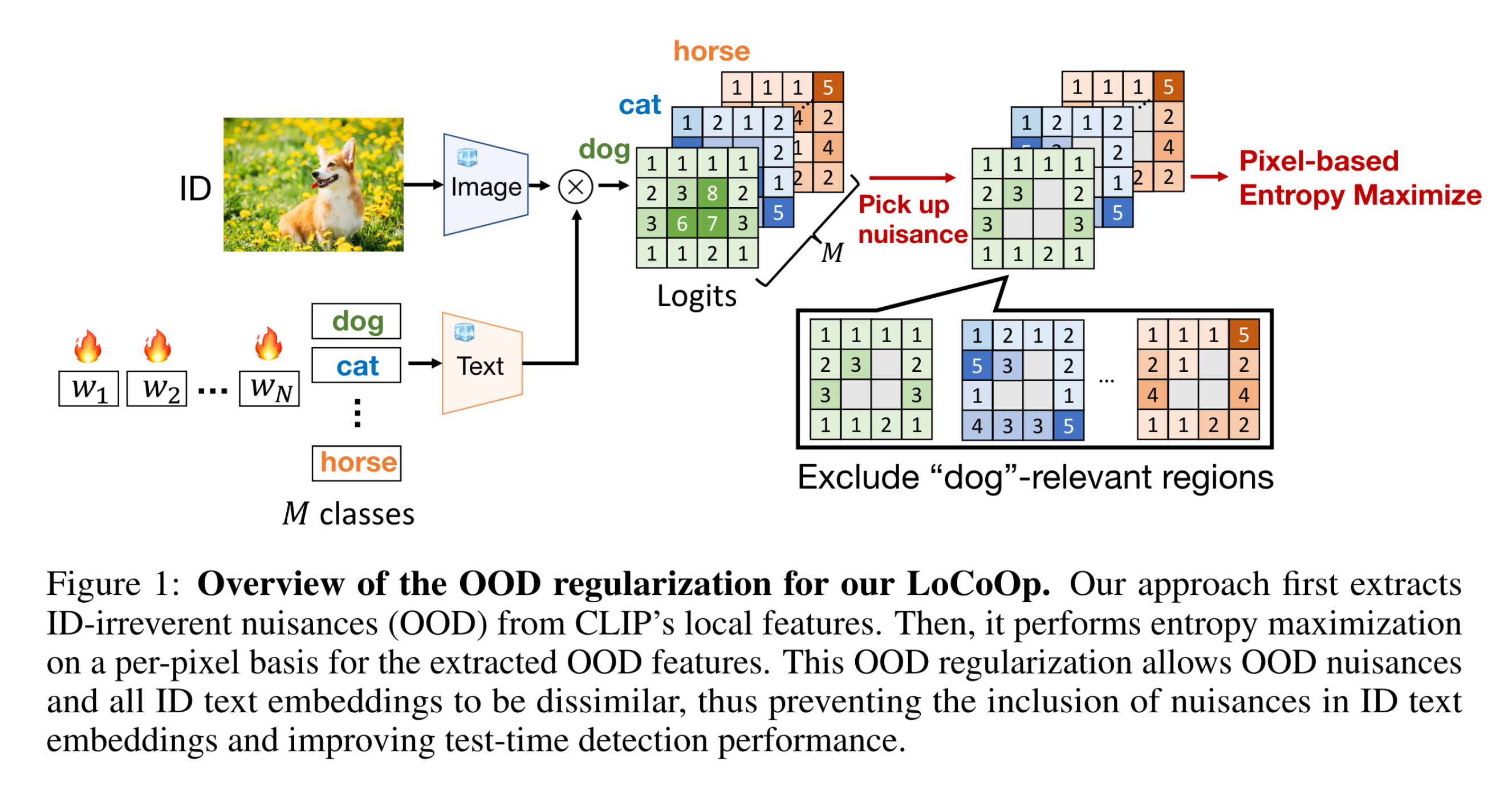

LoCoOp 제안

- Local regularized Context Optimization

- 학습 중 CLIP의 local feature을 OOD feature로 활용하는 OOD 정규화를 수행

- CLIP의 local feature는 ID data에 무관한 정보 (배경 등) 을 많이 담고 있음

- 이러한 local feature를 text embedding에서 멀어지게 만듦

-

LoCoOp의 두 가지 장점

- OOD regularization 을 minimal cost로 수행 가능

- Global 및 local feature을 모두 사용하는 LoCoOp은 ID와 OOD를 분리하는 테스트 시간 OOD 탐지 방법인 GL-MCM과 호환성이 높음

Method

Preliminary

- CLIP으로부터 Local feature를 얻기 위해 visual feature의 각 영역을 textual sapce로 projection

- 이러한 projection은 CLIP에 inherent, 즉 학습할 필요가 없음

- 이러한 local feature는 local visual, textual alignment에 대한 정보를 많이 가지고 있음

Extraction of ID-irrelevant regions

- 우리의 목표: ID-irrelevant region을 뽑아보자!(region indices)

- 아주 단순한 방법: image feature의 각 영역과 text feature의 similarity 계산

% Experiments