<다양한 분류 알고리즘>

04-1. 로지스틱 회귀 (Logistic Regression)

개념

- 선형 회귀 + 분류 기능 = 로지스틱 회귀

- 입력값을 선형 방정식으로 계산한 후, 시그모이드 또는 소프트맥스 함수를 적용하여 클래스 확률을 출력함

분류 함수

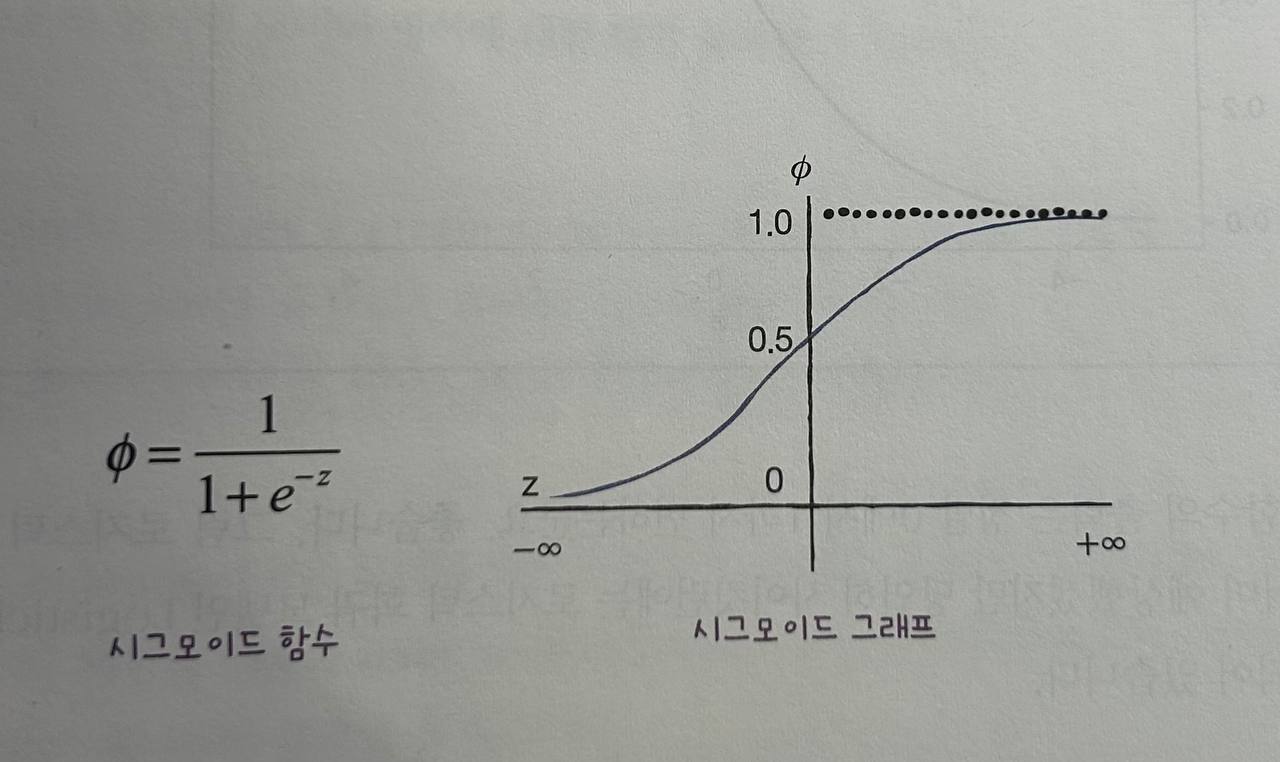

-

시그모이드 함수

0~1사이의 값 반환 → 이진 분류에서 확률로 사용- 출력값이 0.5보다 크면 양성 클래스, 작으면 음성 클래스

-

소프트맥스 함수

- 다중 분류에서 사용

- 모든 클래스에 대해 확률을 계산하고, 그 합이 1이 되도록 정규화

주요 함수 및 클래스

-

LogisticRegression: 로지스틱 회귀 분류 모델solver: 최적화 알고리즘 선택 (기본값:'lbfgs')

-

predict_proba(): 각 클래스에 대한 예측 확률 반환 -

decision_function(): 선형 방정식 결과값 반환 (확률 아님)

04-2. 확률적 경사 하강법 (SGD: Stochastic Gradient Descent)

개념

- 손실 함수의 기울기(경사)를 따라 모델 파라미터를 조금씩 조정하며 최적화하는 방식

- 1개 샘플씩 → SGD

- 여러 개 샘플씩 → 미니배치 경사 하강법

- 전체 샘플 → 배치 경사 하강법

용어 정리

-

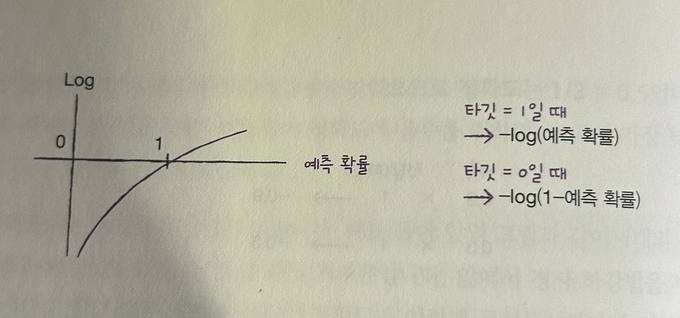

손실 함수: 예측값과 실제값 차이를 측정하는 함수

- 이진 분류 → 로지스틱 손실

- 다중 분류 → 크로스 엔트로피 손실

- SVM(서포트 벡터 머신) → 힌지 손실

-

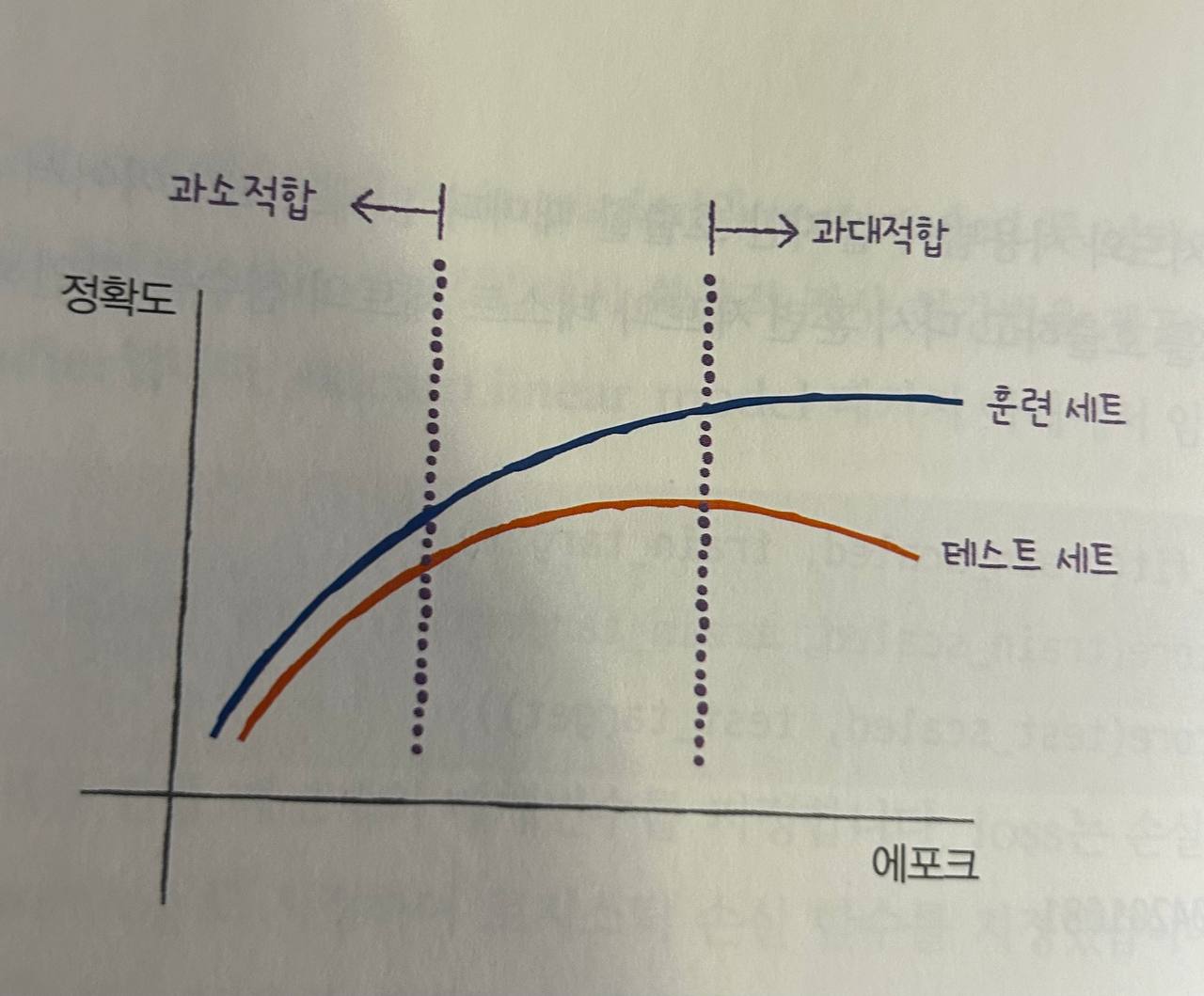

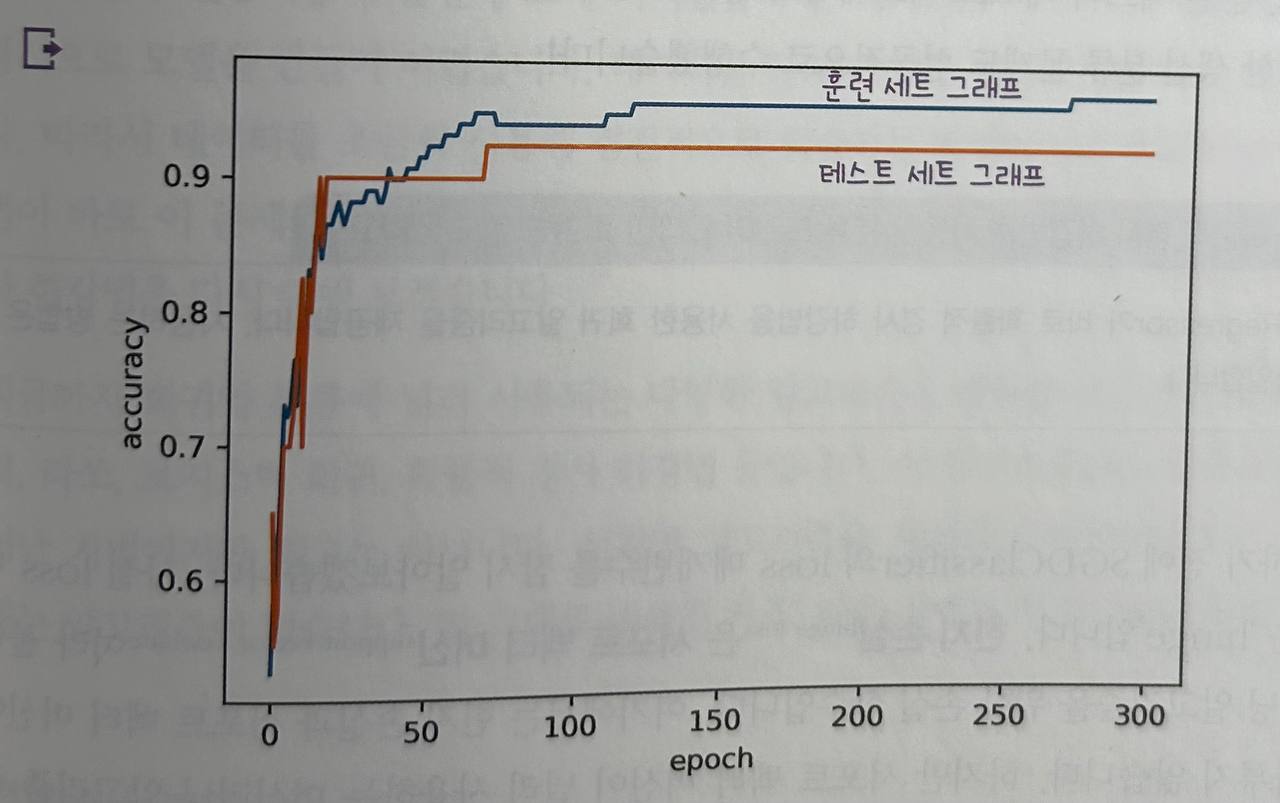

에포크(epoch): 전체 데이터셋을 한 번 모두 학습하는 과정

사이킷런 클래스

-

SGDClassifier: 확률적 경사 하강법 기반 분류 모델loss='log_loss': 로지스틱 회귀 손실loss='hinge': SVM용 힌지 손실 (기본값)max_iter: 에포크 수 지정

-

SGDRegressor: 회귀용 확률적 경사 하강법 모델