[Huggingface] Transformers Timeout Issue 해결

0

Issue

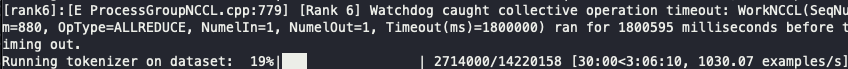

Huggingface Transformers에서 제공하는 기본 Trainer로 대량의 코퍼스를 돌리다보면, Timeout 이슈가 발생한다. 이 이슈는 Transformers만의 고유한 이슈는 아니고, Distributed Data Parallel (DDP)로 학습을 진행할때 발생하는 이슈이다 (torchrun으로 학습을 실행시키면 DDP로 학습시키는 것).

이전 포스트에서는 Accelerate에서 Timeout 이슈를 해결하는 방법에 대해서 설명했는데, Transformers에서는 더욱 간단하게 해결할 수 있다.

Solution

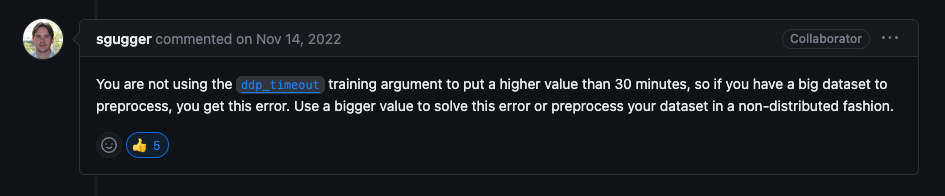

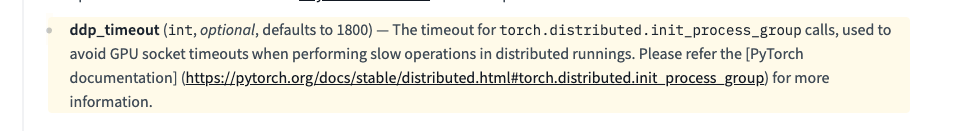

Transformers의 TraningArguments 설정에서 ddp_timeout 옵션의 값만 변경해주면 된다.

Reference

https://github.com/huggingface/transformers/issues/17106

https://github.com/huggingface/transformers/issues/17106