분류 모델의 평가

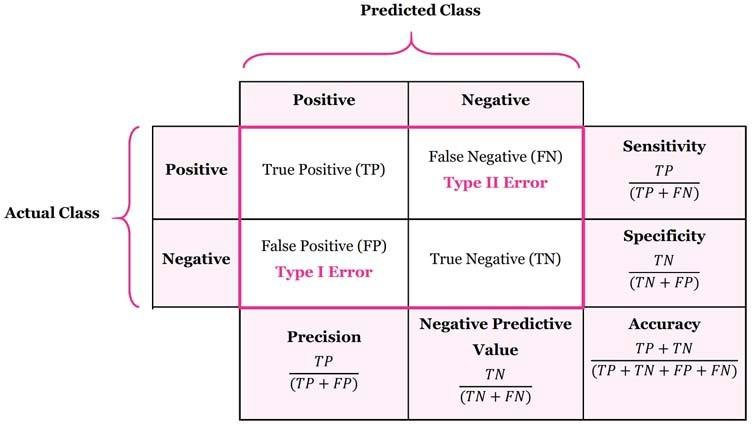

오차행렬(Confusion Matrix)

정확도(Accuracy)

- 전체 데이터 중에서 예측 결과와 실제 값이 동일한 비율

- (TP+TN) / (TP+TN+FP+FN)

정밀도(Precision)

- 양성으로 예측한 데이터 중 맞춘 양성 데이터의 비율

- 정밀도는 음성을 양성으로 판단하는 것이 더 손해인 경우 사용

(깐깐하게 봐야할 때 사용) - TP / (TP+FP)

재현율(Recall)

- 실제 양성 데이터 중 맞춘 양성 데이터의 비율

- 재현율은 양성을 음성으로 판단하는 것이 더 손해인 경우 사용

(털털하게 봐도될 때 사용) - TP / (TP+FN)

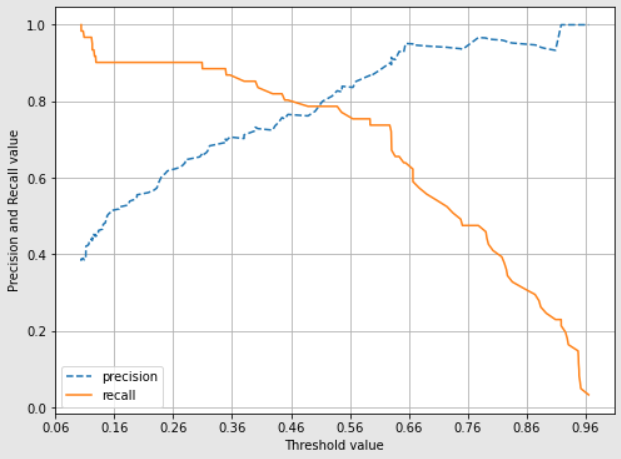

정밀도/재현율 트레이드오프

- 어느 한쪽을 강제로 높이면 다른 하나의 수치는 떨어지기 쉬운 현상을 나타내는 용어

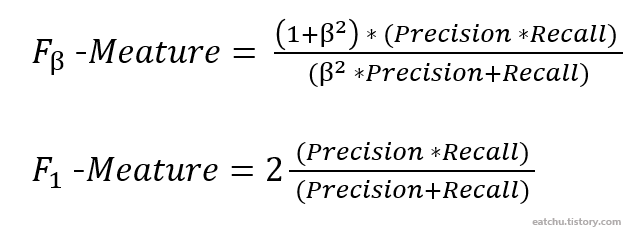

F1-score

- 정밀도와 재현율의 조화평균

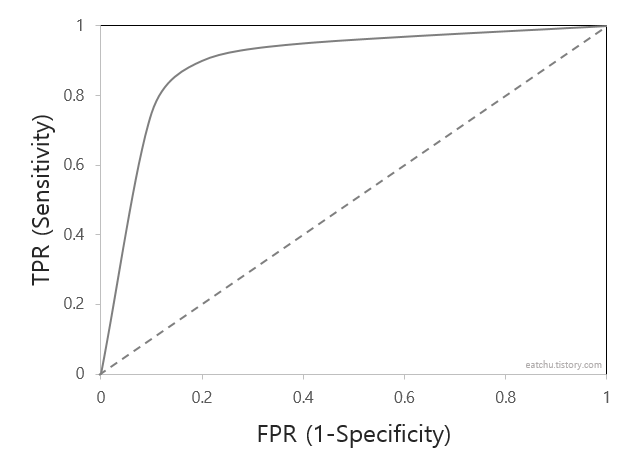

ROC-AUC

- ROC곡선과 이에 기반한 AUC스코어는 이진 분류의 예측 성능 측정에 중요하게 사용되는 지표이다.

ROC curve

- FPR(False Positive Rate=특이도)를 x축으로,

TPR(True Positive Rate=재현율)을 y축으로 삼은 곡선 - FPR(특이도) : FP / (TN+FP)

실제 음성 데이터 중 맞춘 음성 데이터의 비율 - TPR(재현율) : TP / (TP+FN)

실제 양성 데이터 중 맞춘 양성 데이터의 비율

- 좋은 성능을 가진 모델은 FRP는 0에 가깝고 TPR은 1에 가까운 값을 가지는 것이 좋다.(좌상단 밀착이 좋음)

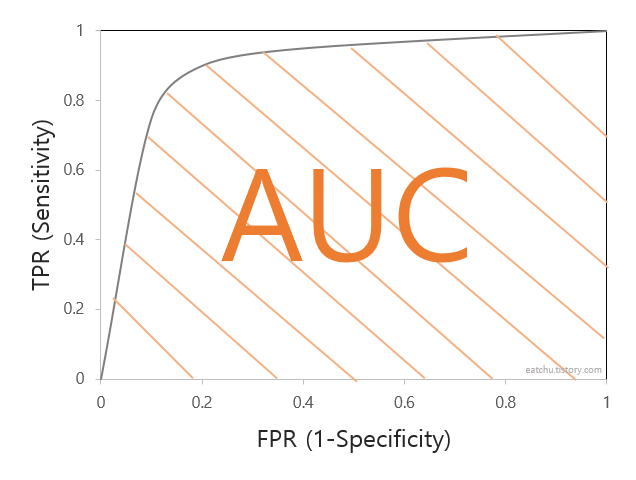

AUC

- AUC(Area Under the ROC)는 ROC curve의 아랫 부분 면적이다.

- 따라서 AUC는 면적이 넓을 수록 좋다.

회귀 모델의 평가

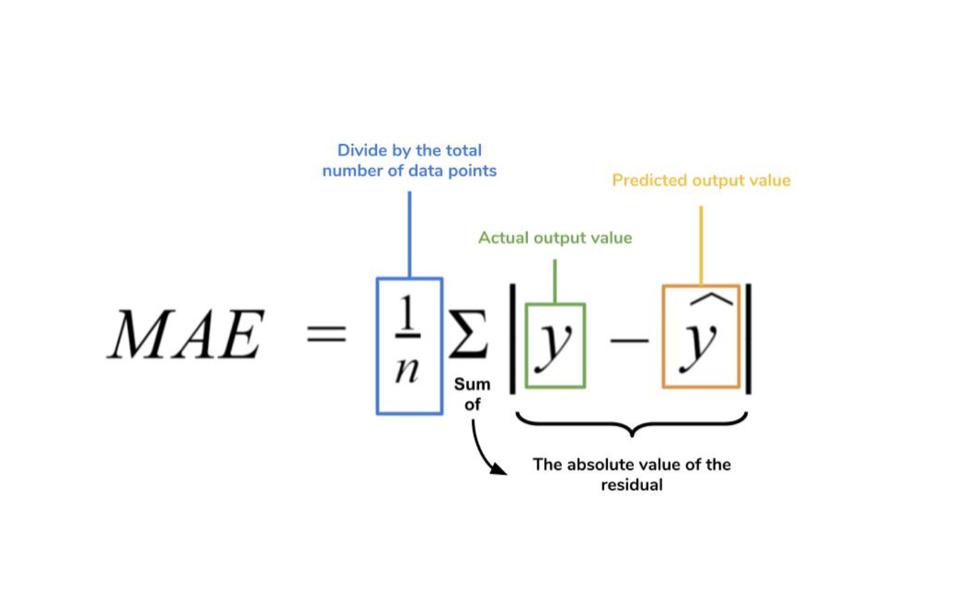

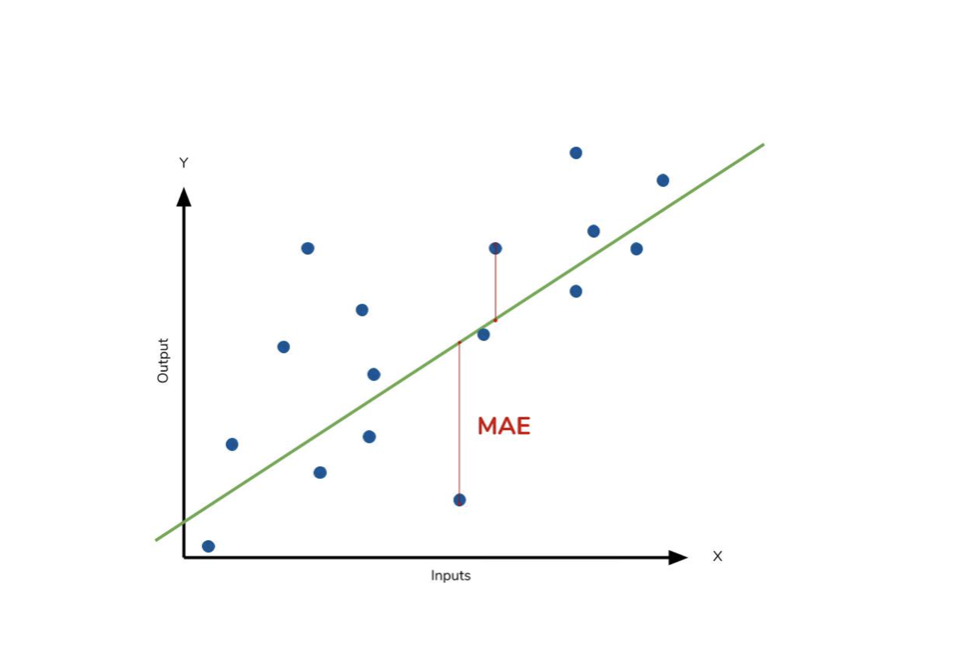

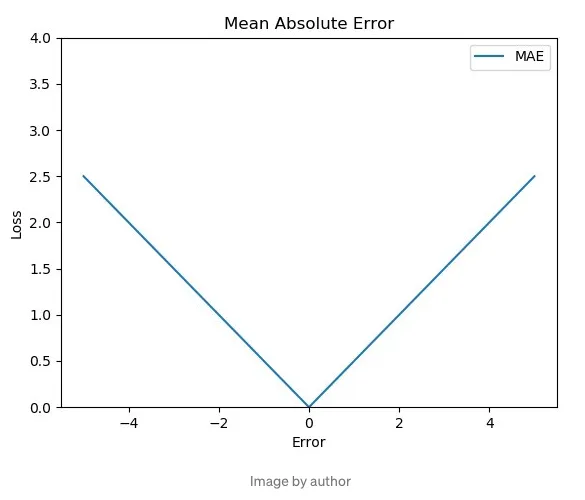

MAE(Mean Absolute Error:평균 절대 오차)

- 실제 값과 예측값의 차이를 절대값으로 변환해서 평균을 구한다.

- 이상치에 둔감하다.

- 예측변수와 단위가 같다.

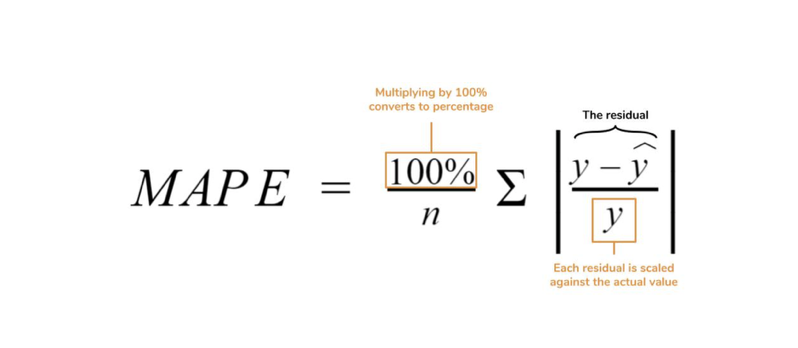

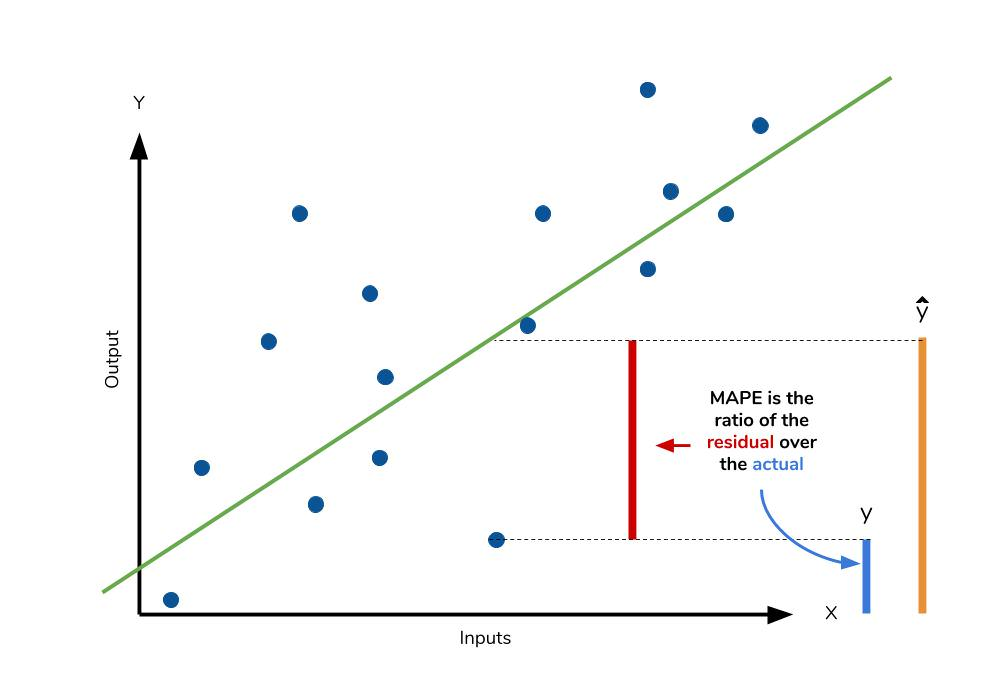

MAPE(Mean Absolute Percentage Error:평균 절대비율 오차)

- 실제값과 예측값 사이의 평균 절대 백분율 차이이다.

- 백분율로 나와서 여러 모델간 비교가 용이하다.

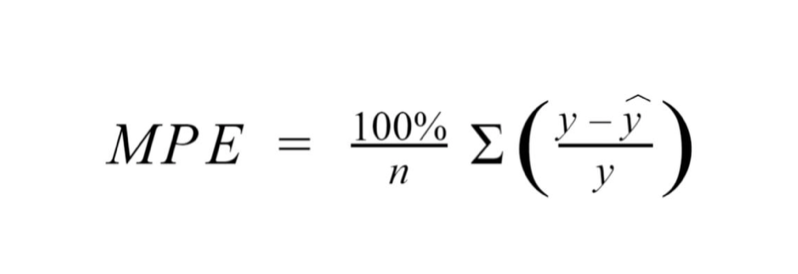

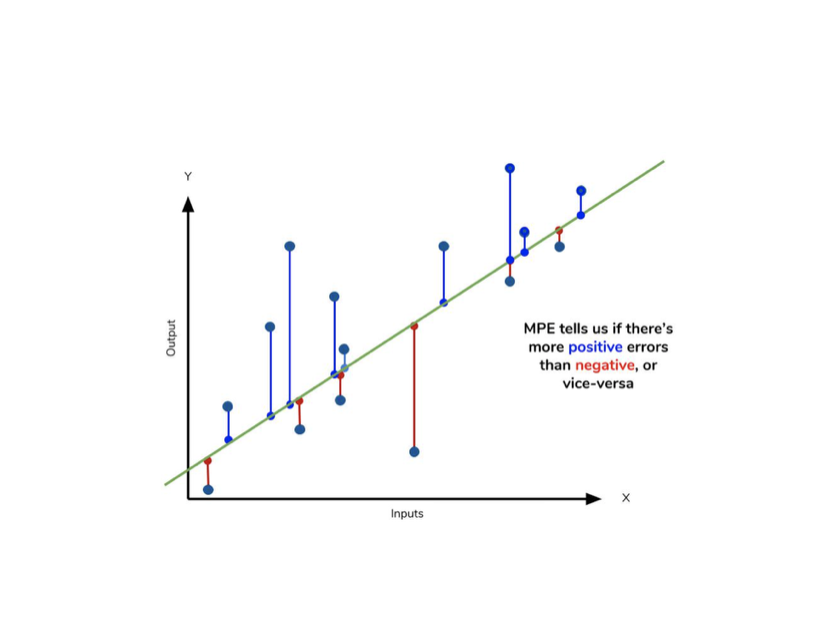

MPE

- MAPE에서 절대값을 제외한 지표이다.

- 실제 값에 대해 underestimates or overestimates 인지 파악할 수 있다.

- MPE > 0: underperformance (underestimates)

- MPE < 0: overperformance (overestimates)

- 직관적이지 않고, 예측변수와 단위가 다르다.

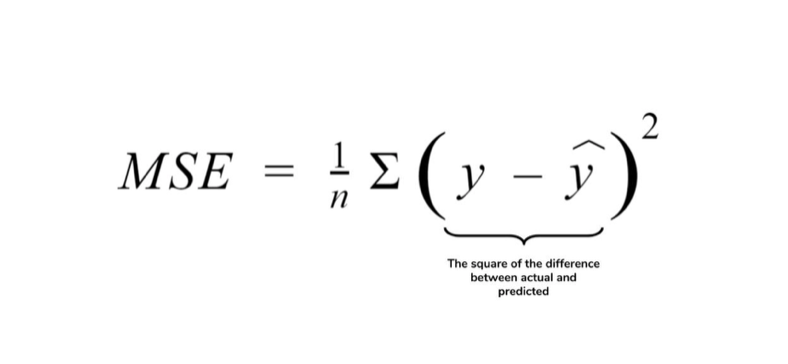

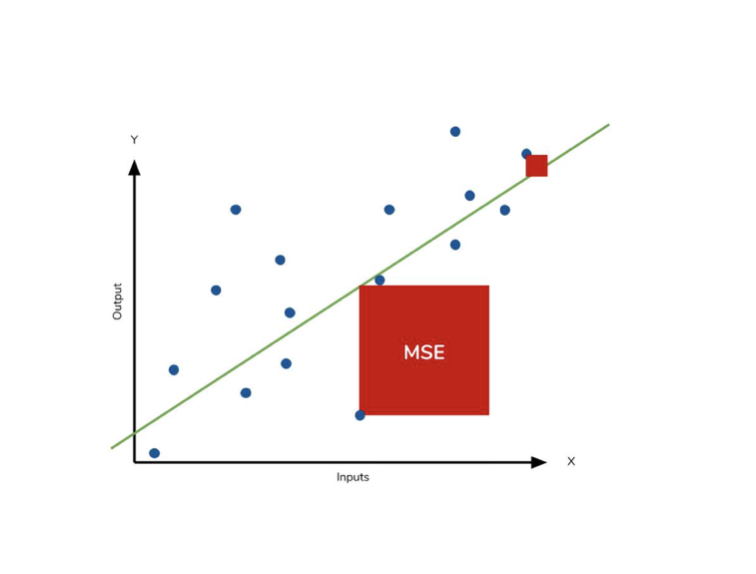

MSE(Mean Squared Error:평균 제곱 오차)

- 실제값과 예측값의 차이를 제곱해서 평균을 구한다.

- 오차값에 제곱을 취하기 때문에 오차가 0과 1 사이인 경우 본래보다 더 작게 반영되고, 오차가 1보다 클 때는 본래보다 더 크게 반영된다.(이상치에 민감)

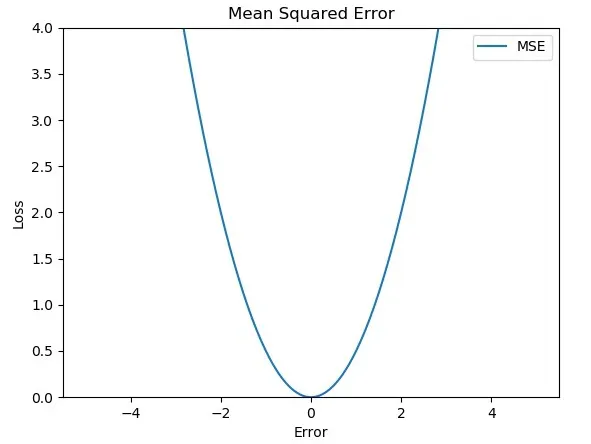

- 모든 함수값이 미분 가능하다. MSE는 이차 함수이기 때문에 아래와 같이 첨점을 갖지 않는다. (손실함수로써 주로 쓰음)

- 예측변수와 단위가 다르다.

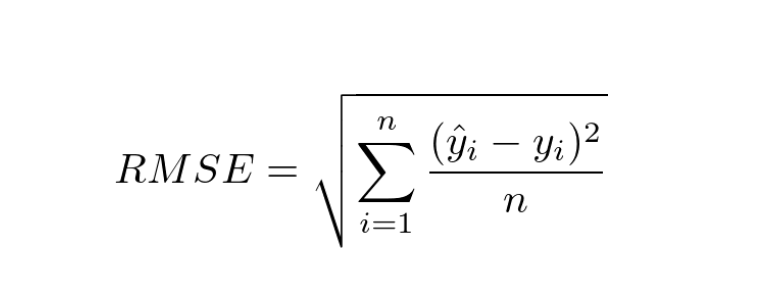

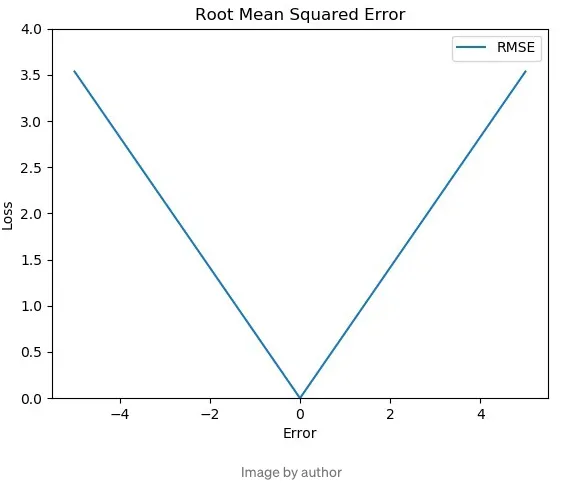

RMSE(Root Mean Squared Error:평균 제곱근 오차)

- 루트를 씌워서 실제 오차보다 더 커보이는 MSE의 특성을 어느정도 보완한다.(이상치에 덜 민감)

- MAE처럼 미분 불가능한 지점을 갖고 있다.

출처