오늘은 딥러닝에 꼭 필요한 활성화 함수에 대해 알아보려고 합니다 !

딥러닝을 하면서 사용하는 활성화 함수는 크게 3가지 있습니다.

sigmoid,softmax,ReLu 가 그 3가지에요!

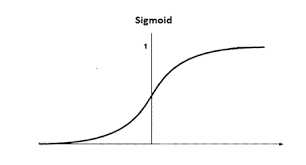

우선, 시그모이드 함수부터 알아봅시다!

시그모이드

시그모이드 함수의 생김새는 다음과 같습니다.

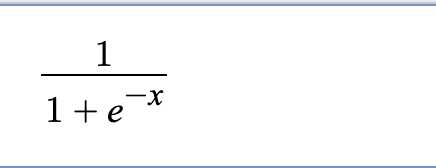

함수식은

다음과 같습니다.

-

시그모이드 함수는 입력값이 커지면 커질수록 1에 수렴하고, 작아지면 작아질수록 0에 수렴합니다. -

시그모이드 함수를미분하면, 양 쪽으로 향할수록 변화값이 거의 없습니다. -

따라서, 오류역전파를 할 때,

Vanishing Gradient현상이 발견될 수 있습니다. -

0 또는 1을 반환하기 때문에,

이진 분류 모델의 마지막 활성화 함수로 사용됩니다!

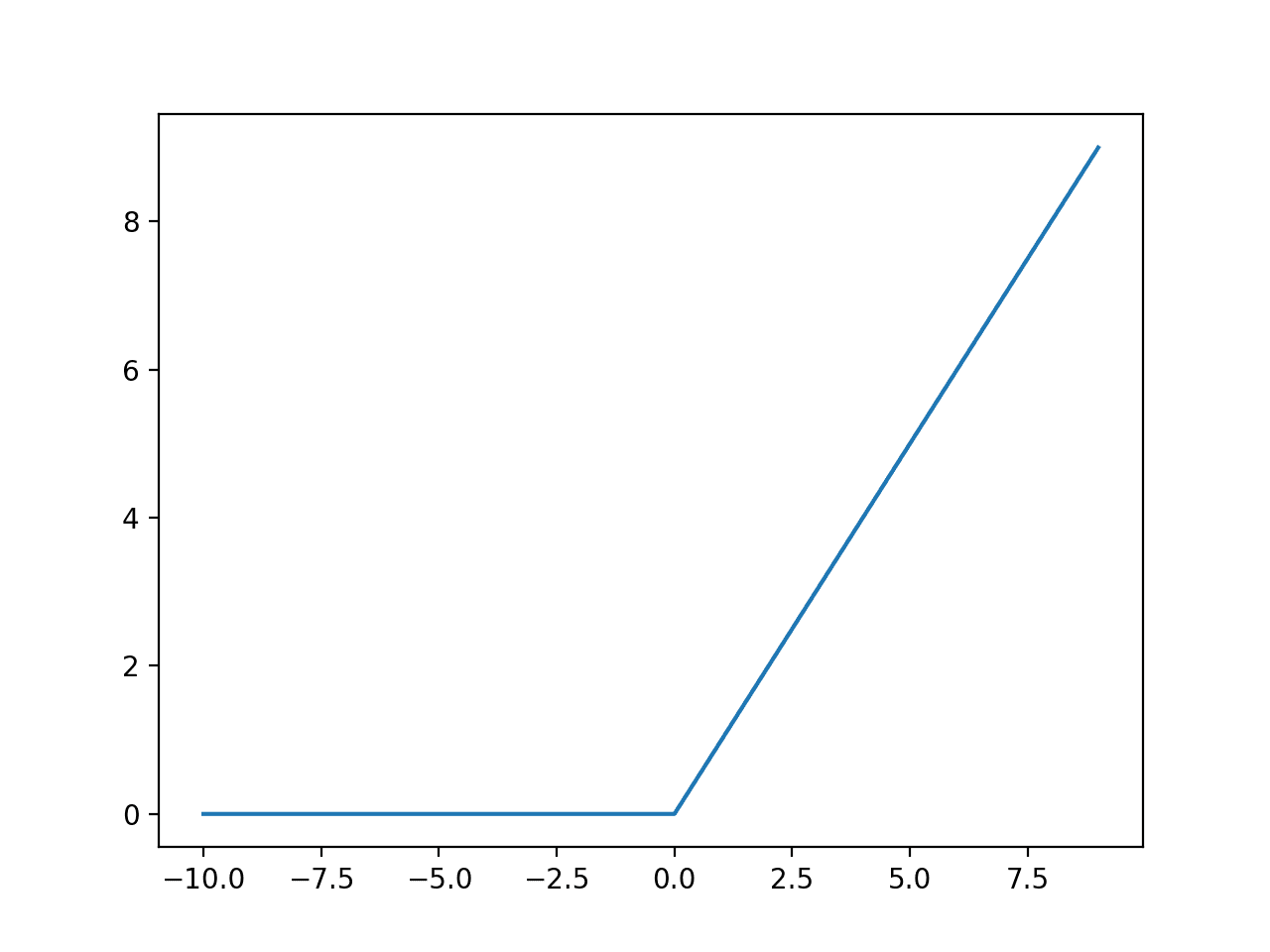

ReLu

ReLu 함수는 은닉층의 활성화 함수로 사용됩니다.- 입력값이 0보다 작거나 같을 때는 항상 0을 출력하고, 0보다 크면 입력값과 동일한 출력값을 출력합니다.

소프트맥스

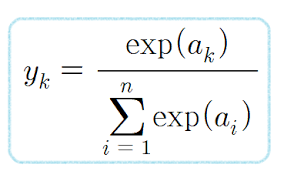

softmax 함수는 시그모이드와 비슷하게, 0~1사이로 변환하여 출력하지만,

출력값들의 합이 1이 되도록 하는 함수입니다.- 따라서 다중 분류의 최종 활성화 함수로 사용됩니다!!

- 소프트 맥스의 식은 위와 같다.

간단 정리 !

시그모이드 - 이진 분류 모델의 마지막 활성화 함수 !

소프트맥스 - 다중 분류 모델의 마지막 활성화 함수 !

ReLU - 기본적으로 은닉층에 사용하는 활성화 함수 !

이렇게만 알고 계셔도 사용하실 때 큰 부담 없으실 것 같습니다!!

감사합니다!