다중선형회귀(Multiple Linear Regression)

- 단순선형회귀식은 다음과 같다

- 지금 다룬 2특성의 다중선형회귀 식은 다음과 같다

학습/테스트 데이터 분리

- 모델 학습에 사용한 훈련(train) 데이터를 잘 맞추는 모델이 아니라 학습에 사용하지 않은 테스트(test) 데이터를 얼마나 잘 맞추는지가 중요

- 데이터를 훈련/테스트 데이터로 나누어야 우리가 만든 모델의 예측 성능을 제대로 평가

- 학습에 사용하는 데이터와 모델을 평가하는데 사용하는 데이터가 달라야 한다

- 데이터를 무작위로 선택해 나누는 방법이 일반적이지만 시계열 데이터를 가지고 과거에서 미래를 예측하려고 하는 경우 무작위로 데이터를 섞으면 절대로 안되고 이때는 훈련 데이터 보다 테스트 데이터가 미래의 것이어야 할 것

평가지표(evaluation metrics)

-

MSE (Mean Squared Error) =

- MSE는 에러가 크면 클수록 그에 따른 가중치를 높게 반영하지만 Outlier에 민감(에러 값이 증가함에 따라 손실 함수가 제곱배 만큼 커지기 때문)

-

MAE (Mean absolute error) =

- MAE는 Outlier가 있어도 최대한 잘 추정된 데이터들의 특성을 반영

-

RMSE (Root Mean Squared Error) =

- 에러에 따른 손실이 기하 급수적으로 올라가는 상황에서 적합

-

R-squared (Coefficient of determination) =

- 값이 1에 가까울 수록 성능이 좋음

-

참고

- SSE(Sum of SquaresError, 관측치와 예측치 차이):

- SSR(Sum of Squares due toRegression, 예측치와 평균 차이):

- SST(Sum of SquaresTotal, 관측치와 평균 차이): , SSE + SSR

회귀 오류지표 참조 사이트

과적합(Overfitting)과 과소적합(Underfitting)

-

테스트데이터에서 만들어내는 오차를 일반화 오차

-

훈련데이터에서와같이 테스트데이터에서도 좋은 성능을 내는 모델은 일반화가 잘 된 모델

-

모델이 너무 훈련데이터에 과하게 학습(과적합)을 하지 않도록 하는 많은 일반화 방법들이 있다

-

과적합은 모델이 훈련데이터에만 특수한 성질을 과하게 학습해 일반화를 못해 결국 테스트데이터에서 오차가 커지는 현상

-

과소적합은 훈련데이터에 과적합도 못하고 일반화 성질도 학습하지 못해 훈련/테스트 데이터 모두에서 오차가 크게 나오는 경우

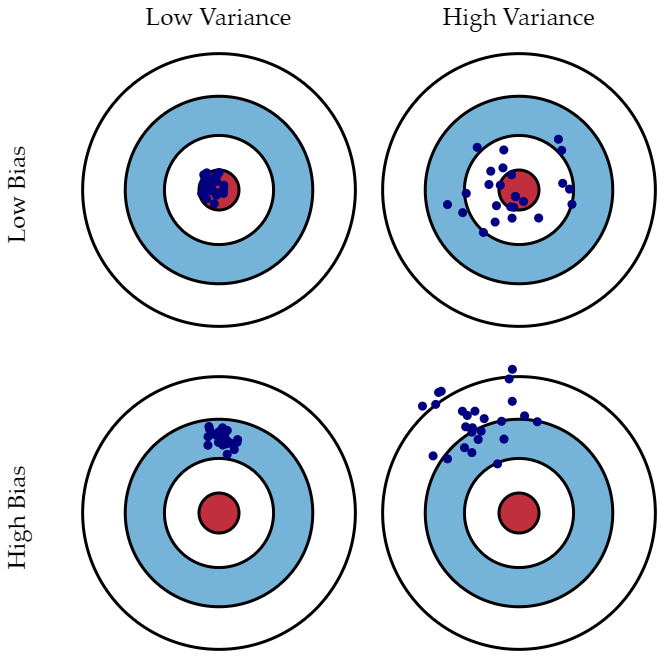

분산/편향 트레이드오프

- 분산이 높은경우는, 모델이 학습 데이터의 노이즈에 민감하게 적합하여 테스트데이터에서 일반화를 잘 못하는 경우 즉 과적합 상태

- 편향이 높은경우는, 모델이 학습 데이터에서, 특성과 타겟 변수의 관계를 잘 파악하지 못해 과소적합 상태