Evaluation Metrics for Classification

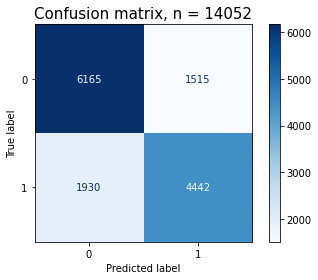

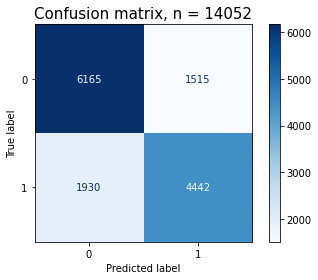

Confusion matrix

정밀도(precision), 재현율(recall)

- 정확도(Accuracy)는 전

체 범주를 모두 바르게 맞춘 경우를 전체 수로 나눈 값

- TotalTP+TN

- 정밀도(Precision)는 Positive로 예측한 경우 중 올바르게 Positive를 맞춘 비율

즉 예측값이 얼마나 정확한가

- TP+FPTP

- 재현율(Recall, Sensitivity)은 실제 Positive인 것 중 올바르게 Positive를 맞춘 것의 비율

즉 실제 정답을 얼마나 맞췄느냐

- TP+FNTP

F1점수(F1 score)는 정밀도와 재현율의 조화평균(harmonic mean)

- 2⋅precision+recallprecision⋅recall

정밀도/재현율 트레이드오프

- 특성상 정밀도 또는 재현율이 특별히 강조돼야 할 경우가 있는데 이때는 임계값을 조정해 정밀도 또는 재현율을 높일 수 있지만 정밀도와 재현율은 상호 보완적인 평가 지표이기 때문에 어느 한쪽을 높이면 다른 한쪽은 줄어들게 됨

ROC, AUC (Receiver Operating Characteristic, Area Under the Curve)

ROC curve는 모델의 판단 기준을 연속적으로 바꾸면서 측정했을 때 FPR과 TPR의 변화를 나타낸 것

- Recall(재현율) = Sensitivity = TPR=PTP=TP+FNTP=1−FNR

- 1인 케이스에 대해 1로 바르게 예측하는 비율 (Sensitivity)

- Fall-out(위양성률) = FPR=NFP=FP+TNFP=1−TNR(Specificity)

- 0인 케이스에 대해 1로 틀리게 예측하는 비율 (1-Specificity)

재현율은 최대화 하고 위양성률은 최소화 하는 임계값이 최적의 임계값AUC 는 ROC curve의 아래 면적

- 1에 가까울수록 좋은 수치이고, 0.5에 가까울수록 학습이 제대로 이루어지지 않은 모델

- 추가 참조 사이트