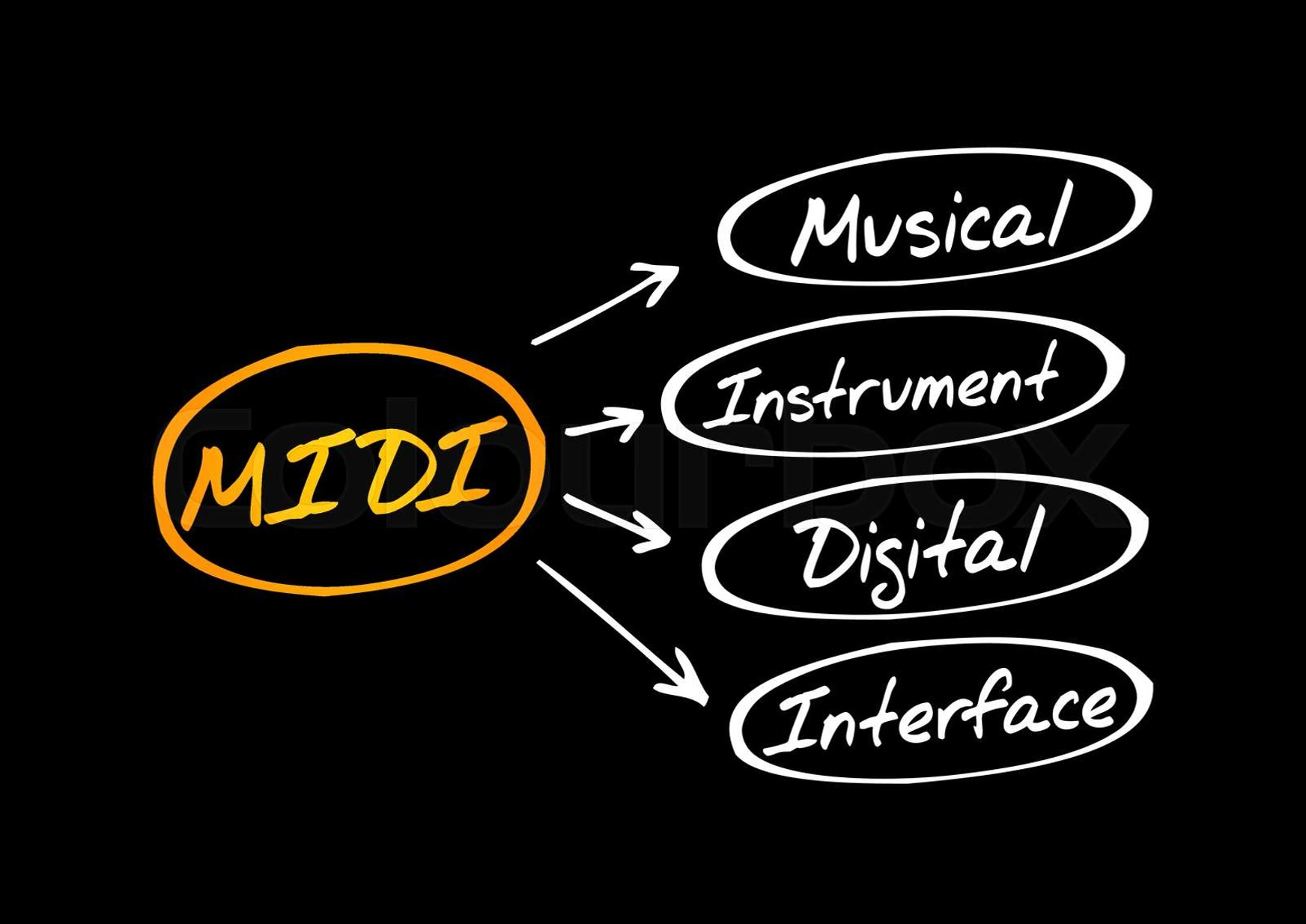

[MIDI]

MIDI는 "Musical Instrument Digital Interface"의 약자로,

음악과 음악 장치 간에 정보를 전송하고 통신하는 표준 프로토콜 및 데이터 형식이다

MIDI는 디지털 음악 기기, 컴퓨터, 신디사이저, 디지털 키보드, 드럼 머신 등의

다양한 음악 장치 간에 음악 데이터를 전송하고 제어하는 데 사용된다

MIDI의 주요 특징과 용도:

1. 음악 데이터 전송: MIDI는 음악적 이벤트 및 명령을 디지털 형식으로 나타내며,

이를 음악 장치로 전송하여 음악을 연주하거나 제어한다

이 이벤트에는 음표, 음량, 템포, 리듬, 악기 선택 등이 포함된다

2. 다중 음악 장치 제어: MIDI는 여러 음악 장치를 제어하고 조정하는 데 사용된다

MIDI 컨트롤러를 사용하여 신디사이저, 소프트웨어 음악 앱, 믹서, 이펙트 프로세서 등을 조작할 수 있다

3. 음악 제작 및 작곡: MIDI는 음악 작곡과 편곡에 널리 사용된다

작곡자는 MIDI 키보드 또는 컴퓨터 소프트웨어를 통해 MIDI 데이터를 생성하고 편집하여 음악 작품을 만든다

4. 음악 교육: MIDI는 음악 교육 분야에서 매우 유용하게 활용된다

MIDI 키보드 및 음악 교육 소프트웨어를 사용하여 학습자들은 음악 개념 및 연주 기술을 습득할 수 있다

5. 실시간 음악 공연: MIDI는 실시간 음악 공연에서도 사용된다

음악 장치 간에 실시간으로 MIDI 데이터를 전송하여 공연을 조정하고 음악적 효과를 생성한다

MIDI 파일은 MIDI 데이터를 저장하는 파일 형식이다

MIDI 파일에는 음악 이벤트, 악기 정보, 템포, 박자 및 다양한 음악 관련 정보가 포함되어 있으며,

이 파일은 MIDI 호환 장치 및 소프트웨어에서 재생되거나 편집된다

MIDI는 디지털 음악 제작 및 관리에서 중요한 역할을 하며, 다양한 음악 장르와 분야에서 사용되고 있다1. 음원 파일 자체를 딥러닝 모델에 넣어서 비슷한 음악 출력 (배제)

- 음악의 특성들을 추출하여 csv 파일로 만드는 과정의 부분이 같음, 비효율적, 더 많은 데이터량 요구2. 음원과 비슷한 음악 생성

- 음악적 특성 이외에도 악보 분석, 악기 정보 및 음표에 대한 세부 정보가 필요하며

음악 생성 모델의 품질에 영향을 끼치기 때문에 필요하다

(현재 우리는 악보 분석과 악기 정보가 없음)[전체 과정의 단계]

단계 1: 데이터 수집

음악 생성을 위한 데이터를 수집합니다.

MIDI 파일은 음악 데이터를 표현하는 데 자주 사용되며, 다양한 곡을 MIDI 형식으로 얻을 수 있습니다.

단계 2: 데이터 전처리

수집한 MIDI 파일을 파싱하여 음악 노트와 시간 정보를 추출합니다.

시간 정보를 정규화하고 시퀀스 데이터로 변환합니다.

데이터를 모델에 입력할 수 있는 형식으로 처리합니다.

단계 3: 모델 선택

음악 생성에는 여러 모델을 사용할 수 있습니다.

여기서는 LSTM (Long Short-Term Memory) 기반의 RNN 모델을 사용합니다.

단계 4: 모델 훈련

전처리된 데이터를 사용하여 모델을 훈련합니다. 모델은 시퀀스 데이터를 입력으로 받고,

다음 음악 노트를 예측하도록 학습합니다.

모델의 손실을 최소화하기 위해 역전파 알고리즘을 사용하여 가중치를 조정합니다.

단계 5: 음악 생성

훈련된 모델을 사용하여 새로운 음악을 생성합니다.

초기 음표나 멜로디를 주고, 모델이 나머지 음악을 생성하도록 합니다.

생성된 음악을 MIDI 파일로 저장하거나 재생합니다.

TensorFlow와 Keras를 사용하여 LSTM 기반의 음악 생성 모델을 구현합니다.[전체 과정의 틀]

import tensorflow as tf from tensorflow import keras from tensorflow.keras.layers import LSTM, Dense import numpy as np# 데이터 전처리 (이 부분은 실제 데이터에 따라 달라집니다) # X: 입력 시퀀스 데이터, y: 다음 음악 노트 # X와 y를 적절히 전처리하세요.# LSTM 기반 모델 정의 model = keras.Sequential() model.add(LSTM(256, input_shape=(X.shape[1], X.shape[2]), return_sequences=True)) model.add(LSTM(256, return_sequences=True)) model.add(Dense(len(unique_notes), activation='softmax'))# 모델 컴파일 model.compile(loss='categorical_crossentropy', optimizer='adam')# 모델 훈련 model.fit(X, y, epochs=50, batch_size=64)# 음악 생성 def generate_music(seed_sequence, length=100): generated_music = [] pattern = seed_sequence for i in range(length): x_pred = np.reshape(pattern, (1, len(pattern), 1)) x_pred = x_pred / float(n_vocab) prediction = model.predict(x_pred, verbose=0) index = np.argmax(prediction) result = int_to_note[index] generated_music.append(result) pattern.append(index) pattern = pattern[1:] return generated_music# 초기 시퀀스를 지정하여 음악 생성 seed_sequence = # 초기 시퀀스를 정의하세요. generated_music = generate_music(seed_sequence, length=200) # 생성된 음악을 MIDI 파일로 저장하거나 출력 # 이 부분은 MIDI 파일로 저장하는 코드를 추가해야 합니다.

[전처리 과정 단계]

단계 1: 지정된 디렉토리에서 MIDI 파일을 읽어옵니다.

단계 2: MIDI 파일에서 음악 데이터를 추출합니다. 이때, 음표와 코드를 분리하고 문자열로 변환합니다.

단계 3: 추출한 음악 데이터를 숫자로 매핑합니다.

단계 4: 시퀀스 데이터를 생성하고 입력 시퀀스와 출력 시퀀스로 분리합니다.

단계 5: 데이터를 정규화하여 모델에 입력할 수 있는 형식으로 준비합니다.

이렇게 전처리된 데이터는 모델 훈련에 사용됩니다.

코드 예제에서 input_sequences와 output_sequences는 모델에 입력되는 데이터입니다.

이 데이터를 사용하여 모델을 훈련하고 음악을 생성할 수 있습니다.[전처리 부분]

import os import numpy as np from music21 import converter, instrument, note, chord# MIDI 파일 경로 지정 midi_dir = 'your_midi_directory' # MIDI 파일이 저장된 디렉토리 midi_files = os.listdir(midi_dir)# 음악 데이터 추출 및 전처리 notes = []for file in midi_files: midi = converter.parse(os.path.join(midi_dir, file)) parts = instrument.partitionByInstrument(midi) if parts: # 악기별로 분리 notes_to_parse = parts.parts[0].recurse() else: # 악기 정보가 없는 경우 notes_to_parse = midi.flat.notes for element in notes_to_parse: if isinstance(element, note.Note): # 음표 notes.append(str(element.pitch)) elif isinstance(element, chord.Chord): # 코드(동시에 여러 음표를 포함하는 경우) notes.append('.'.join(str(n) for n in element.normalOrder))# 추출한 음악 데이터 확인 print(notes[:20]) # 처음 20개의 음표 또는 코드를 출력# 음악 데이터를 숫자로 매핑 unique_notes = sorted(set(notes)) note_to_int = {note: i for i, note in enumerate(unique_notes)} int_to_note = {i: note for i, note in enumerate(unique_notes)}# 시퀀스 데이터 생성 sequence_length = 100 # 시퀀스의 길이 (조절 가능)input_sequences = [] output_sequences = []for i in range(0, len(notes) - sequence_length, 1): input_sequence = notes[i:i + sequence_length] output_sequence = notes[i + sequence_length] input_sequences.append([note_to_int[note] for note in input_sequence]) output_sequences.append(note_to_int[output_sequence])# 데이터 정규화 n_vocab = len(unique_notes) input_sequences = np.reshape(input_sequences, (len(input_sequences), sequence_length, 1)) input_sequences = input_sequences / float(n_vocab) output_sequences = np.array(output_sequences)# 데이터 확인 print("총 고유 음표/코드 수:", n_vocab) print("입력 시퀀스 예시:", input_sequences[0]) print("출력 시퀀스 예시:", output_sequences[0])

3. 음원의 음악 스타일 변환

- 음악적 특성 이외에도 악보 분석, 악기 정보 및 음표에 대한 세부 정보가 필요하며

음악 생성 모델의 품질에 영향을 끼치기 때문에 필요하다

(현재 우리는 악보 분석과 악기 정보가 없음)

+ 음악 스타일 변환 과정은 일반적으로 다른 음악 생성 과제보다 복잡할 수 있다

그 이유는 음악 스타일은 음악의 다양한 측면에 영향을 미치기 때문이다

따라서 원하는 결과를 얻기 위해 세부적인 음악적 특징을 고려하거나 보다 정교한 모델 아키텍처와 기술을 적용해야 할 수 있다[전체 과정의 단계]

단계 1: 데이터 수집

원본 스타일과 대상 스타일의 음악 데이터를 수집합니다.

각 스타일에 해당하는 MIDI 파일 또는 음악 데이터를 확보해야 합니다.

단계 2: 데이터 전처리

수집한 음악 데이터를 모델에 입력할 수 있는 형식으로 전처리합니다.

MIDI 파일을 읽고 음악 데이터를 추출하는 방법은 이전 답변에서 설명한 것과 유사합니다.

단계 3: 모델 선택

음악 스타일 변환에는 주로 생성적 적대 신경망(GAN) 또는 Pix2Pix와 같은 이미지 스타일 변환 모델을 사용합니다.

이 모델들은 이미지를 한 스타일에서 다른 스타일로 변환하는 데 사용될 수 있으며,

음악 데이터를 이미지로 변환하여 음악 스타일을 변경합니다.

단계 4: 모델 훈련

선택한 모델을 데이터로 훈련시킵니다.

이 모델은 원본 스타일의 음악을 입력으로 받고 대상 스타일의 음악을 생성하도록 학습합니다.

모델 훈련은 주어진 데이터셋과 모델 아키텍처에 따라 조정됩니다.

단계 5: 음악 생성

훈련된 모델을 사용하여 원본 스타일의 음악을 대상 스타일로 변환합니다.

이 때, 입력 음악과 대상 스타일의 특징을 조절할 수 있는 하이퍼파라미터를 설정할 수 있습니다.[모델 선택 및 훈련에 대한 코드 예제]

import tensorflow as tf from tensorflow import keras from tensorflow.keras.layers import Input, Conv2D, Concatenate from tensorflow.keras.models import Model import numpy as np# 원본 스타일의 음악 데이터 (이미지)를 로드하여 전처리합니다. # 대상 스타일의 음악 데이터 (이미지)를 로드하여 전처리합니다.# Pix2Pix 모델 아키텍처 정의 def define_model(): # 인코더 (원본 스타일 이미지를 입력으로 받음) in_image = Input(shape=(256, 256, 3)) e1 = Conv2D(64, (4, 4), strides=(2, 2), padding='same')(in_image)# 디코더 (대상 스타일 이미지를 출력으로 생성) d1 = Conv2D(64, (4, 4), padding='same')(e1) g = Concatenate()([d1, e1])# 출력 이미지 크기: (256, 256, 3) out_image = Conv2D(3, (7, 7), activation='tanh', padding='same')(g)model = Model(in_image, out_image) return model# 모델 생성 model = define_model()# 모델 컴파일 model.compile(optimizer='adam', loss='mean_squared_error')# 원본 스타일 이미지와 대상 스타일 이미지로 훈련 데이터 생성 X_train = # 원본 스타일 이미지 데이터 y_train = # 대상 스타일 이미지 데이터# 모델 훈련 model.fit(X_train, y_train, epochs=100, batch_size=1)# 원본 스타일의 음악 이미지를 입력으로 주고, 대상 스타일의 음악 이미지를 생성 output_image = model.predict(input_image)

- 이 코드 예제에서는 Pix2Pix 스타일 변환 모델을 사용하여 원본 스타일의 이미지를 대상 스타일의 이미지로 변환하는 방법을 보여줍니다. 음악 데이터를 이미지로 전환하여 이 모델을 적용할 수 있습니다.

- 실제로 음악 스타일 변환을 위해서는 데이터의 형식과 모델 아키텍처를 조정해야 할 수 있으며, MIDI 파일을 어떻게 이미지로 변환할지에 대한 추가적인 작업이 필요합니다.

[원본 스타일과 대상 스타일의 음악 데이터 (이미지)를 로드하여 전처리 하는 부분]

음악 스타일 변환을 위해 음악 데이터를 이미지로 전환하려면 음악 데이터를 이미지로 매핑해야 합니다.

아래는 MIDI 파일에서 이미지로 음악 데이터를 전환하는 예제 코드입니다.

이 코드는 MIDI 파일을 이미지로 변환하는 것을 보여줍니다.import os import numpy as np from PIL import Image from music21 import converter, stream# MIDI 파일을 이미지로 변환하는 함수 def midi_to_image(midi_file, output_dir, image_size=(256, 256)): # MIDI 파일을 로드하고 음악 스트림을 생성 midi_stream = converter.parse(midi_file)# 음악 스트림을 이미지로 변환 image = stream.Stream() image.append(midi_stream)# 이미지 크기 설정 및 이미지 생성 image_file = os.path.join(output_dir, os.path.basename(midi_file.replace('.midi', '.png'))) image.write('png', image_file, image_size) return image_file# 원본 스타일의 MIDI 파일 경로 및 대상 스타일의 MIDI 파일 경로 설정 original_style_midi = 'path_to_original_style.midi' target_style_midi = 'path_to_target_style.midi'# 이미지로 변환된 원본 스타일 음악 데이터를 저장할 디렉토리 설정 output_dir = 'output_images/'# 이미지로 변환된 원본 스타일의 음악 데이터 생성 original_style_image = midi_to_image(original_style_midi, output_dir)# 이미지로 변환된 대상 스타일의 음악 데이터 생성 target_style_image = midi_to_image(target_style_midi, output_dir)# 이미지 파일 경로 출력 print("원본 스타일 이미지:", original_style_image) print("대상 스타일 이미지:", target_style_image)

- 위의 코드 예제에서는 Music21 라이브러리를 사용하여 MIDI 파일을 이미지로 변환합니다.

- MIDI 파일에서 생성된 이미지는 지정된 디렉토리에 저장됩니다.

- 이렇게 변환된 이미지를 Pix2Pix 또는 다른 이미지 스타일 변환 모델에 입력하여 음악 스타일을 변환할 수 있습니다.

[Music21을 이용한 MIDI 음악 데이터 추출 Kaggle 코드]

https://www.kaggle.com/code/wfaria/midi-music-data-extraction-using-music21