최소제곱법 (method of least squares)

- 최소제곱법 또는 최소자승법 (링크)

잔차제곱합(RSS: Residual Sum of Squares)를 최소화하는 가중치 벡터를 구하는 방법

우리가 사용하는 예측 모형은 다음과 같이 상수항이 결합된 선형모형y^=Xβ (=xaTβa=βaTxa)

#N개의 데이터에 대해서

y^=⎣⎢⎢⎢⎢⎢⎡y0^y1^y2^⋯yN^⎦⎥⎥⎥⎥⎥⎤, X=⎣⎢⎢⎢⎢⎢⎡111⋯1x11x21x31xN1x12x22x32xN2⋯⋯⋯⋯x1Dx2Dx3DxND⎦⎥⎥⎥⎥⎥⎤, β=⎣⎢⎢⎢⎢⎢⎡β0β1β2⋯βD⎦⎥⎥⎥⎥⎥⎤

이때 잔차 벡터(residual vector) e는e=y−y^=y−βX 이고 잔차 제곱합(RSS:residual sum of squares)은

RSS=eTe=(y−βX)T(y−βX)=yTy−2yTXβ+βTXTXβ

#전치 행렬의 특징

(M+N)T=MT+NT

(cM)T=cMT

MTT=M

(MN)T=NTMT

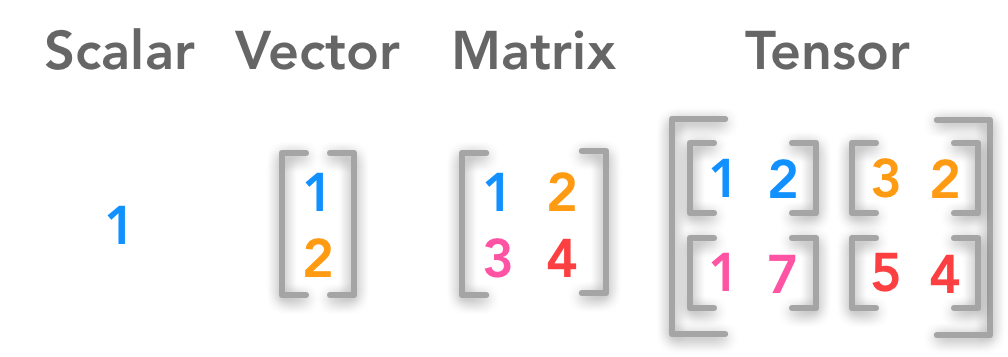

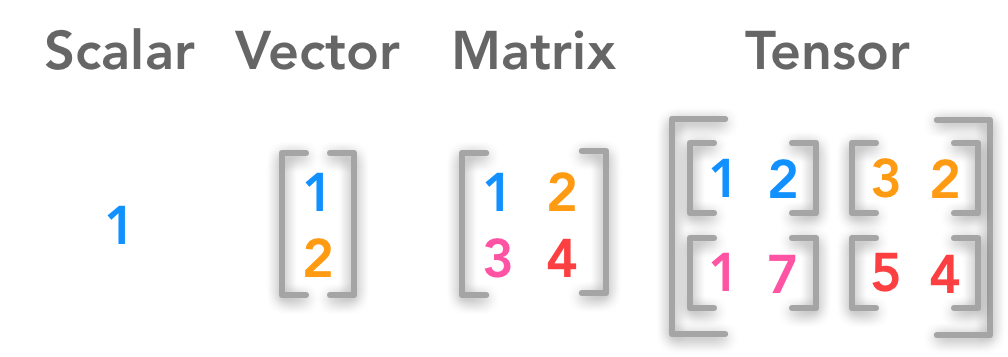

#βTXTy와 yTXβ는 행렬의 곱셈에 의해 스칼라 값이므로 βTXTy=yTXβ