20211025

1. ImageNet Challenge

이미지넷(ImageNet): 대량의 이미지를 포함하는 데이터셋으로 챌린지 데이터셋으로도 제공되었다.

-

NEC-UIUC팀: Descriptor Coding + SVM (오류율 28%, 2010)

-

Xerox Research Centre Europe(오류율 26%, 2011)

-

SuperVision팀: 네트워크를 깊게 쌓은 AlexNet (오류율 16%, 2012)

Top-1, Top-5 accuracy

ImageNet Pretrained Model의 Accuracy 종류

Top-1 accuracy: 일반적으로 생각하는 정답을 맞춘 정확도

Top-5 accruacy: 예측 확률 중 위에서부터 5개 내에 정답이 있으면 맞춘 것으로 간주한 정확도

2. AlexNet

-

GPU의 병렬 연산

-

ReLU, 드롭아웃(Dropout), 오버래핑 풀링(Overlapping pooling) 등 적용

-

가장 깊은 조건: CNN 7개(사전 학습 적용), FCN 2개

3. VGG

-

간결한 구조

-

VGG16: 16개의 층, VGG19: 19개의 층

-

3x3 커널 사용 → 더 많은 레이어를 쌓고 이미지의 비선형적 특성을 잘 잡아냄

-

레이어에 따른 연산 → N x (k x k) x C^2

-

N: 레이어 수

-

k: 커널 사이즈

-

C: 입출력 채널 수

-

GoogleNet과의 차이

-

레이어의 수: 22개

-

Inception block도입으로 다양한 기법 사용

4. 기울기 소실(Vanishing gradient)

모델의 깊이가 깊어질수록 gradient가 소실되는 현상 발생.

깊은 레이어에는 데이터에 따른 차이가 충분하게 반영되기 어렵다.

-

레이어가 깊어짐에 따라 Gradient가 매우 커지거나 작아져 발생

-

이 문제를 해결하기 위해 ResNet은 새로운 방법을 도입

- 활성화 함수 변경

- 가중치 초기화 방법을 통한 문제 완화

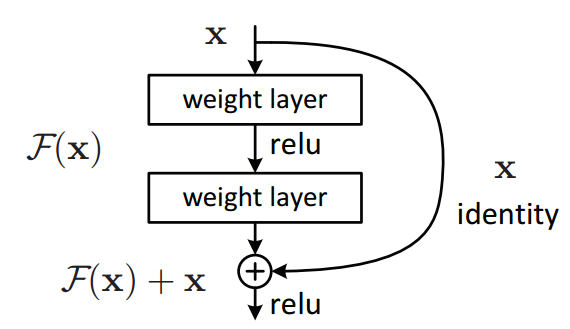

5. Skip Connection

ResNet에서 Vanishing/Exploding Gradient 문제 해결을 위해 Skip Connection 사용.

레이어의 입력을 다른 곳에 이어서 Gradient가 깊은 곳까지 이어지도록 한다.

Residual Block: 레이어와 Skip Connection이 있는 블록

참고 자료

TensorFlow-Slim image classification model library

bskyvision님의 이미지 분류 모델 평가에 사용되는 top-5 error와 top-1 error

Stackoverflow Evaluation & Calculate Top-N Accuracy: Top 1 and Top 5

ImageNet Classification with Deep Convolutional Neural Networks

VERY DEEP CONVOLUTIONAL NETWORKS FOR LARGE-SCALE IMAGE RECOGNITION