🙆♀️ 개요

좋은 딥러닝 학습자

- 구현(implementation) 능력

- Tensorflow, Pytorch

- 수학 능력

- 선형 대수, 확률

AI, ML, DL

- AI(Artificial Inteligence)

- 인간의 지능 모방

- ML(Machine Learning)

- 데이터 기반의 접근

- 강아지와 고양이 분류 모델

- DL(Deep Learning)

- 신경망(Nural Network) 구조를 사용하는 분야

딥러닝 학습의 핵심 요소

- 모델이 학습할 수 있는 데이터

- 말뭉치 for NLP

- 데이터를 변환하는 모델

- 학습 모델

- 학습 정의

- 입력(이미지), 출력(라벨)

- 모델의 불량을 수량화하는 손실 함수(Loss Function)

- 손실을 최소화할 수 있는 변수를 적용하는 알고리즘

데이터

- 해결하려는 문제에 따라 유형이 달라진다

- Classification

- 강아지와 고양이의 이미지

- Semantic Segmentation

- 대상이 아닌 픽셀에 대한 클래스

- Detection

- 물체에 대한 Bounding Box

- Pose Estimation

- 2차원, 3차원 스켈레톤 정보

- Visual Q&A

- 이미지와 문장

- 질문과 답

모델

- 이미지, 텍스트, 단어를 변환해주는 것

- 같은 데이터도 모델의 성질에 따라 결과가 달라진다

손실(Loss)

- 손실 함수

- 달성하려는 값의 근사치, 기준

- 정해진 모델과 데이터를 어떻게 학습시킬 것인가 결정

- 손실 함수가 줄어든다고 해서 원하는 결과를 항상 얻을 수 있는 것은 아니다

- 정해진 풀이가 없다

- 목표에 가장 가까워질 수 있는 방법 선택할 것

최적화 알고리즘

- 신경망의 parameter

- 모멘텀

- 물체가 한 방향으로 지속적으로 변동하려는 경향

- Optimizer

- 딥러닝에서 network가 빠르고 정확하게 학습하는 것이 목표

- 때로는 학습이 안 되게 하는 효과를 찾기도 한다

- 목적

- 실제 환경에서 잘 동작하도록 하는 것

🔮 Historical Review

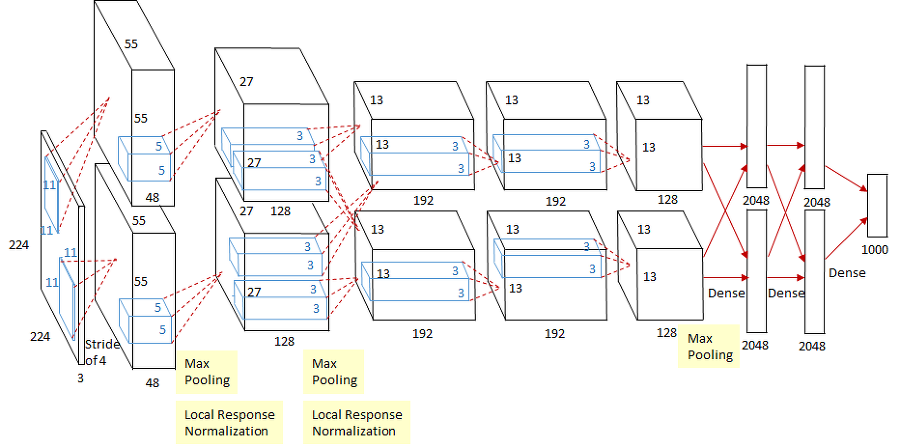

- AlexNet(2012)

- 8개 계층(227*227)으로 구성된 Convolution 신경망(CNN)

- ILSVRC(ImageNet Large Scale Visual Recognition Challenge) 대회 우승

- 이전에는 고전적인 ML 적용

- DQN(2013)

- Google DeepMind 개발(알파고)

- 강화 학습이 가능한 심층 신경망

- 아타리 2600의 게임들을 인간 수준으로 플레이 가능한 AI

- Encoder / Decoder(2014)

- NMT(Neural Machine Translator)

- 구글 번역

- 영어 >> 중국어(단어의 연속)

- Adam Optimizer(2014)

- Adaptive Moment Estimation

- 자주 사용되는 optimizer

- 간단한 구현

- 효율적인 연산

- 메모리 요구 사항이 없음

- RMSPorp와 Momentum 기법을 합친 Optimizer

- Generative Adversarial Network(2015)

- 생성적 적대 신경망

- 비지도 학습에서 사용되는 인공지능 알고리즘

- 제로섬 게임 틀 안에서 서로 경쟁하는 두 개의 신경 네트워크 시스템에 의해 구현

- Residual Networks(2015)

- ResNet

- 네트워크를 깊게 쌓는 기법의 효용을 널리 알린 알고리즘

- 이전에는 네트워크를 쌓는 것이 좋은 결과를 보장하지 못함