RNN

Introduction

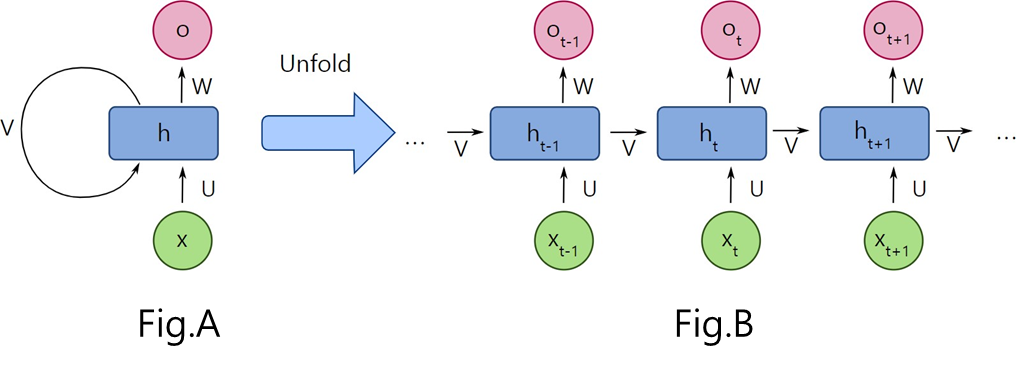

- Recurrent Neural Network

- 입력과 출력을 시퀀스 단위로 처리하는 시퀀스 모델

Problem: Input sequence가 너무 길어지면, parameters가 더 많이 필요함

Structures

- Use the same computational function and parameters

- 은닉층의 메모리 셀은 현재 시점 t에서 바로 이전 시점 t-1에서의 은닉층의 메모리 셀에서 나온 값을 자신의 입력으로 사용하는 재귀적 활동을 함

Two types of input

- Input data of sequences

- Previous hidden state

Two types of output

- Output data of input data (optional)

- Current hidden state for next time step

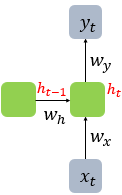

표현

Feed forward neural net: Neuron 이라는 단위RNN: 입력 벡터, 출력 벡터, 은닉 상태(hidden state)라는 표현 사용

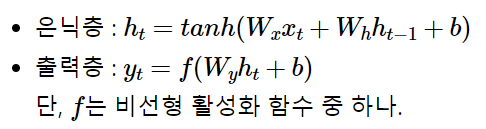

수식

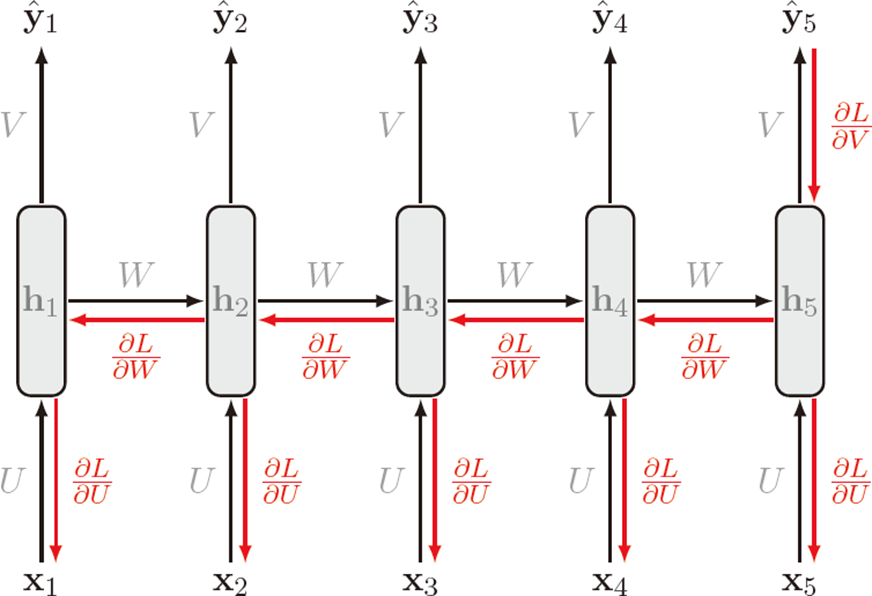

Back propagation

CNN에서는 batch로 묶고 forward한 후, back 하면 동시에 계산되어 weight이 한번에 업데이트 됨RNN은 순서가 있기에 backpropagation도 순서대로 해야한다.- Forward propagation can't be parallelized.

Example

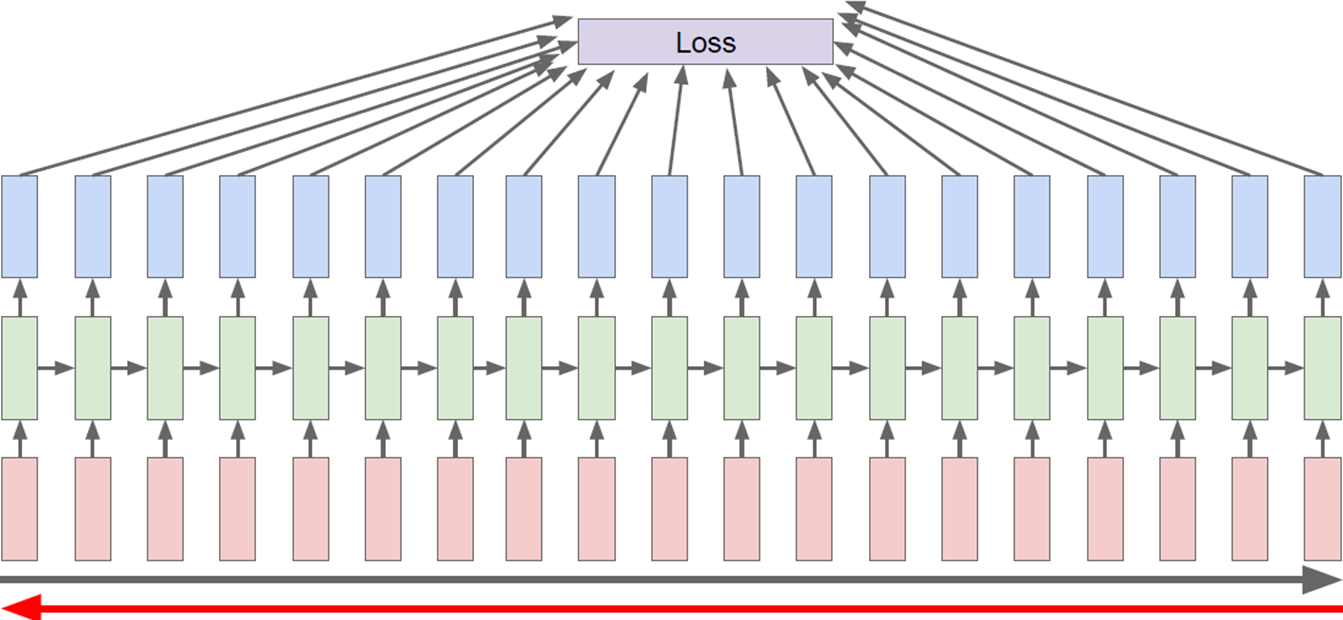

- Loss가 전달되기까지 너무 오래 걸린다.

- Run forward and backward through chunks of the sequences

- Parallelize 가능

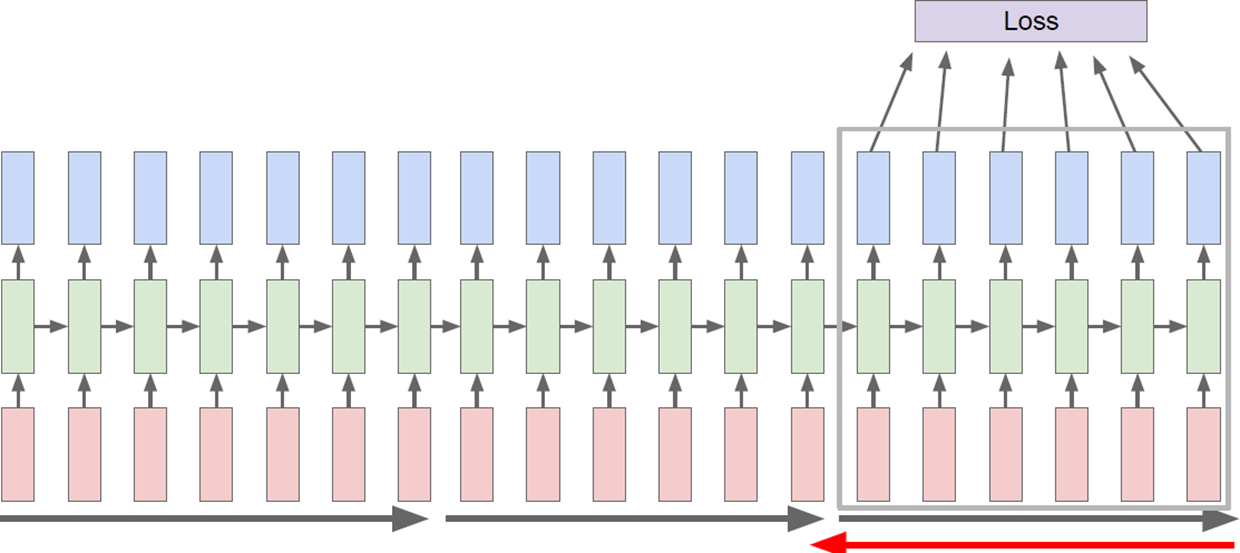

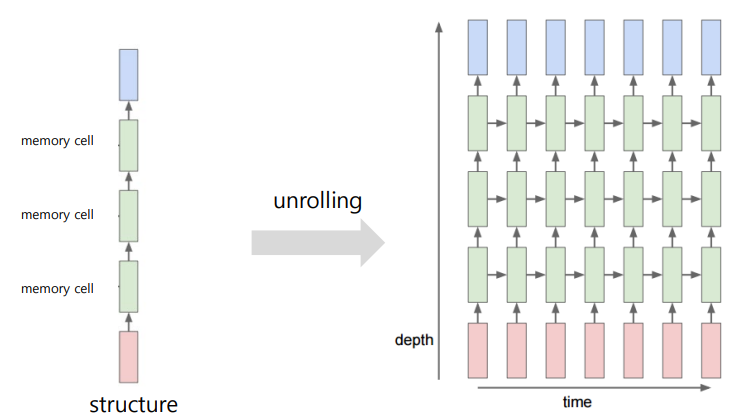

Multi-layered RNN

- Hidden을 여러 개 쌓음

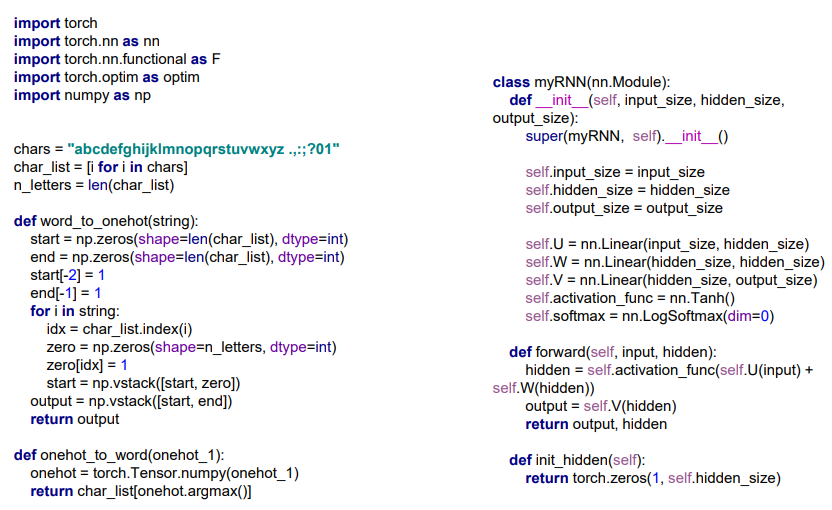

Source Code