Paper Review

1.Paper Review : Structured Knowledge Distillation for Semantic Segmentation

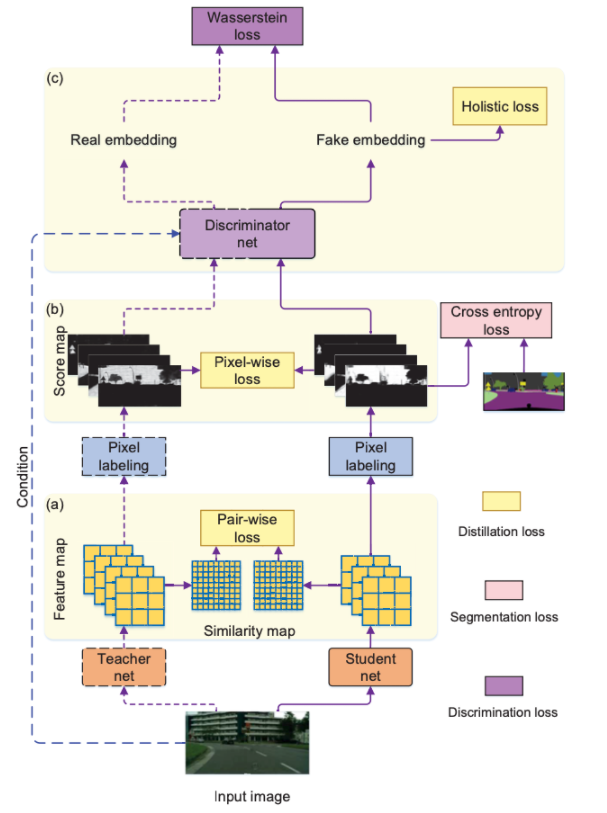

이 논문은 semantic segmentation 분야에 있어서 지식증류 기법(Knowledge Distillation)을 이용하였다.Knowledge Distillation을 Semantic Segmentation 분야에 이용하였다.GAN 구조를 이용하였다.이 논문에

2022년 3월 25일

2.Paper Review : Intra-class Feature Variation Distillation for Semantic Segmentation

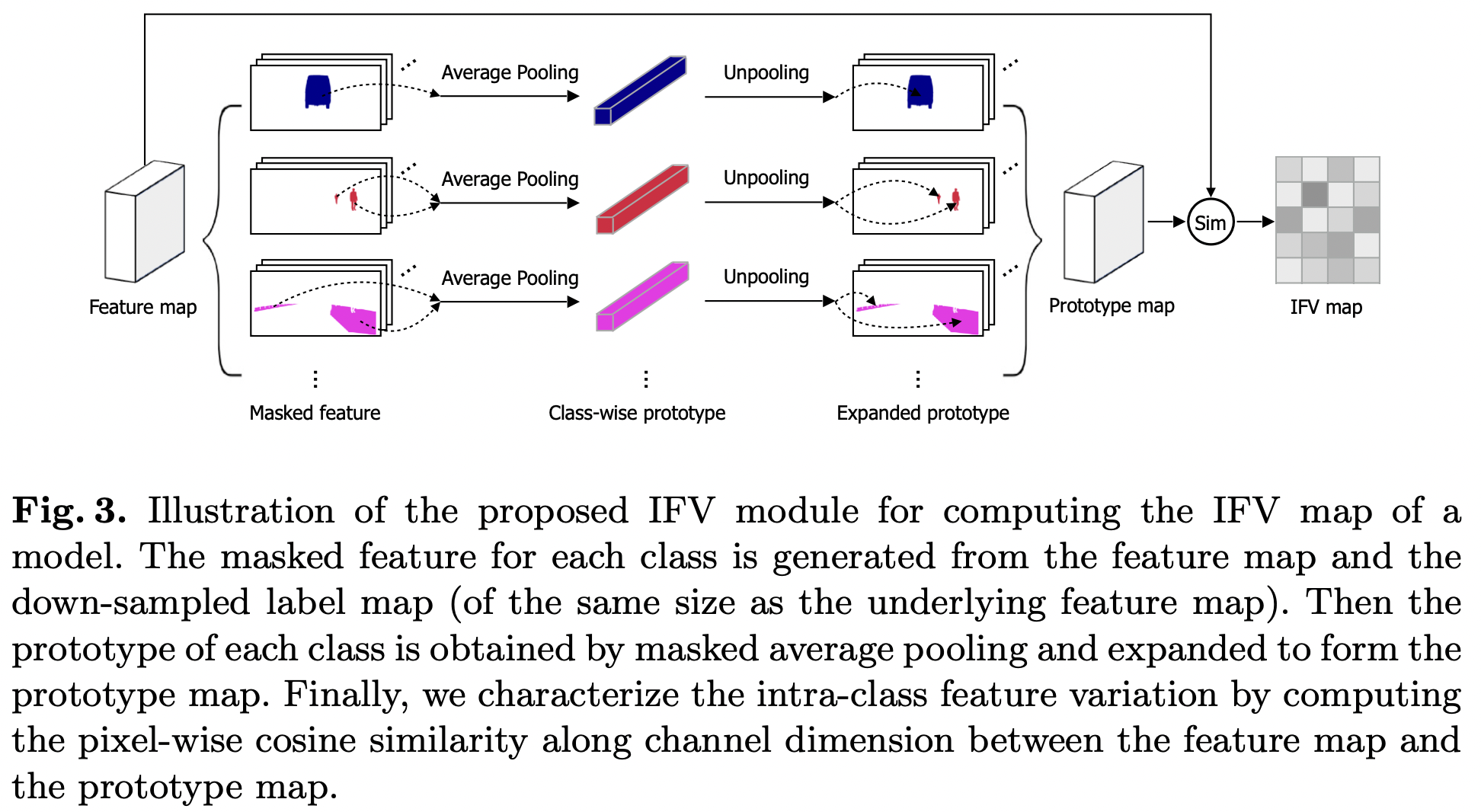

이 논문은 이전의 pairwise relation에서 knowledge distillation을 하던 것들과 달리 새로운 방법론을 제시한다. intra-class feature variation distillation (IFVD)인데 intra-class feature

2022년 6월 2일

3.PAPER REVIEW : Student Customized Knowledge Distillation : Bridging the Gap Between Student and Teacher

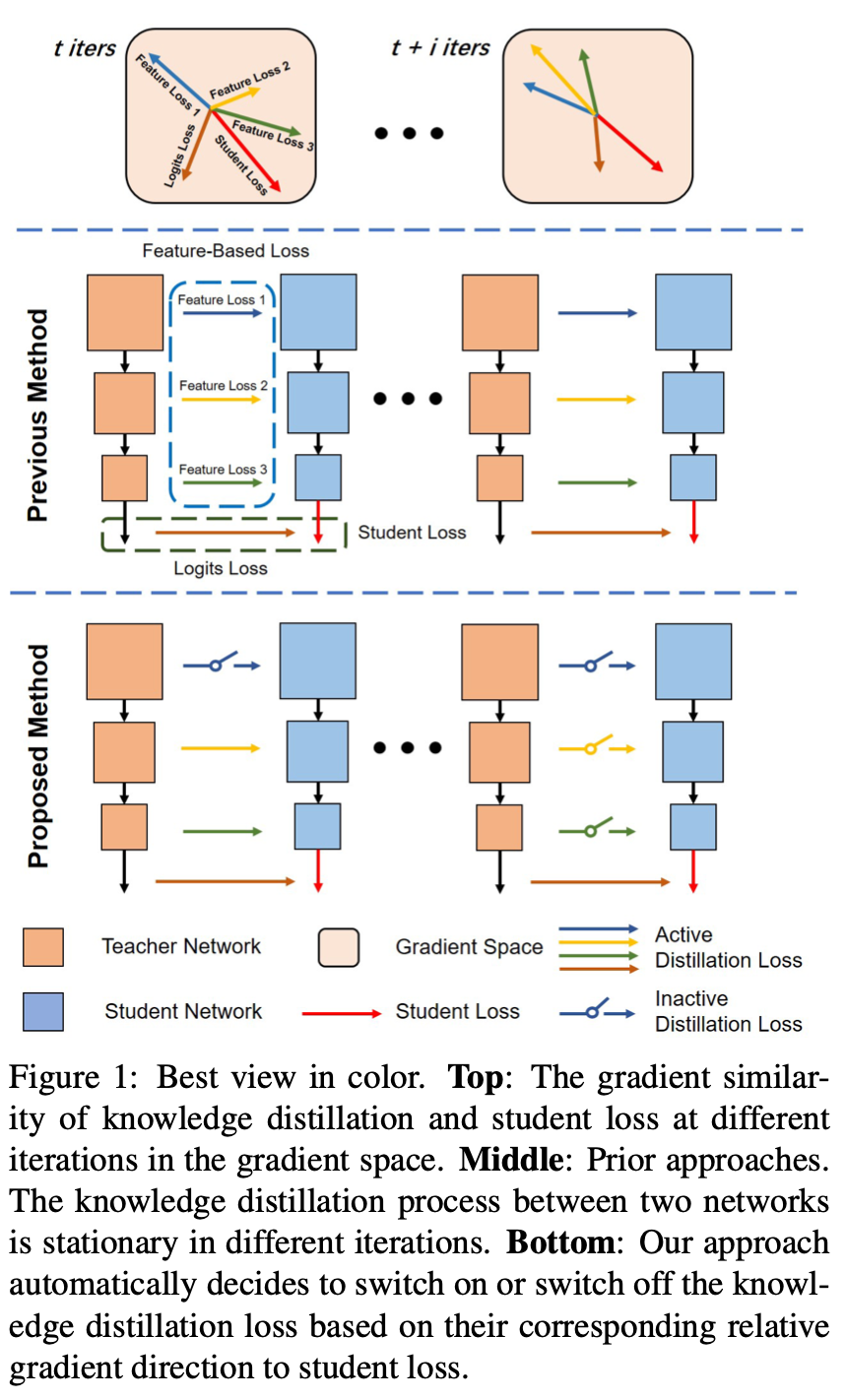

본 논문은 Knowledge Distillation 분야 중 Feature Distillation 분야와 관련된 논문이다. 논문의 저자는 "좋은 교사 모델이 학생에게 좋은 정보만 주는가"에 대해 초점을 맞춰 연구 방향성을 잡았다. 이전의 연구들에서는 좋은 교사들이 좋은

2022년 7월 2일