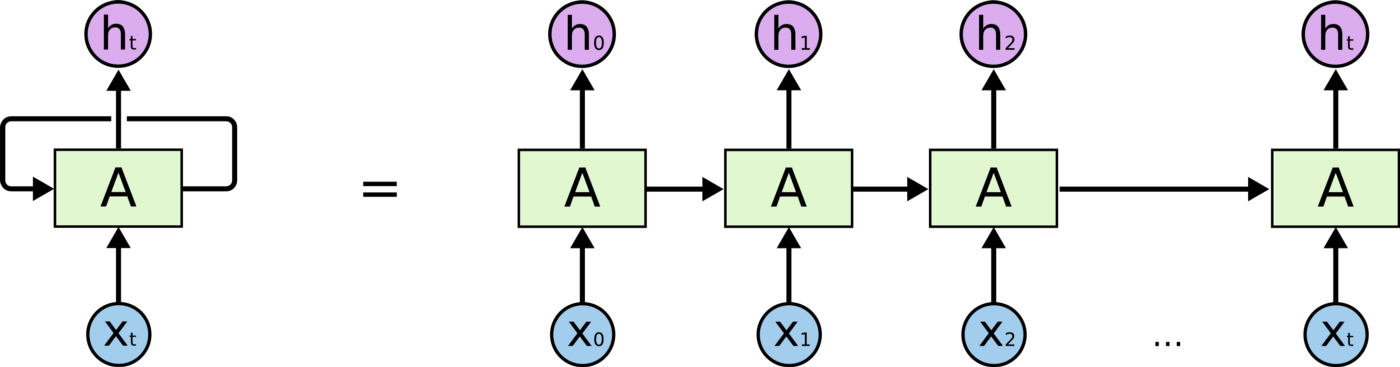

RNN

- Neural Net + Recurrent connection

- 문제점: vanish/explode gradient problem

-> Control Unit (gate)를 달자 -> LSTM

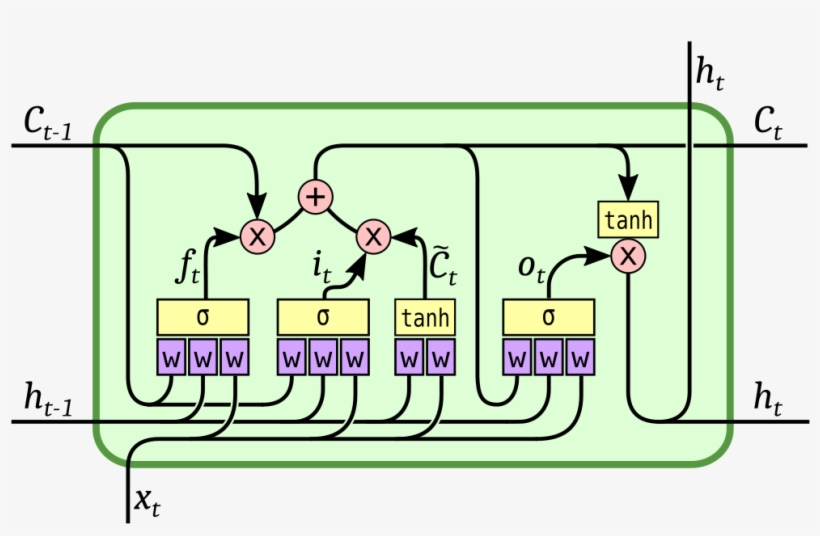

LSTM

- 구성

- 3개의 Gate (, , )

- 2개의 Output (, )

- 4개의 Params (, , , )

- 기존의 RNN + Cell

- Cell: long term memory(t-1 & t의 조합)를 기억

- 기억할지 말지(Gate)는 데이터에 의해 학습됨

- 모든 게이트는 hidden unit과 x를 input으로 받음