Context-aware Recommendation

- 지금까지 추천 시스템에서 유저, 아이템, 유저 아이템 상호작용 정보를 사용

- 성별, 연령과 같은 메타 데이터는 사용하지 못하였음

- Cold Start에 대한 대처가 어려움

문제 정의

- 유저, 아이템 상호작용 정보와 함께 맥락 (Context)적 정보도 함께 반영하는 추천 시스템

- X와 Y의 값을 추론하는 예측 데이터로 변경 (General Predictor)

Click-Through Rate Prediction

- CTR 예측

- 유저가 아이템을 클릭할 확률을 예측하는 문제

- CTR 예측은 주로 광고에서 사용

- Y값은 클릭 여부 0, 1

- 모델이 출력한 실수 값을 시그모이드에 통과 시키면 예측 CTR 값이 됨

- 유저 ID가 존재하지 않는 데이터도 다른 유저 Feature, Context Feature를 통해 예측 가능

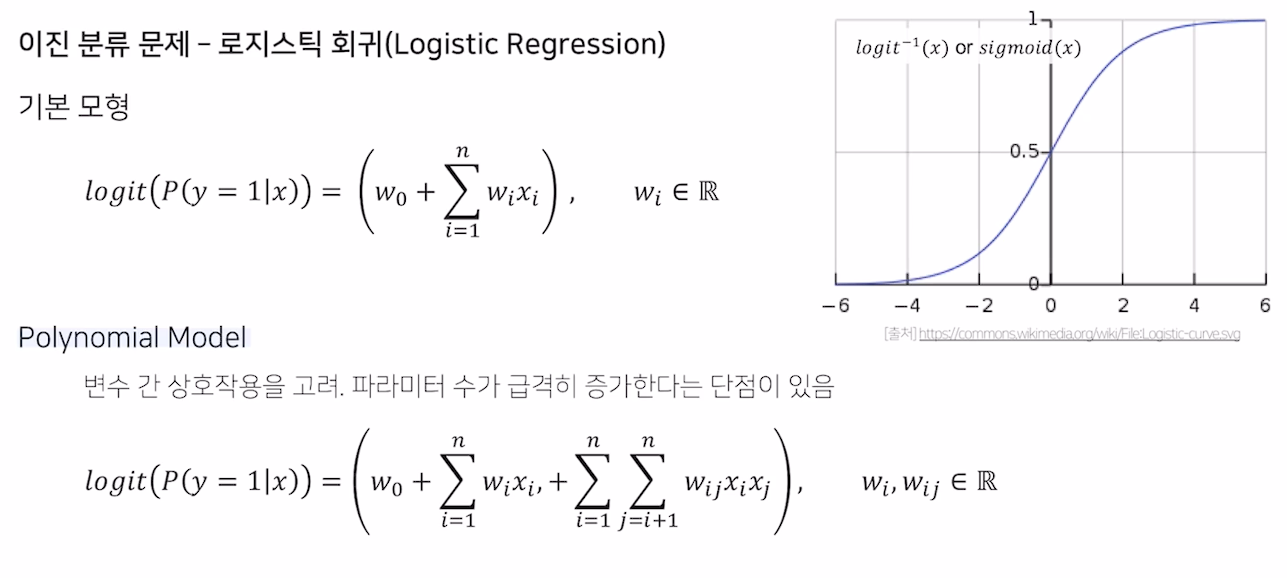

Logistic Regression

- 이후 모델들 모두 로지스틱 회귀로 부터 시작

- Polynomial Model로 상호작용을 고려할 수 있음

- Parameter가 급격히 증가한다는 단점

사용 데이터

Dense Feature

- 벡터로 표현 시 작은 공간에 밀집되어 분포하는 수치형 변수

Sparse Feature

- 벡터로 표현했을 시 넓은 공간에 분포하는 범주형 변수

- 날짜.. 등

- CTR 예측의 대부분 Feature는 Sparse Feature

- One-Hot Encoding해야 하기에 파라미터가 너무 많아질 수 있음, 과적합 발생 가능

- Feature Embedding 한 이후에 이 피쳐를 사용해 예측하기도 함

정리

- 어떻게 Sparse 한 데이터를 embedding 할 것인가

- 어떻게 상호작용을 고려할 것인가

- 이 둘에 집중하며 모델을 탐색

Factorization Machines

- SVM과 Factorization Model의 장점을 결합한 모델

- SVM이 추천 시스템에서 가장 많이 사용됨

- 그러나 CF 환경에서는 SVM보다 MF 계열 모델이 더 높은 성능 (Sparse한 환경)

- 그러나 MF 모델은 특별한 데이터에만 적용할 수 있음

- 둘을 결합할 수는 없을까?

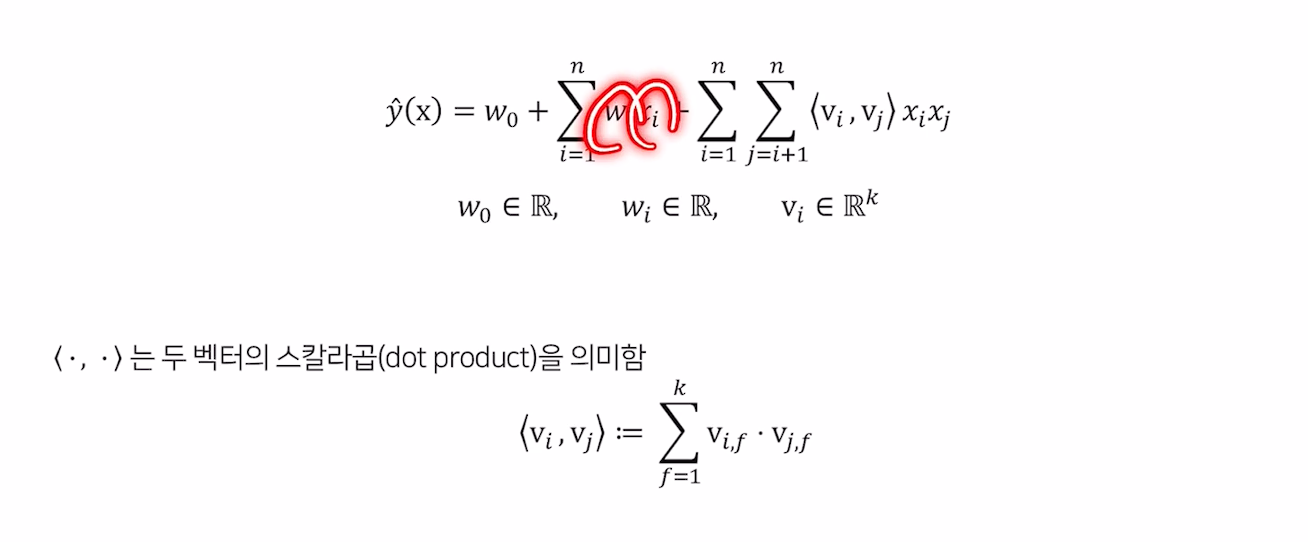

수식

- Vi,Vj는 k차원의 벡터

- 로지스틱 회귀에서 상호작용 벡터 term을 추가한 것

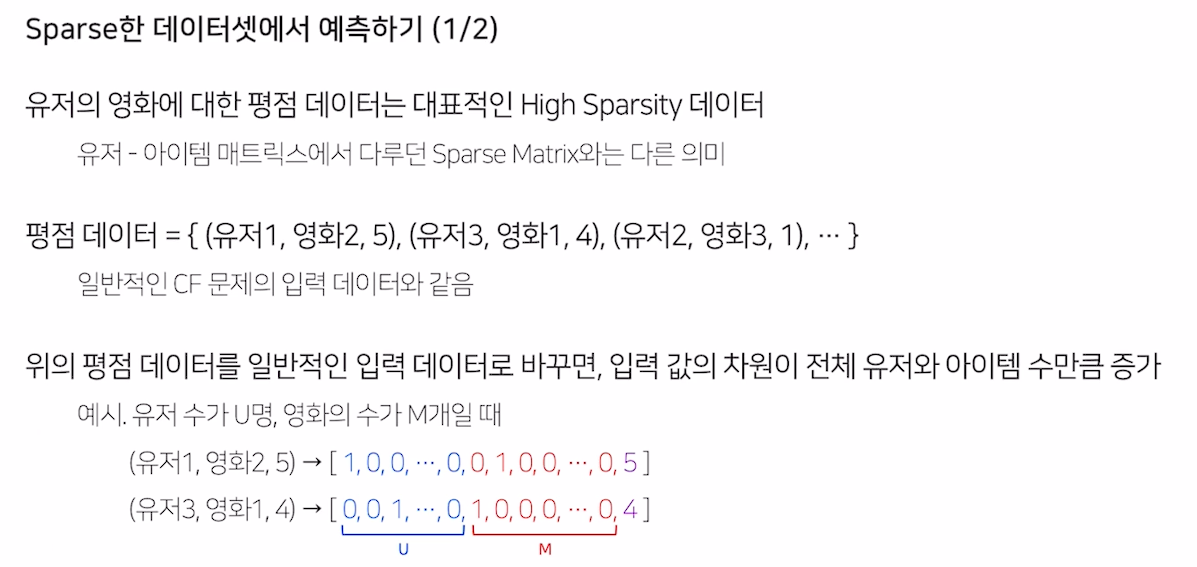

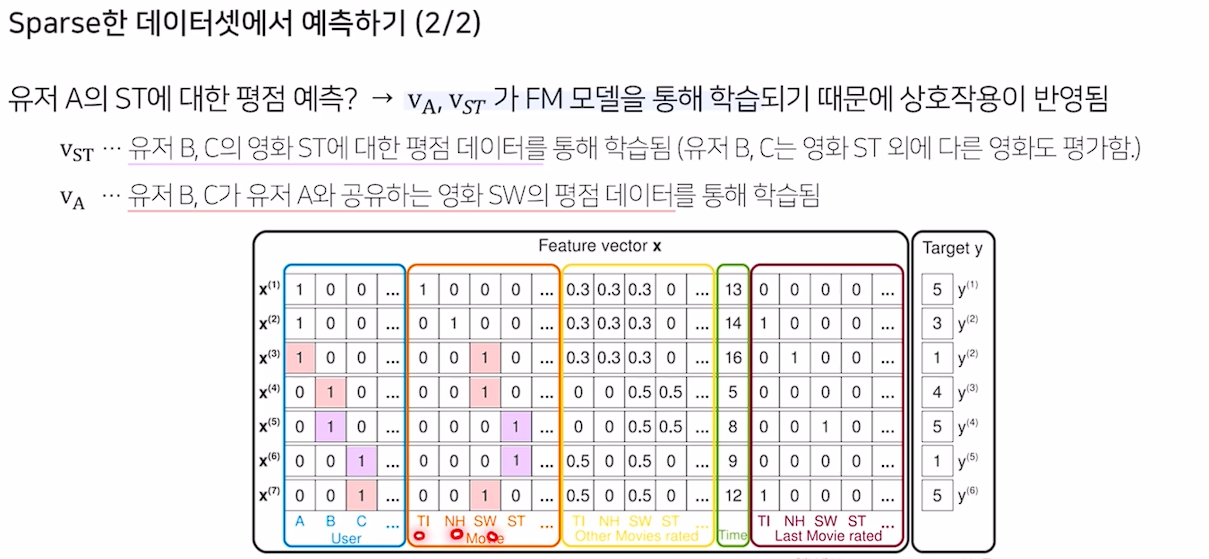

데이터 준비

- 입력 값의 차원이 전체 유저와 아이템 수 만큼 증가

장점

-

SVM에 비해 Sparse한 데이터에 비해 높은 예측 성능

-

선형 복잡도를 가져 수십 억 개의 학습 데이터에 대해서도 빠르게 학습

-

MF에 비해 여러 예측 문제에 모두 활용 가능

-

다른 부가 정보를 모델의 피쳐로 사용할 수 있음

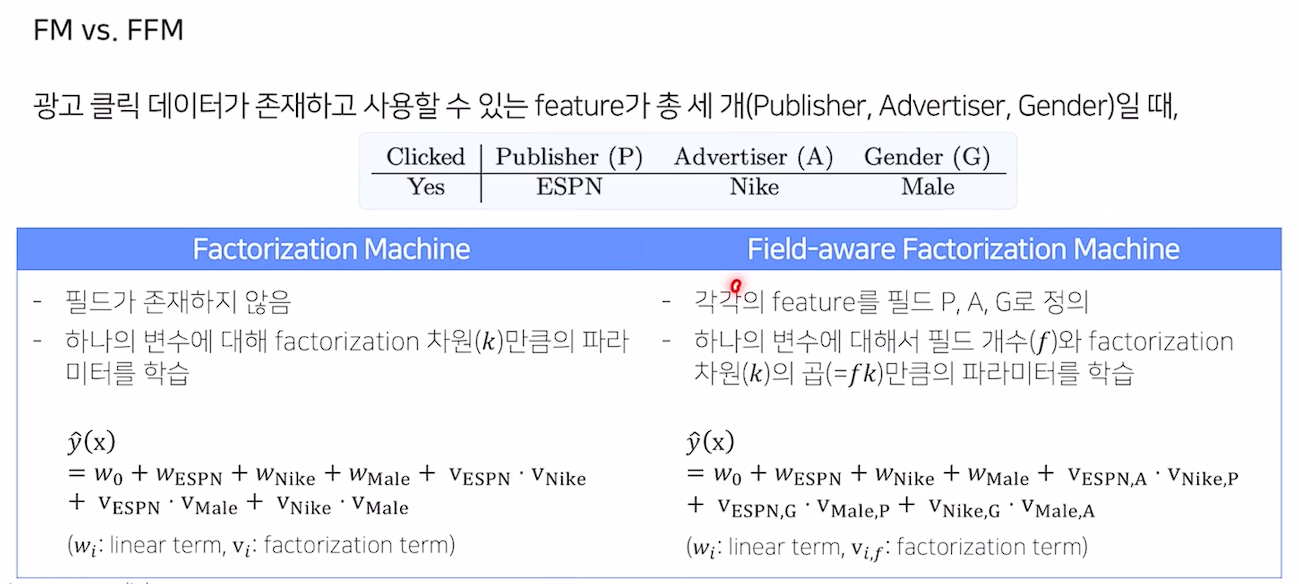

Field-aware Factorization Machine

- FM을 변형시킨 FFM

- Pairwise Interaction Tensor Factorization에서 아이디어를 얻은 논문

- PITF에서는 3차원으로 MF를 확장시킨 모델

- user,item,tag embedding을 각각 구해 latent factor를 정의하여 구함

- FFM은 이 field를 여러개로 늘린 것

특징

- 변수를 필드로 나누어, 필드 별로 서로 다른 latent factor를 가지도록 함

- 필드는 사용자가 정의하며, 같은 의미를 갖는 변수들의 집합으로 설정

수식

- field 별로 factorization 파라미터를 같이 곱해줌

필드 구성

- 수치형인 경우에는 dummy field, 즉 feature 한 개당 하나의 field를 배정하거나

- 실수 feature를 n개의 구간으로 나누어 이진 값을 사용하여 n개의 변수를 하나의 필드로 할당

Gradient Boosting Machine

- GBM을 통한 CTR 예측

Boosting

- 앙상블 기법의 일종

- 의사 결정 나무로 된 weak learner를 연속적으로 학습

- 연속적이란 이전 단계의 weak learner가 취약했던 부분을 위주로 데이터를 샘플링하거나 가중치를 부여해 다음 단계의 learner를 학습한다는 의미

- AdaBoost, GBM, XGBoost, LightGBM 등..

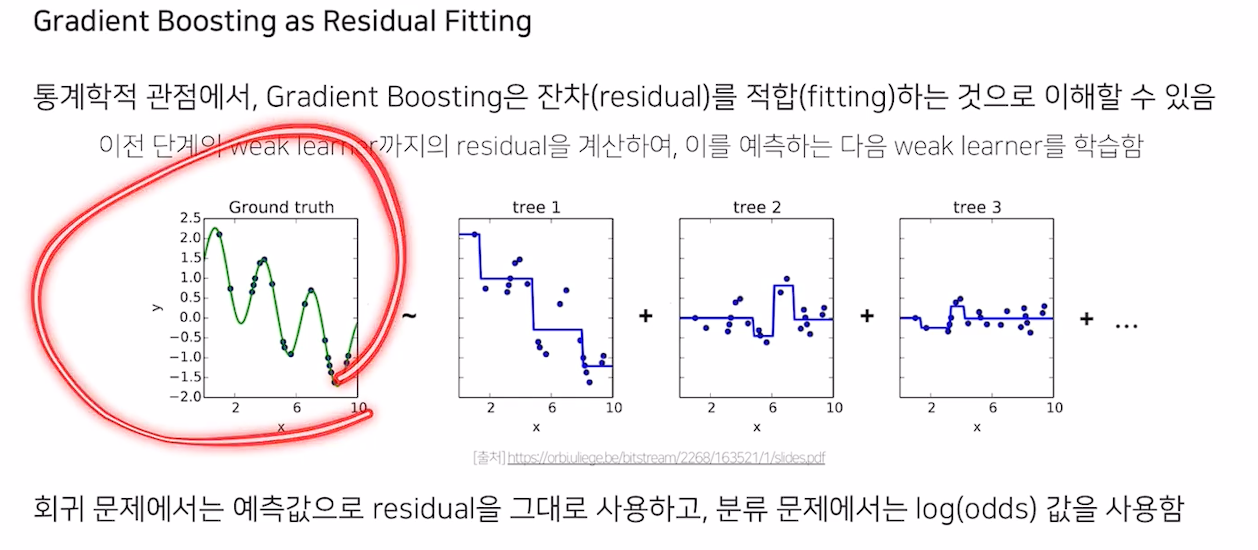

GBM

- gradient descent를 사용하여 loss function이 줄어드는 방향으로 weak learner를 반복적으로 결합함으로써 성능을 향상시킴

- 통계학적 관점에서 잔차를 적합하는 것으로 이해할 수 있음

장점

- Random forest 보다 나은 성능

단점

- 느린 학습 속도

- 과적합