CV Metrics

Classification Metrics:

- Accuracy

- Precision / Recall

- Sensitivity / Specificity

- F1 score

- AUC-ROC

Detection Metrics:

- IoU

- Precision / Recall

- AP

- mAP

Segmentation Metrics :

- PA

- MPA

- IoU

- Dice coefficient

Classification Metrics

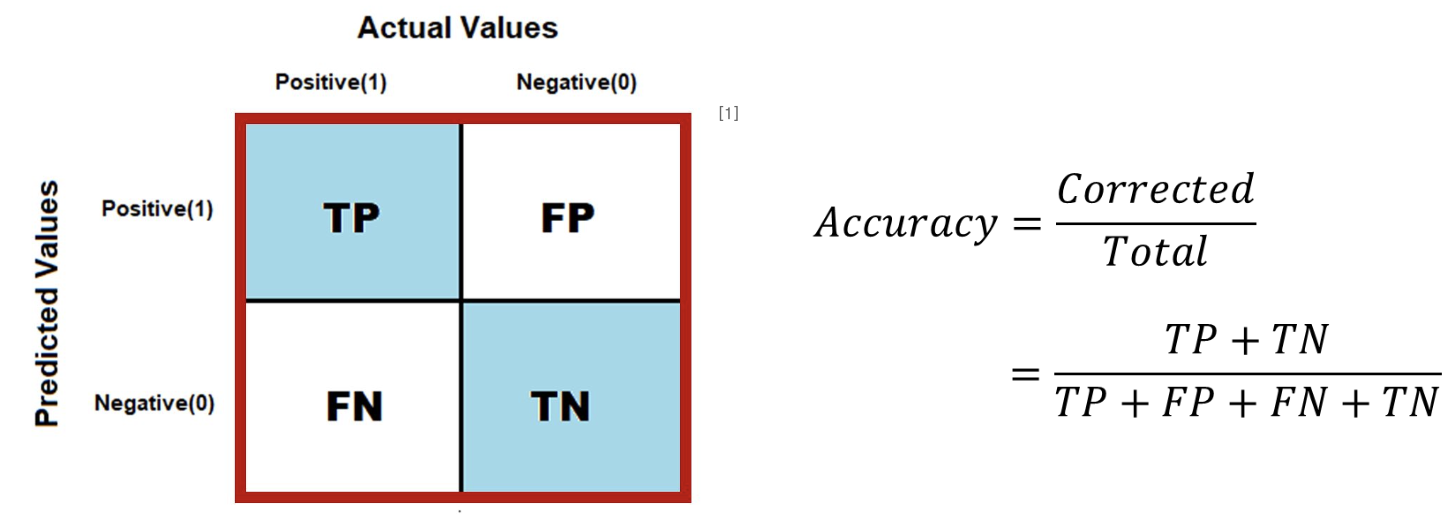

Accuracy

전체 데이터에 대한 올바르게 예측된 데이터의 비율(정확도)

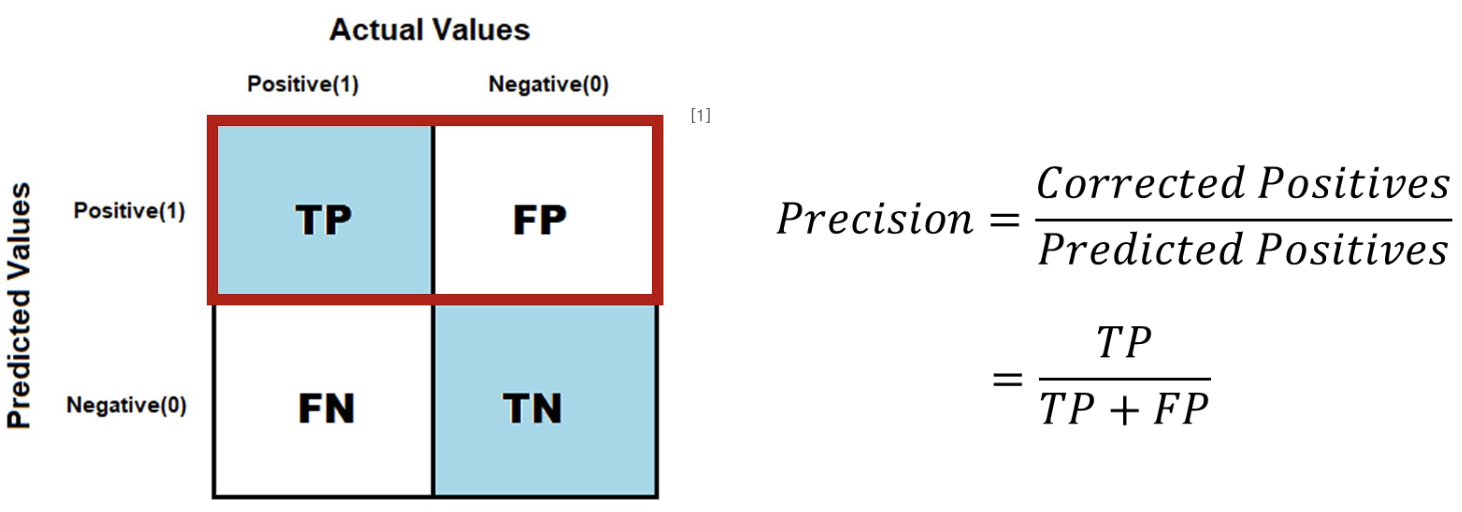

Precision

모델이 positive로 예측한 데이터 중에서 실제 Positive인 데이터의 비율

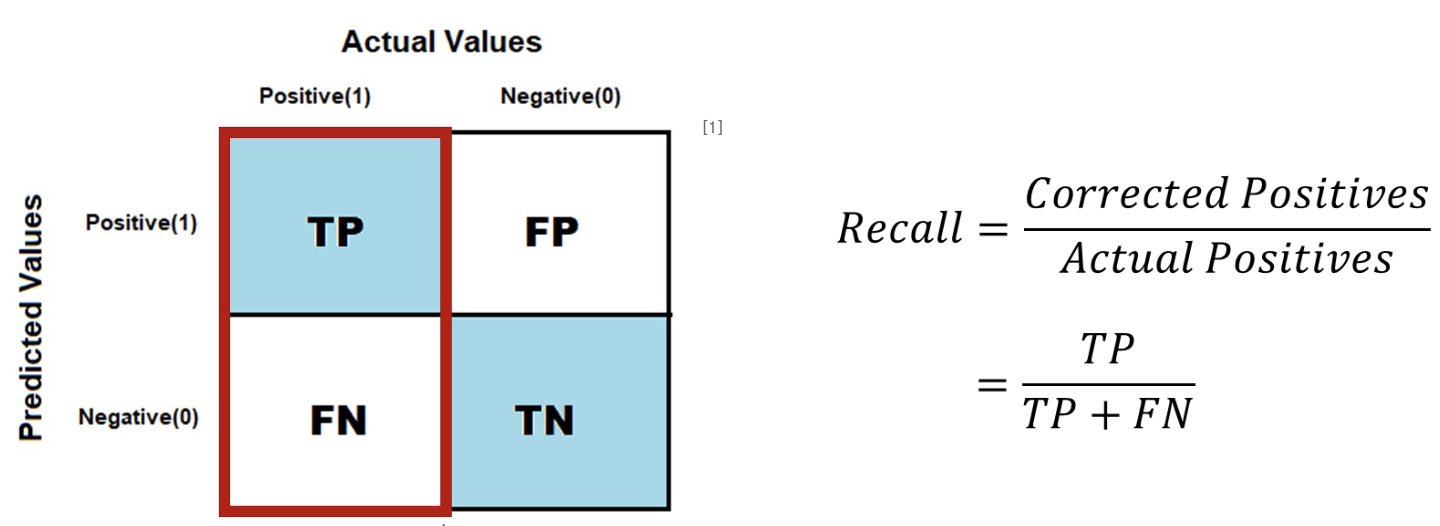

Recall = Sensitivity

실제 Positive인 데이터 중에서 모델이 Positive라고 예측한 데이터의 비율 (재현율 = 민감도)

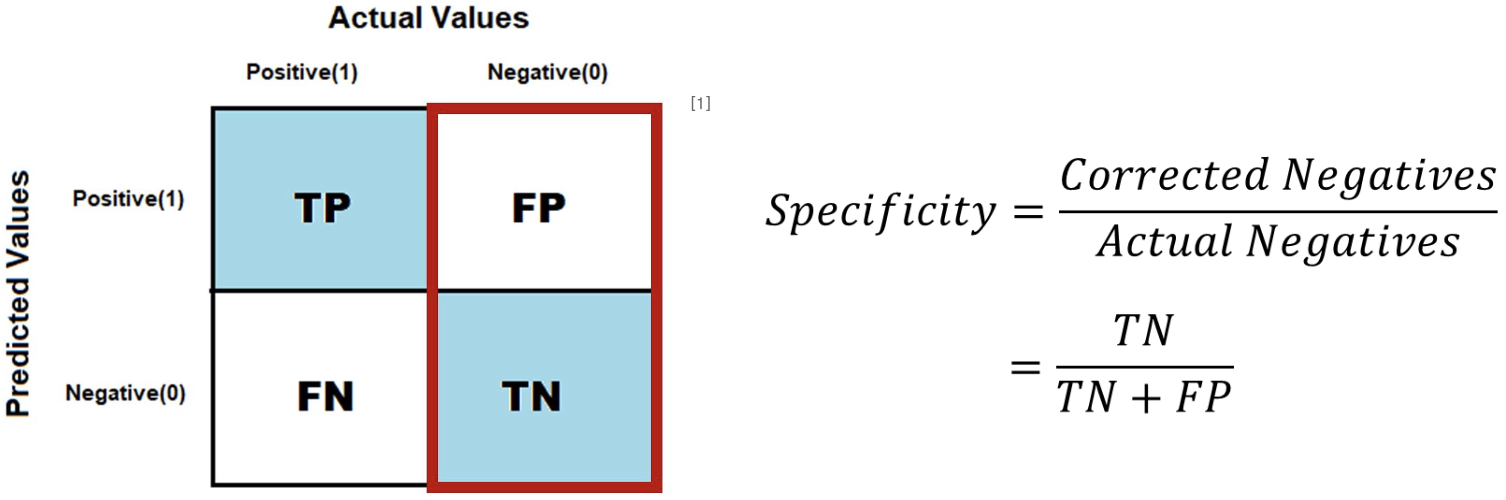

Specificity

실제 negative인 데이터 중에서 모델이 negative로 예측한 데이터의 비율

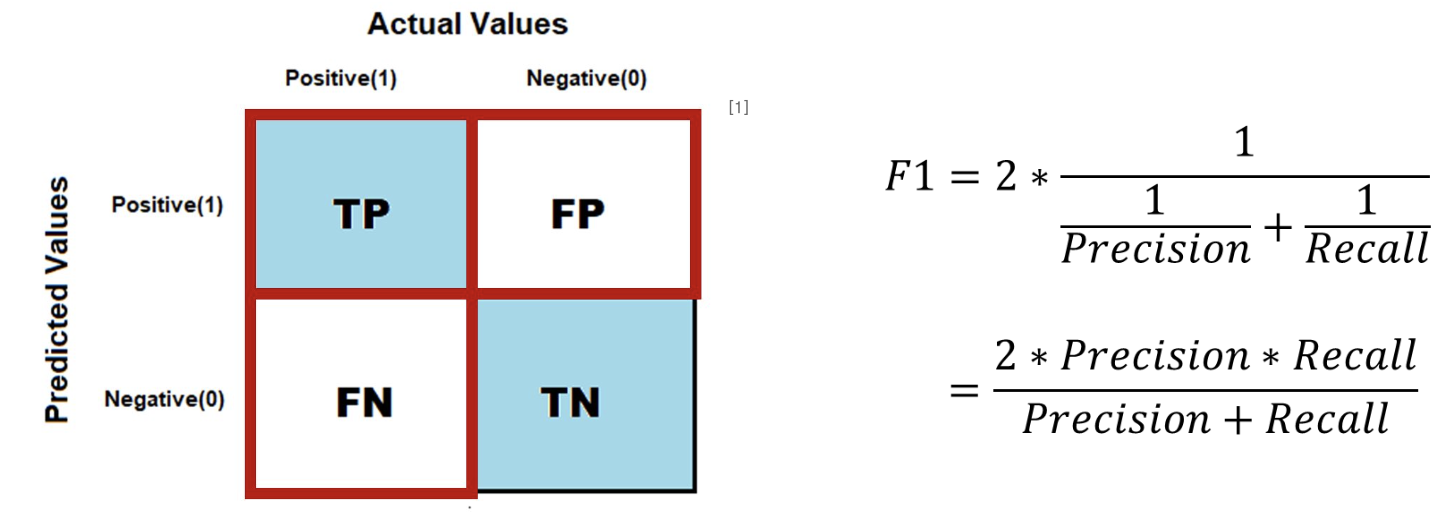

F1 Score

Precision과 recall의 조화평균

- 데이터가 imbalance할 경우 더 정확한 metric

모델이 소수 클래스를 무시하고 다수 클래스에만 좋은 성능을 보이는 경우 F1 스코어가 낮아짐.

즉, F1 스코어는 모델이 소수 클래스를 얼마나 잘 예측하는지(재현율)와 그 예측이 얼마나 정확한지(정밀도)를 동시에 고려하여, 불균형 데이터에 대한 보다 균형 잡힌 성능 평가를 제공

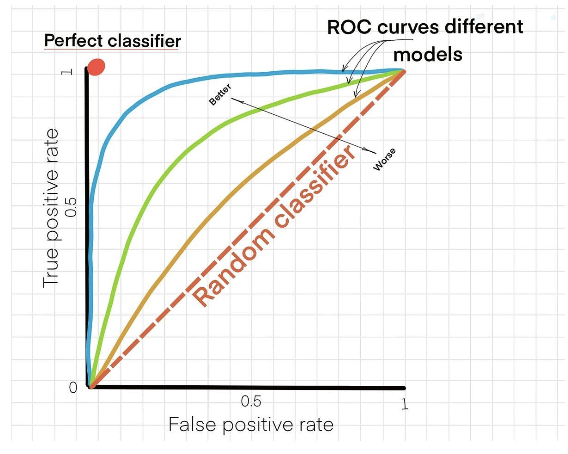

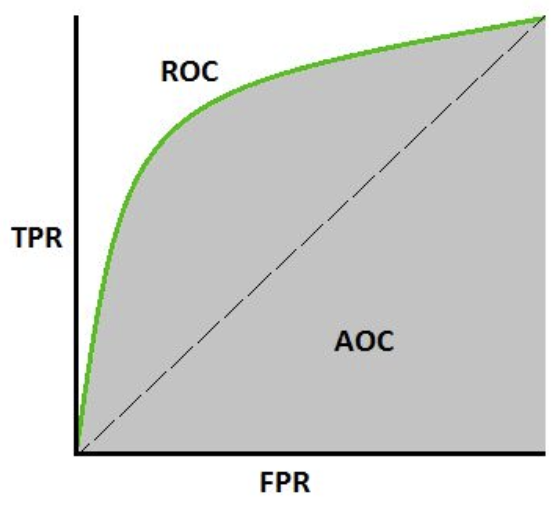

ROC Curve

- TPR (True Positive Rate): 실제 True 중에서 Positive로 예측한 비율

- FPR (False Positive Rate): 실제 False 중에서 Positive로 예측한 비율

(Receiver Operating Characteristic)

다양한 threshold에서의 성능을 한 눈에 볼 수 있도록 시각화 한 측정 그래프

- FPR과 TPR을 각각 x,y축으로 가지는 그래프

- Threshold를 연속적으로 바꾸면서 측정했을 때 TPR과 FPR의 변화를 나타낸 것으로, (0,0)과 (1,1)를 잇는 곡선

- 좌상단에 치우칠수록 높은 성능

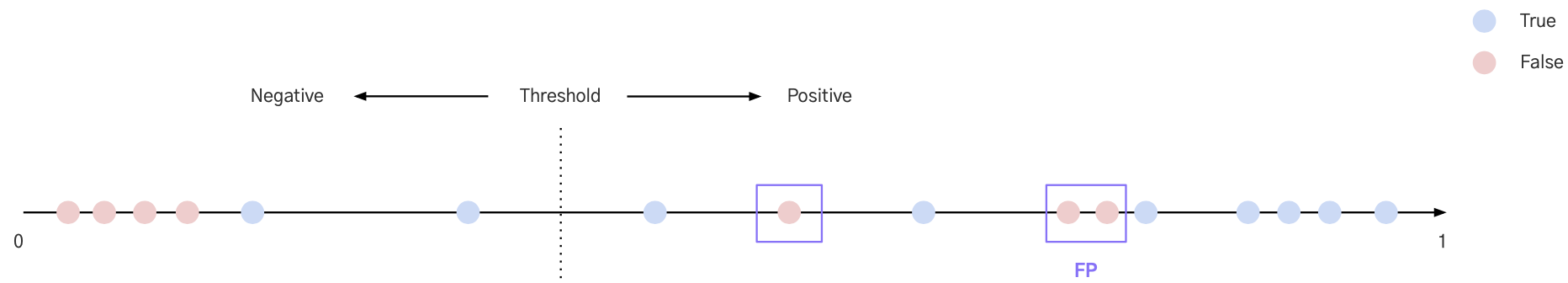

Threshold는 기준값이나 임계값을 의미합니다. 머신러닝과 딥러닝, 특히 분류 문제에서 널리 사용되는 개념으로, 모델이 예측한 확률값을 특정 클래스에 할당하기 위한 기준점으로 활용

AUC

(Area Under the ROC Curve)

ROC curve에서 곡선 아래의 면적

- 성능 평가에 있어서 수치적인 기준이 될 수 있는 값

-1에 가까울수록 그래프가 좌상단에 근접하므로 좋은 성능

Object Detection Metrics

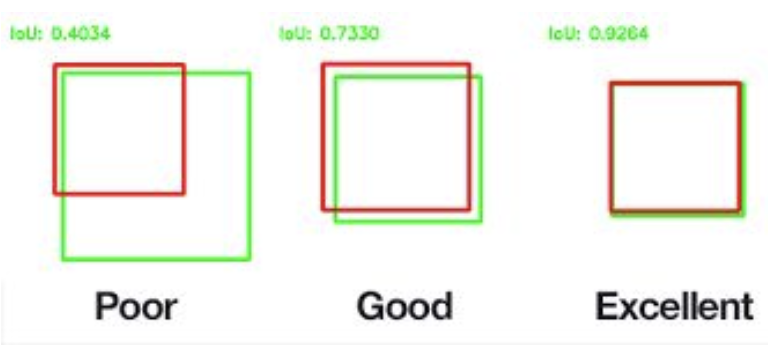

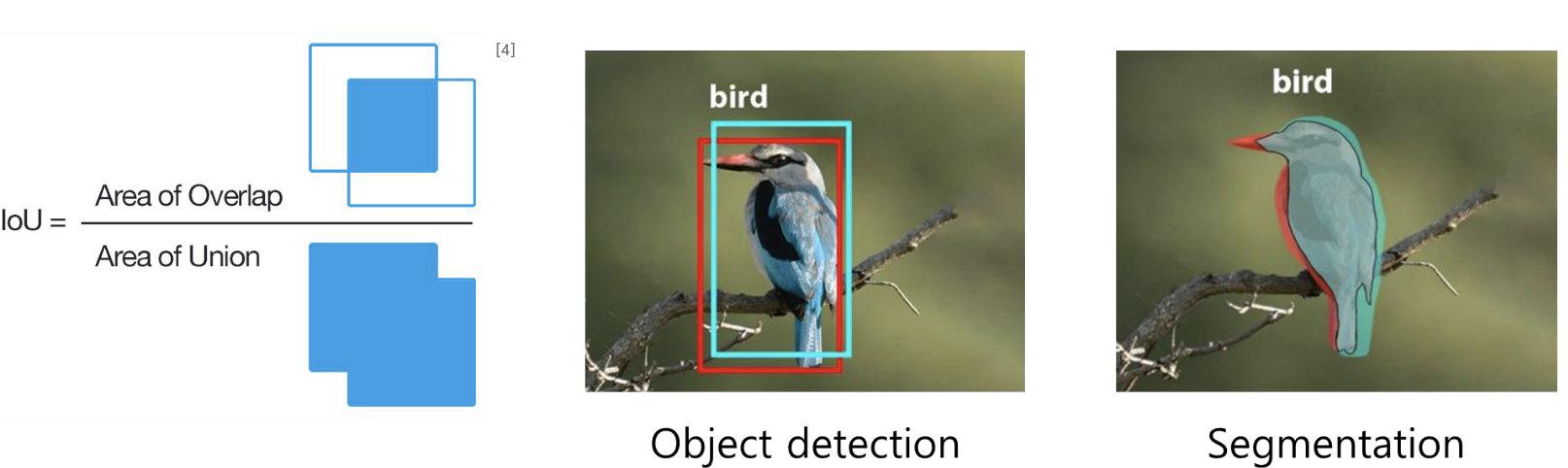

IoU

(Intersection over Union)

Bounding box의 겹치는 영역의 크기를 통해 정확도를 평가하는 방법

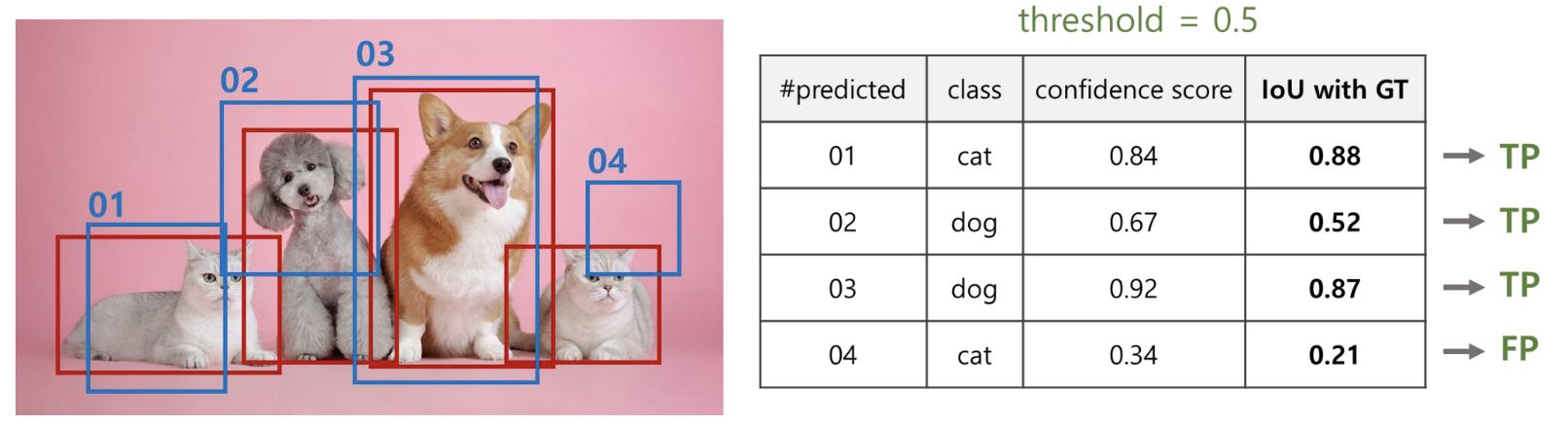

TP & FP

Object detection에서는 IoU 값을 기준으로 TP와 FP 분류

- 특정 threshold를 기준으로, IoU ≥ threshold일 경우 예측이 맞았다고(True Positive) 구분

- 특정 threshold를 기준으로, IoU < threshold일 경우 예측이 틀렸다고(False Positive) 구분

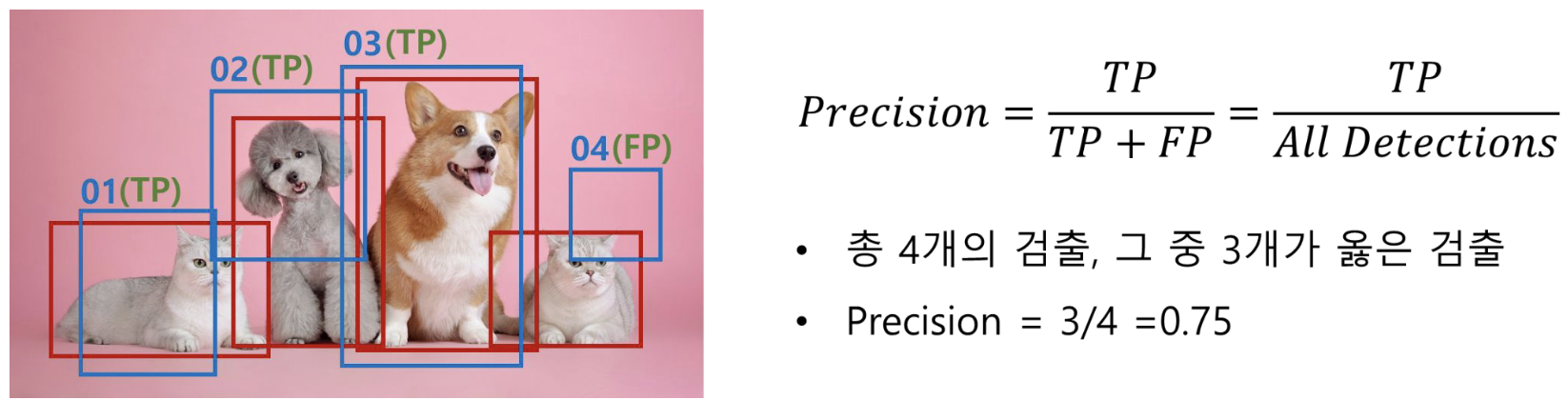

Precision

(정밀도)

IoU를 기준으로 구분한 TP를 통해 precision 계산

Recall

(재현율)

IoU를 기준으로 구분한 TP를 통해 recall 계산

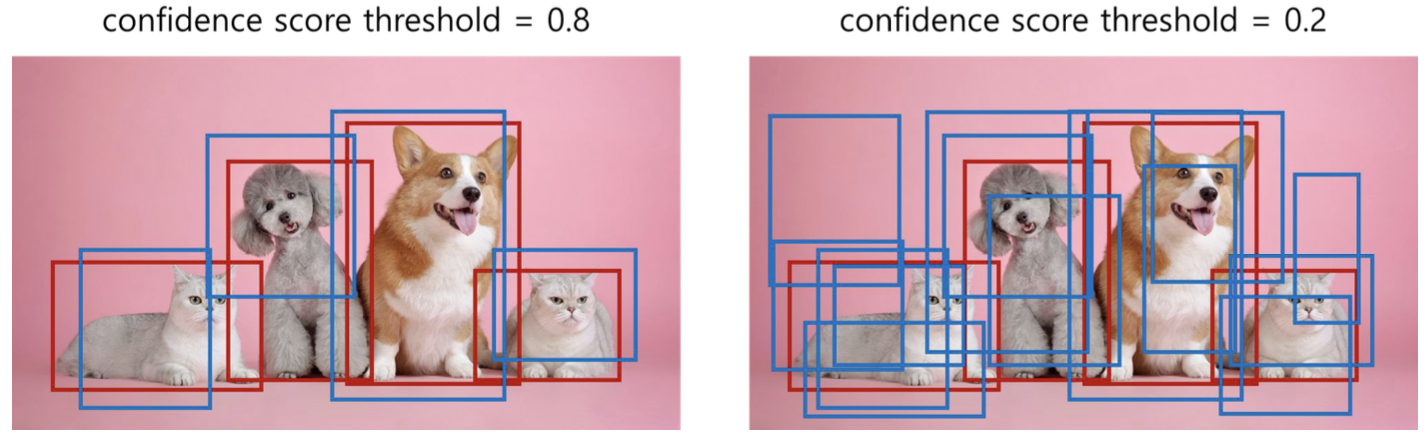

Precision Recall Trade-off

Confidence score의 threshold에 따라서도 precision과 recall 달라짐

- Threshold 높을수록 → bbox 수 적어짐 → Recall ↓, Precision ↑

- Threshold 낮을수록 → bbox 수 많아짐 → Recall ↑, Precision ↓

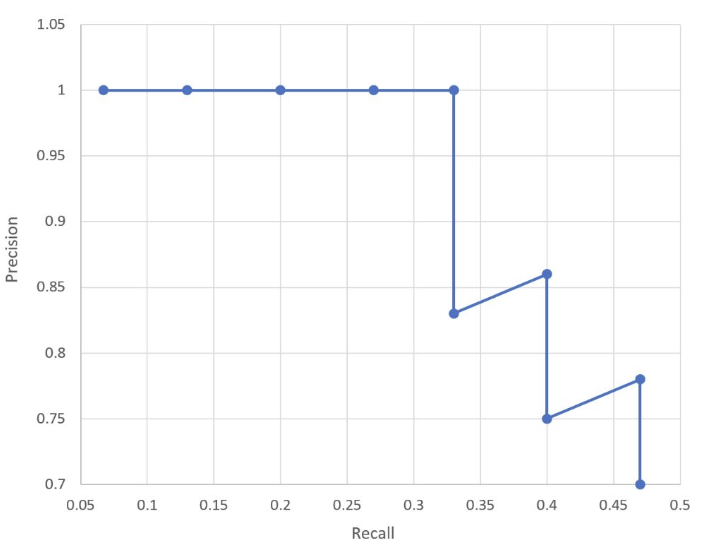

PR Curve

Confidence score threshold의 변화에 따른 precision과 recall 값을 그린 그래프

-Recall, precision 각각을 x, y축으로 가지는 그래프

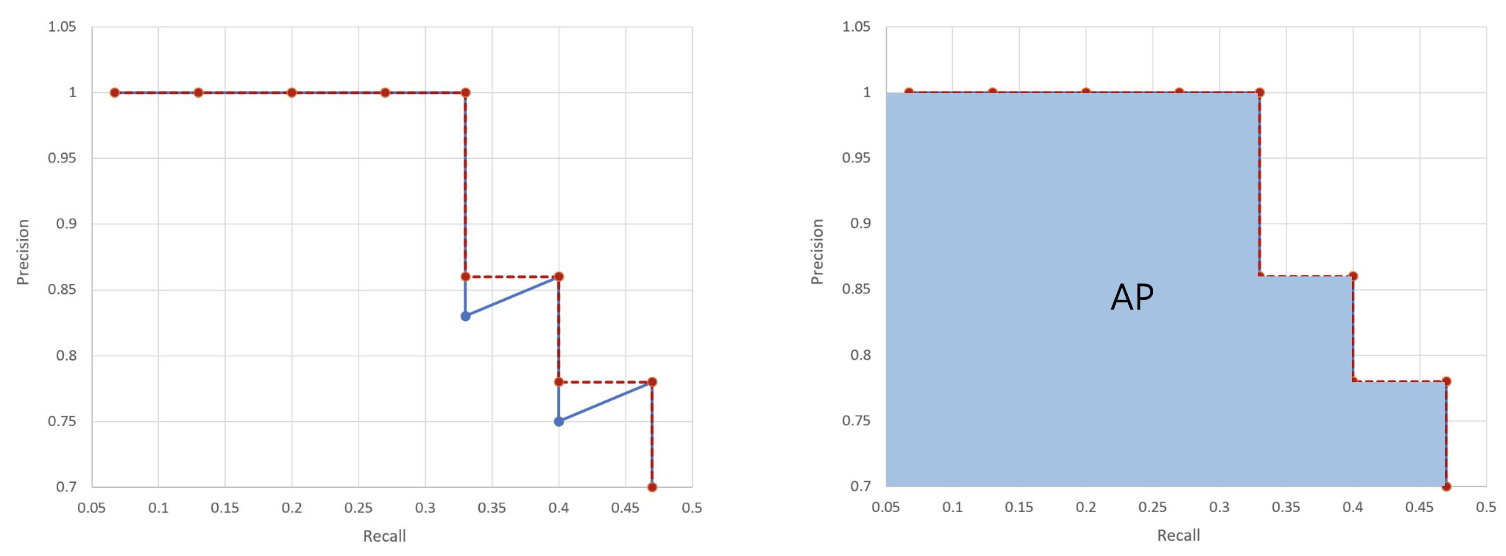

AP

PR 그래프를 통해 모델의 성능을 정량적으로 평가하고자 하는 방법

- 그래프 곡선 아래쪽의 면적

mAP

(Mean Average Precision)

모든 class에 대한 AP의 평균

Segmentation Metrics

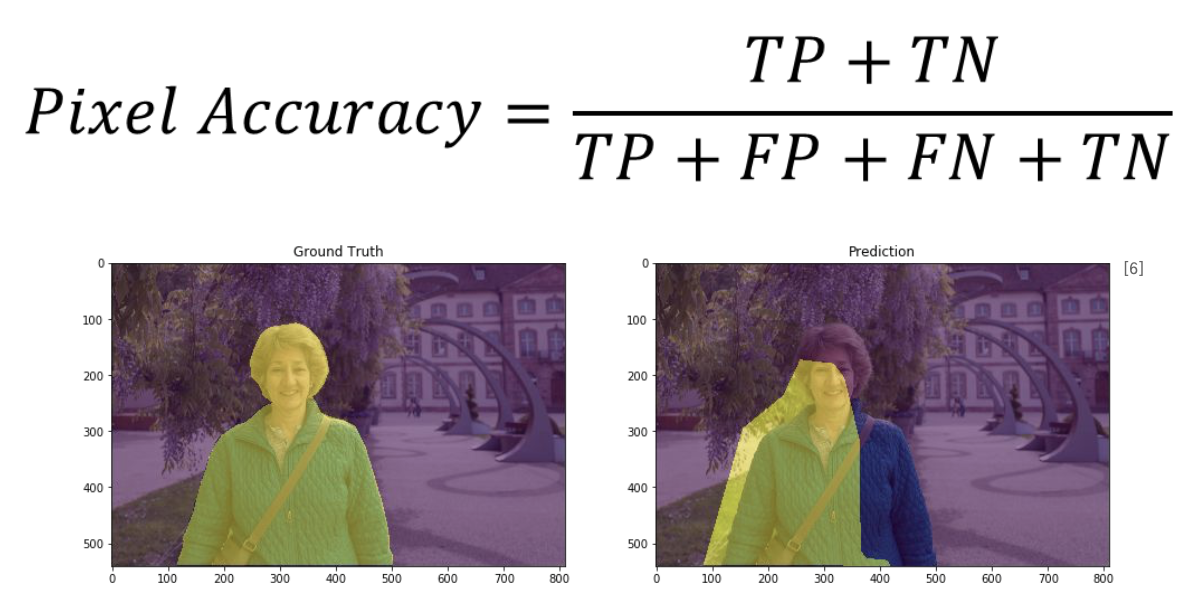

PA

(Pixel Accuracy)

모든 pixel에 대해 class를 올바르게 예측한 pixel의 비율

MPA

(Mean Pixel Accuracy)

모든 class에 대한 PA의 평균

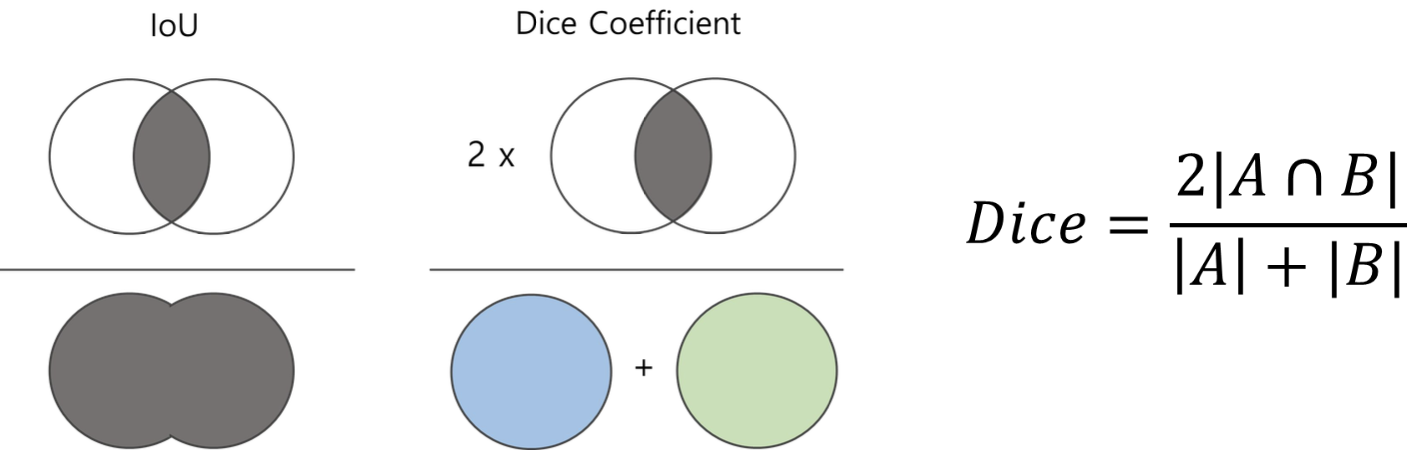

IoU

Object detection의 IoU와 계산 방법은 동일하지만, pixel 단위의 mask로 계산

Dice Coefficient

IoU와 유사하지만, 두 영역(합집합, 교집합)의 조화평균을 사용하여 계산하는 방법

- 데이터가 imbalance할 경우 더 정확한 metric