분류성능평가지표

기계학습에서 모델이나 패턴의 분류 성능 평가에 사용되는 지표

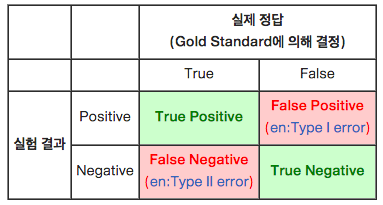

모델의 분류와 정답

모델을 평가하는 요소는 모델이 내놓은 답과 실제 정답의 관계임

4가지 Case

True Positive(TP) : 실제 True인 정답을 True라고 예측 (정답)

False Positive(FP) : 실제 False인 정답을 True라고 예측 (오답)

False Negative(FN) : 실제 True인 정답을 False라고 예측 (오답)

True Negative(TN) : 실제 False인 정답을 False라고 예측 (정답)

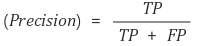

Precision(정밀도)

모델이 True라고 분류한 것 중 실제 True인 것의 비율

Positive 정답률, PPV(Positive Predictive Value)라고도 함

ex) 정보 검색 분야

정밀도(precision) : 검색된 문서들 중 관련 있는 문서들의 비율

ex) 날씨 예측 모델이 맑다로 예측했는데, 실제 날씨가 맑았는지를 살펴보는 지표

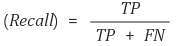

Recall(재현율)

실제 True인 것 중에서 모델이 True라고 예측한 것의 비율

통계학에서는 sensitivity으로, 다른 분야에서는 hit rate라는 용어로도 사용함

ex) 정보 검색 분야

재현율(recall) : 관련 있는 문서들 중 실제로 검색된 문서들의 비율

ex) 실제 날씨가 맑은 날 중에서 모델이 맑다고 예측한 비율을 나타낸 지표

Precision(정밀도) & Recall(재현율)

Precision은 모델의 입장에서, 그리고 Recall은 실제 정답(data)의 입장에서 정답을 맞춘 경우를 보고 있음

"어떤 요소에 의해, 확실히 맑은 날을 예측할 수 있다면 해당하는 날에만 맑은 날이라고 예측하면 되겠다."

이 경우에는 확실하지 않은 날에는 아에 예측을 하지 않고 보류하여 FP의 경우의 수를 줄여, Precision을 극도로 끌어올리는 일종의 편법임

예를 들어 한달(30일) 동안 맑은 날이 20일이었는데, 확실한 2일만 맑다고 예측한다면, 당연히 맑다고 한 날 중에 실제 맑은 날(Precision)은 100%가 나오게 되므로 적절하지 않음

실제 맑은 20일 중에서 예측한 맑은 날의 수도 고려해 보아야함

이 경우에는 Precision만큼 높은 결과가 나오지 않음

Precision과 함께 Recall을 함께 고려하면 실제 맑은 날들(실제 정답 data)의 입장에서 우리의 모델이 맑다고 예측한 비율을 함께 고려하게 되어 제대로 평가할 수 있음

- Precision과 Recall은 상호보완적으로 사용할 수 있음

- 두 지표가 모두 높을 수록 좋은 모델임

F1 score

Precision과 Recall의 조화평균

F1 score는 데이터 label이 불균형 구조일 때, 모델의 성능을 정확하게 평가할 수 있으며, 성능을 하나의 숫자로 표현할 수 있음