multi-modal representation

1.[NeurIPS 2022] Mind the Gap: Understanding the Modality Gap in Multi-modal Contrastive Representation Learning

https://arxiv.org/abs/2203.02053해당 논문은 제목에서 보시는 것 처럼 Multi-modal Contrastive Representation Learning에서 Modality Gap을 발견한 첫번째 논문입니다.Modality Gap이란

2024년 5월 27일

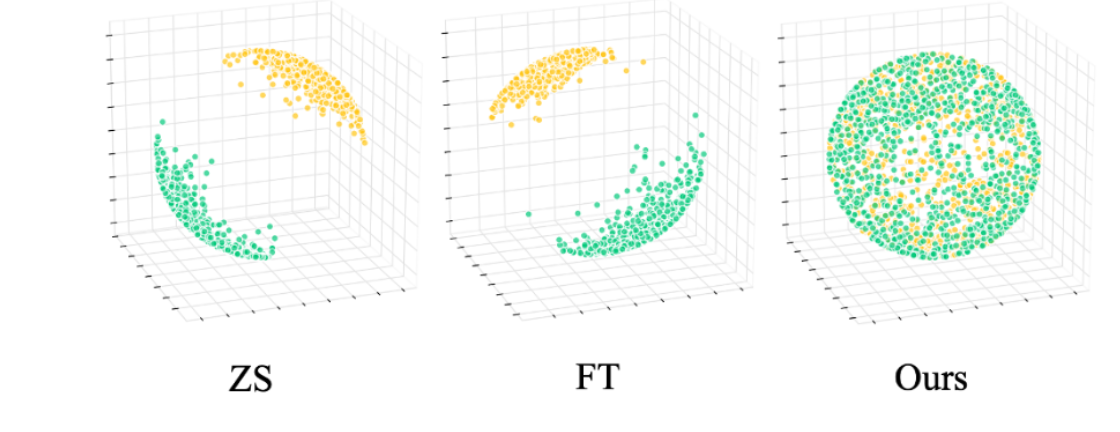

2.[NeurIPS 2023] Geodesic Multi-Modal Mixup for Robust Fine-Tuning

Geodesic Multi-Modal Mixup for Robust Fine-Tuning (2023 NeurIPS) 입니다.https://arxiv.org/abs/2203.03897본 논문에서는 CLIP(multi-modal foundation model)이

2024년 5월 23일

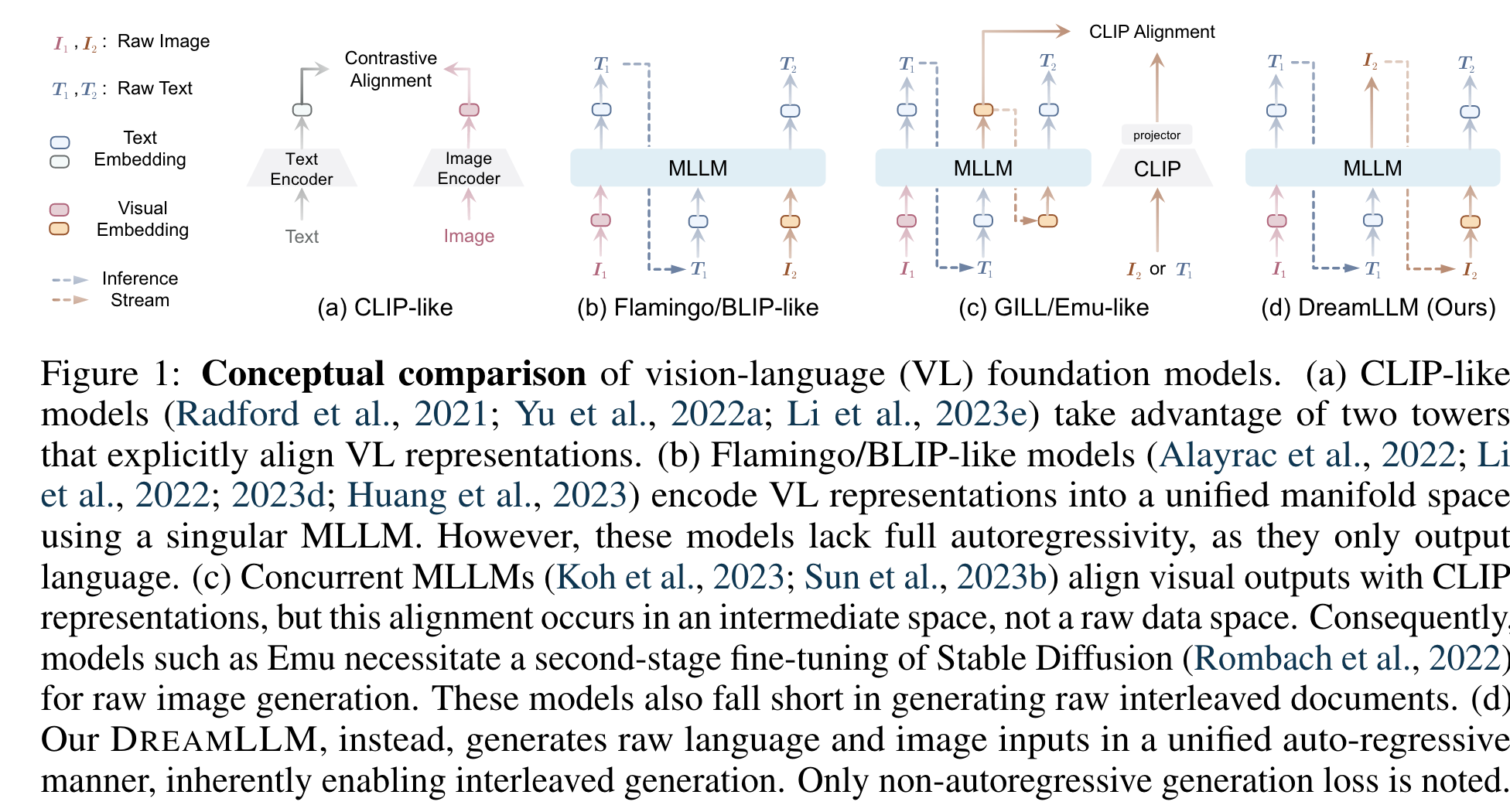

3.[ICLR 2024] DREAMLLM: SYNERGISTIC MULTIMODAL COMPREHENSION AND CREATION

DREAMLLM: SYNERGISTIC MULTIMODAL COMPREHENSION AND CREATION (ICLR 2024 Spotlight)AbstractDREAMLLM은 처음으로 다목적 MLLM(Multimodal Large Language Models)을 제안

2024년 5월 28일