1. 강의 복습 내용

- 목표 :

- 강의 수강 목표는 5강 ~ 8강까지 (Transformer 중심으로 학습)

- 기본과제 2개 풀어보기- 결과 :

- 강의 수강 목표는 5강 ~ 8강까지 (Transformer 중심으로 학습) (O)

- 기본과제 2개 풀어보기 (O)

2. 공부를 하며 고민한 내용, 고민 결과

- Transformer에서, 각 단어의 Embedding Vector는 처음에 어떻게 만들어지는가?

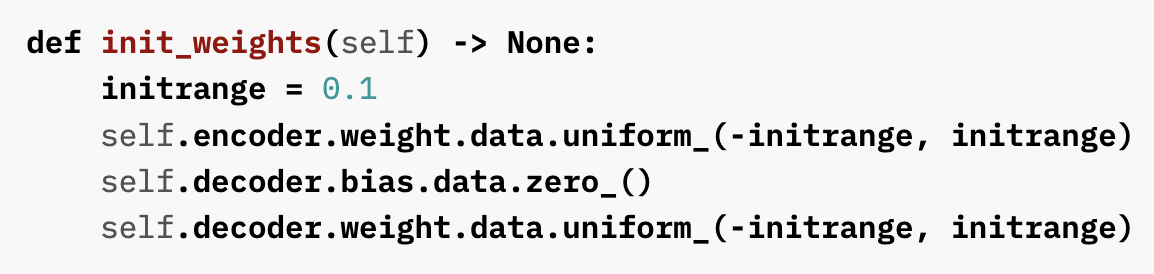

결론 : uniform distribution으로 초기화함

(참고 : https://pytorch.org/tutorials/beginner/transformer_tutorial.html)

3. 피어 세션

[데일리스크럼]

- 학습 목표 공유

- 멘토링 질문 공유 및 토의

[피어 세션]

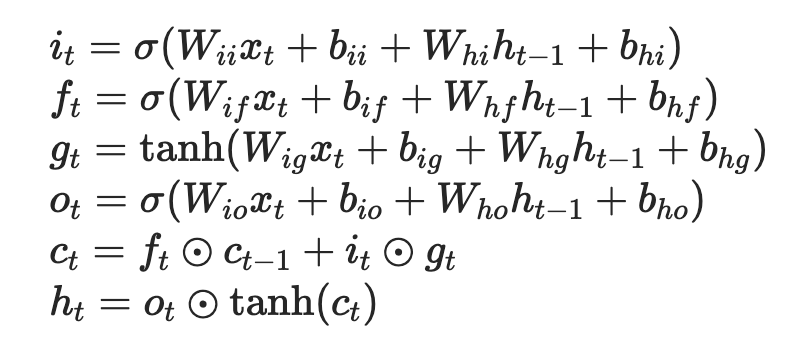

RNN과 LSTM, Attention 구조와 방식에 대한 토론

-

LSTM에서 사용되는 argument들의 의미 : https://pytorch.org/docs/stable/generated/torch.nn.LSTM.html

-

batch, sequence length, input dimension, hidden dimension 등에 대해 논의

-

LSTM의 output과 h_n, c_n은 무슨 차이가 있을까?

LSTM이 NMT에 사용된다면 어떤 식으로 사용될 수 있을까?

참고 : https://wikidocs.net/24996

4. 2nd 멘토링 (8시 ~ 9시 30분)

- 멘토님의 Q&A와 커리어

- 우선순위 : 코딩 > 수학

- ML 엔지니어 : 데이터 엔지니어의 역량 + 코딩 + 모델링

- 논문 서베이하는 법

- 논문 읽는 법

5. 회고

- 오늘의 모더레이터 : 나

- 멘토링 예습으로 예전에 읽어봤던 illustrated Transformer, Attention is all you need 논문을 다시 천천히 보며 기억을 더듬어봤음

- MNIST 데이터셋을 학습하는 PyTorch 코드를 PyTorch Lightning으로 변환하는 과제 수행해봄

- 피어세션과 멘토링 모두 시간이 지날수록 알찬 시간이 되어가는 느낌