Introduction

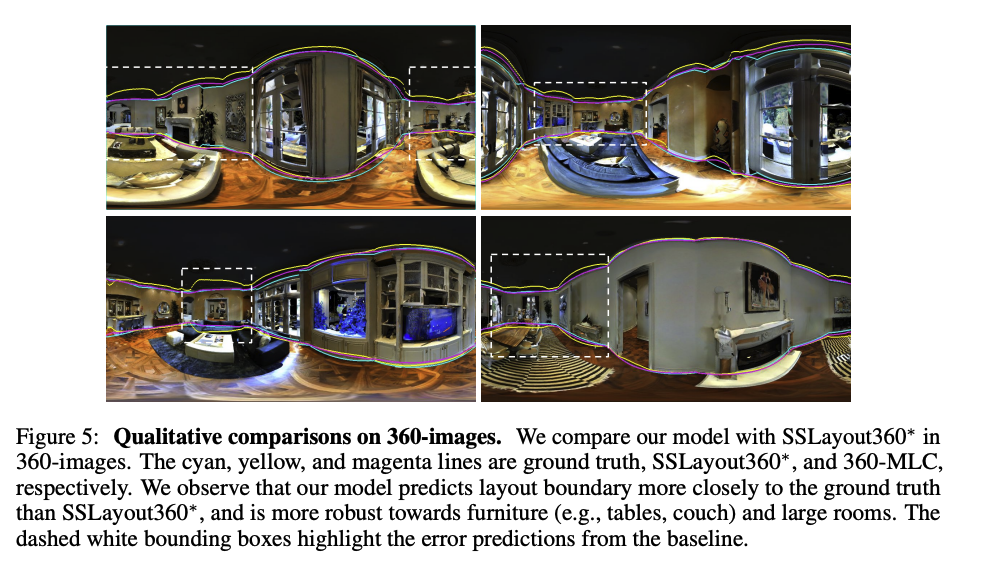

- Pre-trained model은 novel view position, different lighting conditions, severe object occlusion과 같은 문제들로 인해 새로운 도메인에서 예측 성능이 떨어진다.

- 이를 보완하기 위해 target domain에 대한 GT를 활용해 fine tuning을 하게 되는데 data labeling에는 큰 비용이 든다.

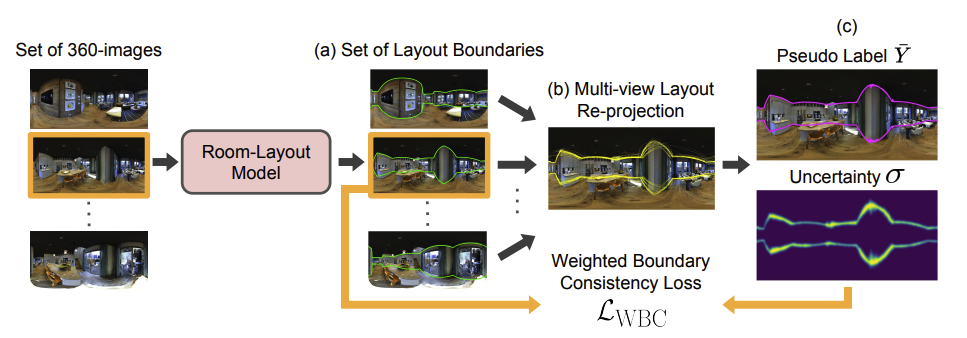

- 따라서, 저자들은 layout estimation을 self-training으로 할 수 있는 360-MLC (Multi-view Layout Consistency)를 제안한다.

- 하나의 scene에서 다양한 파노라마 이미지가 만들어질수 있음을 활용하며 camera position에 관계없이 multiple layout estimation이 consistent한 scene geometry를 정의함을 가정한다.

- Self-training을 위한 weighted boundary consistency loss와 GT label 없이 evaluation을 통해 hyper parameter를 tuning 할 수 있게 만드는 multi-view layout consistency metric을 제안한다.

Methods

Multi-view Layout Re-projection

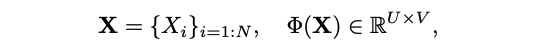

- 하나의 scene에 대해 개의 파노라마 이미지가 있으며 는 번째 이미지, 는 번째 이미지의 boundary에 대한 vector를 의미한다.

- 는 column 에서의 boundary인 row 를 의미한다.

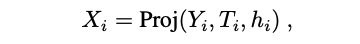

- Self-training을 위해 를 번째 target view로 보내 re-projected boundary 를 만든다.

- 는 world coordinate에서의 projected boundray, 는 카메라 높이, 은 world coordinate에 대한 camera pose를 의미한다.

- Proj()은 spherical coordinates를 3D world coordinate로 projection하는 함수이다.

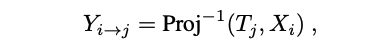

- 는 번째 target view로 reprojection 할 수 있다.

- 모든 re-projected boundaries를 로 정의하며 은 column 에 대한 개의 view로부터의 boundaries를 의미한다.

Weighted Boundary Consistency Loss

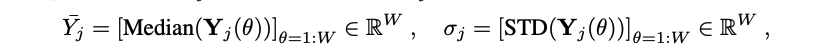

- Re-projected boundaries를 활용해 pseudo-label boundaries 와 uncertainty 를 만든다.

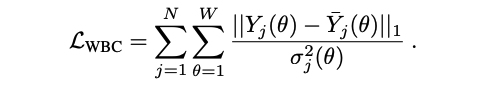

- 위와 같은 loss를 통해 uncertainty가 높은 곳에 가중치를 크게 주어 drastic occlusion이 존재하여 variance가 큰 영역에 대한 안정성을 높인다.

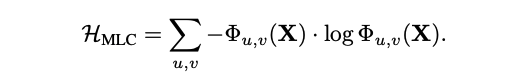

Multi-view Layout Consistency Metric

- Unlabeled data에 대한 evaluation을 할 수 있는 metric을 제안하여 hyper parameter tuning을 돕는다.

- 모든 이미지에 대한 예측된 layout set 를 를 통해 top-down view로 projection하여 크기의 discrete 2D-grid를 만든다.

- Metric의 수식은 위와 같으며 align이 잘 되어있을 때 더 작은 entropy를 가지게 된다.

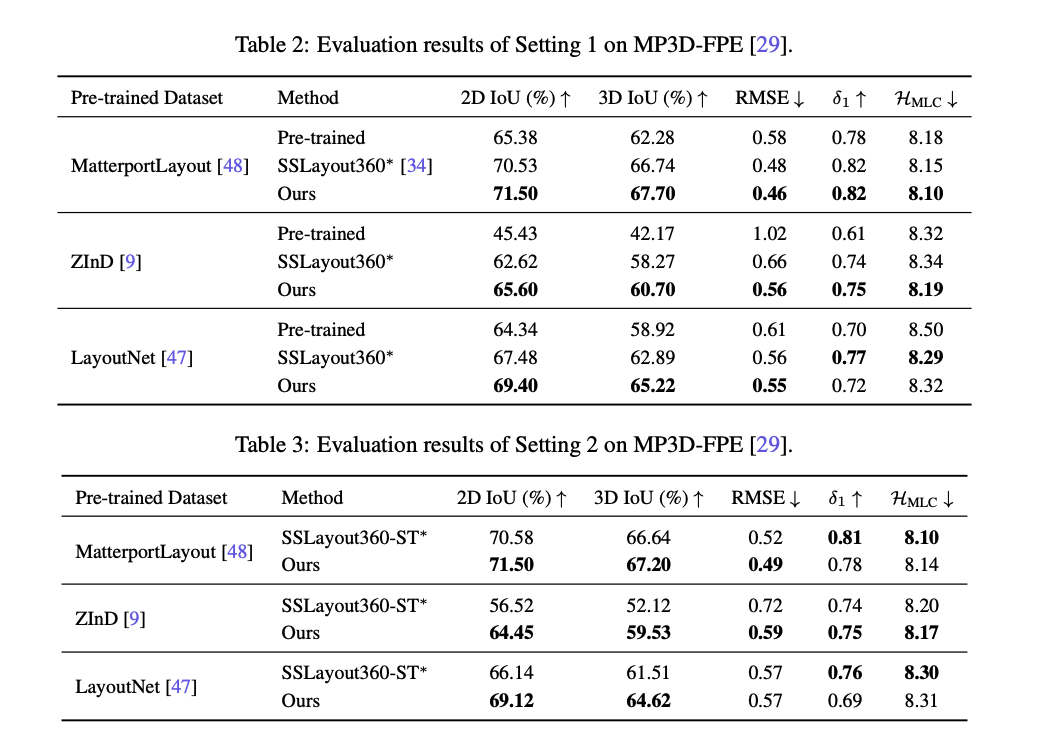

Experiments