✏️학습 정리

9. Generative Models Part 1

-

Generative model

- Generation: 단순 생성하는 모델 (implicit model)

- Density estimation: 이상 탐지, 입력이 주어졌을 때 확률값을 얻어내는 모델 (explicit model)

- Unsupervised representation learning: feature 학습

-

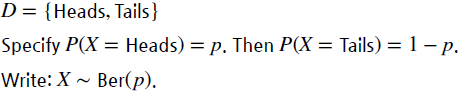

기본 Discrete Distributions

- Bernoulli distribution (코인 앞,뒤면)

- Categorical distribution (주사위)

- Bernoulli distribution (코인 앞,뒤면)

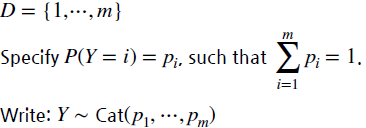

- Structure Through Independence

-

X가 전부 independent 하다고 가정

-

가능한 state

-

필요한 parameter 갯수

-

- Conditional Independence

-

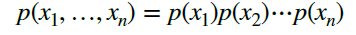

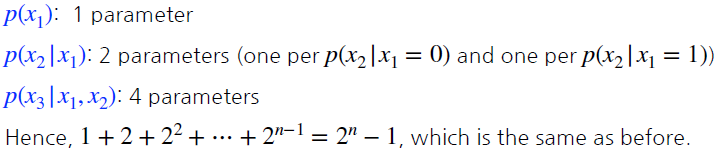

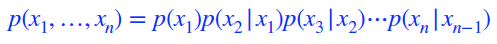

chain rule parameter 갯수

-

Markov assumption parameter 갯수

—> parameter 갯수를 기하급수적으로 줄일수 있다. (Auto-regressive model이 활용)

-

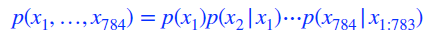

- Auto-regressive Model

-

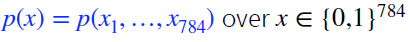

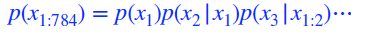

28x28 binary pixel을 가정

-

목표

-

chain rule과 markov assumption 적절히 이용

-

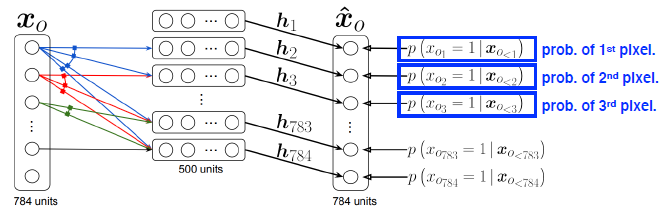

- NADE (Neural Autoregressive Density Estimator)

-

explicit model

-

NN의 입력차원 증가 → weight 증가

-

주어진 이미지의 density 계산

-

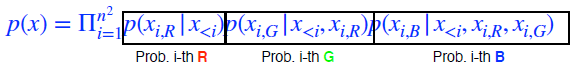

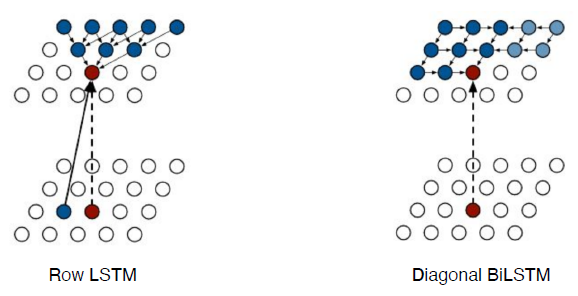

- Pixel RNN

-

RNN을 이용하여 auto-regressive model 정의 가능

-

NxN RGB 이미지

-

두 가지 model (chain의 ordering 기반)

-

10. Generative Models Part 2

- Variational Auto-encoder (VAE)

-

뒷단(decoder, 생성)부분을 학습시키려고 encoder를 붙인것

-

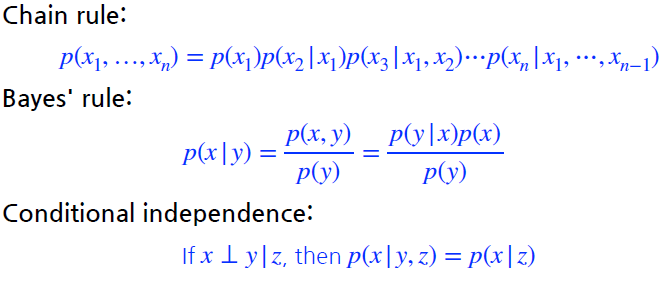

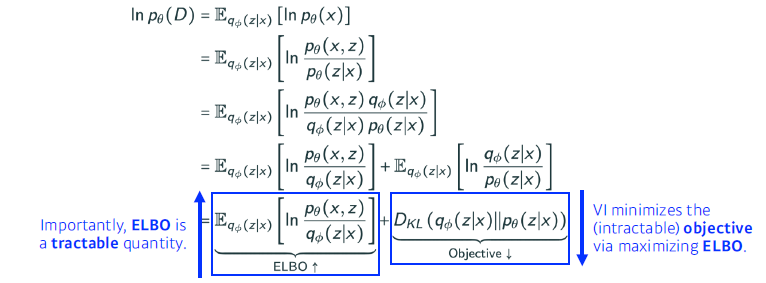

Variational inference (VI)

- posterior distribution을 찾는 것이 목적

- posterior distribution: observation이 주어졌을 때 내가 관심있어 하는 random variable의 확률분포

- variational distribution: posterior에 근사한 분포

-

어떻게?

-

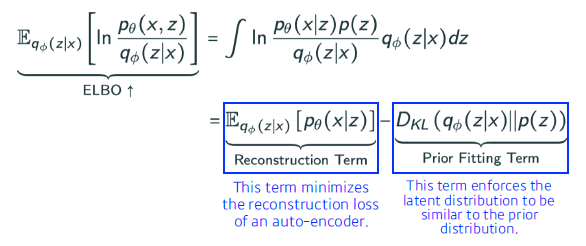

ELBO

-

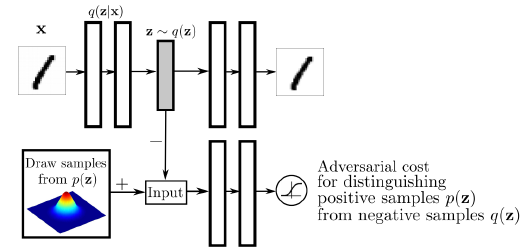

- Adversarial Auto-encoder (AAE)

-

GAN의 Discirminator 사용하여 prior 분포와 같게 만듬 (KL divergence 역할)

-

구조

-

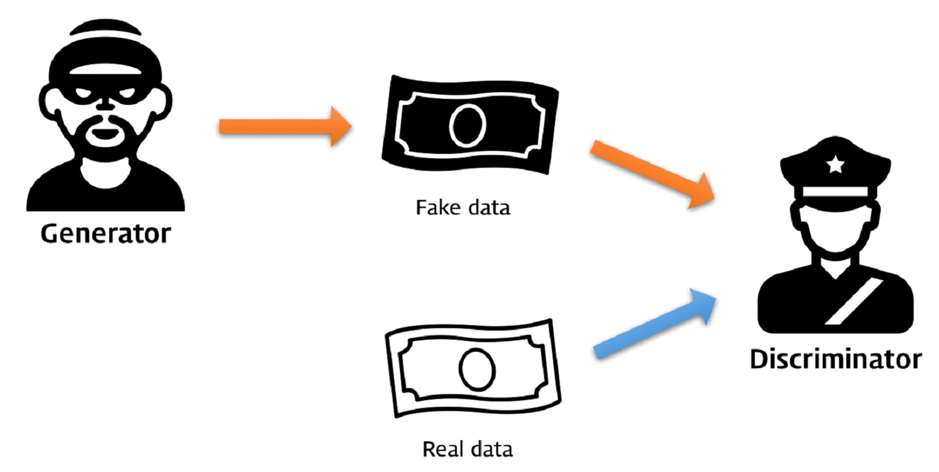

- Generative Adversarial Network (GAN)

-

implicit model

-

예시

-

목적함수

-

다양한 GAN

-

DCGAN

-

Info-GAN (class를 줘서 학습을 집중시킨다.)

-

Text2Image

-

Puzzle-GAN (GAN 구조 두개)

-

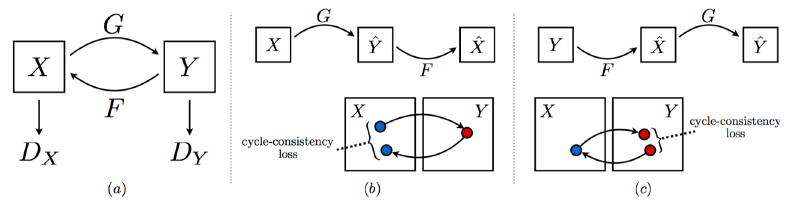

CycleGAN

-

Star-GAN

-

Progressive-GAN (해상도가 낮은 이미지부터 만들어 결국 고해상도 이미지 생성)

-

-