[CS330] L1: Start of multi-task learning

Why Multi-Task Learning?

-

데이터 셋이 적은 task의 경우 학습이 힘들다. [의료, 로봇 등 분야]

-

여러 task 하나 하나 밑바닥부터 모두 학습하는 것은 비효율적이다. [하나를 학습한 후 이를 공유하면 어떨까?]

-

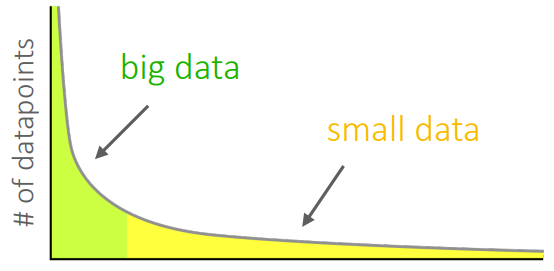

데이터가 Long-tail 형태를 띄고 있다면 학습이 힘들다. [데이터에 자주 등장한 것을 많이 보게 됨]

NLP의 경우 불용어(the, a 등)

- 이전 지식을 활용해 새로운 것을 빠르게 배울 수 있다면 효율적일 것이다. [few-shot learning]

Multi-Task & Meta Learning

Task: Dataset 에서 손실 함수(loss function) 을 최소화하는 model 를 학습하는 것.

Multi-Task Learning: 일련의 task들을 독립적으로 학습하는 것보다 더 빠르고 효과적으로 학습하는 것. (주어진 것을 배우는 것에 힘씀)

Meta Learning: 어떤 task에 대해 학습이 된 후, 다음의 새로운 task를 보다 빠르고 효과적으로 학습하는 것. (새로운 것을 배우는 것에 힘씀)

-

Transfer Learning VS Meta Learning

-

Transfer Learning: 이미 학습한 지식을 전달하는 것에 집중

-

Meta Learning: 새로운 task에도 잘 적응(학습)하는 것에 집중

-

즉, Meta Learning은 새로운 task가 등장해도 이전 지식을 바탕으로 빠르게 학습하는 능력에 집중하는 것

-

Critical Assumption

많은 task들이 서로 공유하는 구조가 있을 것이라 가정한다.

예를 들어 병뚜껑을 여는 것과 캔을 따는 것을 보면, 우선 해당 물체를 인식하고 들어올리는 task는 공통되는(공유하는) 구조일 것임.