📌17주차 학습내용 요약

딥러닝 역사

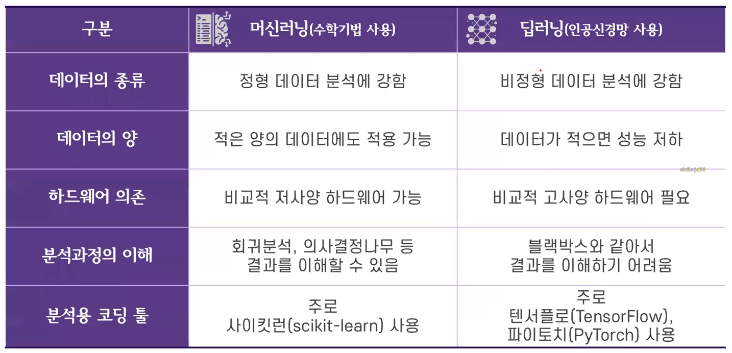

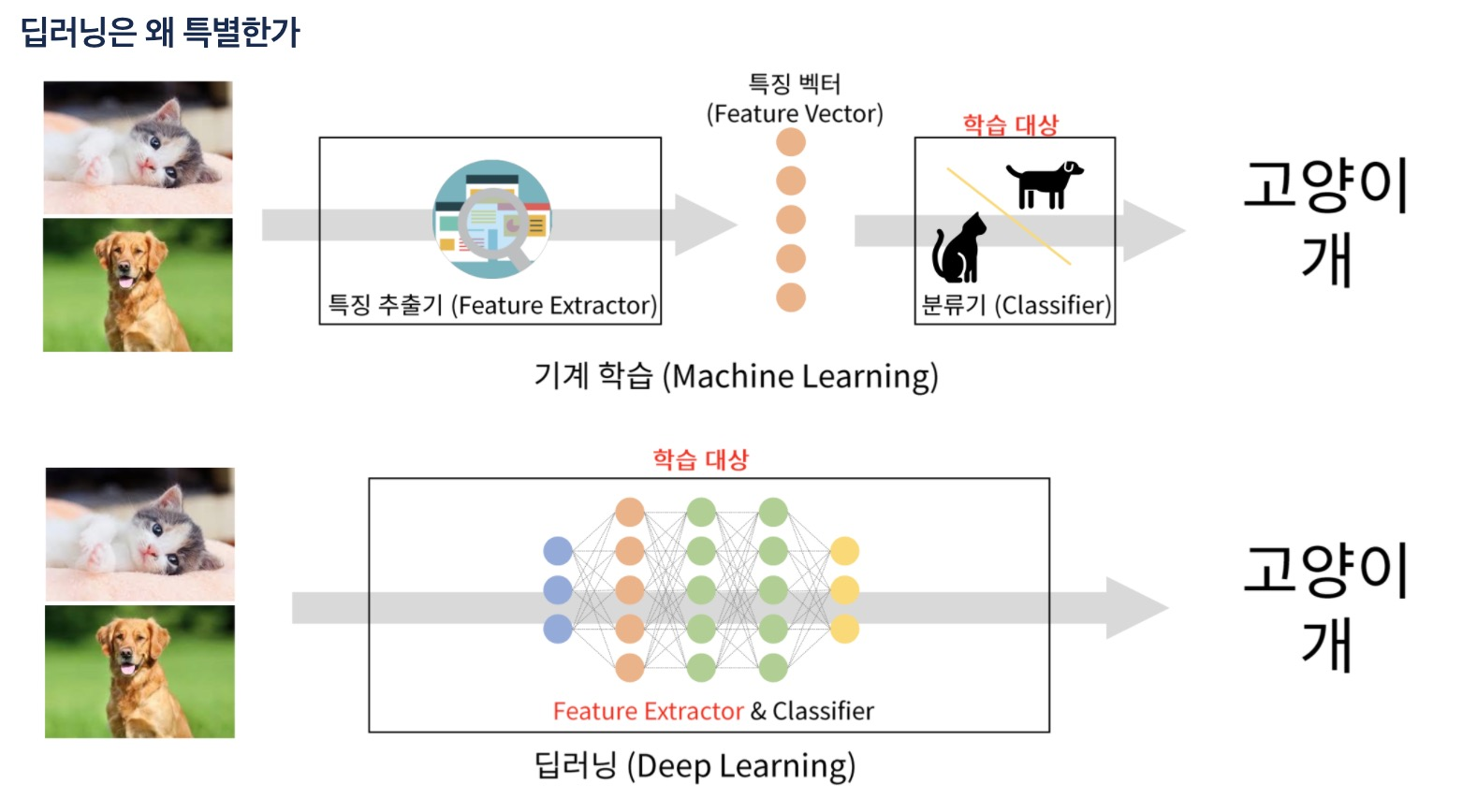

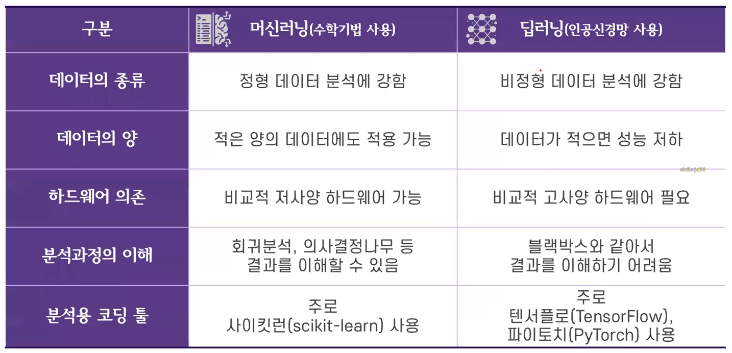

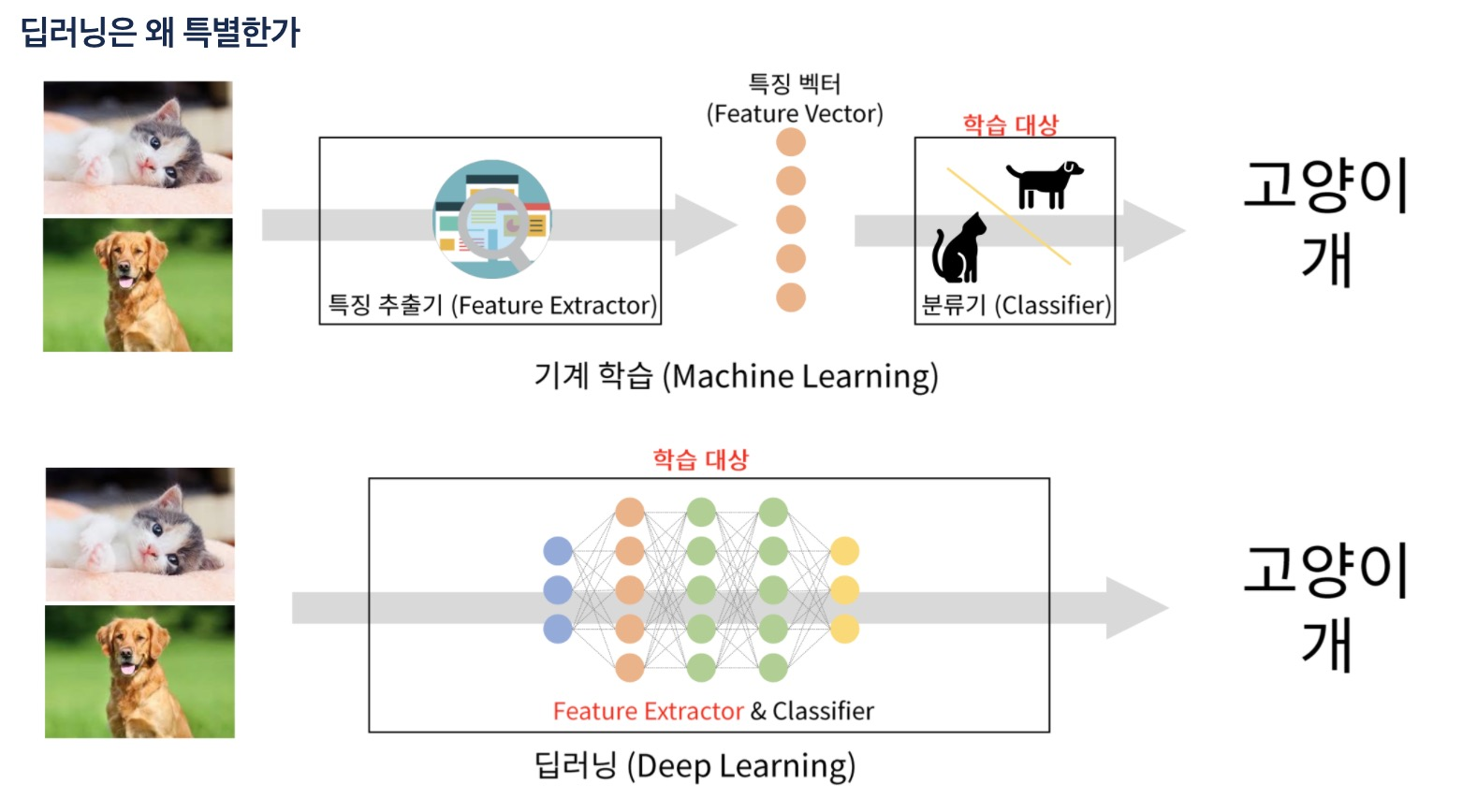

ML vs DL

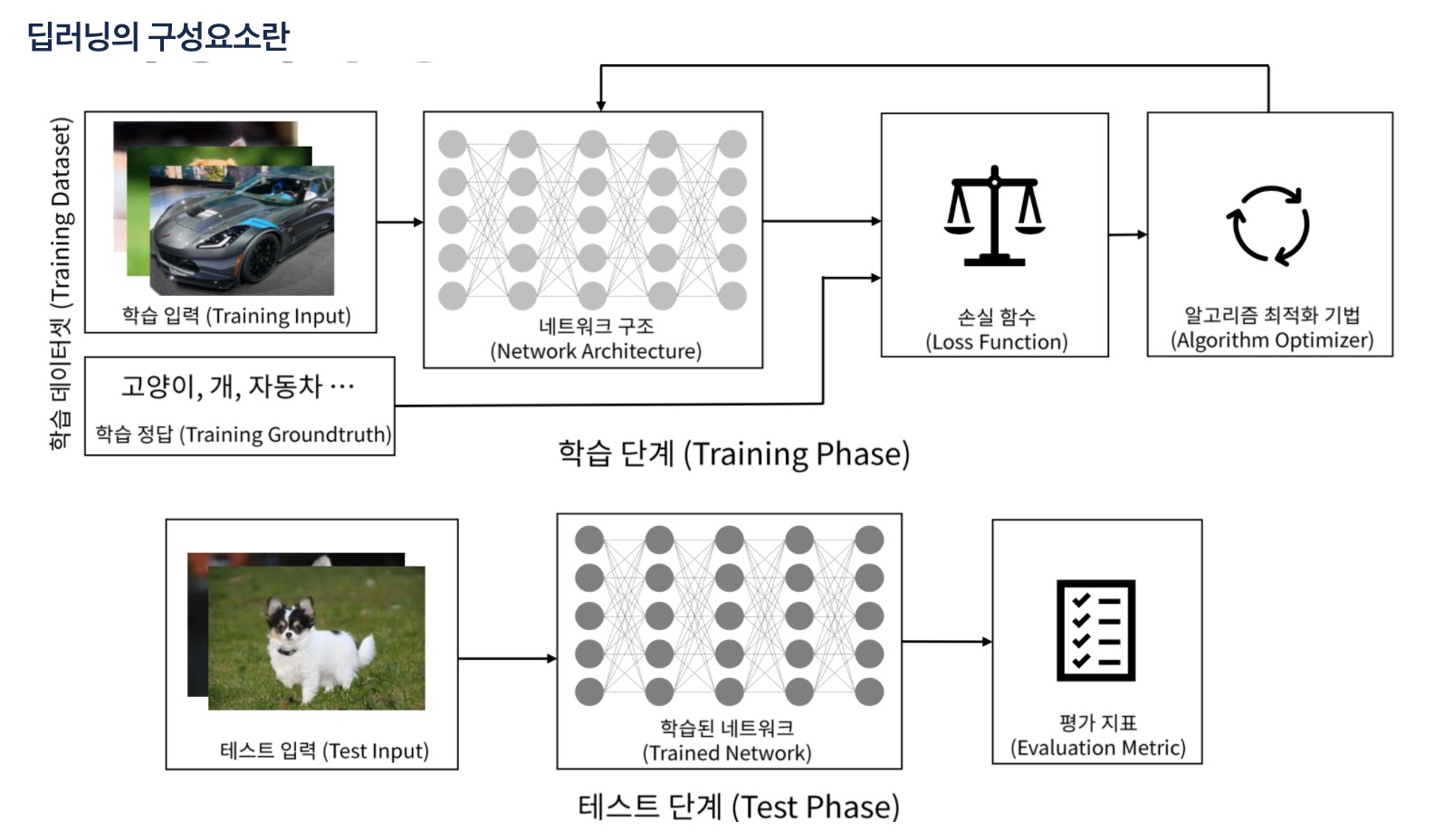

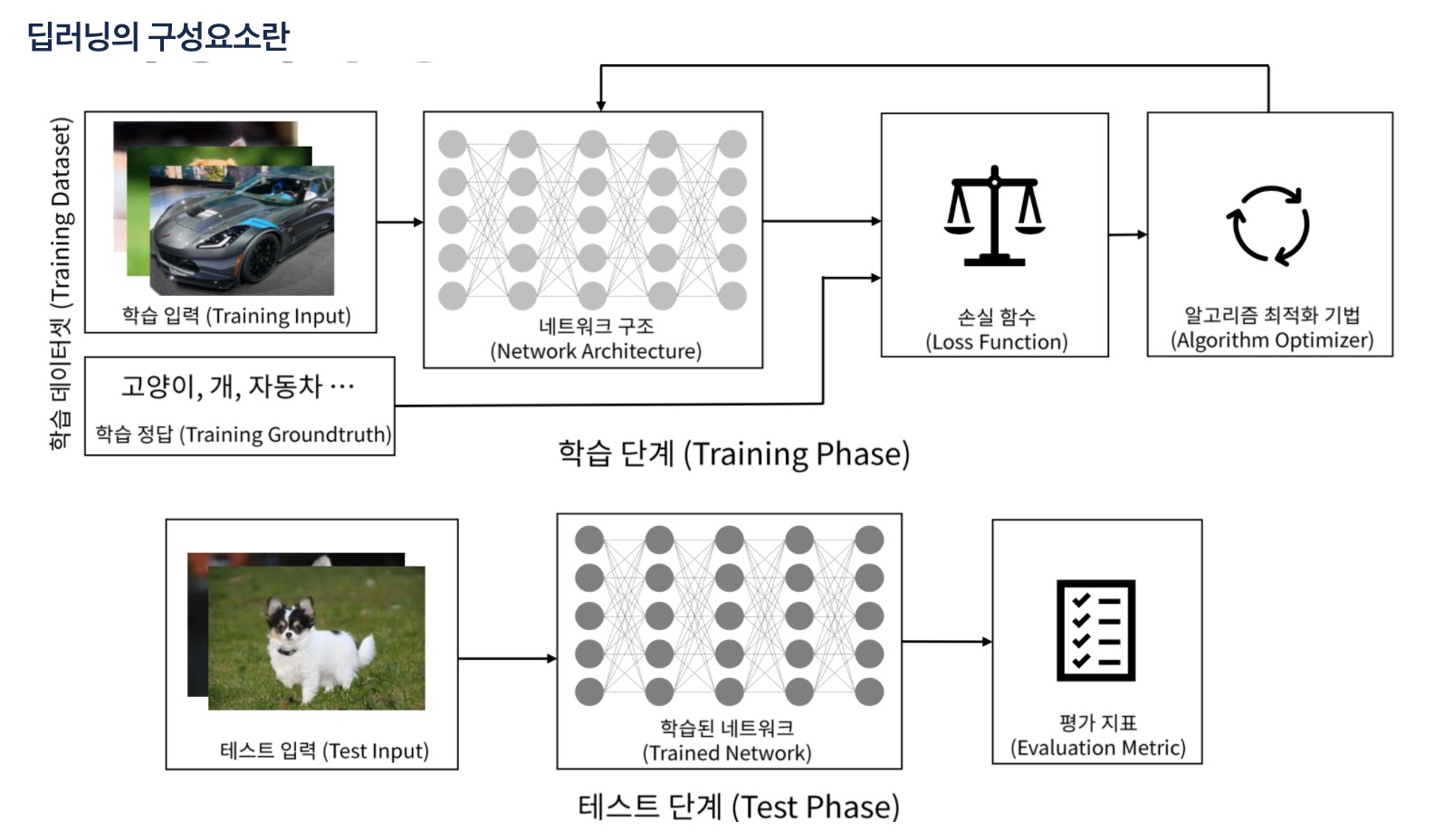

딥러닝 구성

딥러닝

뉴런

- 구성요소 : 입력, 가중치, 활성화함수, 출력

- 가중치를 업데이트

- 처음에는 초기화를 통해 랜덤값을 넣고, 학습을 통해 가중치를 수렴시킴

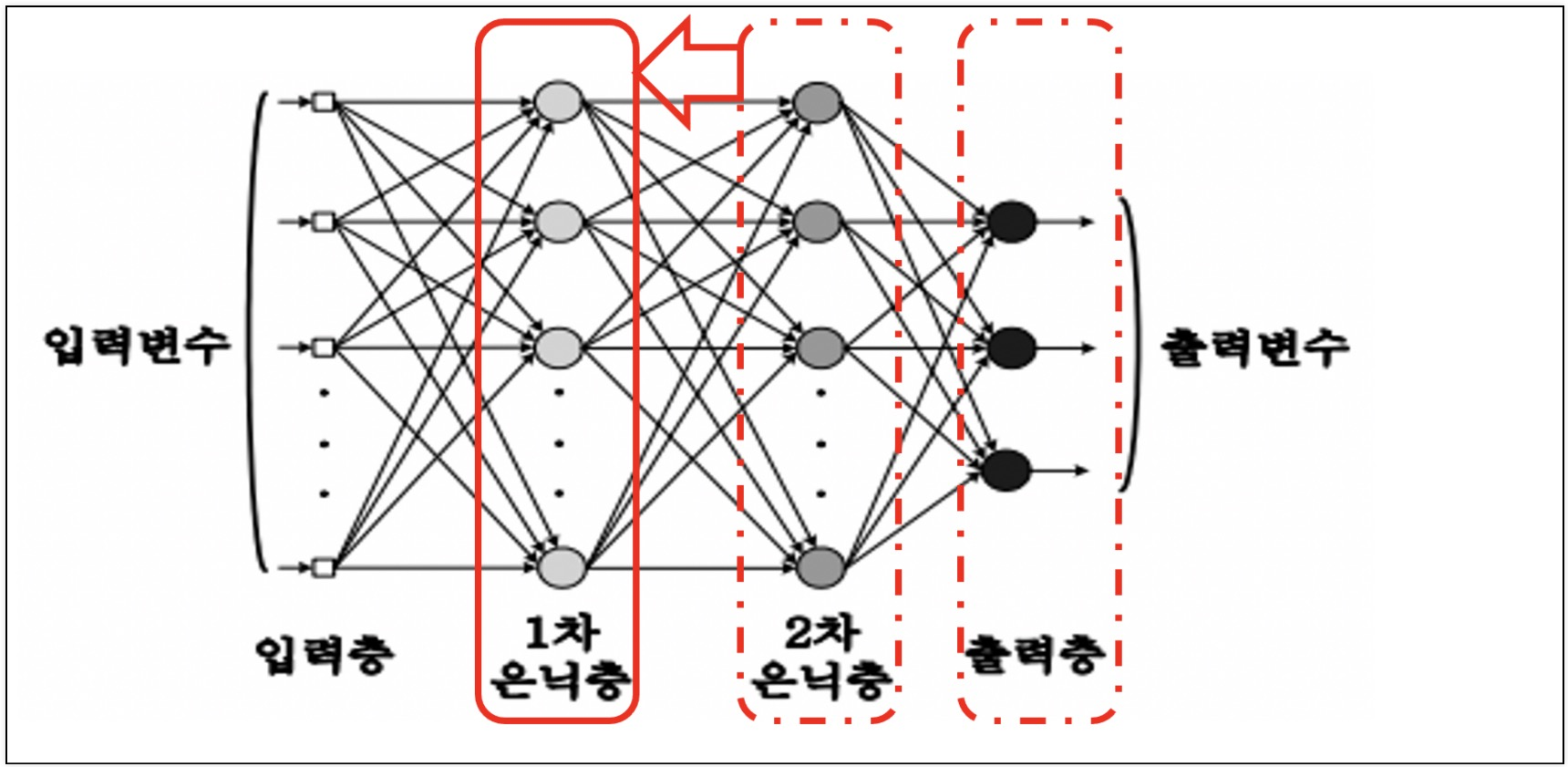

레이어와 망(net)

- 뉴런이 모여서 layer를 구성하고, 망(net)이 됨

딥러닝

- 신경망이 깊어(많아)지면 깊은 신경망 Deep Learning이 됨

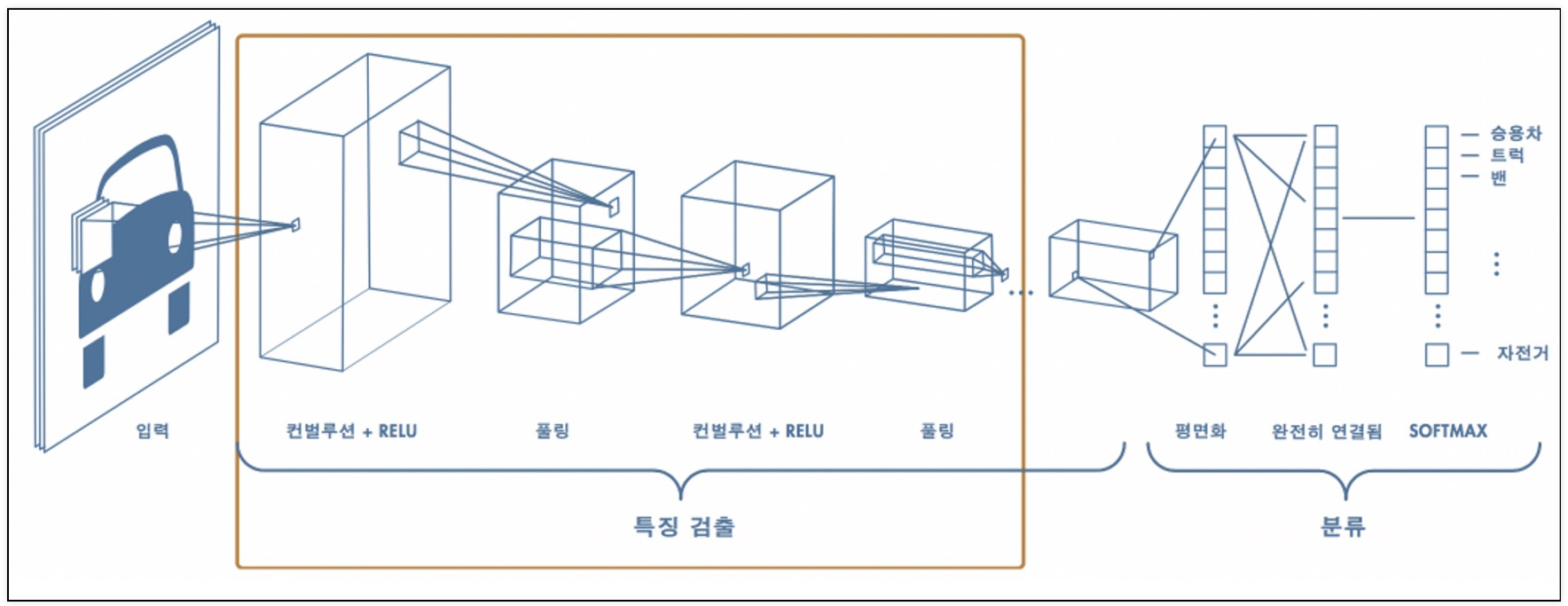

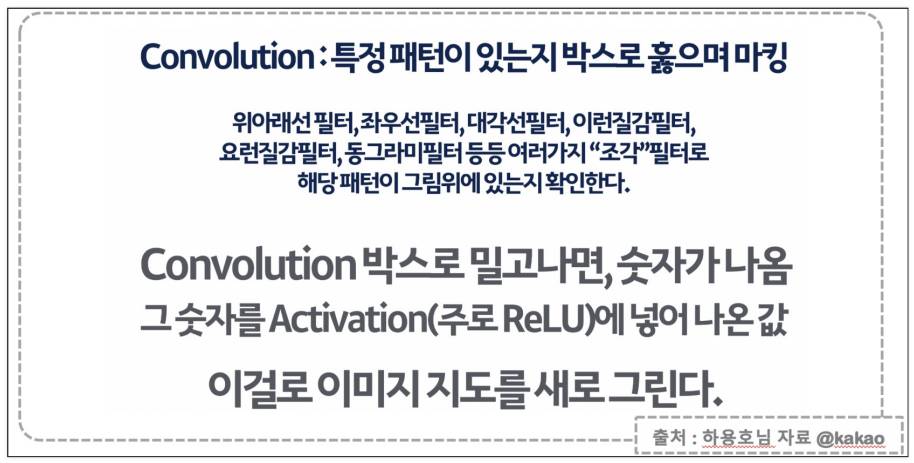

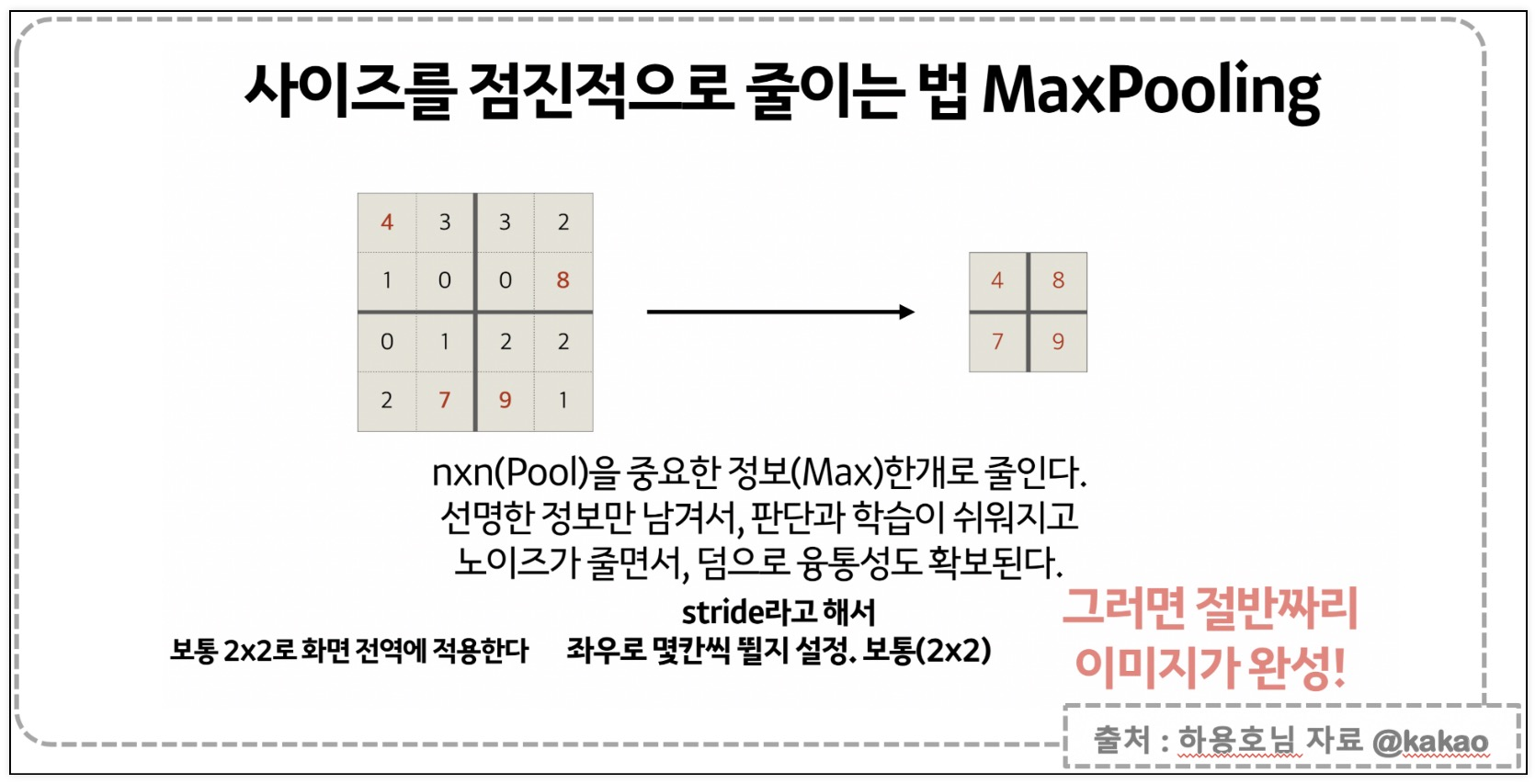

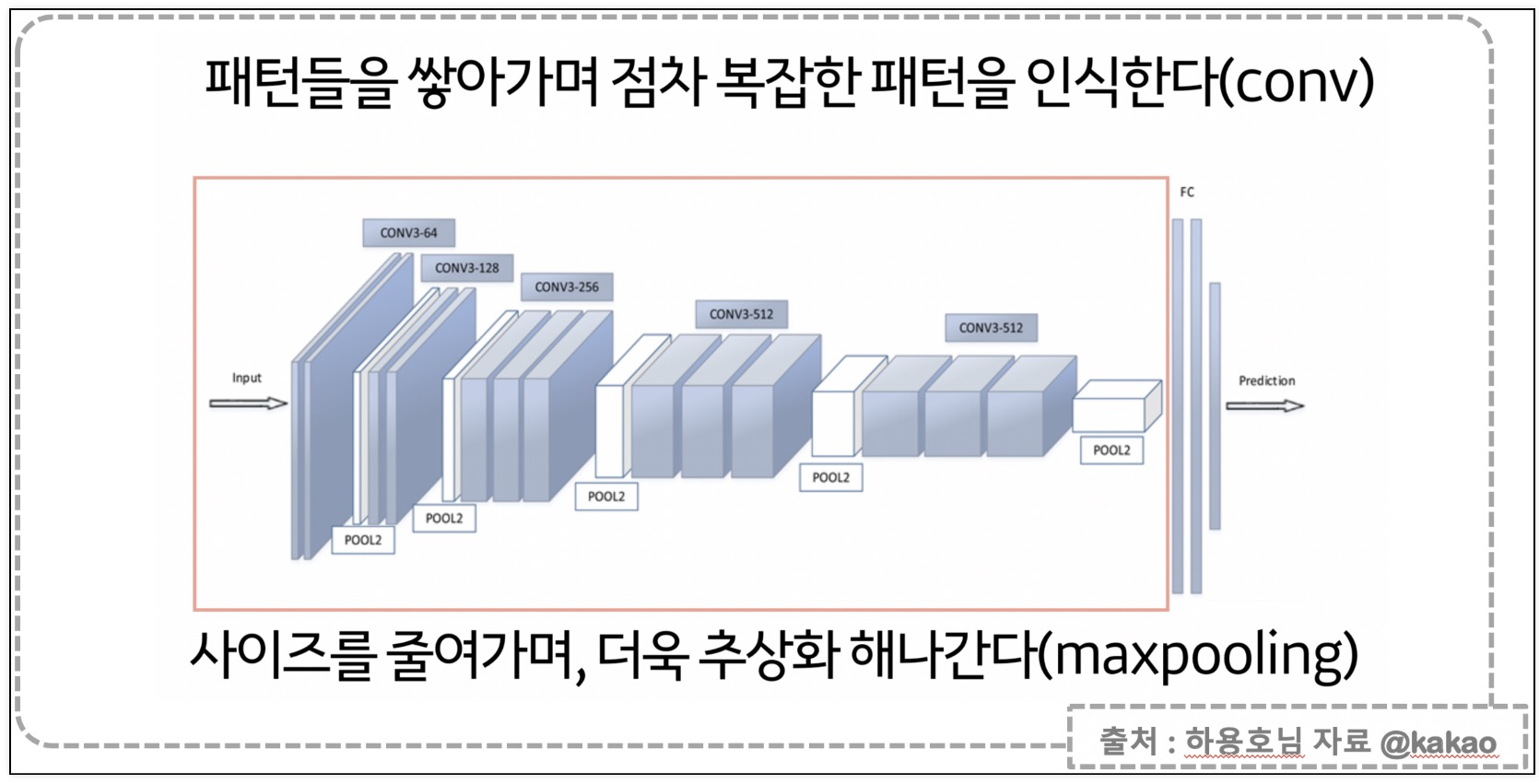

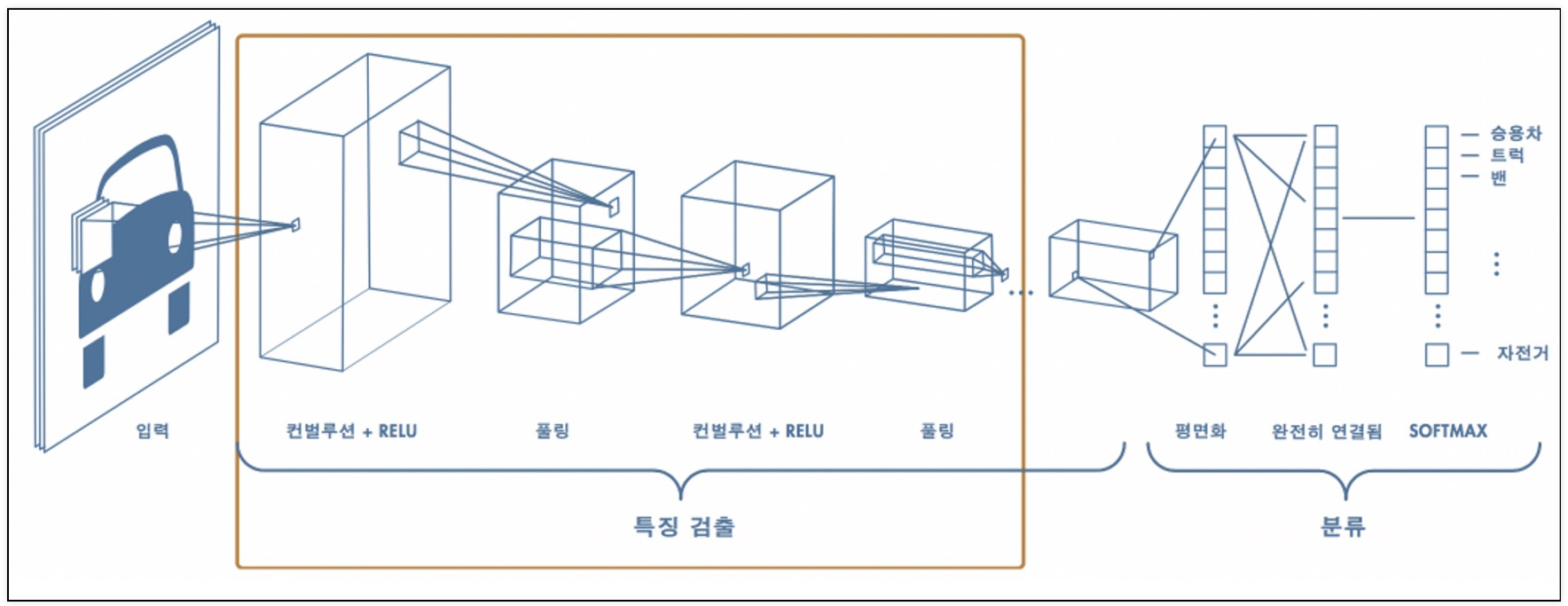

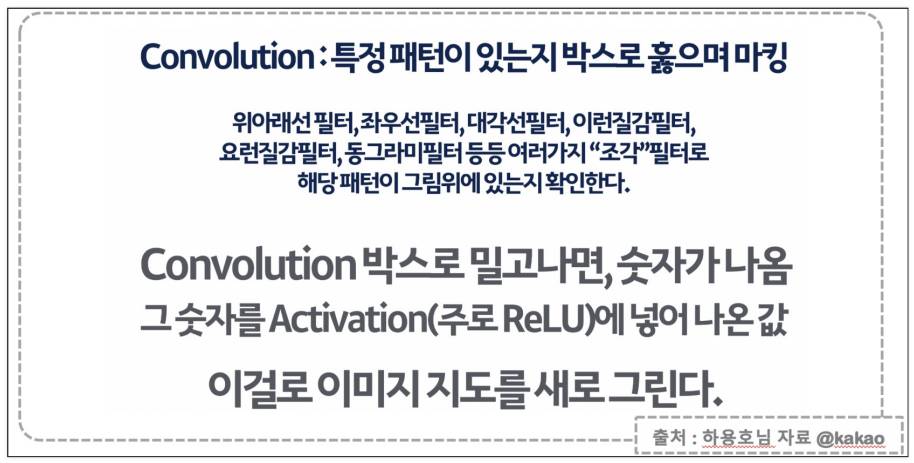

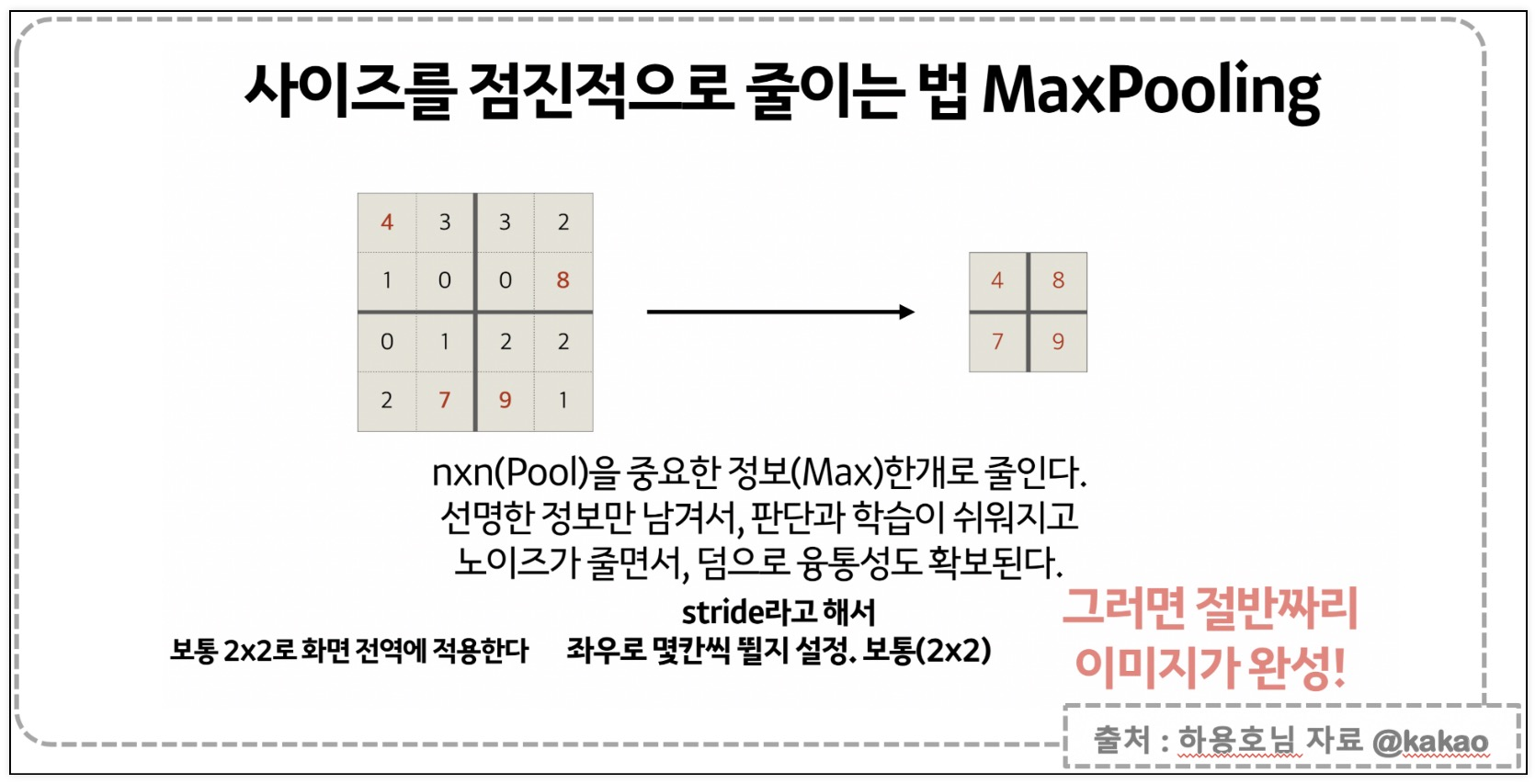

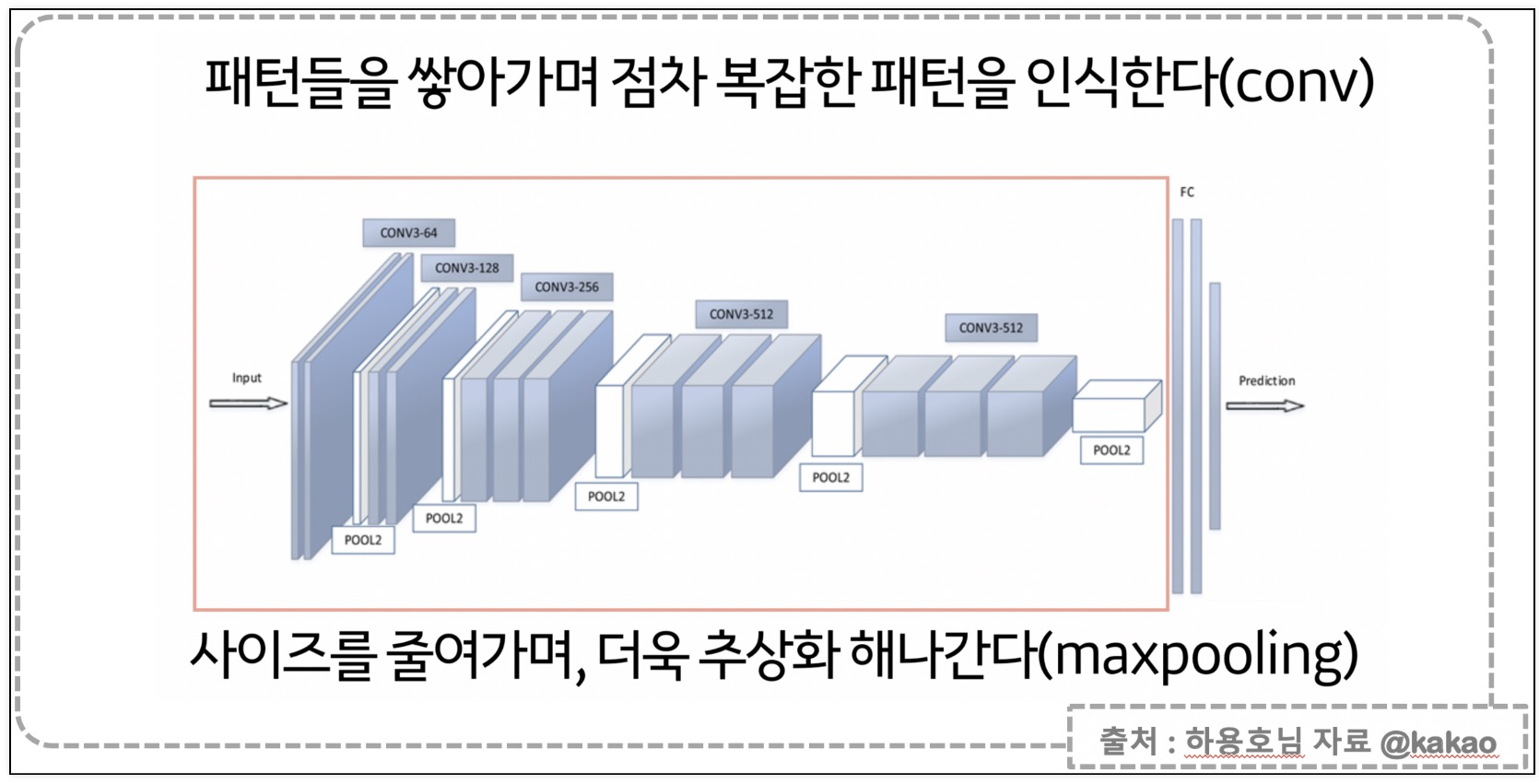

CNN

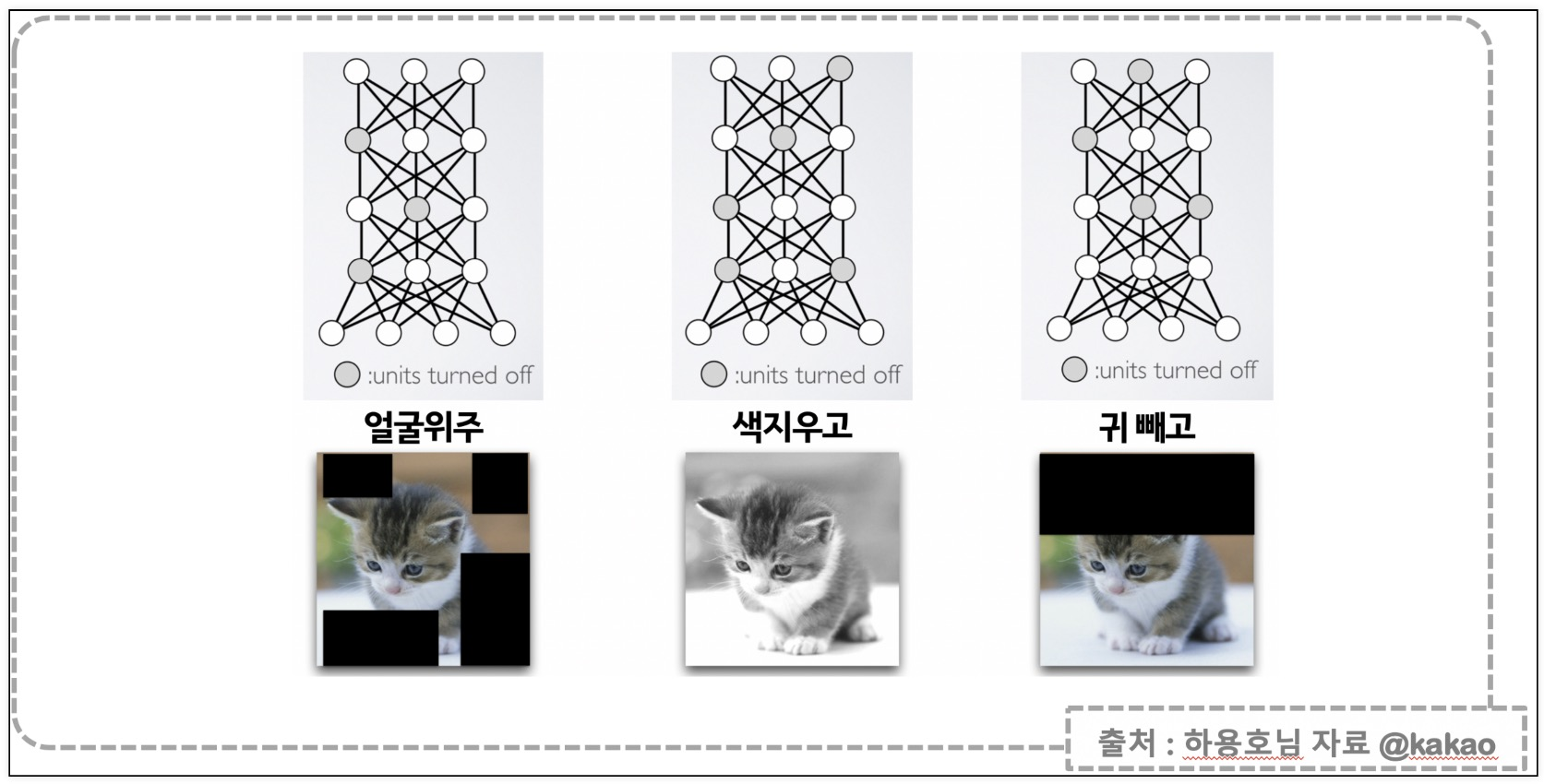

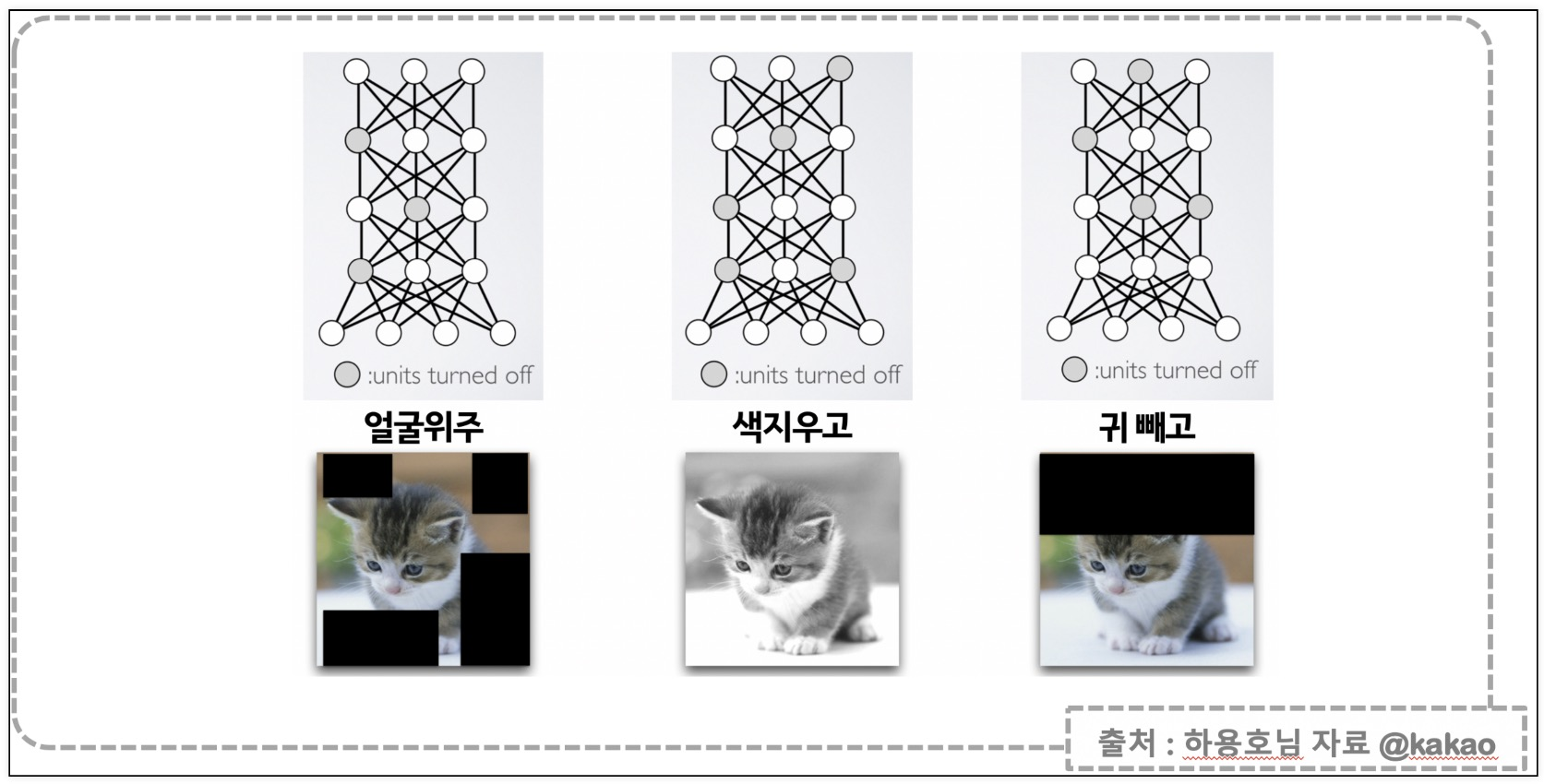

Dropout

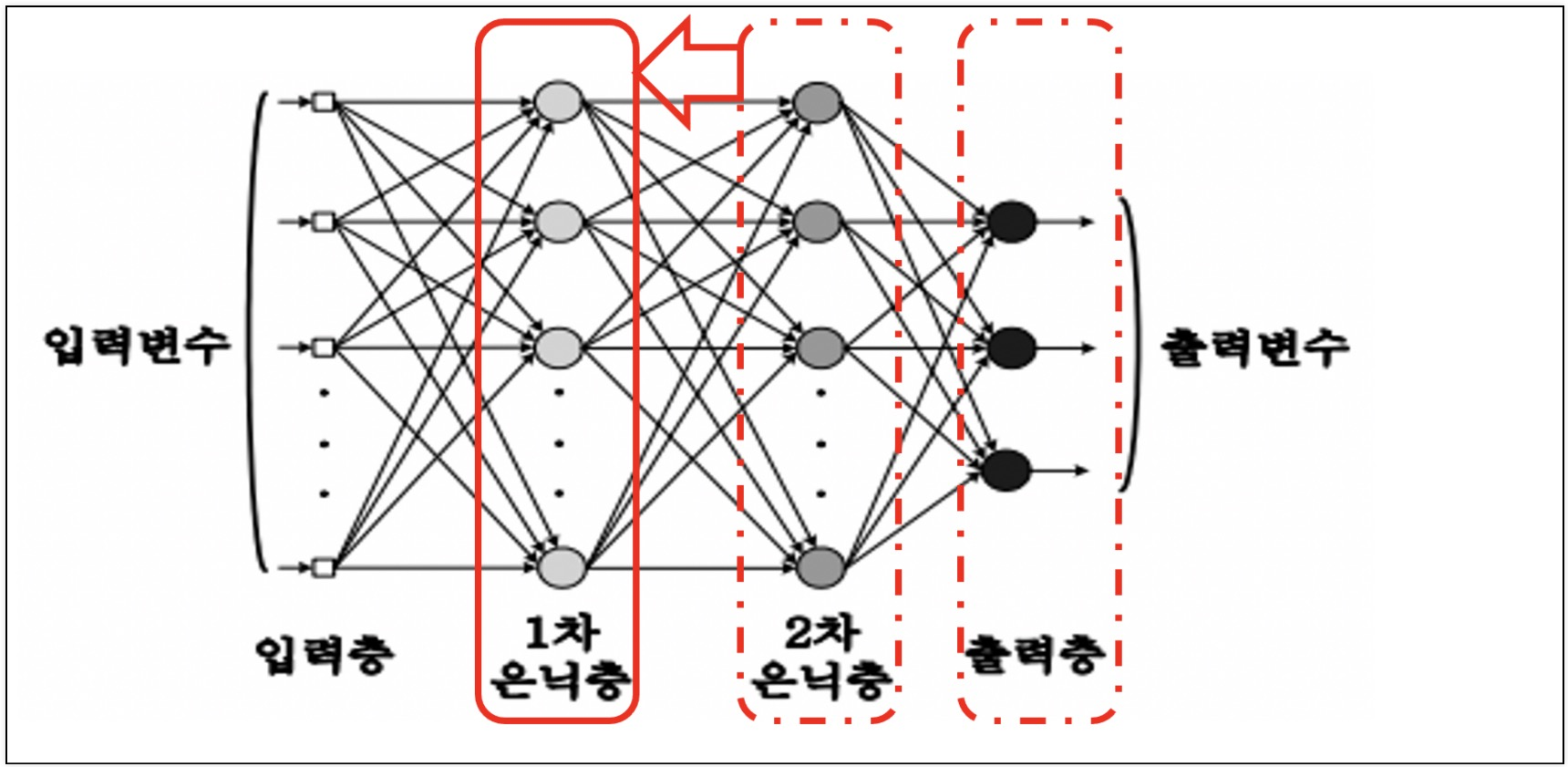

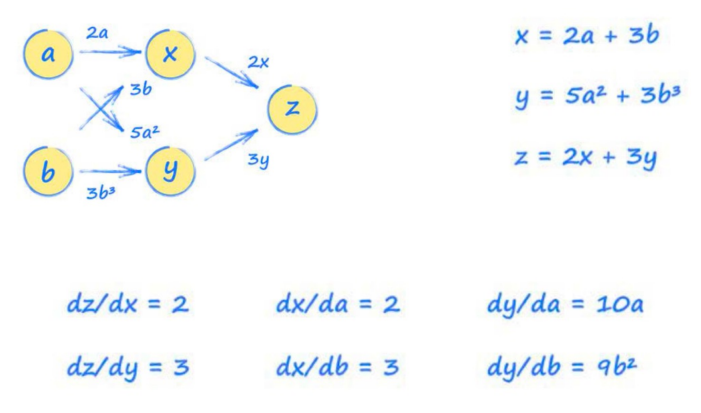

역전파

- XOR문제의 해결을 위해 등장한 역전파

- 출력층부터 delta를 계산해서 은닉층으로 전달한다

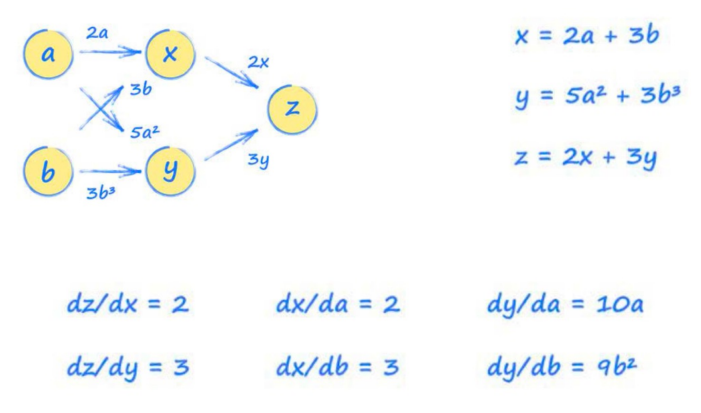

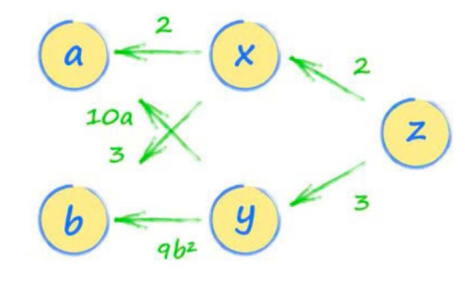

연쇄법칙(Chain Rule)

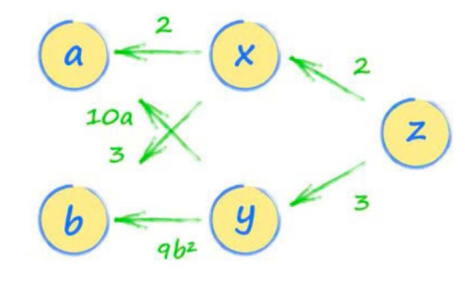

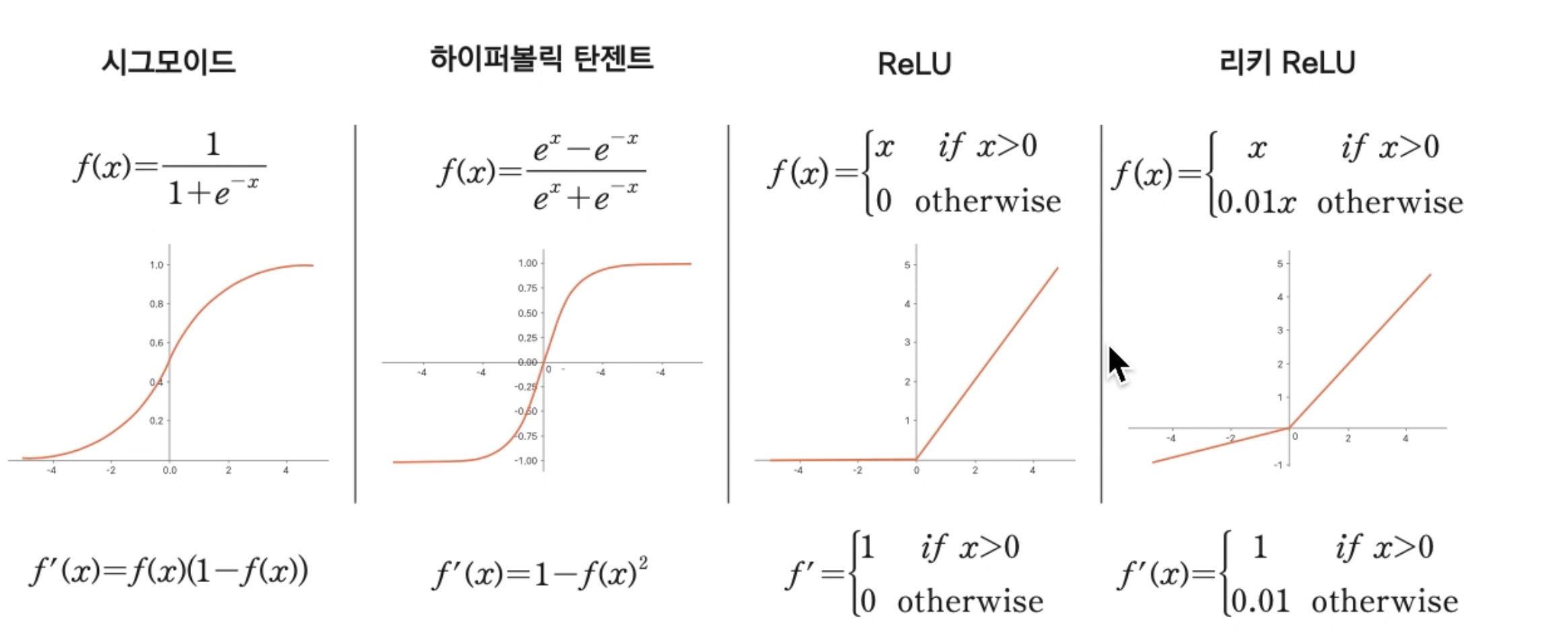

활성함수

softmax

- softmax(xi)=exi/∑j=1nexj

- 입력받은 값을 출력으로 0~1사이의 값으로 모두 정규화하며 출력 값들의 총합은 항상 1이 되는 특성을 가진 함수

ReLU

- f(x)=max(0,x)

- +/-가 반복되는 신호에서 -흐름을 차단

sigmoid의 한계

Vanishing Gradient problem

ReLU

- Rectified Linear Units

- 은닉층은 대부분 ReLU를 사용

softmax

- 카테고리들 중 확률이 가장 높은 대상을 정답으로 판단

활성화 함수 미분값

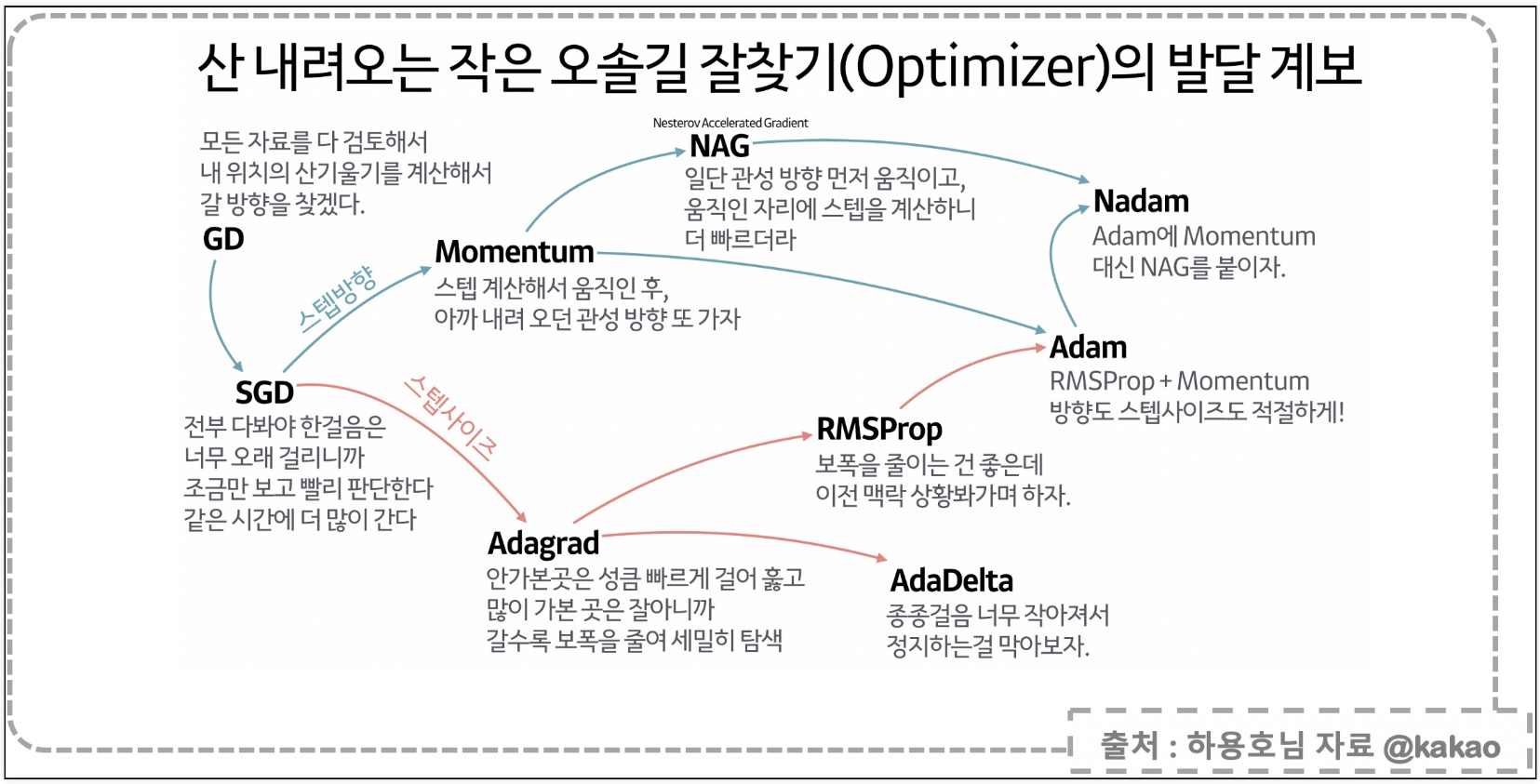

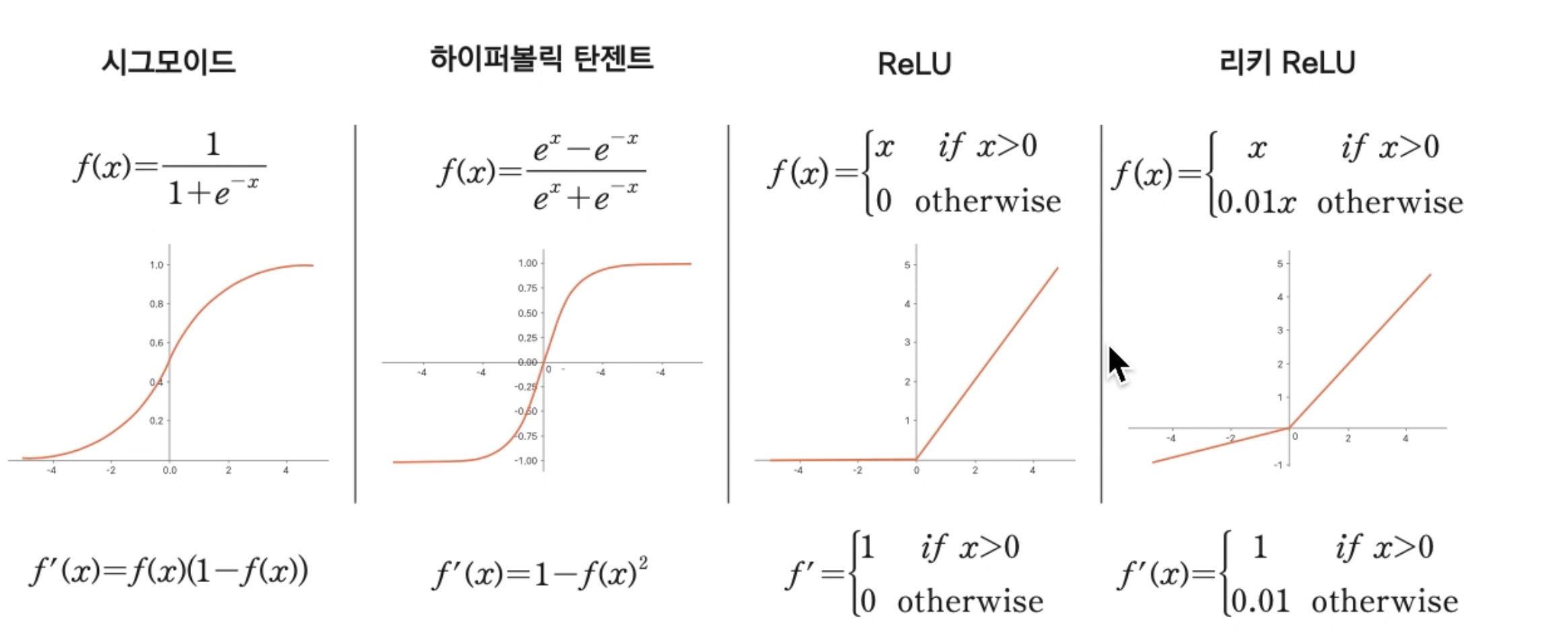

옵티마이저