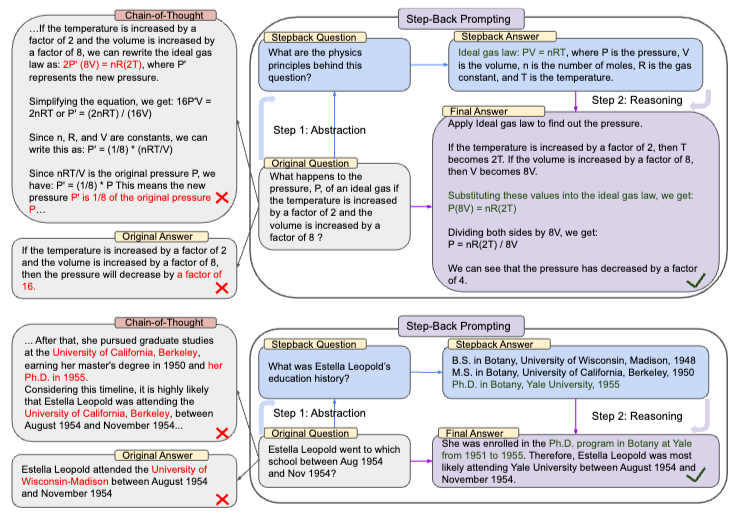

two -step process

-

LLMs에게 step back 방식을 알려준다

high-level abstraction을 뽑아낼 수 있도록 한다.

-

추론능력을 leverage 시킨다.

1번 과정에서 진행한 concepts들을 바탕으로 solution을 유도한다.

본 논문에서는 domain specific reasoning을 실험했다. ex) knowledge-intensive QA, multi-hop commonsense reasoning. → 성능이 최대 27% 까지 증가함

Step-Back prompting

LLMs 은 테스크를 해결하기위해 관련된 사실을 retrieve하기 어렵다.

original question은 higher-level of abstraction이라는 가정을 진행. (더 세분화 시킬 수 있다.)

original question을 직접적으로 언어모델에게 물어보는 것이 아니라, 관련된 세분화된 사실들을 검색 후 모아진 내용들을 바탕으로 추론을 진행함. → multi hop reasoning(multi-hop이란?: 복잡한 질문이나 문제를 해결하기 위해 여러 정보들 결합을 통해 문제해결 진행)

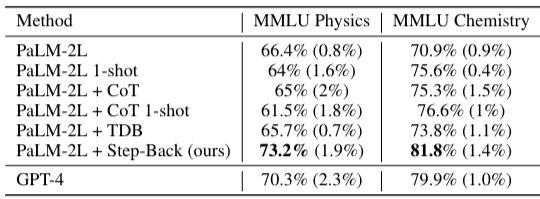

Experimental setup

(a) STEM: MMLU에서 물리, 화학에 대학 문제를 가져옴,

(b) Knowledge QA: TimeQA를 사용, 복잡한 queries가 요구되는 task

(c) Multi-Hop(테스크가 따로 있음): MusiQue테스크 - hard multihop reasoning dataset

STEM task에서는 물리와 화학에 관련된 내용이므로 모델에게 추론을 할 수 있는 개념들을 학습시킨 후 “what are the physics or chemisry principles and concepts involved in solving this task?” 라는 prompt를 준다.

실험결과

CoT, TDB(take a deep breath) 에서는 과학 영역추론에 효과적이지 못하다. 반면, STEP-BACK Prompting 은 7%정도 증가한 것을 볼 수 있다.

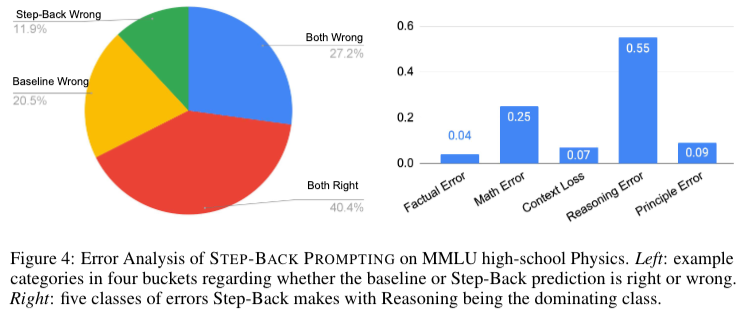

또한 본 논문에서는 error에 대해서 분석을 진행하였다. - 대부분 90% 의 에러가 reasoning step에서 발생하엿으며 그중에서 (principle error를 제외하고 모두 reasoning step이다.) 수학부분에 에러와 reasoning 에러부분이 큰 비중을 차지한다.

Knowledge QA (Time QA, Situated QA)

intensive factual knowledge를 필요로 하는 테스크

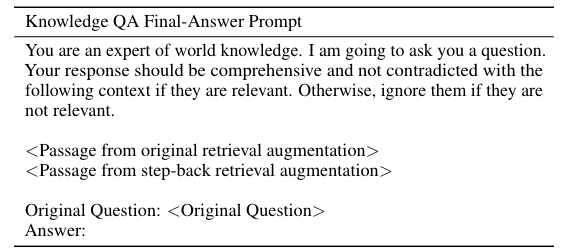

실험 evaluation진행 할 때, LLMs이 Abstraction(추출)을 학습시킨다. figure2 에서 “What was Estella Leopold’s education history”부분을 추출하는 것을 학습. → original retrieval augmentation과 step-back retrieval augmentation을 넣어준 후 답변을 찾게한다.(RAG사용 appendix d.2)

저자들은”high-level concepts(such as education history) is much more accessible than the low-level details” 낮은 수준에서 더많은 details를 이용해 high-level을 풀 수 있음을 보인다고 설명한다.

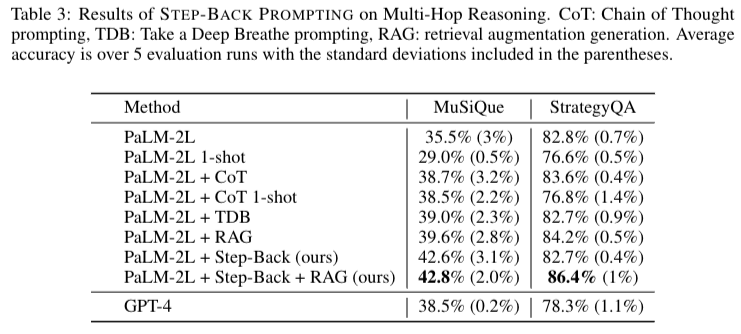

Multi-Hop reasoning(MuSIQue, Strategy QA)

Strategy QA점수가 높은 이유는 binary cls 이기 때문, RAG와 step-back을 함께 사용했을때 기존 방식들 보다 더 좋은 결과가 나옴.

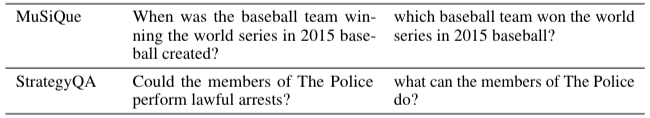

좌측은 original question, 우측은 step-back question

Knowledge QA Step-Back Prompt

You are an expert at world knowledge. Your task is to step back and

paraphrase a question to a more generic step-back question, which is

easier to answer. Here are a few examples:

Original Question: <Original Question Example1>

Stepback Question: <Stepback Question Example1>

...

Original Question: <Original Question Example5>

Stepback Question: <Stepback Question Example5>

Original Question: <Original Question>

Stepback Question:Knowledge QA Final-Answer Prompt

You are an expert of world knowledge. I am going to ask you a question.

Your response should be comprehensive and not contradicted with the

following context if they are relevant. Otherwise, ignore them if they are

not relevant.

<Passage from original retrieval augmentation>

<Passage from step-back retrieval augmentation>

Original Question: <Original Question>

Answer: