Motivation: transformer-based LM이 relevant information을 longcontext에서 어떻게 가져오는 지 보기위한 실험을 진행함.

retrieval head: the heads that redirect information from the input to the output

이에 대한 명칭을 retrieval head라고 명명함. retrieval head는 아래의 5가지 특징이 존재함

- universal: 대부분의 long-context를 다룰 수 있는 모델에 존재한다.

- sparse: 이룹의 head만이 retrieval head 능력이 있다.

- intrinsic: short context로 학습된 pretrained 모델에서 context length를 늘리는 학습을 진행해도 retrieval head는 이전과 동일한 애들이 그 역할을 한다.

- dynamically activated: llama2 모델에서는 12개의 retrieval head가 long-context에서 동작하며, 다른 retrieval head 들은 다른 context에 활성화된다.

strongest retrieval head는 필요한 정보가 무엇이든 항상 활성화 된다. 하지만 weaker retrieval 은필요한 정보의 다른 부분에서 활성화된다. 결과적으로 헤드는 서로의 기능을 보완한다. 이는 헤드의 하위 집합을 제거하면 모델은 최소한 필요한 정보의 일부를 검색한다. - causal: retrieval head를 다 pruning하면 model performance가 급격하게 떨어진다. 하지만 동일한 숫자의 다른 head를 푸르닝해도 model performance 감소치는 상대적으로 작다.

- CoT 는 retrieval head영향을 받지만 direct QA의 형태에서는 영향이 작다.

Retrieval score

Niddle in the haystack 셋팅에서 “모델이 생성한 단어가 input정답에 있을 때, 어떤 head의 활성화 정도가 가장 크냐” (Intuitively, retrieval score represents a token-level recall rate of the most attended tokens by an attention head)

Retrieval Head Detection Algorithm

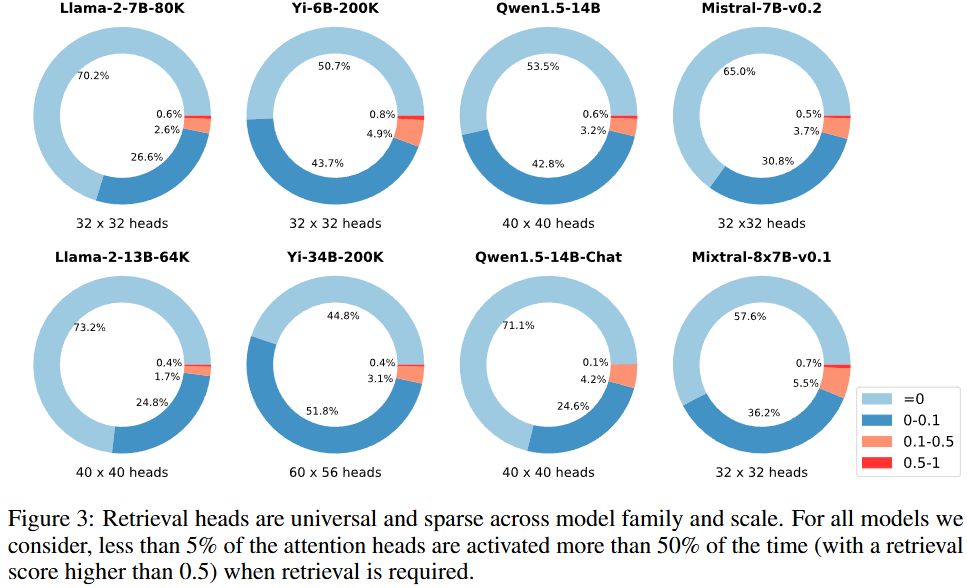

question과 answer 에 해당하는 k 를 관련없는 정보를 넣으며, 내부지식으로 답변할 수 없는 데이터를 사용한다. 20개의 다양한 length를 가지고, 다양한 위치에 답변을 넣어서 확인한다. 이때 모든 head의 retrieval score를 측정하고 0.1 이상의 점수를 갖는 head에 대해서 retrieval head로 간주한다. 전체 attention head중 약 5퍼센트 미만이 retrieval head가 된다.

Basic Properties of Retrieval Heads

전체 retrieval head에서 약 45-73% 는 활성화 되지 않고 다른 역할을 한다. 오직 3-6% 정도의 retrieval head의 score가 0.1 보다 높다.

retrieval head를 제거했을 때 와 random으로 제거했을 때 QA 실험결과