- 전체보기(309)

- flutter(18)

- laravel(6)

- 인공지능(6)

- 리뷰(5)

- 공상(5)

- 아이디어(4)

- 보안(4)

- 퀀트(4)

- 파이썬(4)

- 책(3)

- 팁(3)

- error(3)

- API(3)

- 수학(2)

- php(2)

- LLM(2)

- livewire(2)

- dbeaver(2)

- vue(2)

- dart(2)

- 딥페이크(2)

- C(2)

- google(2)

- git(2)

- 딥러닝(2)

- Tailwind CSS(2)

- 정리(1)

- CocoaPods(1)

- obj(1)

- 파나마(1)

- 웹(1)

- js(1)

- jsp(1)

- tailwind(1)

- Backend(1)

- Oracle-Cloud(1)

- 나에게(1)

- ssh(1)

- json(1)

- dump(1)

- 생각(1)

- 대출(1)

- bug(1)

- 자격증(1)

- OpenAI(1)

- iphone(1)

- 투자(1)

- cloud(1)

- 암호화폐(1)

- getx(1)

- riverpod(1)

- 추천(1)

- scotch.io(1)

- mysql(1)

- chris(1)

- CSS(1)

- 게이샤(1)

- 커피(1)

- null-satefy(1)

- 에러(1)

- 사업(1)

- better dev(1)

- 마크다운(1)

- react native(1)

- 의역(1)

- db(1)

- 맥도날드(1)

- 리서치(1)

- go(1)

- 일기(1)

- jquery plugin(1)

- 유틸(1)

- 강화학습(1)

- datepicker(1)

- Fuchsia(1)

- 아마존(1)

- sql(1)

- terminal(1)

- 쿠폰(1)

- server(1)

- vibe coding(1)

- claudecode(1)

- 꿈(1)

- 비추천(1)

- NLP(1)

- velog(1)

- 유튜브(1)

- diffusion(1)

- 생두(1)

- chatGPT(1)

- muscle memory(1)

- 시장(1)

- Firebase(1)

- 코딩 설명(1)

자신의 프로젝트 히스토리에 맞게 Claudecode Skills 만드는 make-skills

name: make-skillsdescription: Meta-skill for creating new Claude Code skills. Systematic approach to identify repeated workflows, extract patterns fro

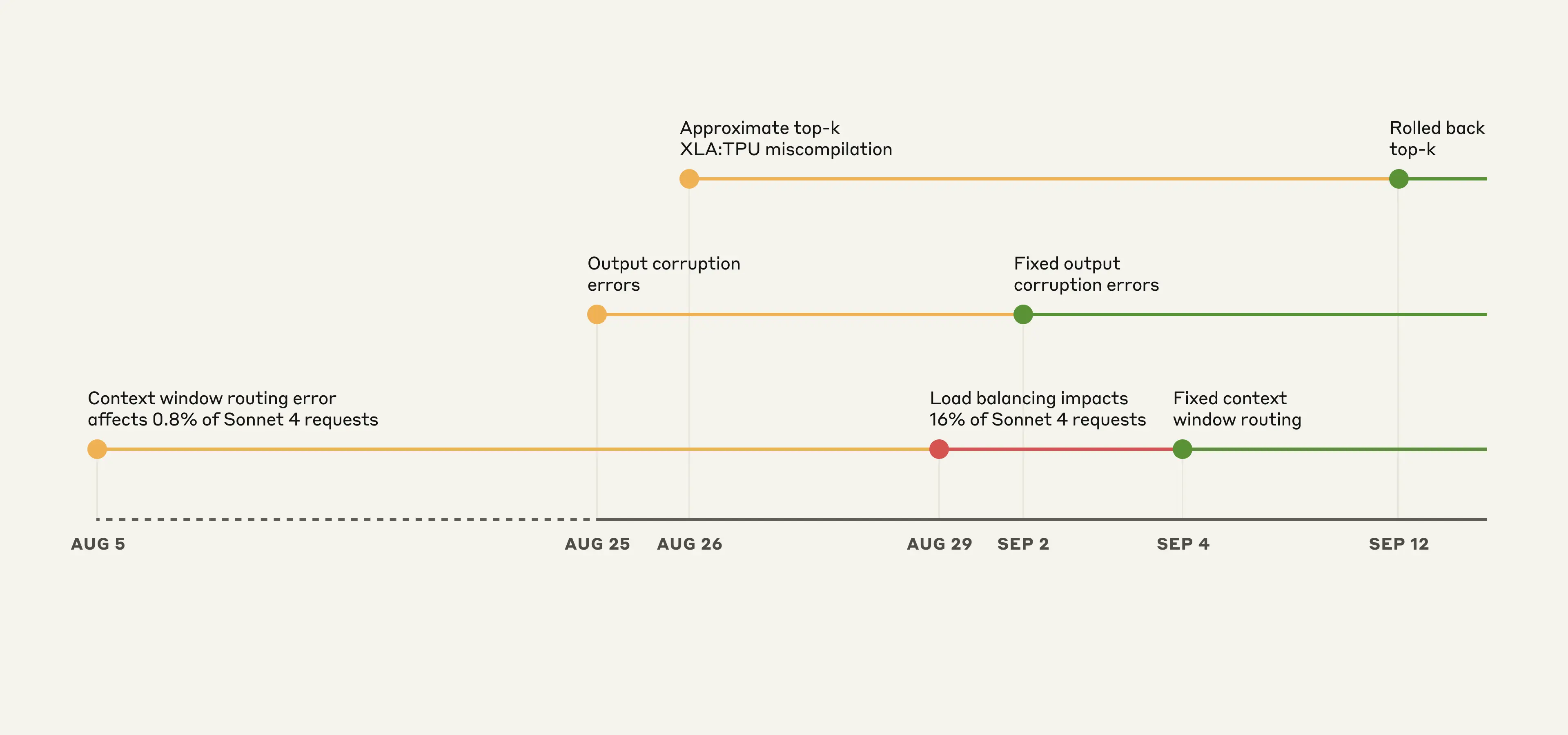

안트로픽 버그, 다시 한번 엔비디아 생태계가 절대적인지 알려줌

https://www.anthropic.com/engineering/a-postmortem-of-three-recent-issues예전에는 'JAX' 이런 프레임워크는 연구자용 실험 툴이고, 진짜 실전은 다들 PyTorch 기반에 NVIDIA GPU만 돌리는

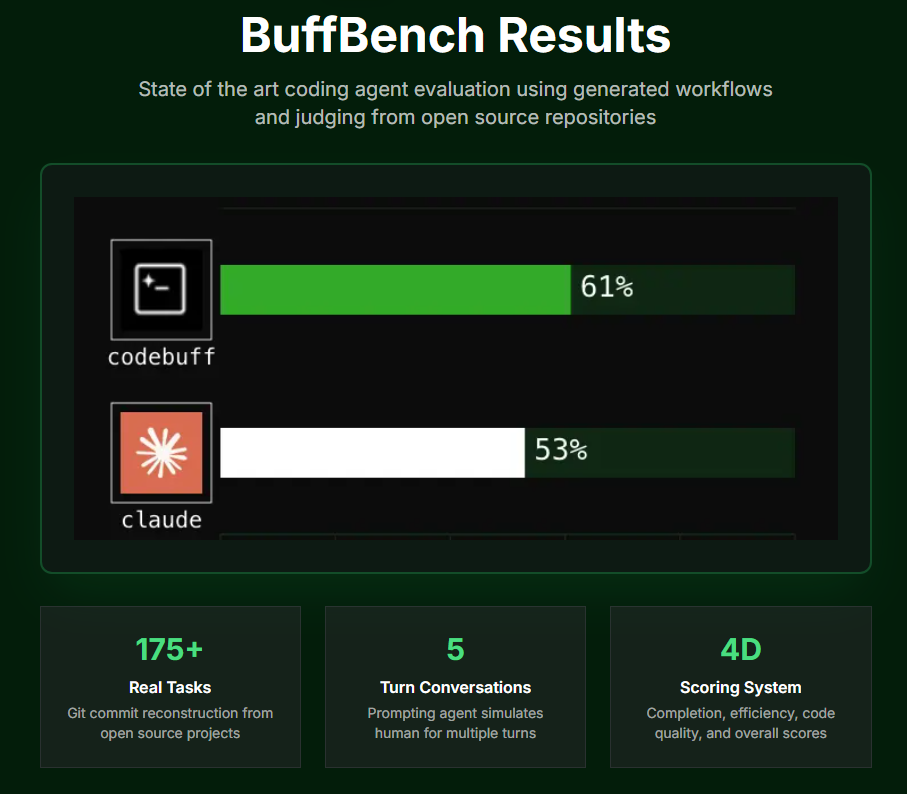

Codebuff, Claudecode Opus 보다 좋은 CLI

비싸지만 현재 1짱클로드코드 및 다른 AI 코딩툴 다 써도 해결 안된 문제를 3트만에 해결대신 비쌈...서로 200크레딧 리퍼럴 링크(최대 5명)유튜브 관련 링크https://www.youtube.com/watch?v=y4JvgfsO8PUhttps:/

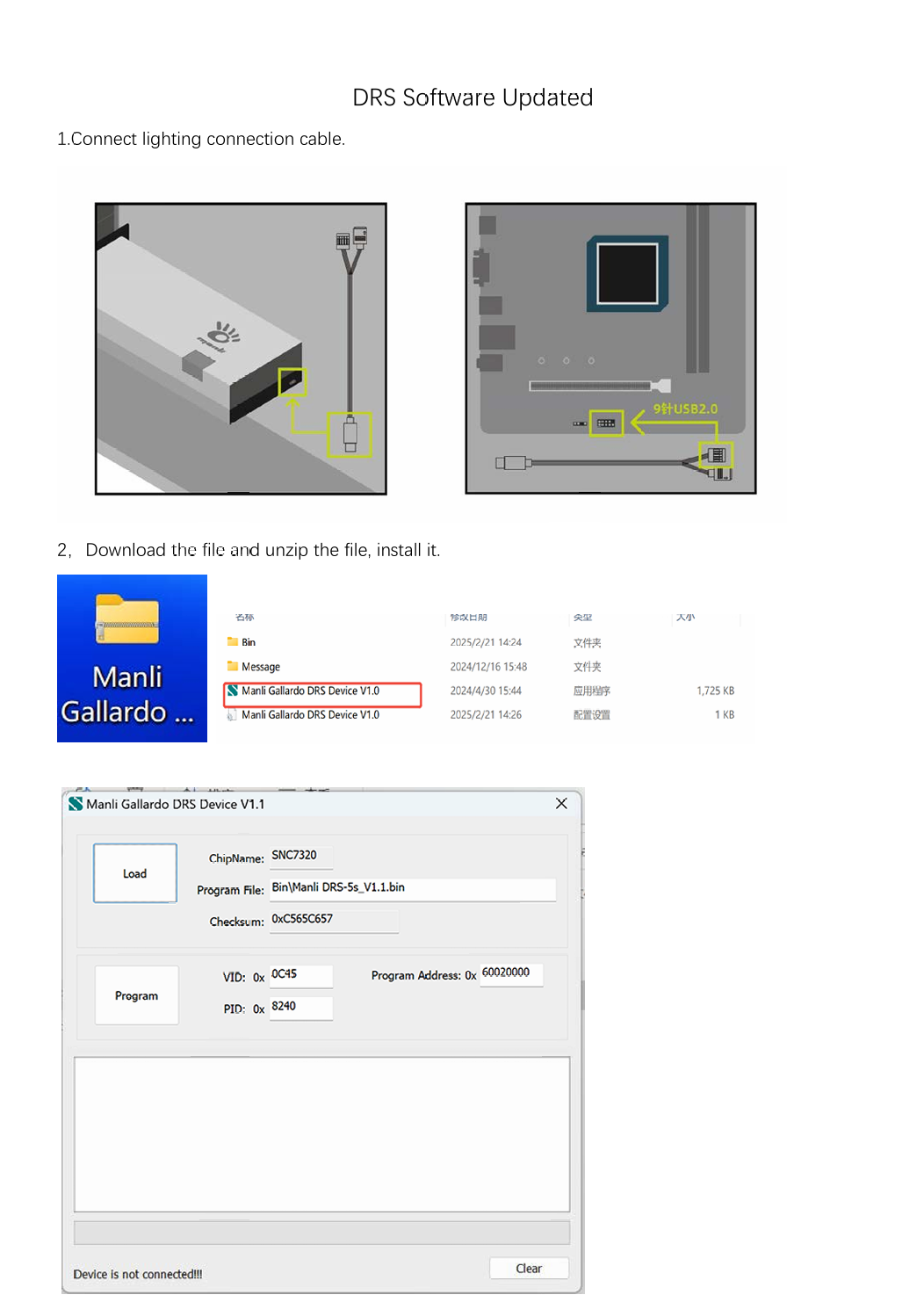

manli rtx 5090 RGB 싱크 맞추기

만리 공식 웹사이트에서 DRS 다운로드DRS Updating 읽고 따라하기2번정도는 program failed 나오는데, 여러번 하면 결국 된다.메인보드사 RGB Controller 다운받고윈도우 설정까지 맞추면 끝.

생성 확산 모델 generative diffusion model 수학 공식 풀어서 설명하기

최근 인공지능 그림들을 보면 감탄이 나옵니다. DALL-E, Midjourney 같은 모델들은 어떻게 완전히 새로운 이미지를 만들어낼까요? 이 기술의 중심에는 '확산 모델(Diffusion Model)'이라는 아이디어가 있습니다.문제는 대부분의 설명이 시작부터 아래와

deepseek 패닉셀 = qqq 매수 기회

Text 생성의 제약컨텍스트 사이즈의 제한으로 인해 텍스트 생성 AI는 아직 완벽한 성능을 보여주지 못하고 있다. 진정한 의미의 고성능 구현을 위해서는 현재보다 100-1000배 이상의 GPU 연산력이 필요한 상황이다.비디오 생성의 현실구글이 개발한 비디오 생성 AI도

ChatGPT 대중에 데모 공개된 건 2022년이 아닌 2020년

2050년 없어질 0순위 업종: 일반 프로그래머4년 하고 5개월전, 대충 미래가 어떻게 변화 할지는 짐작을 했다.하지만 이렇게 빠르게 변화 할 줄은 몰랐다. 그때 potcast에서 잠깐나온 OpenAI의 Sam Altman이라는 사람이 대단한 사람인줄은 알았는데 이렇게

LLM 코딩 관련 유튜브 채널 소개 🎥🤖✨

오늘은 AI, AGI, LLM에 관심이 많으신 분들을 위한 유튜브 채널들을 소개해드리려고 해요. 📚🔥

LLM 관련 투자 아이디어 업데이트

2023년 12월 구글 롱2023년 12월 마이크로소프트 숏내년 LLM에 넣을 데이터 현저히 작아진다.현재 청산시 무위험으로 30% 수익시장에 배팅 했다면 35% 수익하지만, 아무래도 10% 무수익으로 먹고 끝날을 듯.얻은 데이터: 나의 관점과 시장과 괴리 lag는 1

SQL의 숨은 보물, OVER () 절 완전 정복하기! 🎉

안녕하세요, SQL 요리사 여러분! 오늘은 SQL의 맛있는 비밀 재료, OVER () 절에 대해 알아볼 거예요. 이 기능은 마치 비빔밥에 계란 프라이를 얹는 것처럼 여러분의 쿼리를 더욱 맛있게 만들어줄 거예요! 😋 OVER ()란 뭘까요? OVER () 절은 SQ

Flutter + Riverpod로 전역 상태 관리 마스터하기 💪

안녕하세요, 여러분! 오늘은 제가 Flutter 프로젝트에서 겪은 상태 관리의 '아하' 모먼트를 공유하려고 해요. Riverpod를 처음 봤을 때 "이게 뭐야?" 싶었던 그 복잡한 코드, 함께 파헤쳐 봐요!먼저 상태가 뭔지부터 알아볼까요? 간단히 말하면, 앱이 기억해야

Flutter Riverpod 예제로 설명

Flutter에서 제네릭 믹스인 이해하기

오늘은 Flutter에서 자주 사용되는 제네릭 믹스인에 대해 알아보겠습니다. 다음 코드를 예로 들어 설명해 보겠습니다: 이 코드는 무엇을 의미할까요? 믹스인 선언 DrawerPage는 클래스가 아닌 믹스인입니다. 믹스인을 사용하면 여러 클래스에서 코드를

flutter에서 ":" colon

보통 위와 같은 코드에서 쓴다.두개의 : 이 있는데첫번째 colon의LoginScreen({Key? key}) :명칭은 initializer list 불린다.: 이후 따라오는 것이 constructor body가 실행되기전에 먼저 초기화 된다.위 코드를 한국어로 번역

JSP Java Beans 생성자가 두개 있는 이유

도구와 프레임워크에 의한 인스턴스화: 기본 생성자를 통해 JSP, Servlet 등의 Java Beans 프레임워크에서 인스턴스를 생성하기 위해Serialization and Deserialization: 기본 생성자는 Java Beans 객체를 Serializatio

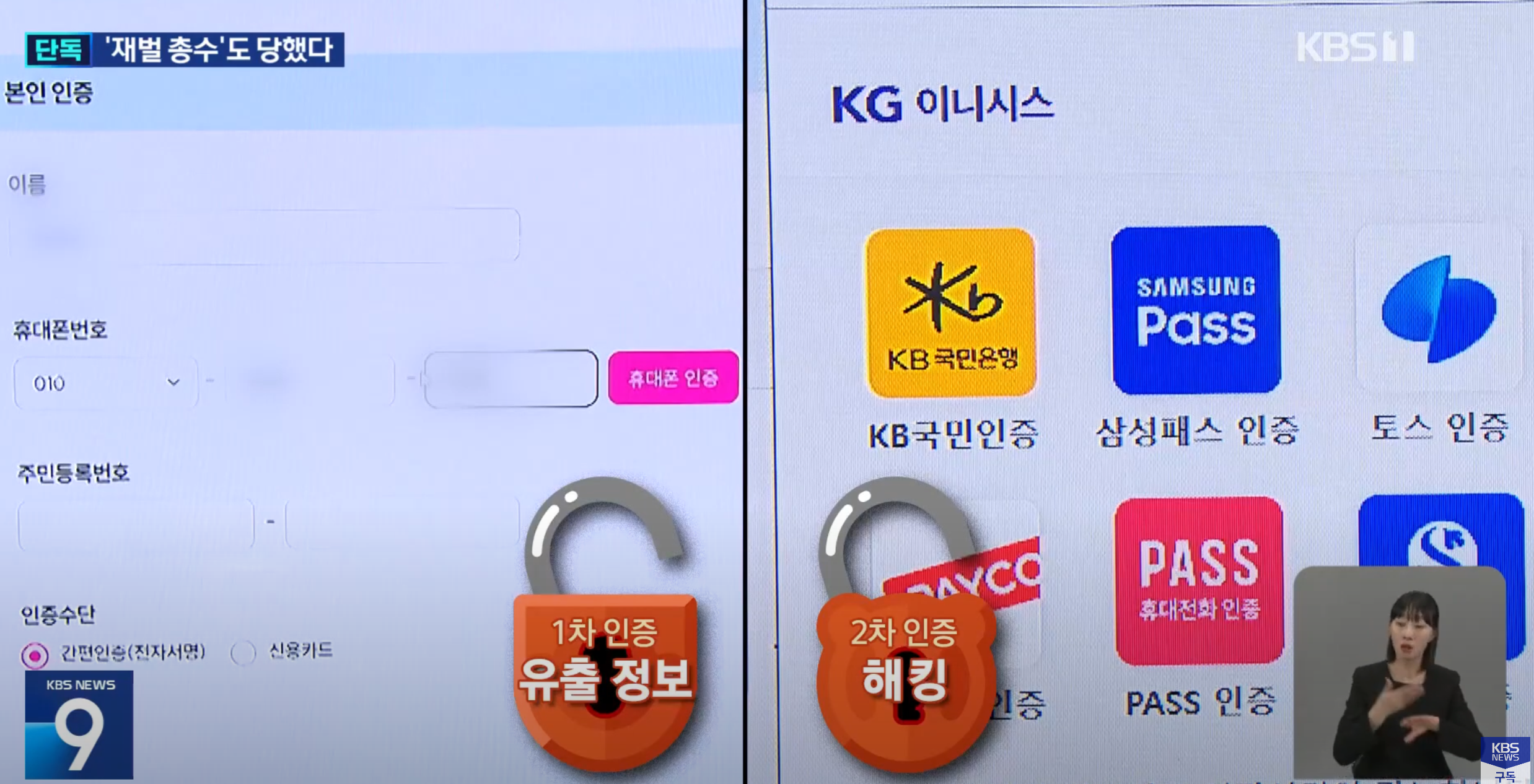

2021년에 이미 언급한 간편인증 보안문제 이제야 정부에서 확인

2021년 12월 8일에 쓴 "간편인증서 보안 문제"이미 2021년에 언급한 보안문제가이제야서 수면위에 올라왔다.뚫린곳은 도로교통공단뿐만이 아니다.분명 건강보험공단도 뚫렸다.아마도 건강보혐료 최대치를 내는 사람을 찾기 위한 작업이였으리 생각 된다.여기서 더 큰문제는 도

apple vision pro 사업 아이디어

아이디어 경로: 고프로 착용하고 축구하는 유튜버고프로와의 좋은 차이시선 트렉킹을 저장 할 수 있음depth를 느낄 수 있음현장감이 더 생생함고프로와의 안좋은 차이공유 할 수 있는 플랫폼이 아직 없음같은 기기를 착용 해야 시청 할 수 있음주변 시야가 좁을 수 밖에 없다화

ResNet 차원을 늘리고 줄이는 이유

중에서 input_planes가 16,32,64 로 바뀌는 이유는...ResNet 아키텍처에서 평면(채널) 수의 변경은 사용되는 특정 ResNet 변형에 기반합니다. 일반적으로, 한 "레이어"에서 다음으로 넘어갈 때 평면 수가 증가합니다. 예를 들어, ResNet-34

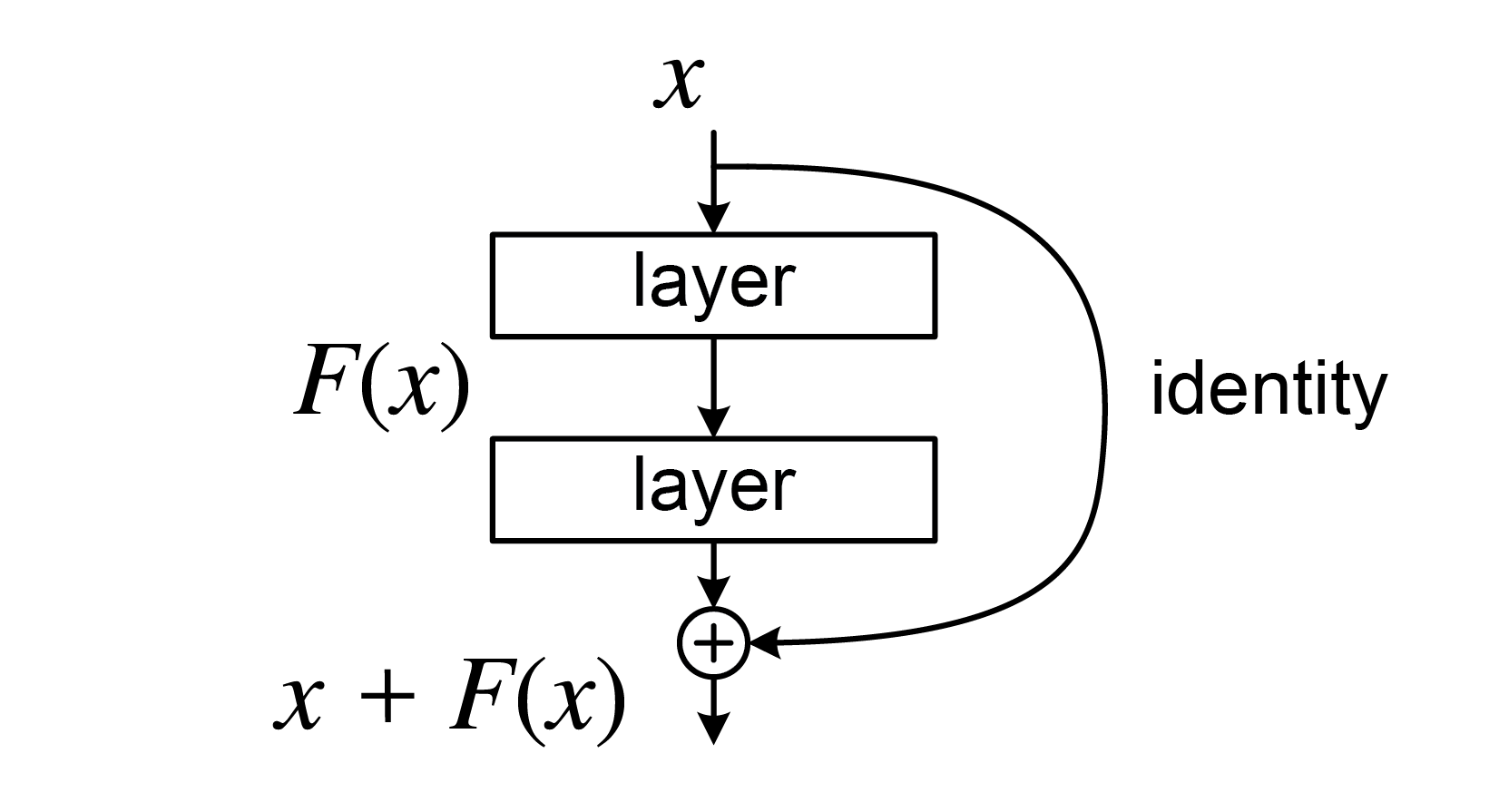

Residual Block in ResNet, identity connection in PyTorch

코드 출처중여기서 shortcut은 그림에서identity connection을 의미한다.element wise addition을 하려면 차원의 동일해야 되니,을 넣는 것 이다.stride가 2이상일 경우는 크기가 축소 될 것 이고input(in_planes)과 ou

multi-head Attention의 필요성

context를 더 많이 담기 위해.각 attention 마다 다른 context를 담을 수 있음.즉 더 많은 정보를 담기 위해.예) "I gave my dog Charlie some food"attention 1 = gave -> Iattention 2 = gave