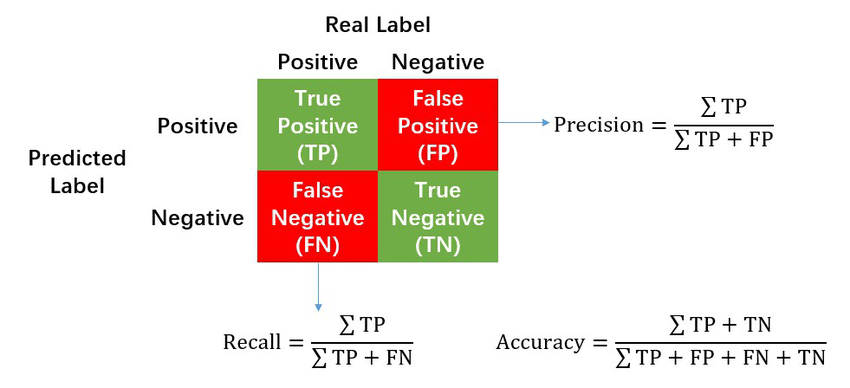

1. precision and recall

- Precision: measures how accurate is your prediction

Prediction이 얼마나 정확한지를 나타내며 검출 결과 중 옳게 검출한 비율을 의미한다.

탐지된 결과가 얼마나 맞는가?

TP+FP = All detections로 Positive의 개수, 즉 탐지된 전체의 수

- Recall: measures how good you find all the positives.

Recall은 재현율을 의미하며, 실제 옳게 검출된 결과 중 옳다고 예측한 것(positive)의 비율을 의미한다.

얼마나 잘 탐지했는가?

TP+FN = Ground truths의 개수, 즉 탐지되어야 한다.

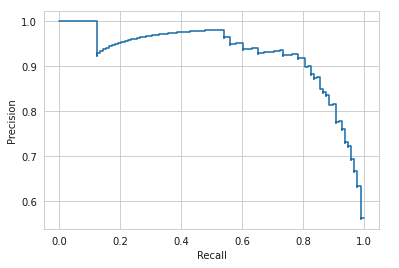

Precision과 recall은 서로 반비례 관계를 갖고 있기 때문에 precision과 recall 중 하나만 고려하기 보다는 precision recall curve를 이용하여 둘 다 고려하는 편이 낫다. Precision recall 곡선은 물체를 검출하는 알고리즘의 성능을 평가하는 방법 중 하나로 confidence 레벨에 대한 threshold(임계값)에 따라 precision과 recall 값들 또한 달라진다.

Confidence는 검출한 것에 대해서 알고리즘이 얼마나 정확하는지 알려주는 값이다. 물체를 검출했을 때, confidence가 1에 가까운 숫자를 가진다면 그 object detection algorithm이 물체가 검출해야 하는 물체와 거의 일치한다고 여기는 것이다. 하지만 confidence는 알고리즘이 학습한 것에 대한 정확도를 나타내기 때문에 confidence가 높다고 해서 무조건 정확한 것은 아니다.

2. Precision-Recall Curve

Recall을 x축, Precision을 y축으로 나타낸 것이 PR 곡선이고 아래와 같다.

PR 곡선을 통해서 Recall 값의 변화에 따른 Precision 값을 확인할 수 있다.

(이미지: https://towardsai.net/p/l/precision-recall-curve)

3. AP(Average Precision)

Precision-recall(PR) 곡선이 정량적으로 비교하기에 불편하다는 점에서 고안된 것이 Average Precision이다. Average Precision은 object detection algorithm의 성능을 하나의 값으로 나타낸 것으로 PR 곡선에서 선 아래의 면적으로 계산된다. Average Precision이 높을수록 알고리즘의 성능은 우수하다.

4. mAP (mean Average Precision)

mAP는 object detection algoritm의 성능을 평가하는 것으로 Average Precision의 평균을 구한 값으로 물체의 class가 여러 개 존재할 때, 각 class의 AP를 구하고 모두 합한 다음 class의 개수로 나눠준다.