아래 내용은 OpenAI ChatGPT로 생성된 내용을 기반으로 필자가 수정(이미지 출처 표기, 어색한 단어 수정)한 것입니다.

딥러닝은 인공신경망을 기반으로 한 기술로, 복잡한 패턴 인식과 추론을 수행하는 데 강점을 가지고 있습니다. 딥러닝의 기원은 인공신경망에 대한 연구로 거슬러 올라갑니다. 그 중에서도 단층 퍼셉트론과 다층 퍼셉트론의 발전은 딥러닝의 핵심적인 기반을 형성했습니다.

단층 퍼셉트론 (Single-layer Perceptron):

- 1957년, Frank Rosenblatt이 단층 퍼셉트론을 개발하였습니다.

- 입력과 가중치를 곱한 후, 활성화 함수를 통해 출력을 계산하는 구조입니다.

- 단층 퍼셉트론은 선형 분류 문제에만 적용할 수 있었고, XOR 문제와 같은 비선형 문제를 해결할 수 없는 한계가 있었습니다.

다층 퍼셉트론 (Multi-layer Perceptron):

- 1986년, 역전파 알고리즘이 제안되면서 다층 퍼셉트론이 발전하였습니다.

- 다층 퍼셉트론은 여러 개의 은닉층을 포함하고, 비선형 활성화 함수를 사용할 수 있어 보다 복잡한 문제를 해결할 수 있게 되었습니다.

- 역전파 알고리즘은 오차를 역방향으로 전파하여 가중치를 조정하면서 학습하는 방법입니다.

다층 퍼셉트론은 여러 개의 은닉층을 추가하여 비선형 문제를 해결할 수 있게 되었습니다.

심층 신경망과 초기화 방법

- 2006년, Geoffrey Hinton과 그의 팀이 심층 신경망의 훈련을 가능하게 하는 초기화 방법을 제안하였습니다.

- 이 초기화 방법은 학습을 위한 초기 가중치를 잘 설정함으로써 깊은 신경망의 효과적인 학습을 도움으로써 성능을 향상시켰습니다.

- 초기화 방법의 개선은 심층 신경망의 훈련에 있어서 중요한 진전으로 여겨집니다.

이렇게 단층 퍼셉트론에서 다층 퍼셉트론, 그리고 심층 신경망으로 발전해오면서 딥러닝은 더 복잡한 문제를 해결할 수 있게 되었습니다. 이후에는 컨볼루션 신경망(CNN), 순환 신경망(RNN), LSTM과 같은 다양한 딥러닝 아키텍처와 알고리즘이 개발되어 왔습니다.

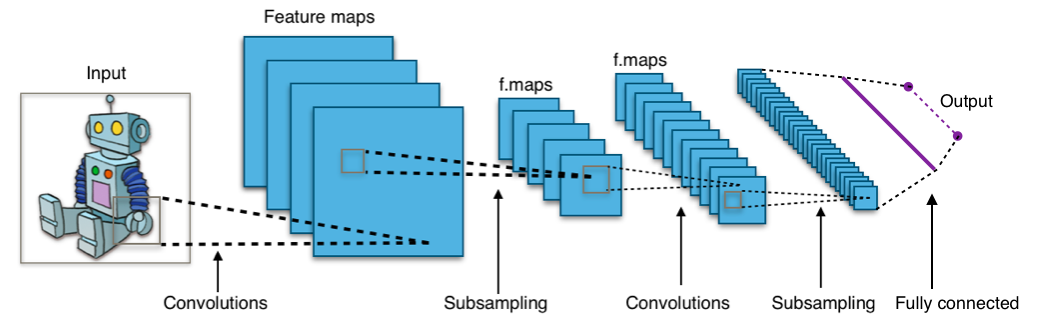

컨볼루션 신경망 (Convolutional Neural Network, CNN):

source: wikimedia

- 1998년, Yann LeCun이 손글씨 인식 문제에 컨볼루션 신경망을 적용한 LeNet을 발표했습니다.

- CNN은 주로 이미지 처리에 사용되며, 합성곱층과 풀링층으로 구성됩니다.

- 합성곱층은 이미지의 특징을 추출하는 역할을 하고, 풀링층은 공간적인 크기를 줄여 연산량을 감소시킵니다.

- 합성곱층은 이미지의 지역적인 패턴을 학습하고, 풀링층은 공간적인 크기를 줄여 연산량을 감소시킵니다.

순환 신경망 (Recurrent Neural Network, RNN):

source: wikimedia

- 1982년, John Hopfield이 순환 신경망을 제안했습니다.

- RNN은 순차적인 데이터 처리에 적합하며, 이전의 정보를 기억하고 현재 입력과 함께 처리합니다.

- 하지만 RNN은 긴 시퀀스를 처리하는 데 어려움이 있고, 장기 의존성 문제가 발생합니다.

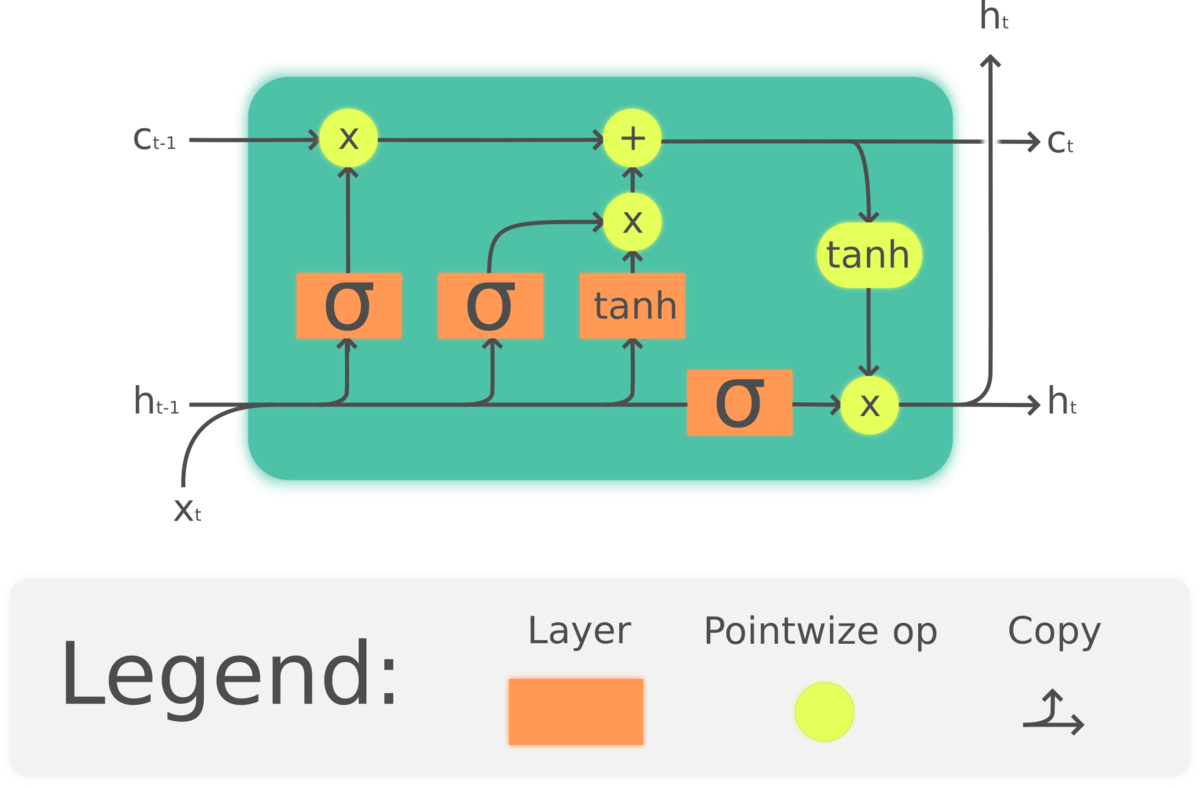

LSTM (Long Short-Term Memory):

source: wikimedia

- 1997년, Sepp Hochreiter와 Jürgen Schmidhuber가 LSTM을 제안했습니다.

- LSTM은 RNN의 문제를 해결하기 위해 기억 셀과 게이트 메커니즘을 도입한 모델입니다.

- LSTM은 장기 의존성 문제를 해결하고, 긴 시퀀스를 처리할 수 있게 되었습니다.

심층 신경망 (Deep Neural Network):

- 2006년, Geoffrey Hinton 등이 심층 신경망의 훈련을 가능하게 하는 초기화 방법을 제안하였습니다.

- 심층 신경망은 다수의 은닉층을 포함한 신경망을 의미하며, 딥러닝의 핵심 개념이 되었습니다.