서론

2022년 10월 16일에 카카오 관련 서비스가 이용이 안되는 일이 있었다.

판교에 있는 'SK C&C'의 데이터 센터 화재 때문이다.

SK C&C가 화재가 났는데 왜 카카오가 불통이 됐냐함은

기업들의 데이터 운용 방식부터 알아봐야 한다.

1. 데이터 운용 방식

기업들의 데이터 운용 방식은 크게 세 가지로 나뉜다.

1. 자체 서버실을 운영

2. KT·SK C&C 등이 운영하는 대형 데이터센터에 입주(서버 파킹) (=**IDC**)

3. 아마존웹서비스(AWS) 등의 클라우드 서비스를 활용

그럼 카카오는?

: 카카오는 2번 IDC의 비중이 40% 이상이었다. 단 하나의 자체 데이터 센터도 없이 판교의 SK C&C가 메인 데이터 센터였던 것이다.

이렇기 때문에 DRS(재해복구시스템)는 외부의 의존성으로 많은 절차와 시간이 소요될 수 밖에 없었다.

자체 데이터 센터 없음 -> 화재로 인한 SK C&C 데이터 센터의 전원 차단 -> 과도한 서버 의존으로 인한 업무 마비 -> 재난!

카카오가 SK C&C를 이용한 이유

: 데이터센터는 서비스 위치와 가까울 수록 좋기 때문에 (서버와 물리적 거리가 멀어질수록 지연시간이 증가) 가까우면 대응이 그만큼 빨라진다.

자체 데이터 센터가 없기에 판교에 위치한 카카오가 SK C&C를 쓸 수 밖에 없었던 이유다.

카카오는 판교 뿐만 아니라 안양 등 총 4곳의 데이터센터에 정보를 저장하고 있다. 보안을 이유로 나머지 두 곳의 데이터센터는 공개되지 않았다.

네이버의 데이터 운용 방식?

:네이버도 SK C&C를 이용했는데 카카오에 비해 피해가 적었다. 10%정도만 위탁하였고, 춘천에

네이버 자체 데이터센터가 있기 때문에 DRS로 빠른 복구를 할 수 있었기 때문이다.

그럼에도 카카오를 쓰는 이유?

: 카카오로 인해 서비스 차질를 겪었음에도, 많은 기업들은 카카오의 오픈 API를 이용하여 서비스를 복구하고 있다.

- 카카오는 2014년부터 자체 개발자 플랫폼으로 오픈API를 공개하여 아무나 카카오의 응용프로그램 인터페이스를 가져다가 개별 서비스와 플랫폼을 만들 수 있도록 했다.

- 이 방식으로 카카오는 IT를 비롯한 각 업계에 대한 영향력을 늘릴 수 있었고, 자사 API에 의존하는 새로운 외부 서비스를 통해 인사이트를 도출할 수 있었다

2. DR, HA(이중화)의 차이

(1) DR(Disaster Recovery) 재해복구

각종 재해 및 위험요소에 의해 정보시스템이 중단됐을 때 이를 정상으로 회복시키는 것을 의미

- 이미 일어난 재해를 뒤로 하고 빠르게 서비스를 재개하기 위해 대비하는 것.

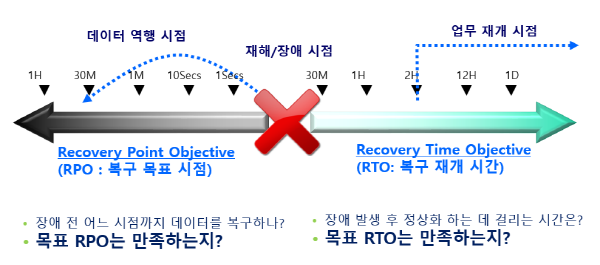

- 데이터 손실과 다운타임을 적게 DRS를 구성할 수록 비용이 상승하기 때문에 적절한 수준으로 RLO를 설정하는 것이 중요하다.

- DR센터에는 독자구축, 공동구축, 상호구축 등이 있다

(자세한건 새글로 다시 파야겠다..)

(출처: 맨텍)

(출처: 맨텍)

- BCP(Business Continuity Planning, 업무연속성계획)

재해 발생시 전 과정에 대한 계획을 체계적으로 수립하는 것.

- BIA 관리 및 감시를 통한 예방

- 재해에 대비한 전략 수립

- 상황 발생 시 대응 계획

- 피해 시 복원 절차

- 전산시스템(서버, 네트워크, 스토리지, 운영체제, 애플리케이션, DB 등)의 복구를 통합적으로 고려하여 단계적으로 진행

- BIA(Business Impact Analysis, 업무영향분석)

재해가 업무와 자산에 미칠 영향을 분석하는 것

데이터의 중요도에 따라 등급을 나눈다.

- RTO(Recovery Time Objective, 복구목표시간)

장애 후 수용 가능한 다운타임

- RPO(Recovery Point Objective, 복구목표시점

수용 가능한 데이터 손실 시점

- RLO(Recovery Level Objective, 복구목표수준)

어느 수준까지 복구를 할 건지 결정하는 것

(2) HA (고가용성, 이중화)

시스템 고장 발생 시 얼마나 빠른 시간 내에 다시 정상적으로 서비스 할 수 있는 상태인지 분석하는 척도.

HA를 높이기 위해서는 **이중화**(Duplication)을 구현하는 것.두개의 스토리지 사용으로 (두개의 서버) 한 서버는 활성화(Hot, Active)하고 나머지 한대는 대기상태(Cold, Standby)로 만든다.활성화Active 되어있는 장비가 장애가 생겨 작동이 멈췄을 시, 즉시 Standby 장비를 active로 전환하여 사용하는 구조장비마다 스토리지가 별도로 있기 때문에 동기화 필요.

3. 앞으로의 데이터는?

카카오의 장애를 계기로 데이터 이중화 의무화 입법화까지 논의 되었고, 아직 이중화를 하지 않은 기업들의 IDC(인터넷데이터센터) 수요가 늘어날 전망이다.

데이터센터 이중화 등은 그간 ‘돈 먹는 하마’로 여겨졌다. 100% 실시간 백업을 하려면 관련 비용이 딱 두 배로 들기 때문이다. 하지만 카카오 사태로 ‘비용보다 안전’이란 인식이 확산하는 모습이다.

- 국내에서는 통신사업자들을 중심으로 하이퍼스케일급 IDC를 운용하고 있다.

한국데이터센터연합회(KDCC)에 따르면 지난 2020년 기준 전국 IDC는 156개로, 오는 2023년 205개에 달할 전망이다. 현재 KT클라우드는 14개, LG유플러스는 12개, SK브로드밴드는 5개 IDC를 운영하고 있다. 하이퍼스케일 IDC로는 KT클라우드가 용산 IDC, LG유플러스는 평촌 IDC, SK브로드밴드는 가산 IDC를 갖고 있다. 여기에 KT클라우드는 지난 7월 초거대 규모 가산 IDC 착공에 들어갔다. 오는 2025년까지 100MW 데이터센터를 추가로 확보한다는 방침이다. LG유플러스는 축구장 6개 규모의 평촌2센터를 구축 중이다.

하나의 데이터 센터에 장애가 발생하며

수동으로 전환 작ㅇㅂ을 진행했기 때문에 ㅗㅂㄱ구 지연

둘재 사용자 서비스 외에 서비스 개발자 관리ㅇ를 위한 도구들의 이중화 미흡

안정ㅎ성확보에 소홀

컨테이너 이밎미를

화재 여파소 사용할 수 없게 되서 복구에 상당한 어려운

셋째 이중화 자원 가용의 부족

ㅏㄱ용자원의 확보가 부족해사ㅓ 전원이 들어올때까지 기다려야함

가장 약한 이중화를 따라가기 때문에

개발시스템 미흡한 이중화

개발 부서 시스템과 다른 이중화

ㅈ부족한 상면

체꼐적인 이중화 준비

위기 대응면 부족

인력과 자원의 부족

운영관리도구 부족의 이중화 상며느이 부족 치명적

이중화나 대응에 관심이 있어도 준비가 부족하다

둘째, 커뮤채널의 혼선

사내 커뮤니케이션 모니터링을 위해 랯녈과 카톡사용

의사결정을 위한 커뮤가 실생활로 사용되기 않음

컨트롤 타워 부재에 지적

동시다발적으로 장애에 전사조직이 사전에 세팅되어있지 않고

개발자들이 최선을 다했지만 부족

주요 원인

1. 데이터 센터간 이중화 부족

둘재 시스템을 모니터링 할 시스템의 이중화 부족

셋째 인력과 자원의 부족

출처

"카카오 먹통 대란, 남의 일 아냐"…데이터 서비스 점검나선 기업들

'먹통 사태' 단 며칠 만에 백기…카카오 전략에 당했다?

디지털 셧다운 대응 달랐던 이유는… 데이터센터 1조 쓴 네이버, 문어발 확장만 카카오

데이터 이중화 입법 추진…통신 3사 IDC 반사이익 얻나